| freiesMagazin-Umfrage gestartet | 01/2009 |

| Auswertung der freiesMagazin-Umfrage | 03/2009 |

| Kurztest: Etherpad | 04/2009 |

| Linux-Herstellerunterstützung: DVD-Brenner-Update | 04/2009 |

| Rückblende zur CeBit 2009 | 04/2009 |

| freiesMagazin-Programmierwettbewerb | 04/2009 |

| ECDL/ICDL wagt sich an OpenOffice.org | 06/2009 |

| Linuxtag - Erlebte Community | 08/2009 |

| 41. DANTE-Mitgliedertagung in Esslingen | 10/2009 |

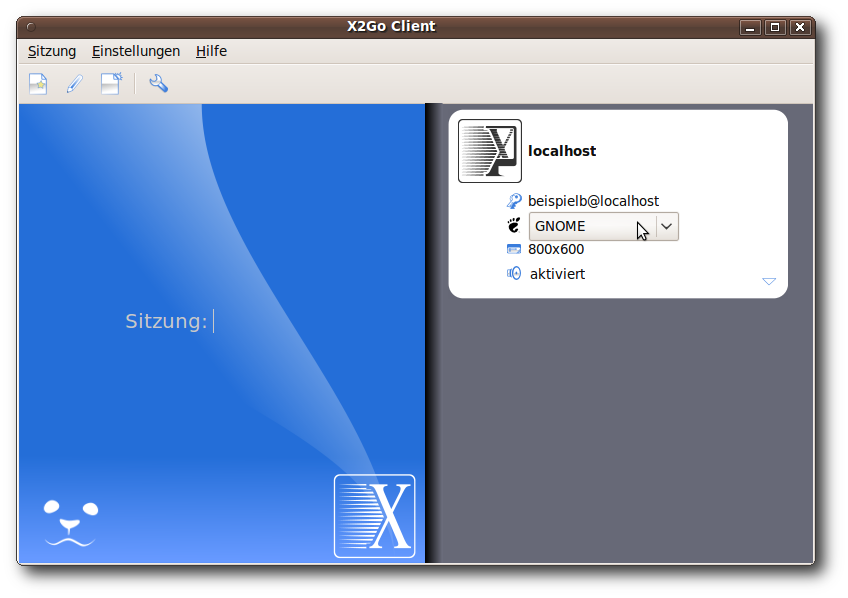

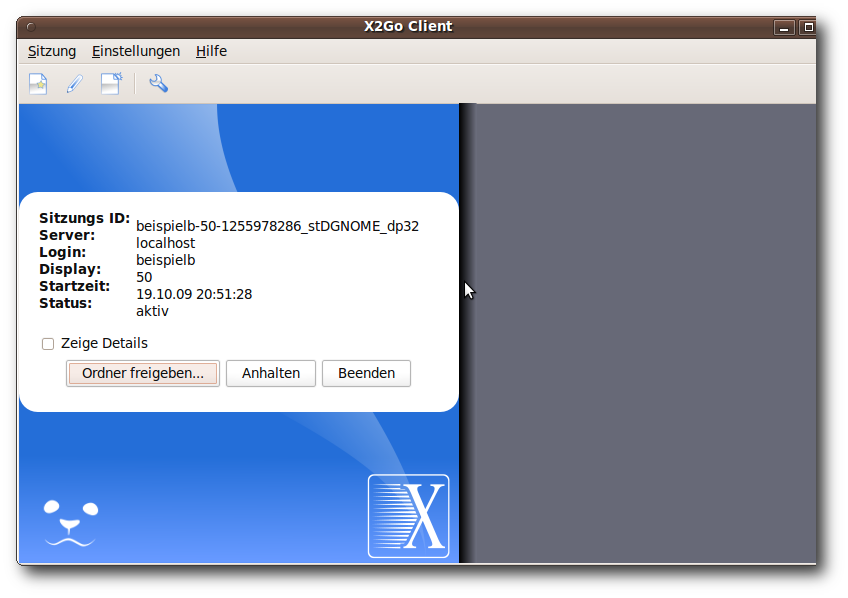

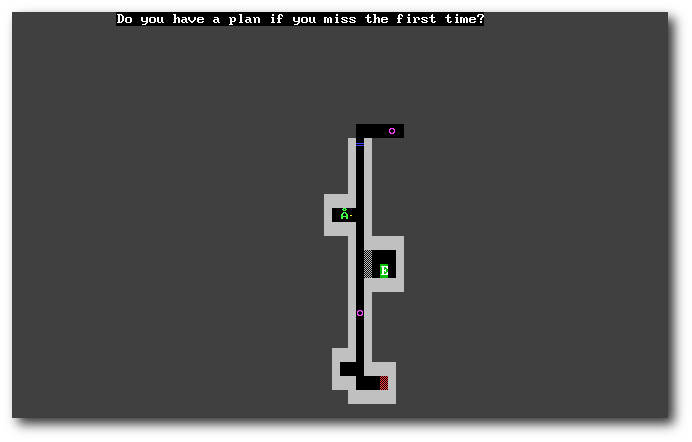

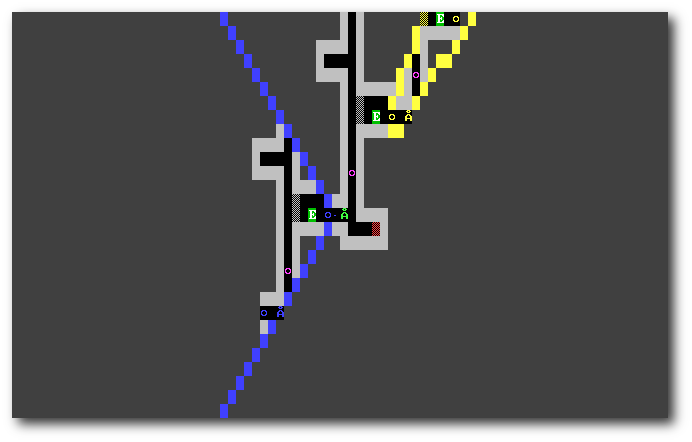

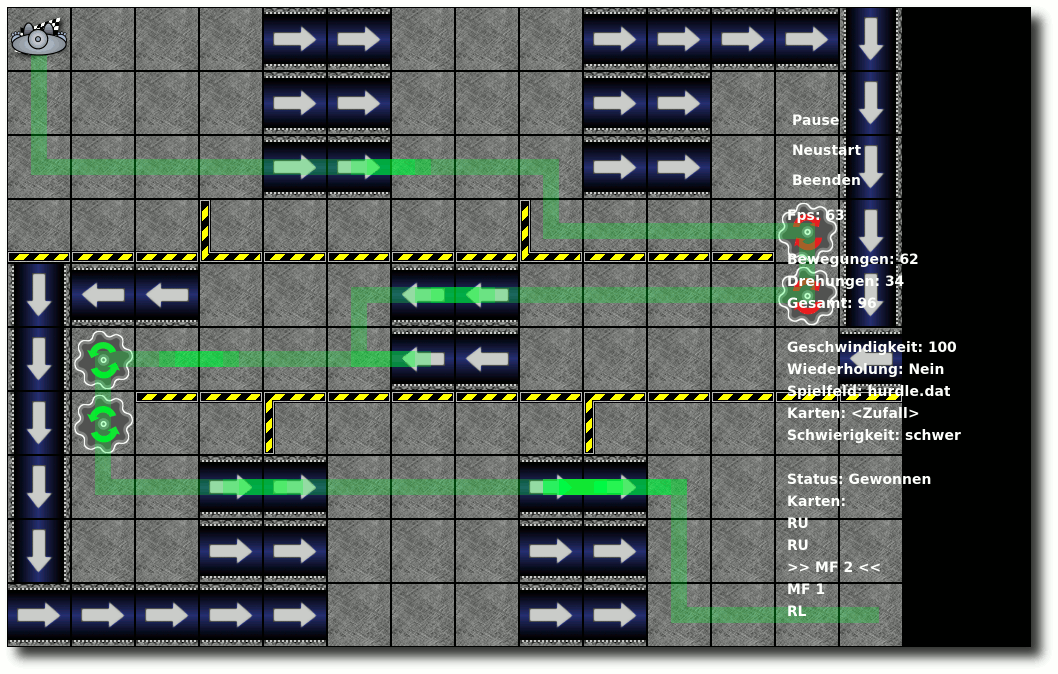

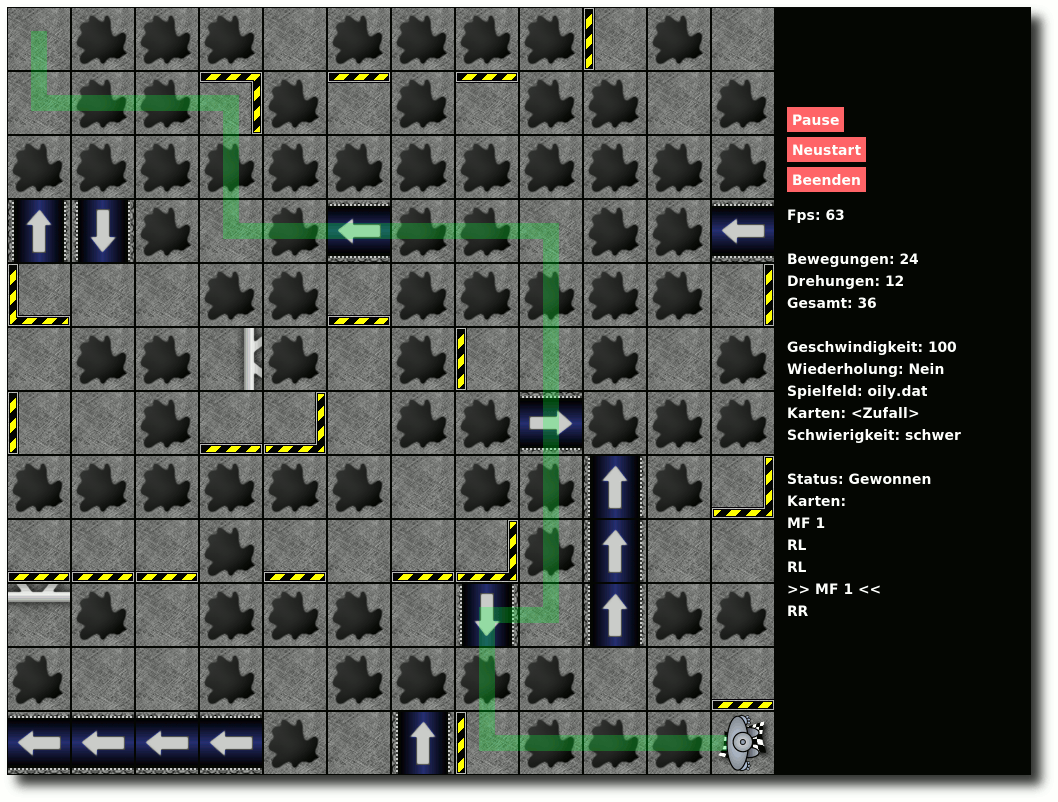

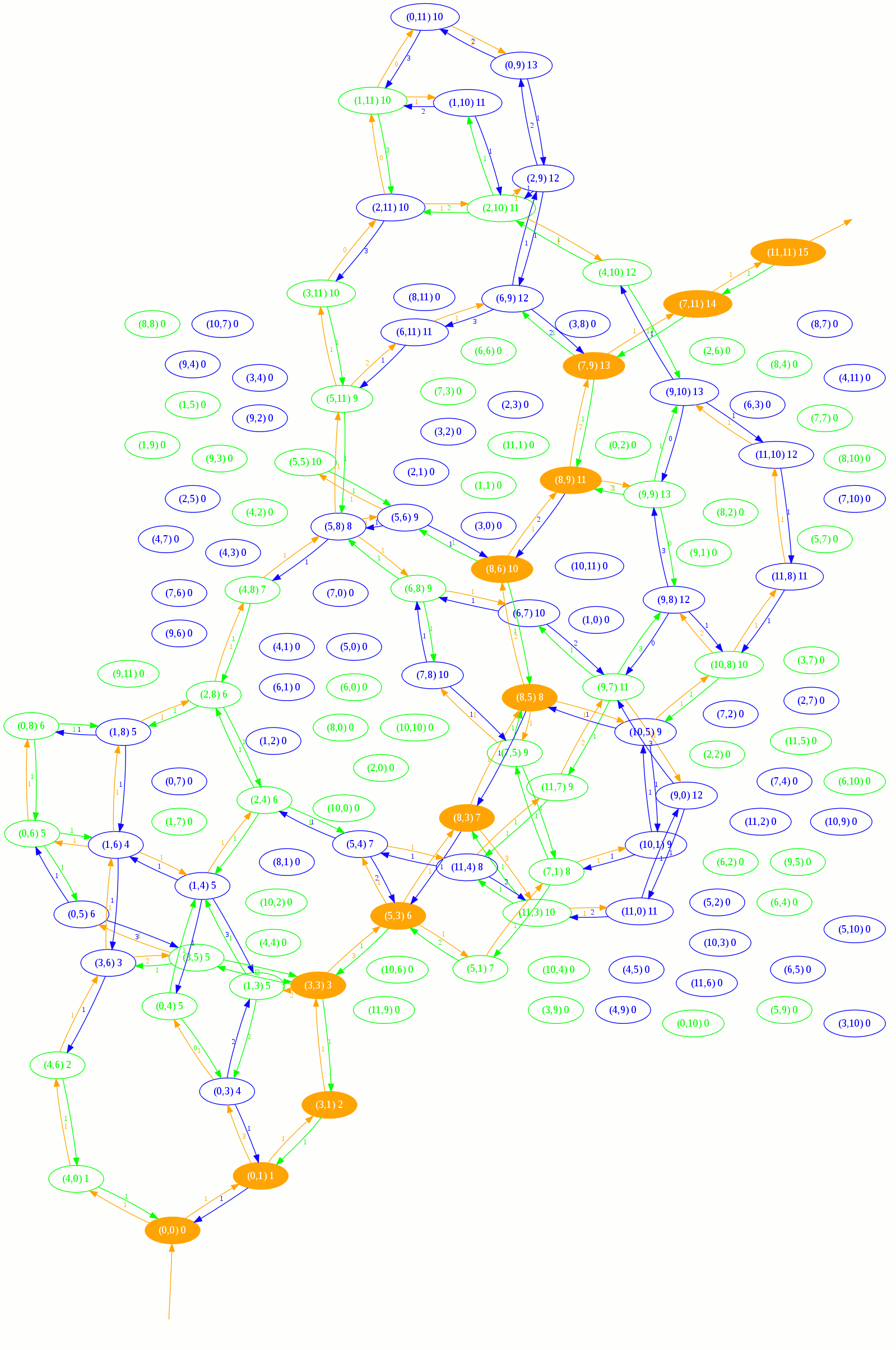

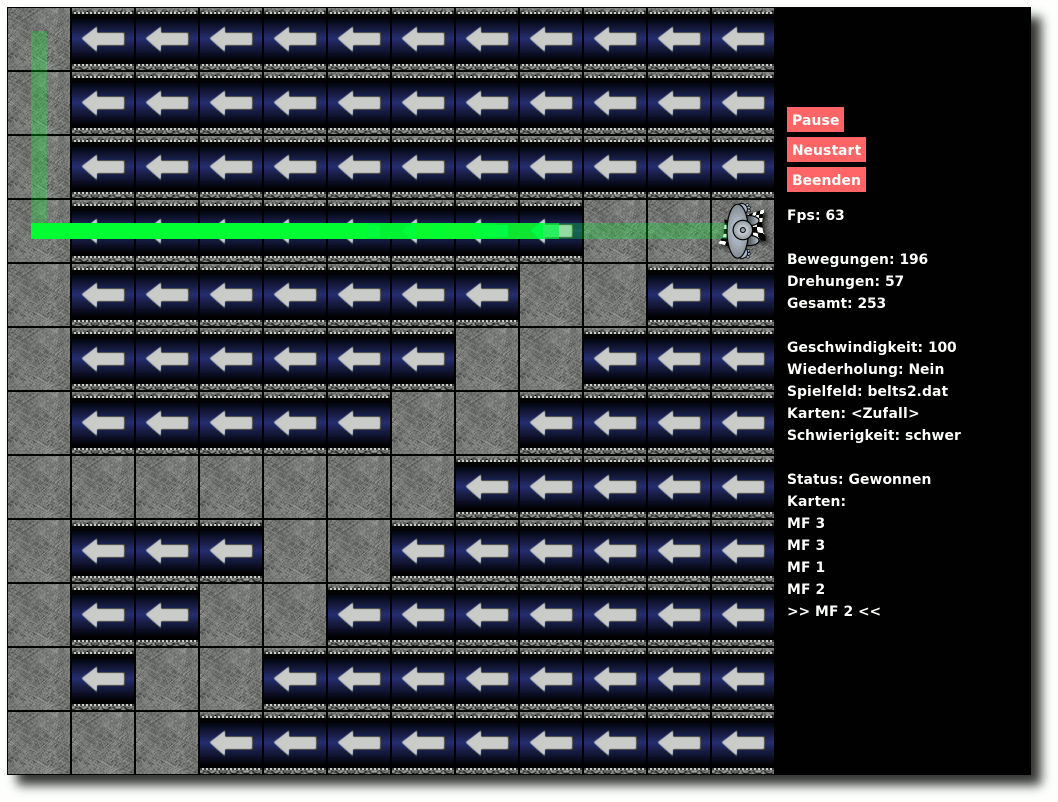

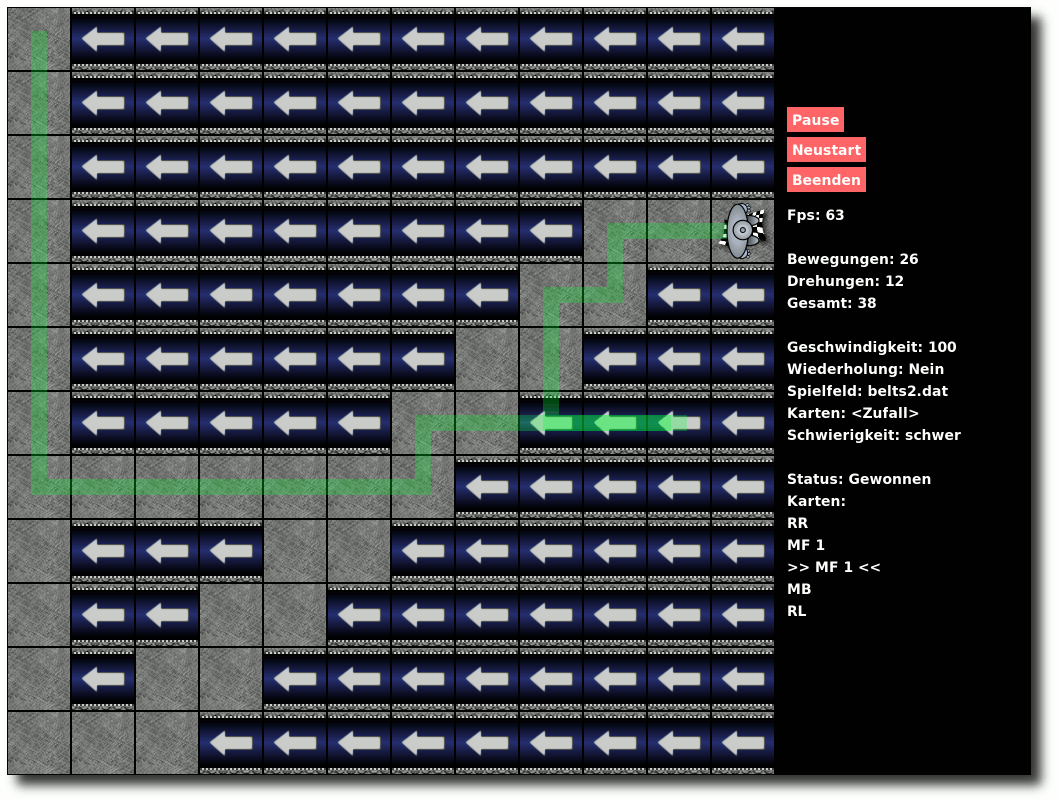

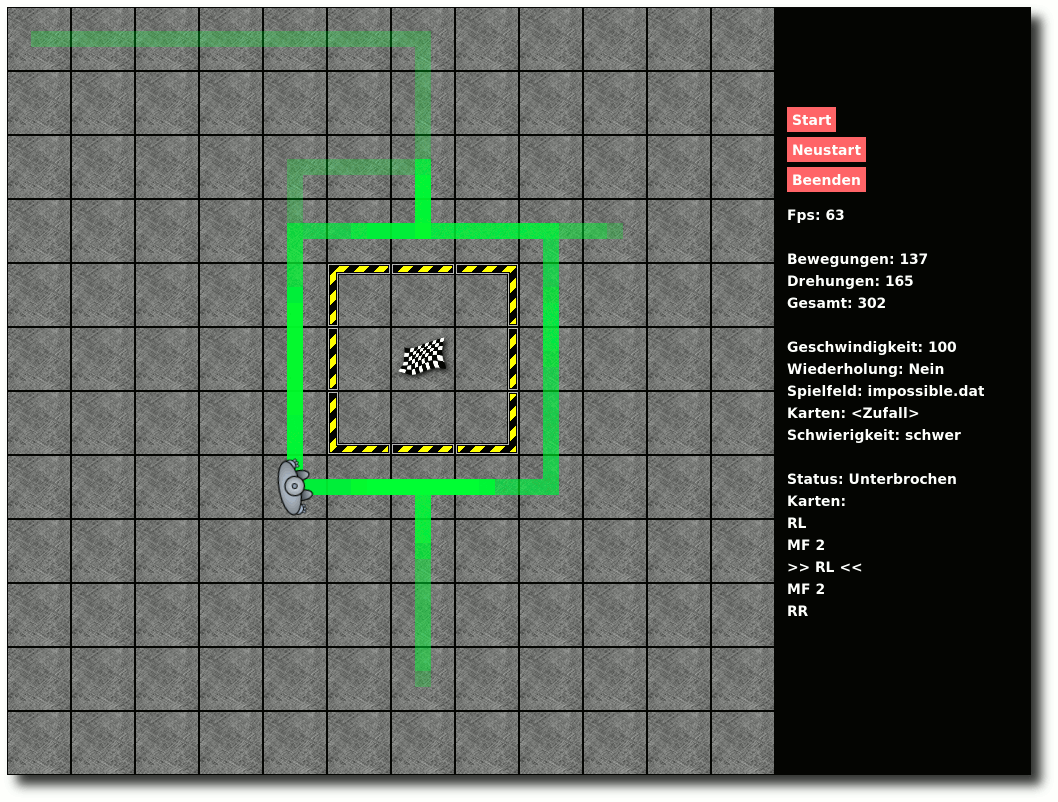

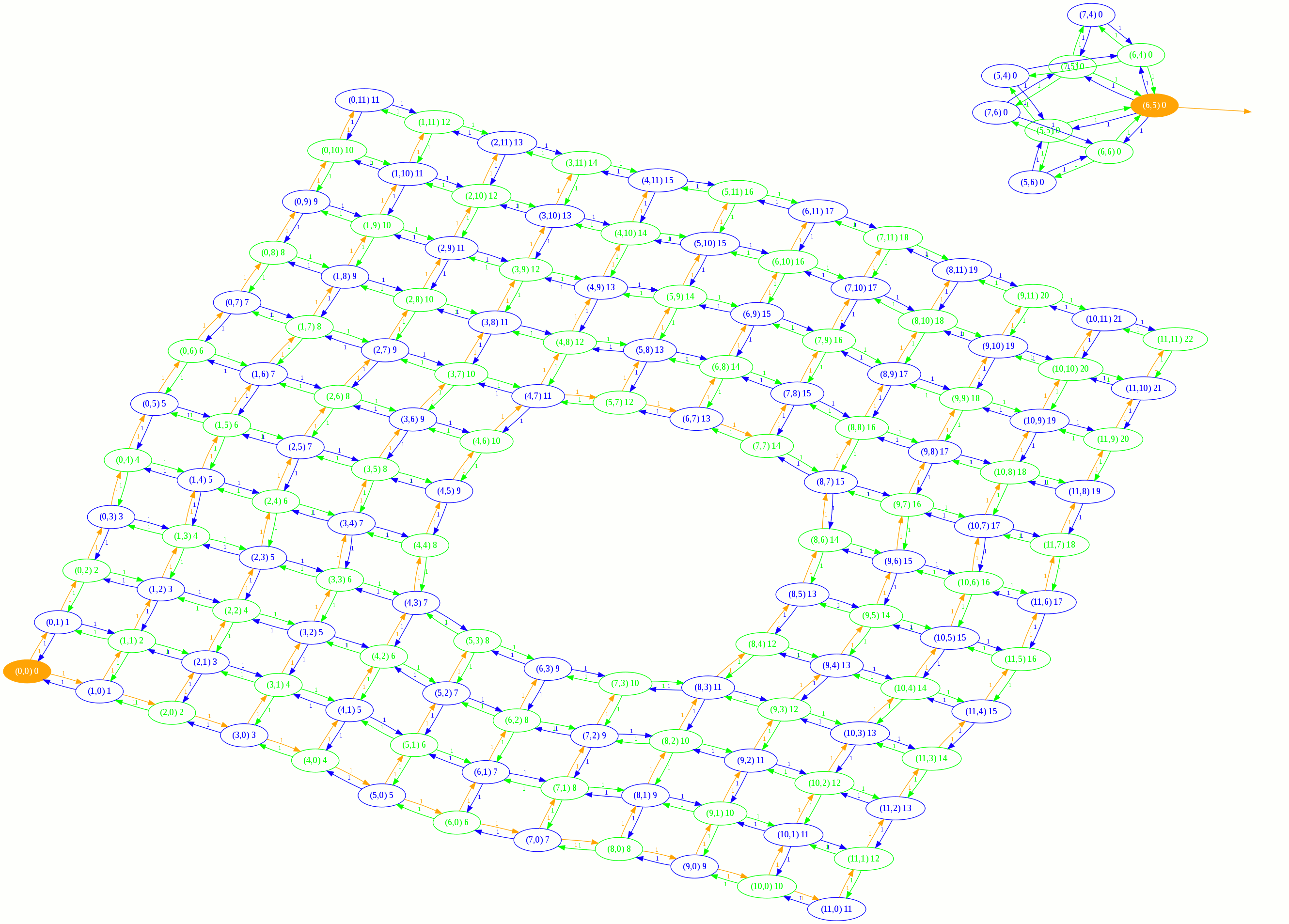

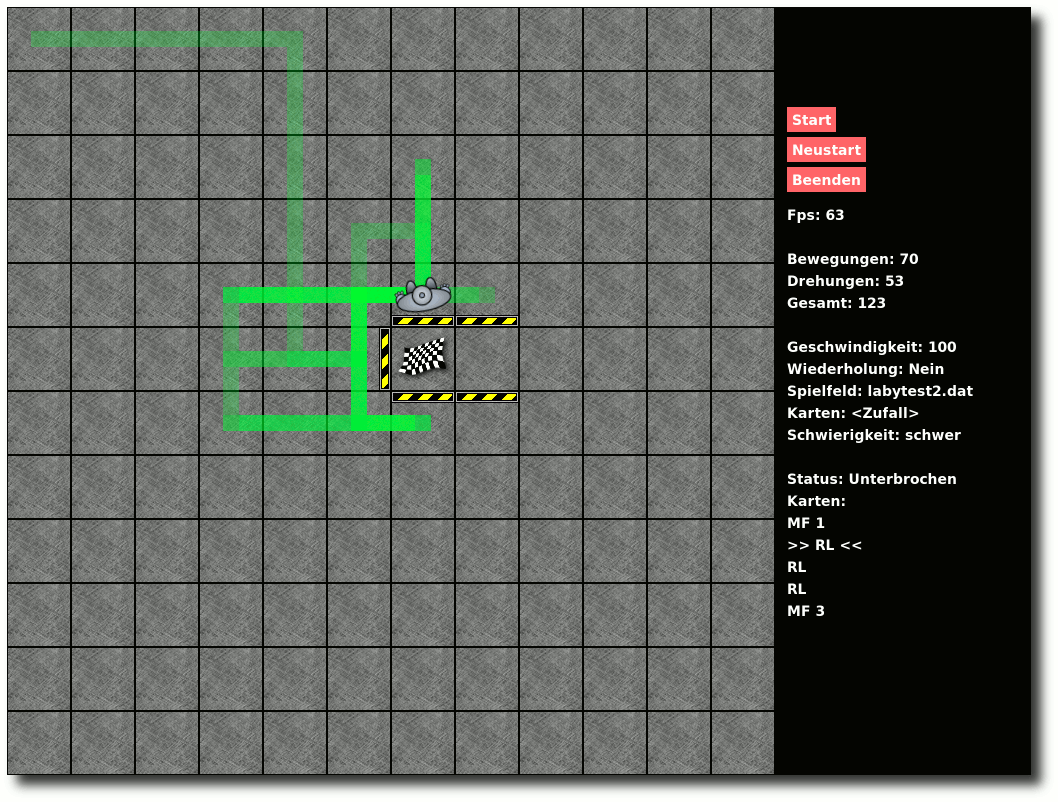

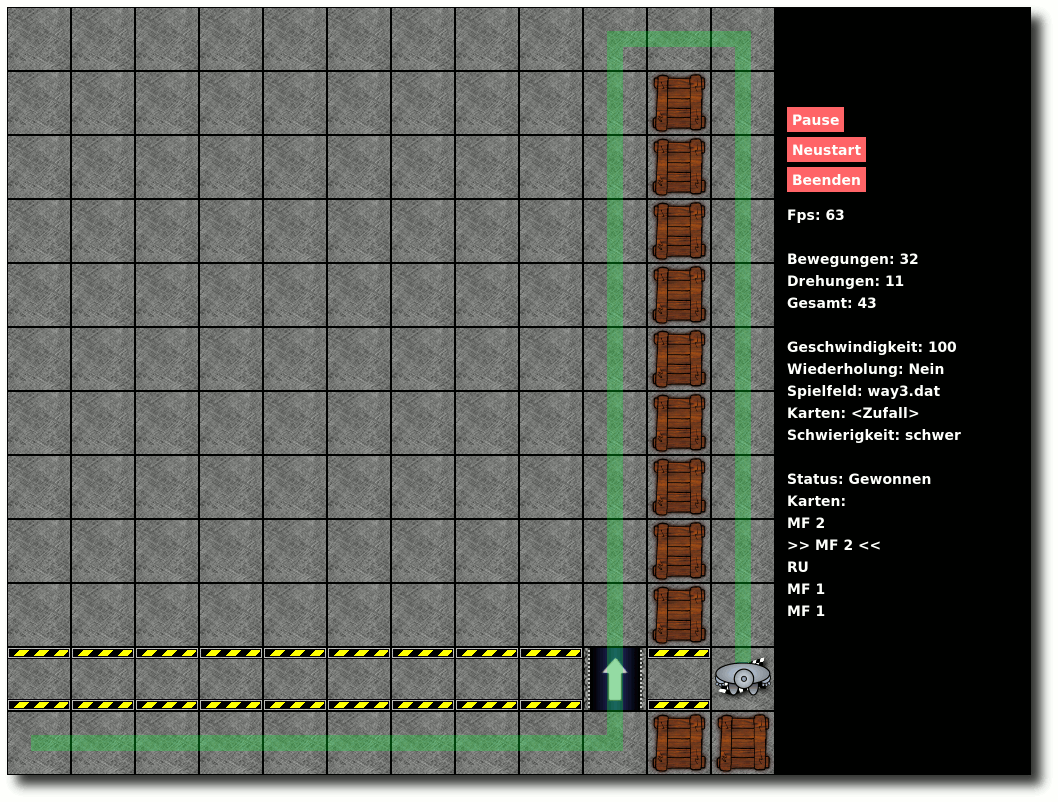

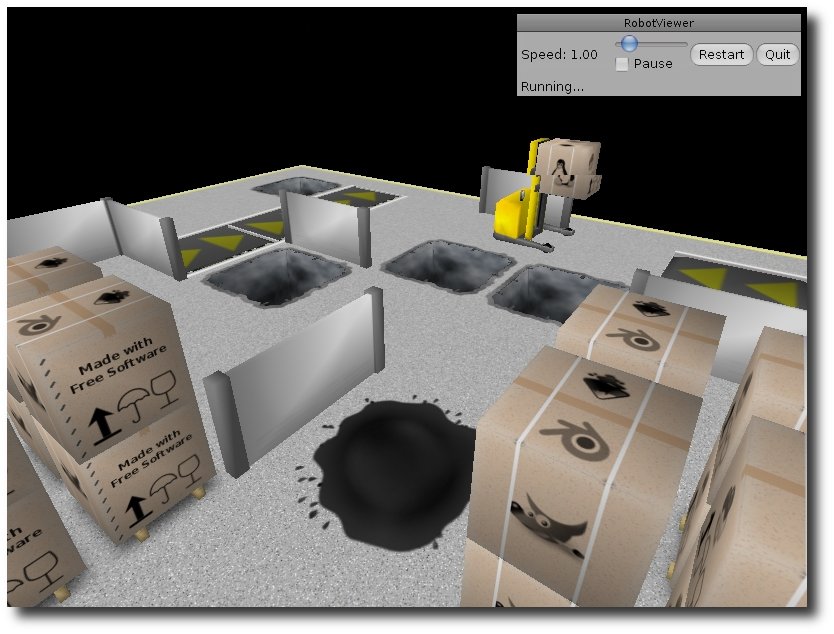

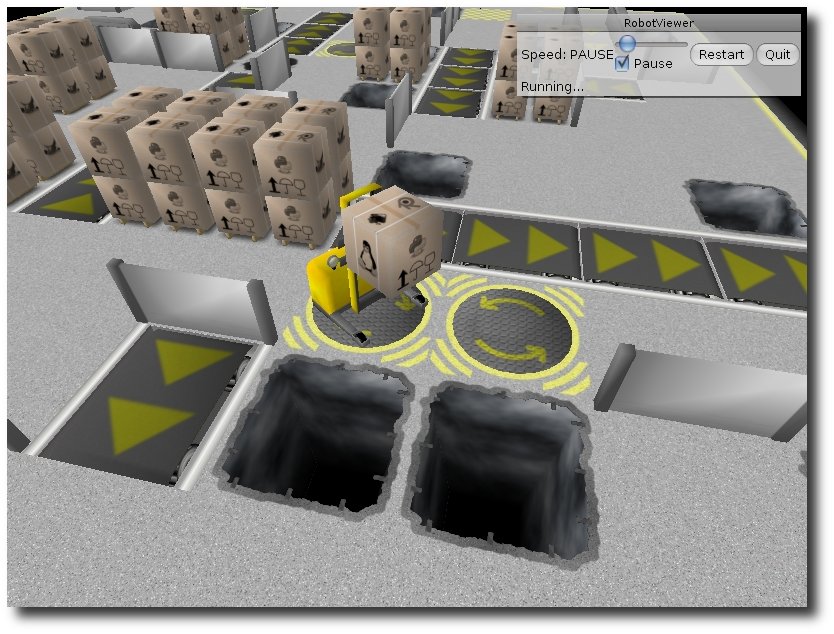

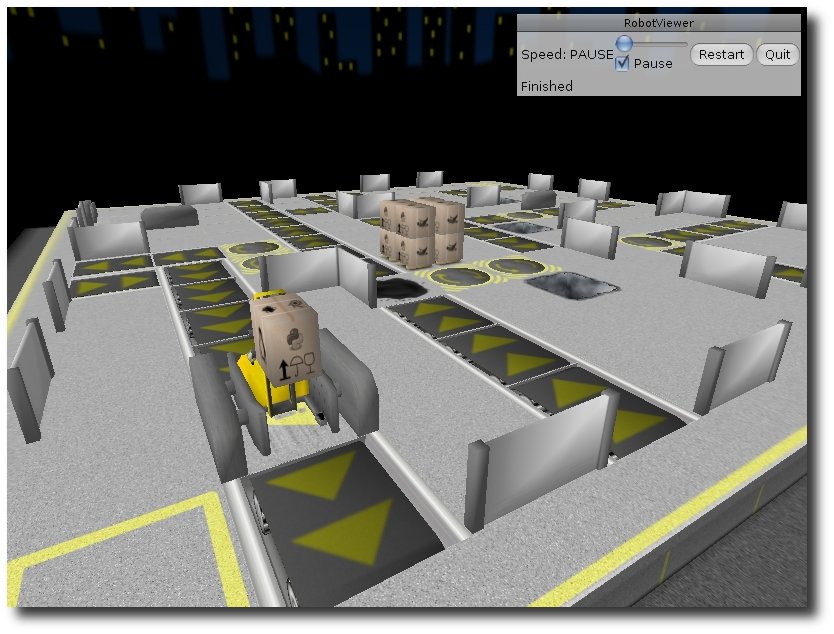

| Die GUI zum Programmierwettbewerb | 10/2009 |

| Erklärungen zum zweiten Programmierwettbewerb | 10/2009 |

| FAQ zum Programmierwettbewerb | 10/2009 |

| Rückblick: Ubuntu-Treffen auf der Ubucon 2009 | 11/2009 |

| Weitere Informationen zum Programmierwettbewerb | 11/2009 |

| Google Summer of Code | 12/2009 |

| |

| Distributionen aktuell | 01/2009 |

| Kernel-Rückblick | 01/2009 |

| Nachrichtenschnippsel | 01/2009 |

| Januar und Februar im Kernelrückblick | 03/2009 |

| OS-Tan-Linux-Desktophintergründe | 03/2009 |

| Das Dateisystem ext4 | 04/2009 |

| Ein Tuz für den Kernel | 04/2009 |

| Linux-Herstellerunterstützung: DVD-Brenner-Update | 04/2009 |

| Der April im Kernel-Rückblick | 05/2009 |

| AVR-Mikrocontroller unter Linux | 06/2009 |

| Der Mai im Kernel-Rückblick | 06/2009 |

| Die Vorgeschichte von Linux | 06/2009 |

| Mobiles Linux mit Moblin | 06/2009 |

| Rezension: Just for Fun - The Story of an Accidental Revolutionary | 06/2009 |

| Der Juni im Kernel-Rückblick | 07/2009 |

| Der Juli im Kernel-Rückblick | 08/2009 |

| Über magische Tasten aus der Klemme - SysRQs | 08/2009 |

| Der August im Kernel-Rückblick | 09/2009 |

| Einfach Easy Peasy | 09/2009 |

| Linux auf der Nintendo Wii | 09/2009 |

| Der September im Kernel-Rückblick | 10/2009 |

| Gefahren von Fremdquellen am Beispiel PPA | 10/2009 |

| Der Oktober im Kernel-Rückblick | 11/2009 |

| Hardwarekompatibilität unter Linux | 11/2009 |

| Der November im Kernel-Rückblick | 12/2009 |

| |

| freiesMagazin-Umfrage gestartet | 01/2009 |

| Auswertung der freiesMagazin-Umfrage | 03/2009 |

| freiesMagazin-Programmierwettbewerb | 04/2009 |

| Informationen zum Programmierwettbewerb | 05/2009 |

| Das Ende des Programmierwettbewerbs | 06/2009 |

| Magazinerstellung mit LaTeX - Das Layout | 08/2009 |

| freiesMagazin sucht Unterstützung! | 08/2009 |

| Die GUI zum Programmierwettbewerb | 10/2009 |

| Erklärungen zum zweiten Programmierwettbewerb | 10/2009 |

| FAQ zum Programmierwettbewerb | 10/2009 |

| Weitere Informationen zum Programmierwettbewerb | 11/2009 |

| |

| freiesMagazin-Programmierwettbewerb | 04/2009 |

| GPL-Lizenzenzschwierigkeiten | 05/2009 |

| Informationen zum Programmierwettbewerb | 05/2009 |

| NaturalDocs - Quelltexte natürlich dokumentieren | 08/2009 |

| Der Raytracer POV-Raytracer | 09/2009 |

| Die GUI zum Programmierwettbewerb | 10/2009 |

| Erklärungen zum zweiten Programmierwettbewerb | 10/2009 |

| FAQ zum Programmierwettbewerb | 10/2009 |

| Java, Teil 1 - Einführung in eine moderne Sprache | 10/2009 |

| Von der Schaltung zur fertigen Platine mit EAGLE | 10/2009 |

| Nautilus-Scripts | 11/2009 |

| Shebang - All der Kram | 11/2009 |

| Testen mit Perl | 11/2009 |

| Weitere Informationen zum Programmierwettbewerb | 11/2009 |

| Google Summer of Code | 12/2009 |

| Java, Teil 2 - Grafische Programmierung mit Swing | 12/2009 |

| Lösungen zum Artikel „Shebang - All der Kram“ | 12/2009 |

| |

|

| Erscheinungsdatum: 10. Januar 2010 |

|

|

| Redaktion |

| Dominik Honnef | Thorsten Schmidt |

| Dominik Wagenführ (Verantwortlicher Redakteur) |

| |

| Satz und Layout |

| Ralf Damaschke | Yannic Haupenthal |

| Marcus Nelle | Sebastian Schlatow |

| |

| Korrektur |

| Daniel Braun | Frank Brungräber |

| Raoul Falk | Karsten Schuldt |

| |

| Veranstaltungen |

| Ronny Fischer |

| |

| Logo-Design |

| Arne Weinberg (GNU FDL) |

| |

Dieses Magazin wurde mit LaTeX erstellt. Mit vollem Namen

gekennzeichnete Beiträge geben nicht notwendigerweise die Meinung

der Redaktion wieder. Wenn Sie

freiesMagazin ausdrucken möchten, dann

denken Sie bitte an die Umwelt und drucken Sie nur im Notfall. Die

Bäume werden es Ihnen danken. ;-)

Soweit nicht anders angegeben, stehen alle Artikel und Beiträge in

freiesMagazin unter der

GNU-Lizenz für freie Dokumentation (FDL). Das Copyright liegt

beim jeweiligen Autor.

freiesMagazin unterliegt als Gesamtwerk ebenso

der

GNU-Lizenz für freie Dokumentation (FDL) mit Ausnahme von

Beiträgen, die unter einer anderen Lizenz hierin veröffentlicht

werden. Das Copyright liegt bei Dominik Wagenführ. Es wird die

Erlaubnis gewährt, das Werk/die Werke (ohne unveränderliche

Abschnitte, ohne vordere und ohne hintere Umschlagtexte) unter den

Bestimmungen der GNU Free Documentation License, Version 1.2 oder

jeder späteren Version, veröffentlicht von der Free Software

Foundation, zu kopieren, zu verteilen und/oder zu modifizieren.

Die xkcd-Comics stehen separat unter der

Creative-Commons-Lizenz CC-BY-NC 2.5. Das Copyright liegt

bei

Randall Munroe.

Zum Index