Impressum ISSN 1867-7991 | ||

| freiesMagazin erscheint als PDF und HTML einmal monatlich. | ||

| Redaktionsschluss für die August-Ausgabe: 22. August 2010 | ||

| Kontakt | ||

| Postanschrift | freiesMagazin | |

| c/o Dominik Wagenführ | ||

| Beethovenstr. 9/1 | ||

| 71277 Rutesheim | ||

| Webpräsenz | http://www.freiesmagazin.de | |

| Autoren dieser Ausgabe | ||

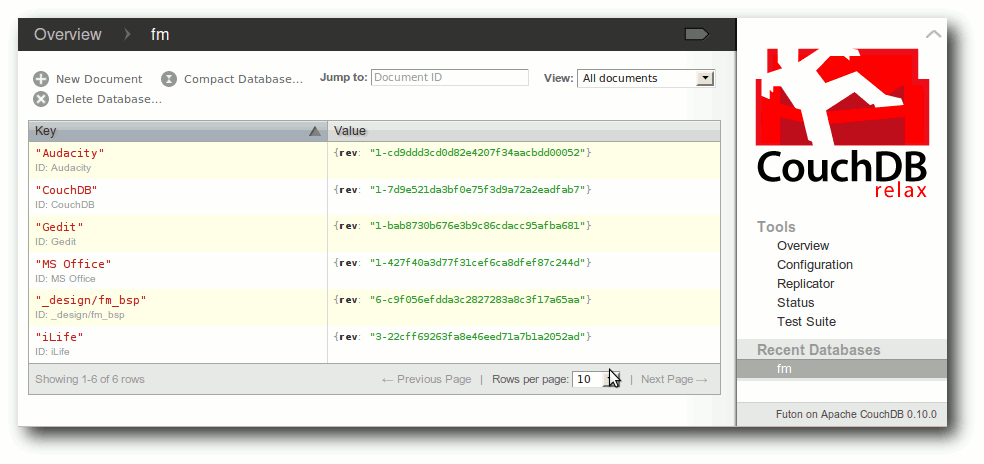

| Hans-Joachim Baader | Rezension: CouchDB – kurz & gut | |

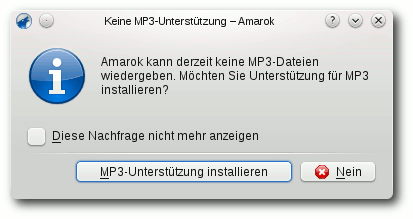

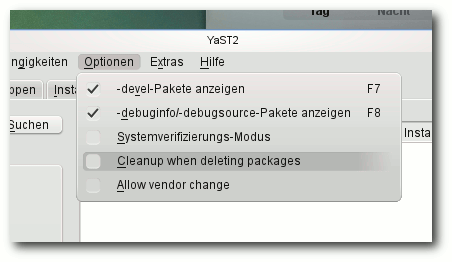

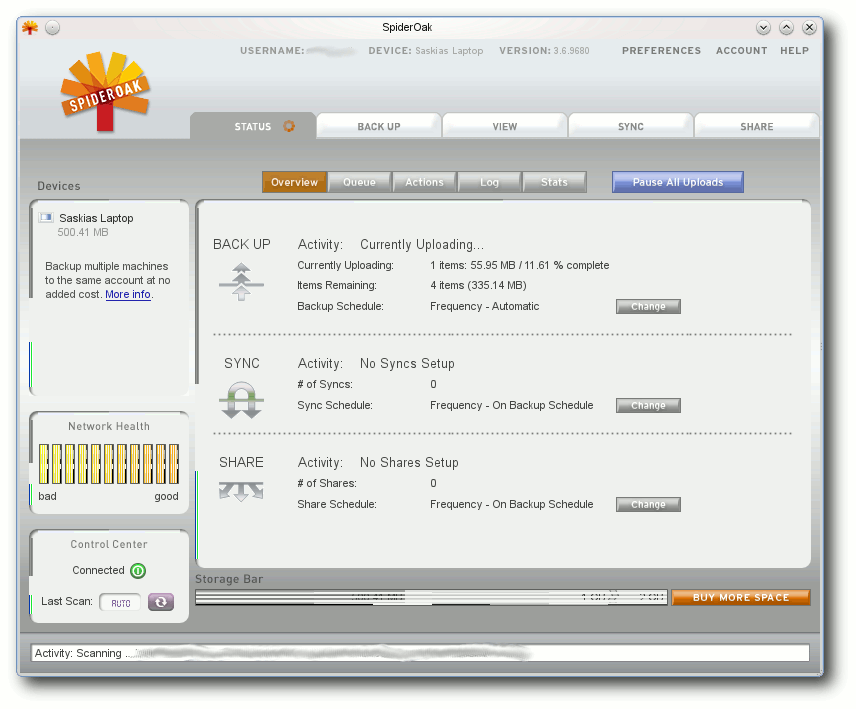

| Saskia Brückner | Das neue openSUSE 11.3 ist da | |

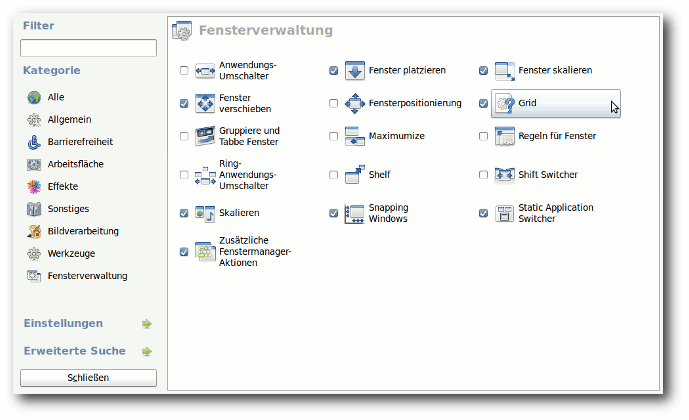

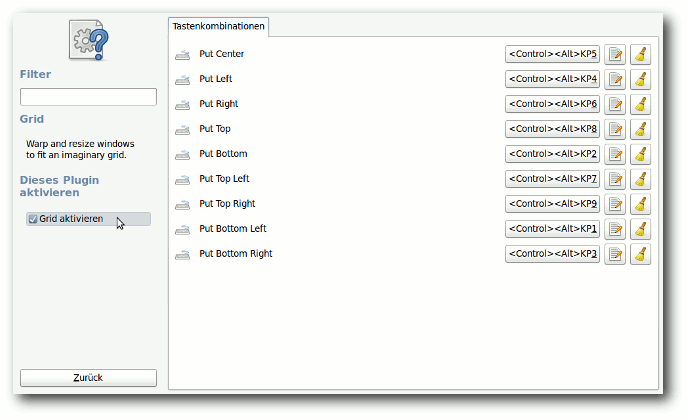

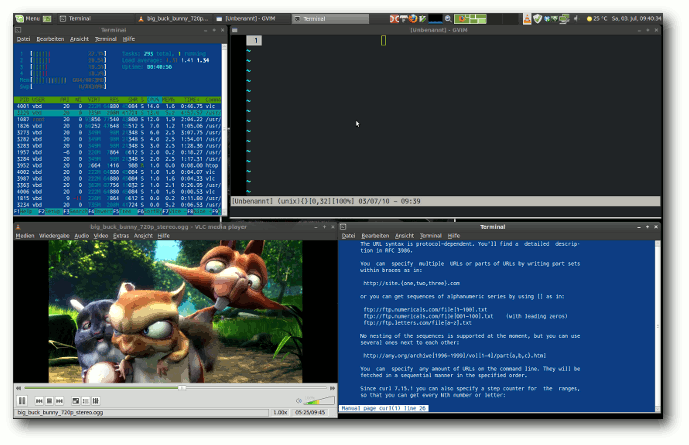

| Volker Duetsch | Tiling Windows mit Compiz und dem Grid-Plugin | |

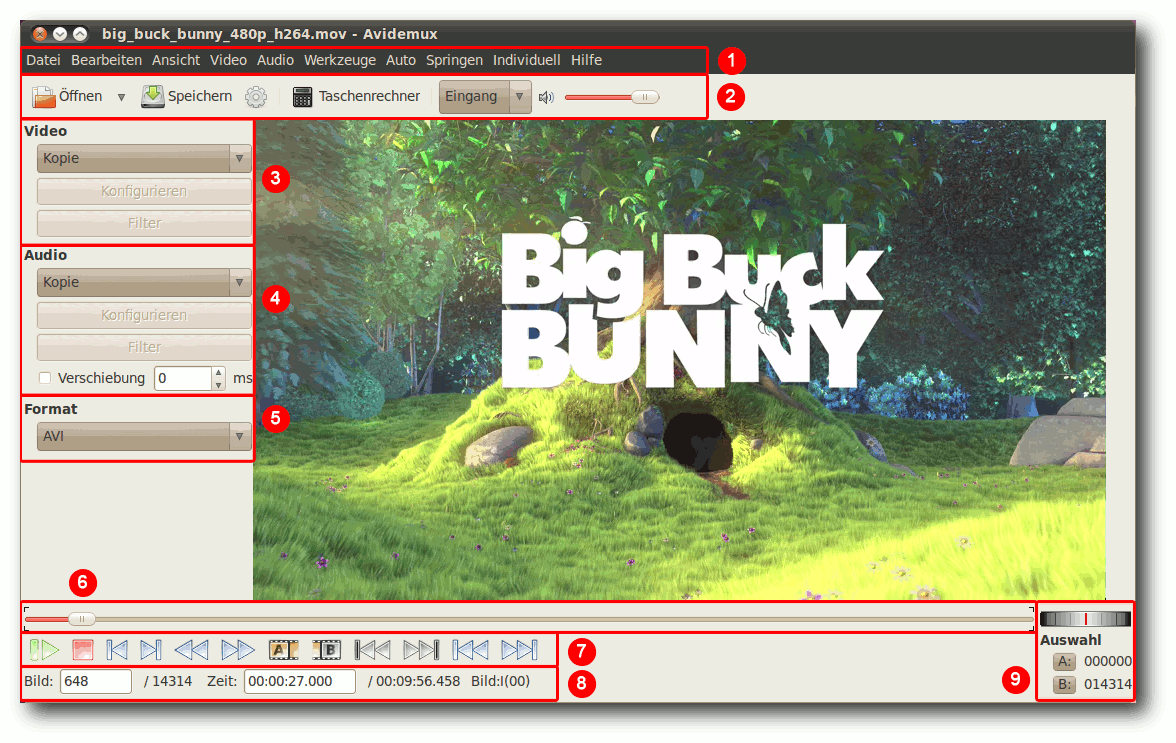

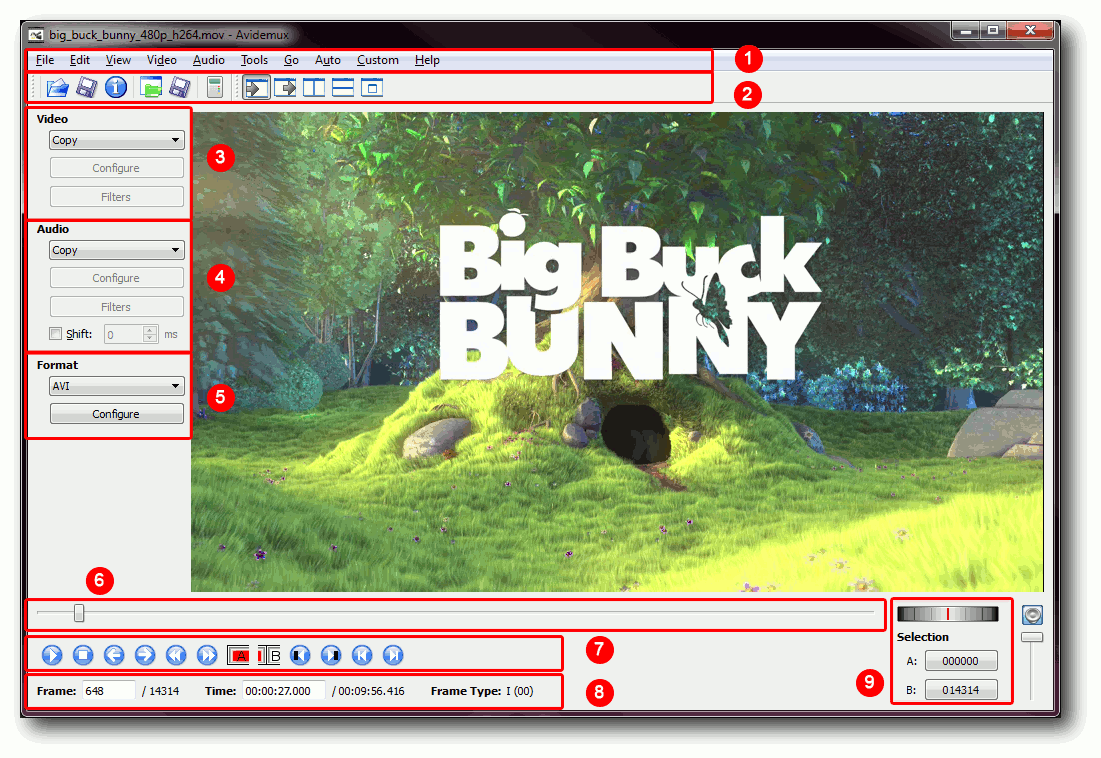

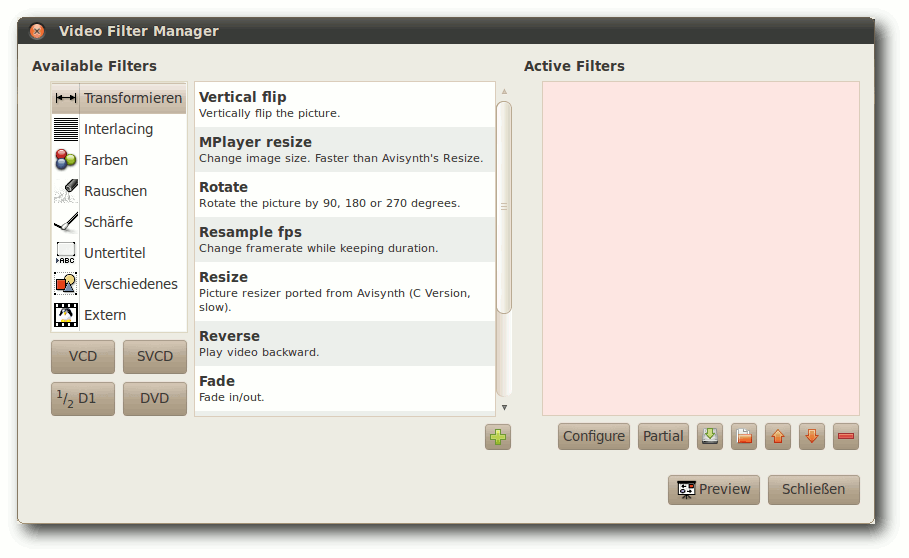

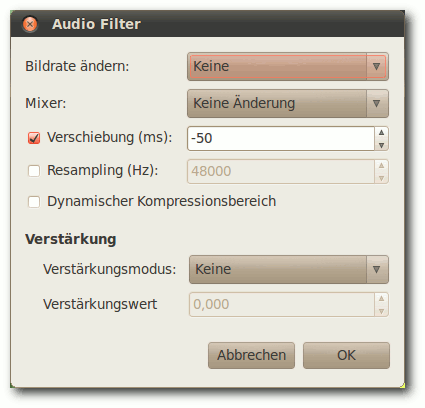

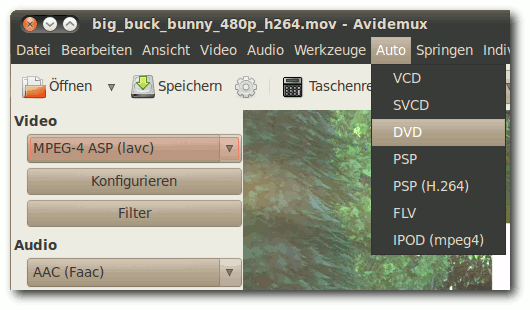

| Kirsten Roschanski | Videoschnitt mit Avidemux | |

| Mathias Menzer | Der Juni und Juli im Kernelrückblick | |

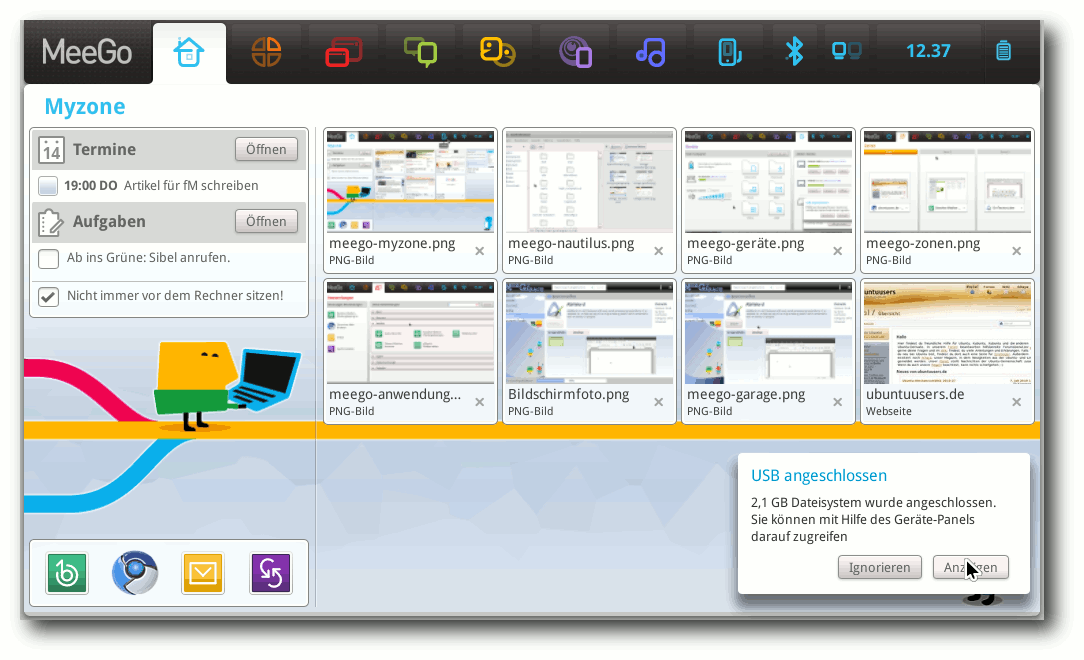

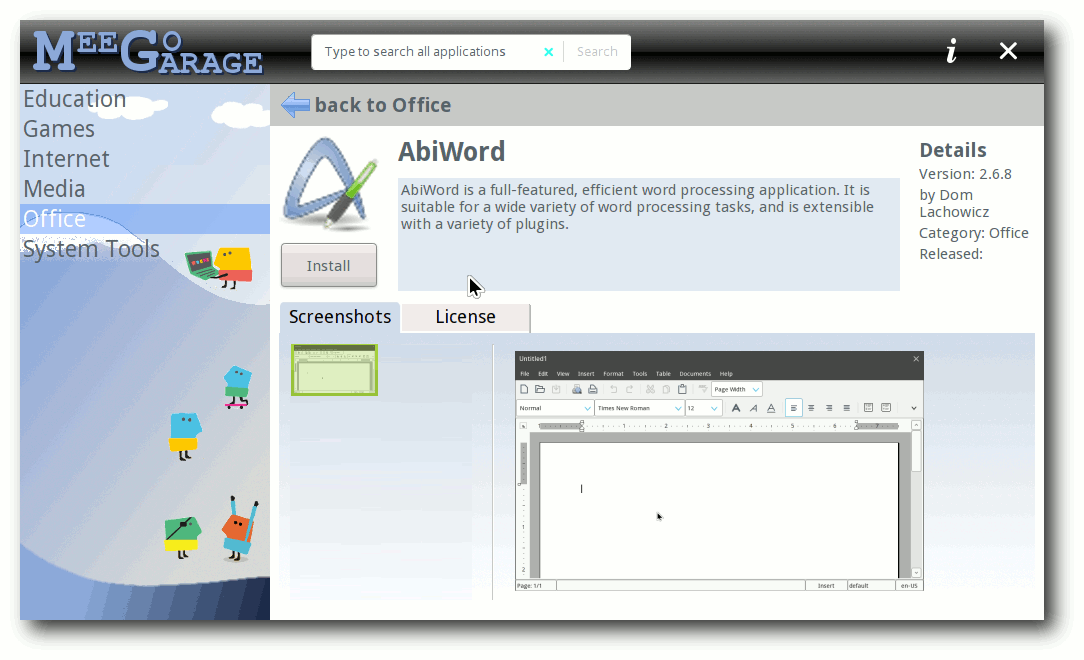

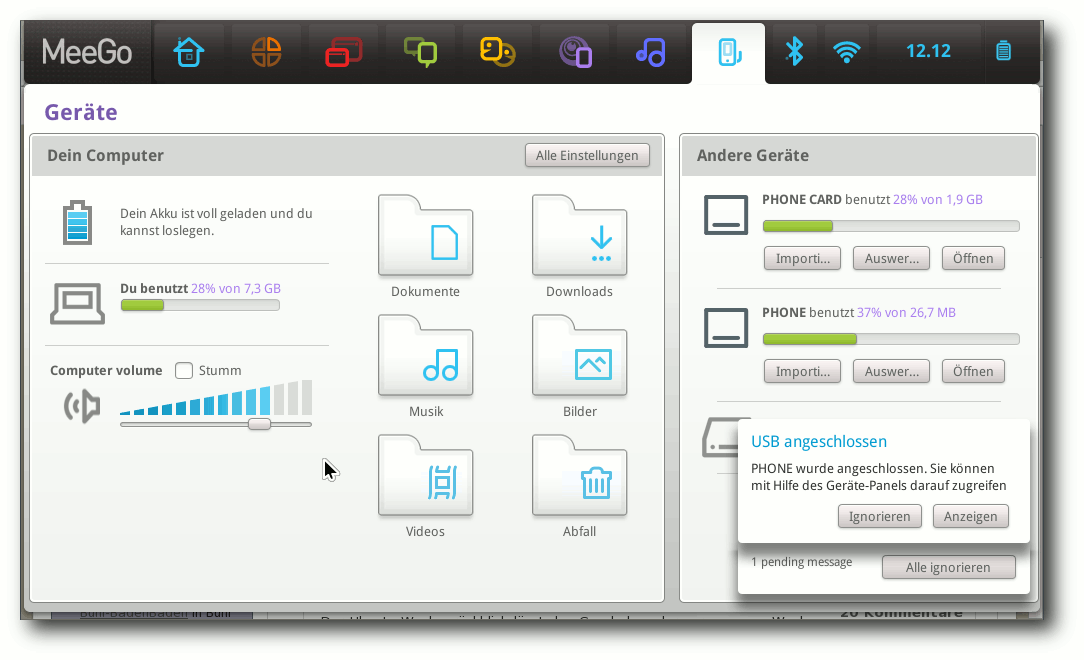

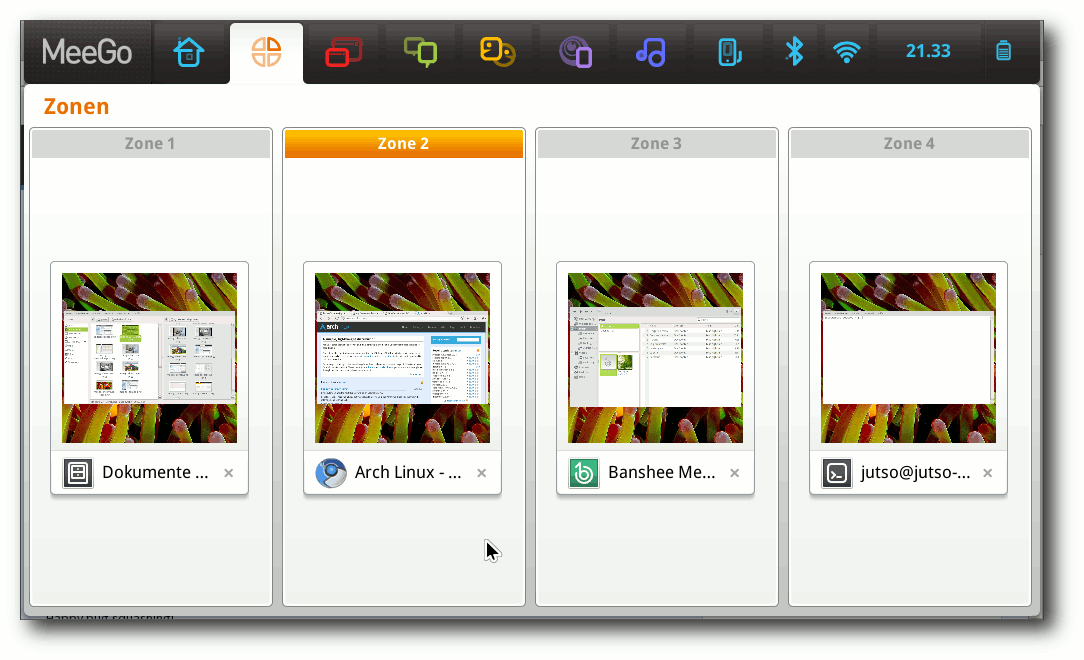

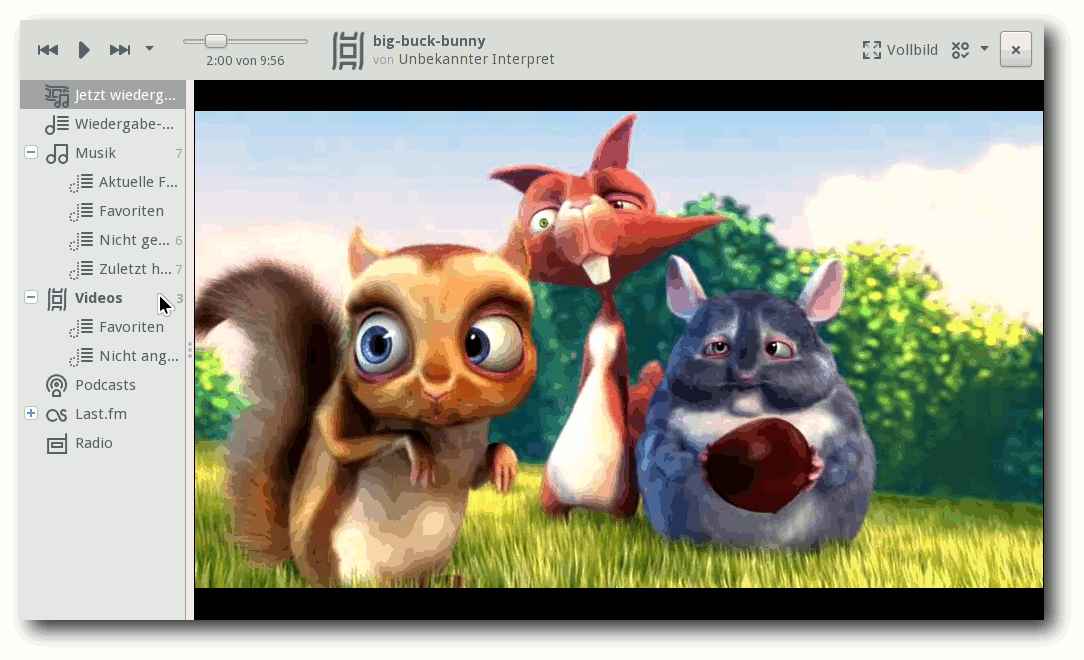

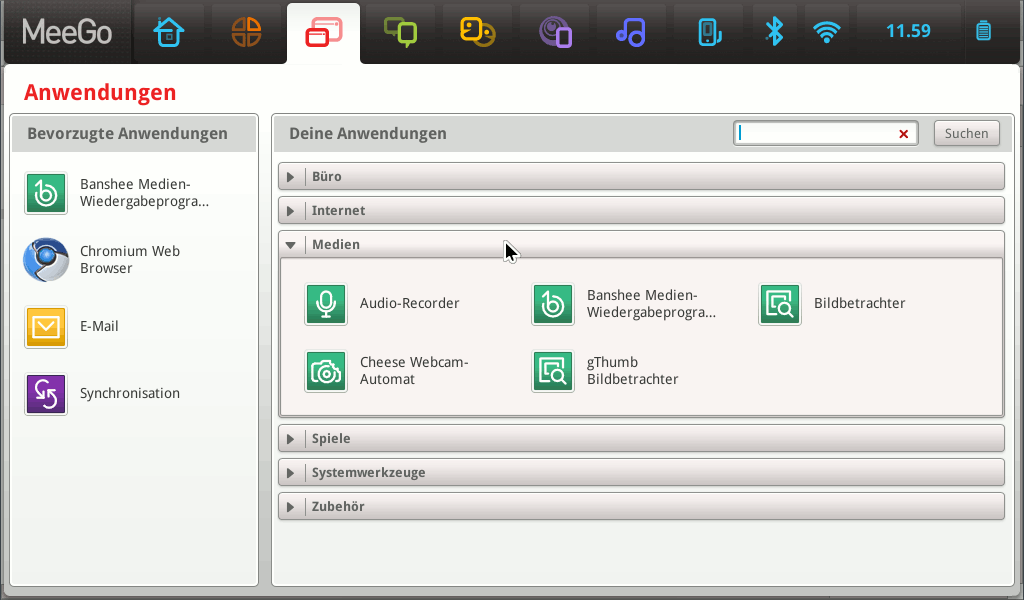

| Thorsten Schmidt | MeeGo im Blick | |

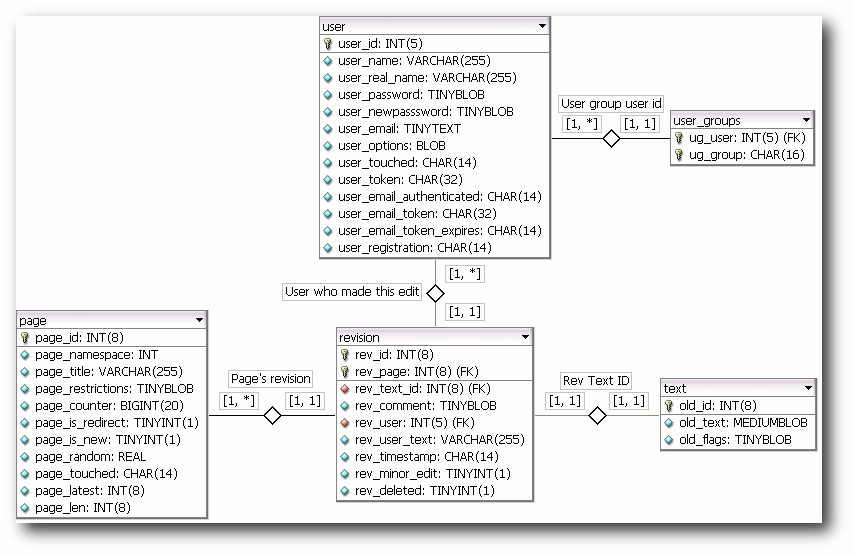

| Jochen Schnelle | NoSQL – Jenseits der relationalen Datenbanken, Rezension: Beginning CouchDB | |

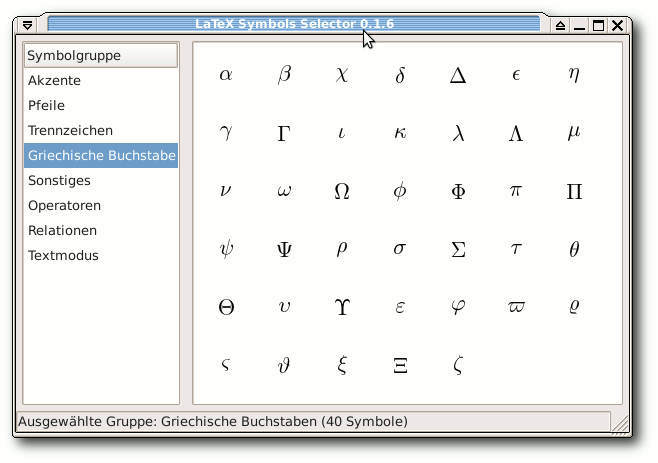

| Dominik Wagenführ | LaTeX-Symbole einfügen mit LSS, Rezension: Die Anarchie der Hacker | |

| Logo-Design | ||

| Arne Weinberg (GNU FDL) | ||

| Erscheinungsdatum: 1. August 2010 | ||

| Redaktion | ||

| Dominik Honnef | Thorsten Schmidt | |

| Dominik Wagenführ (Verantwortlicher Redakteur) | ||

| Satz und Layout | ||

| Tillo Bosshart | Ralf Damaschke | |

| Yannic Haupenthal | Nico Maikowski | |

| Sebastian Schlatow | Matthias Sitte | |

| Günther Wutz | ||

| Korrektur | ||

| Daniel Braun | Frank Brungräber | |

| Stefan Fangmeier | Mathias Menzer | |

| Karsten Schuldt | Franz Seidl | |

| Stephan Walter | ||

| Veranstaltungen | ||

| Ronny Fischer | ||

Soweit nicht anders angegeben, stehen alle Artikel und Beiträge in freiesMagazin unter der GNU-Lizenz für freie Dokumentation (FDL). Das Copyright liegt beim jeweiligen Autor. freiesMagazin unterliegt als Gesamtwerk ebenso der GNU-Lizenz für freie Dokumentation (FDL) mit Ausnahme von Beiträgen, die unter einer anderen Lizenz hierin veröffentlicht werden. Das Copyright liegt bei Dominik Wagenführ. Es wird die Erlaubnis gewährt, das Werk/die Werke (ohne unveränderliche Abschnitte, ohne vordere und ohne hintere Umschlagtexte) unter den Bestimmungen der GNU Free Documentation License, Version 1.2 oder jeder späteren Version, veröffentlicht von der Free Software Foundation, zu kopieren, zu verteilen und/oder zu modifizieren. Die xkcd-Comics stehen separat unter der Creative-Commons-Lizenz CC-BY-NC 2.5. Das Copyright liegt bei Randall Munroe.

Zum Index