Zur Version ohne Bilder

freiesMagazin Februar 2011 (ISSN 1867-7991)

Topthemen dieser Ausgabe

VirtualBox und KVM

Dieser Artikel stellt die Virtualisierungslösungen VirtualBox OSE (Open Source Edition) und KVM (Kernel-based Virtual Machine) in einem kleinen Projekt vor und zeigt auf, wie die gleichen Aktionen in beiden „Welten“ auf der Kommandozeile durchgeführt werden können. Auch wenn beide dasselbe Problem – Bereitstellen eines virtuellen Rechners zum Ausführen von Betriebssystemen und Applikationen – lösen, gibt es in den Details und insbesondere aus der Sicht des Nutzers einige Unterschiede. (weiterlesen)

Python – Teil 5: In medias res

Im vorherigen Teil dieser Einführung wurden Klassen besprochen. Mit diesem Teil soll nun ein Einstieg in die praktische Programmierung in Angriff genommen werden. Zunächst wird dazu aber noch auf die Fehlerbehandlung in Python eingegangen. (weiterlesen)

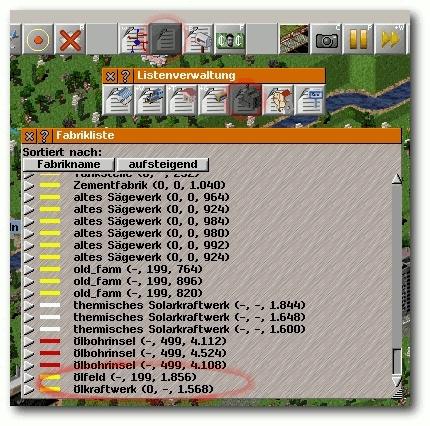

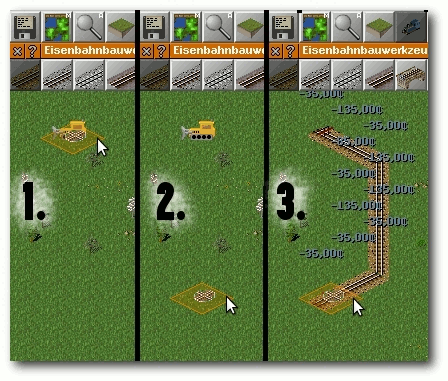

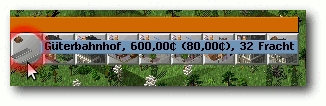

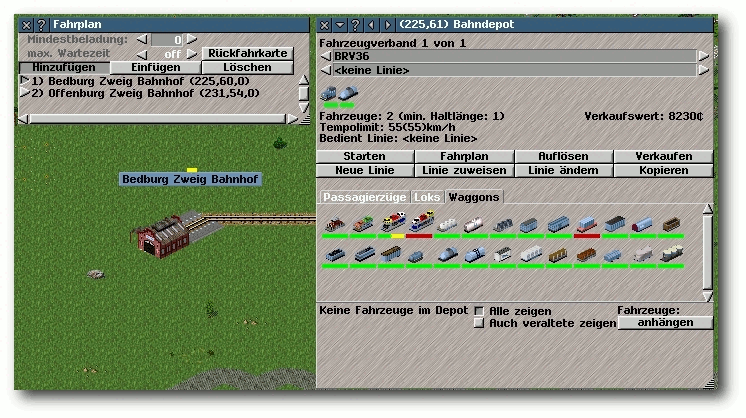

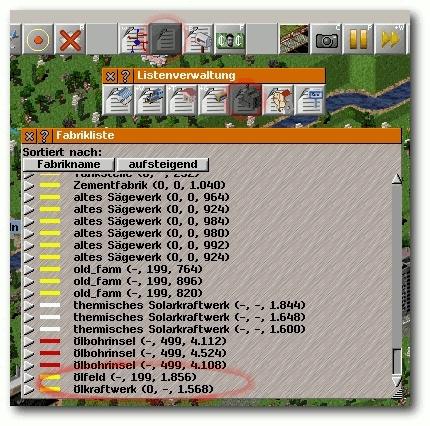

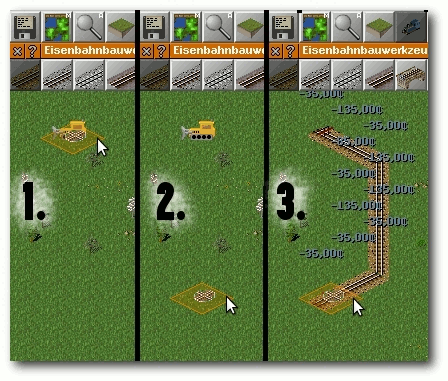

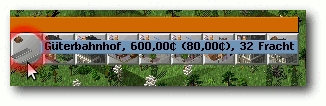

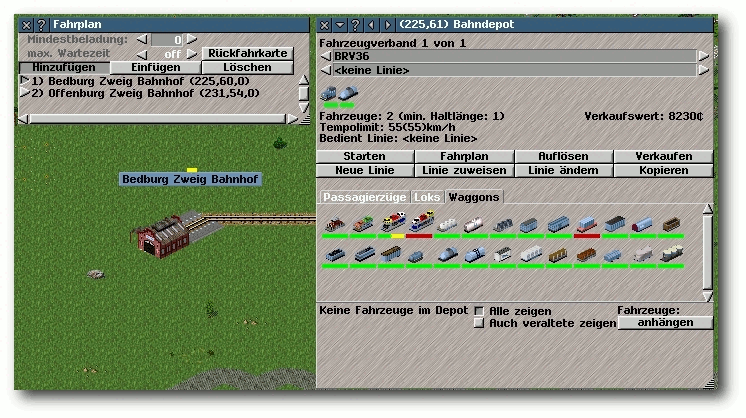

Simutrans – Schnelles Geld zu Lande, zu Wasser und in der Luft

Geld ausgeben ist nicht schwer, Geld verdienen dagegen sehr. Vom Tellerwäscher zum Multimillionär ist es nicht selten ein langer Weg und die Durchfallquote ist hoch. Wer in der Realität ungern mit harter Währung zockt, sollte alternativ in der Virtualität sein Glück versuchen. Eine nicht ganz ernstzunehmende Möglichkeit, aus dem Nichts ein florierendes Imperium zu erschaffen, ist Simutrans. Geld wird man aufgrund der freien Verfügbarkeit des Titels definitiv nicht verlieren und kleine Finanzgenies könnten an diesem Zeitvertreib Gefallen finden. (weiterlesen)

Zum Index

Linux allgemein

VirtualBox und KVM

Kernel-Crash-Analyse unter Linux

Der Januar im Kernelrückblick

Anleitungen

Python – Teil 5: In medias res

Software

Bottle – Ein WSGI-Framework für Python

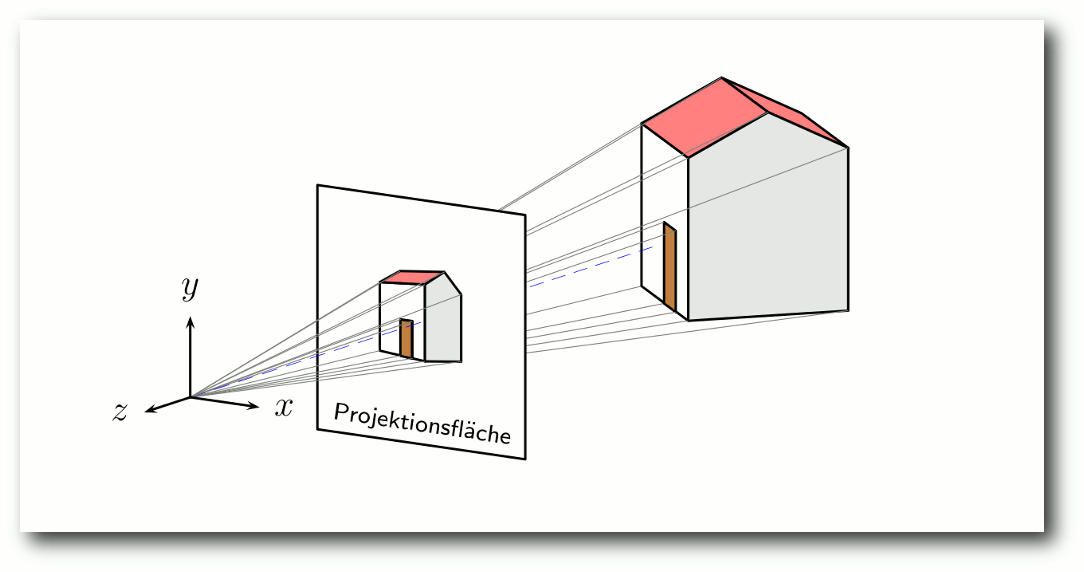

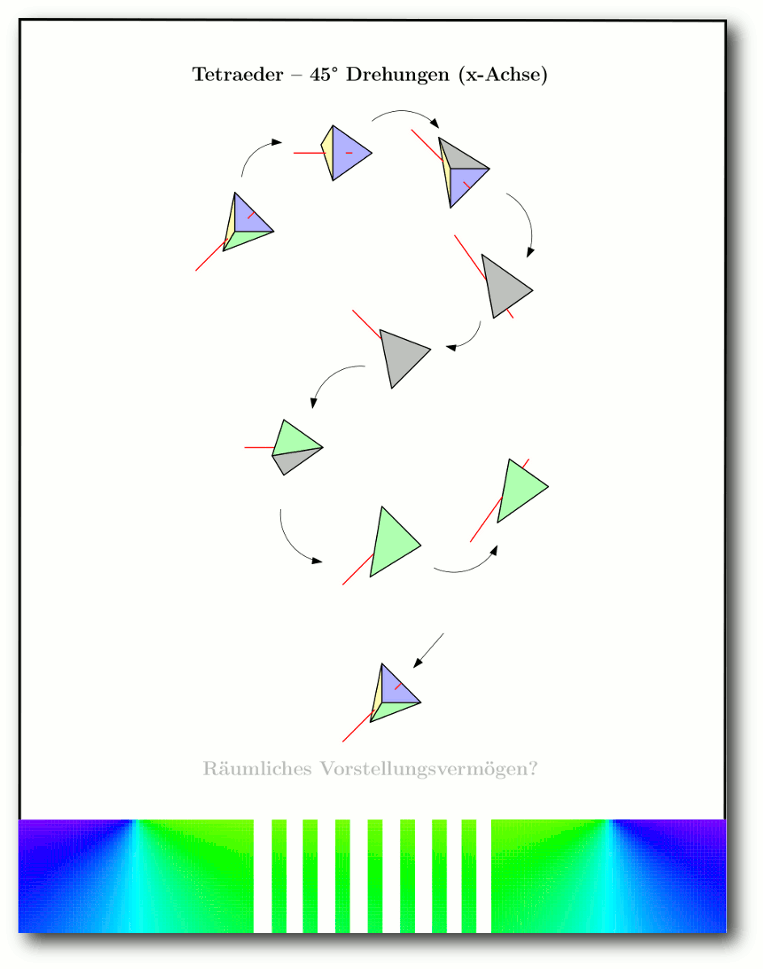

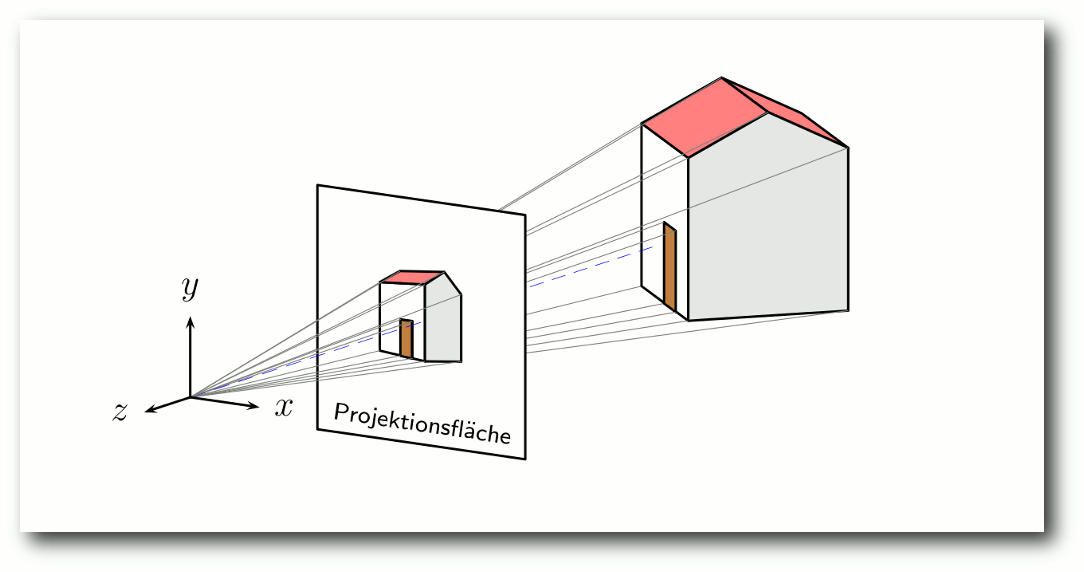

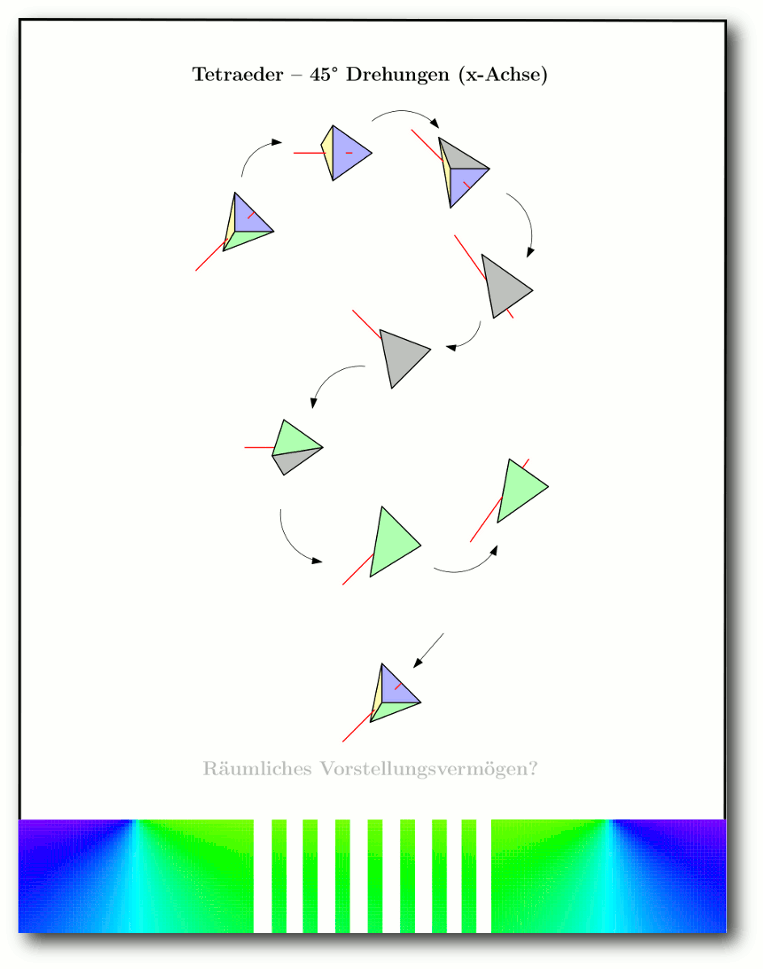

Sketch – 3-D-Grafikcode für LaTeX

Simutrans – Schnelles Geld zu Lande, zu Wasser und in der Luft

Community

Rezension: Bash – kurz & gut

Rezension: Root-Server einrichten und absichern

Magazin

Editorial

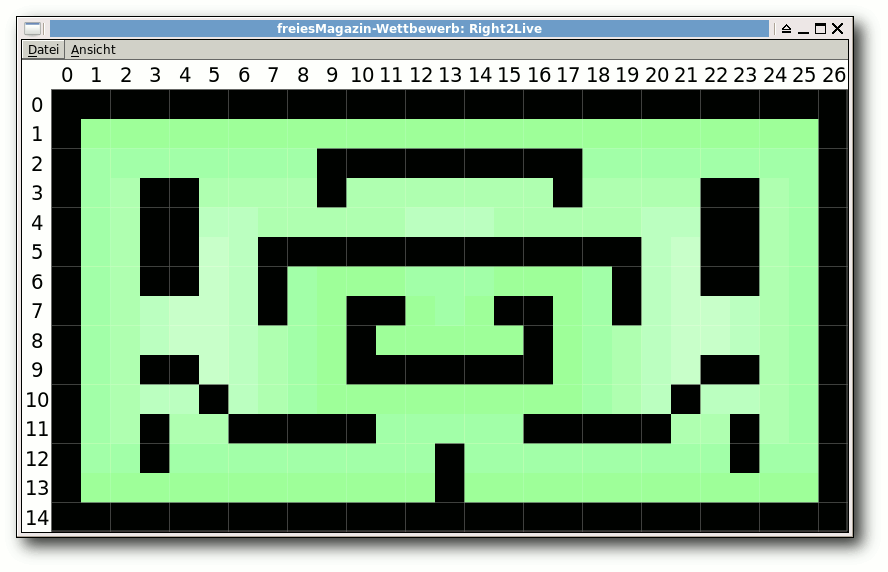

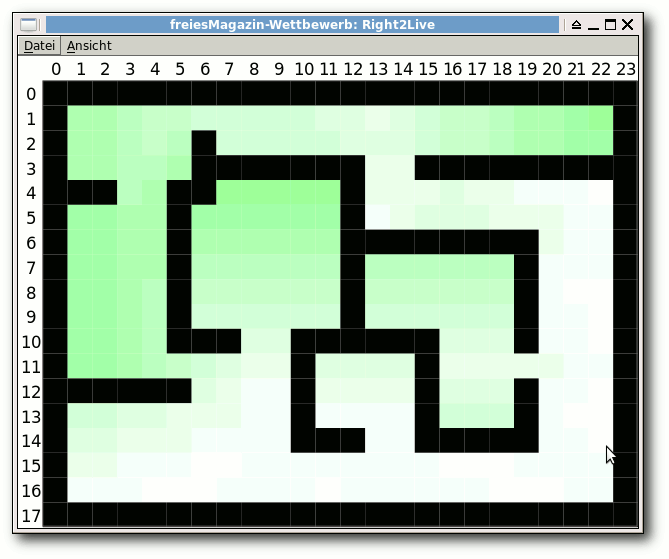

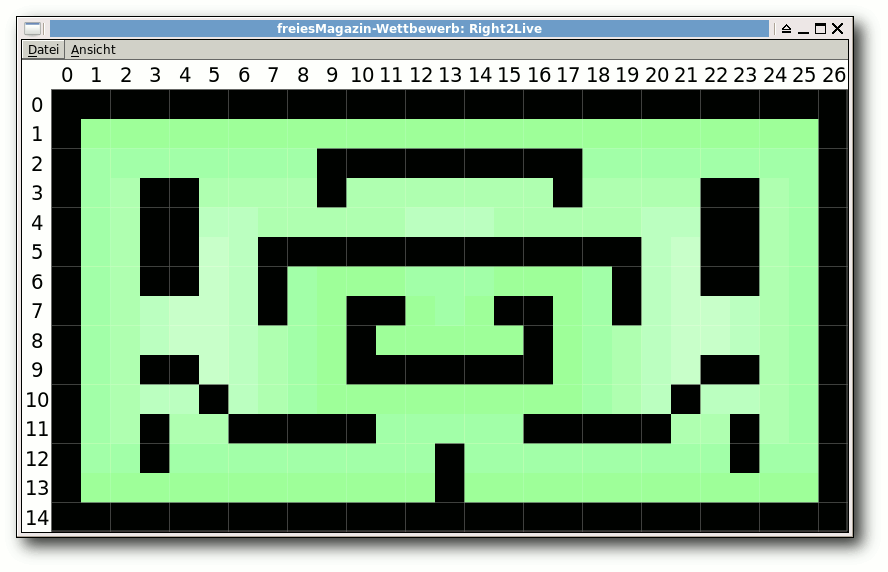

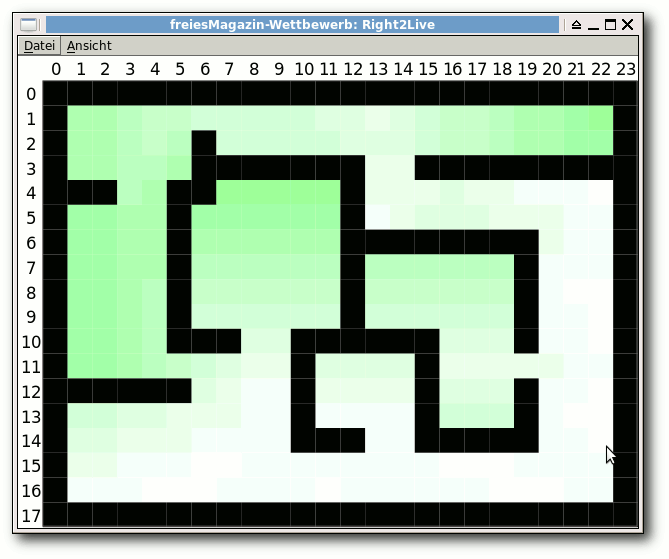

Dritter freiesMagazin-Programmierwettbewerb beendet

Leserbriefe

Veranstaltungen

Vorschau

Konventionen

Impressum

Zum Index

Und die Gewinner heißen …

Programmierer als Gewinner

Auf unserer Webseite konnte man es bereits kurz vor Weihnachten

nachlesen: Der dritter freiesMagazin-Programmierwettbewerb wurde beendet [1].

Die Auswertung dauerte dann über die Feiertage und die Gewinner konnten

sich am 6. Januar über ihre Preise freuen [2].

Die Anzahl der Teilnehmer war im Vergleich zu den vorherigen

Programmierwettbewerben eher enttäuschend. Es haben gerade einmal halb

so viele Programmierer teilgenommen wie zuvor. Die Gründe wollen wir

in einer Umfrage erfahren [3].

Wir freuen uns über jede Rückmeldung, um den nächsten Programmierwettbewerb attraktiver zu gestalten.

Alle weiteren Details zum Wettbewerb können im zugehörigen Artikel nachgelesen werden.

HTTP als Gewinner

Ab und an erhalten wir die Anfrage, wieso wir zum einen sowohl FTP-

als auch HTTP-Links zum Magazin angeben und zum anderen, wieso FTP

als Erstes genannt wird.

Beide Anfragen lassen sich leicht beantworten: Weil wir es können

und weil es schon immer so war. Dies sind natürlich keine befriedigenden

Antworten und um zu testen, ob HTTP oder FTP

bei den Lesern beliebter ist, haben wir ab November die Linkreihenfolge

in der Veröffentlichungsnachricht umgedreht, sodass HTTP zuerst genannt

wurde. Damit konnten wir testen, ob die Leser einfach nur den ersten

Link anklicken oder gezielt den FTP-Link wählen.

In der Vergangenheit war es so, dass die FTP-Version mit im Schnitt

300 Downloads vor der HTTP-Version lag. Nach der Umstellung der

Reihenfolge drehte sich dies gewaltig um und über FTP wurde freiesMagazin

nur noch halb so oft heruntergeladen wie über HTTP. Dies zeigt deutlich,

dass die vorherige Präferenz für FTP hausgemacht war und nur daran lag,

dass wir den FTP-Link als Erstes nannten.

Aus dem Grund haben wir den FTP-Link nun einfach gestrichen, da es

wirklich unsinnig ist, beide Version zu verlinken. Wer will, kann

natürlich immer noch den FTP-Server unter ftp://ftp.freiesmagazin.de/

durchforsten, aber wir werden den FTP-Link nicht mehr separat erwähnen.

Dies schafft hoffentlich bei Neulingen auch mehr Klarheit, da es nur

noch einen Link zur PDF-Version gibt.

ePub als Verlierer

Anfang Januar 2011 fragten wir, ob die Leser von freiesMagazin eine extra

Mobilausgabe neben der PDF- und den beiden HTML-Versionen

benötigen [4].

Insgesamt haben 490 Menschen

abgestimmt, wovon 41 % (202 Stimmen)

gar keine Mobilversion benötigen. Weitere 54 % (264 Stimmen) sind mit dem aktuellen Angebot (PDF und HTML) zufrieden und benötigen keine

weitere Mobilversion zum Angebot. Da Mehrfachnennungen zugelassen

waren, gibt es noch 20 % (100 Stimmen), die eine andere Mobilversion

(zum Beispiel im A5-Hochformat-PDF oder im ePub-Format [5]) wollten.

Obwohl die Nachfrage nach einer neuen Mobilversion sehr gering war,

haben wir uns dennoch umgeschaut, ob wir mit wenig Aufwand (!) eine

A5- oder eine ePub-Version erzeugen können. Die Ergebnisse waren leider

bescheiden. Eine A5-Version wäre möglich, würde aber an einigen Stellen

einen direkten Eingriff in die Artikel erfordern, weil es zahlreiche

Wörter bzw. Befehlsketten gab, die über den Rand hinausragten und die man

nicht mehr lesen konnte.

Noch etwas schlechter sah es bei einer Konvertierung in ePub aus [6].

Da wir LaTeX als Basis für freiesMagazin nutzen, bringt dies

Probleme mit, weil es keinen Konverter von LaTeX direkt nach ePub gibt. Das

PDF in ePub zu konvertieren ist wegen des dreispaltigen Layouts fast

unmöglich und lieferte keine guten Ergebnisse. Aber auch die HTML-Version

als Zwischenstufe war nicht nutzbar, da TTH [7] als Konverter ein wohl

eher schlechtes HTML als Ausgabe erzeugt. Bei der nachfolgenden

Konvertierung nach ePub fehlten zahlreiche Absätze, Links und

Überschriften. Öffnet man die HTML-Seite aber in einem Browser,

speichert sie ab und konvertiert dann nach ePub, sah das Ergebnis

annehmbarer aus, war aber noch weit entfernt von einem guten Layout.

Aus dem Grund haben wir uns entschieden, vorerst keine weitere Arbeit in eine

extra Mobilversion zu stecken. Der damit verbundene Aufwand wird durch

die Nachfrage nicht gerechtfertigt, vor allem da die Konvertierungshelfer

noch zu viele Probleme machen.

Wer aber eine Möglichkeit kennt, wie man ein ordentliches ePub

automatisiert erzeugen kann, kann uns unter  schreiben. Sobald

sich die Werkzeuge verbessern oder wir den Kniff heraus haben, steht

einer ePub-Veröffentlichung natürlich nichts im Wege. Wichtig ist

dabei immer, dass wir die vorliegenden TEX-Dateien nicht ändern

wollen. Maximal an der Formatierung (also alles, was über

LaTeX-Befehle beeinflusst wird) können wir etwas ändern.

Und nun wünschen wir Ihnen viel Spaß mit der neuen Ausgabe.

Ihre freiesMagazin-Redaktion

Links

schreiben. Sobald

sich die Werkzeuge verbessern oder wir den Kniff heraus haben, steht

einer ePub-Veröffentlichung natürlich nichts im Wege. Wichtig ist

dabei immer, dass wir die vorliegenden TEX-Dateien nicht ändern

wollen. Maximal an der Formatierung (also alles, was über

LaTeX-Befehle beeinflusst wird) können wir etwas ändern.

Und nun wünschen wir Ihnen viel Spaß mit der neuen Ausgabe.

Ihre freiesMagazin-Redaktion

Links

[1] http://www.freiesmagazin.de/20101220-dritter-programmierwettbewerb-beendet

[2] http://www.freiesmagazin.de/20110109-gewinner-des-dritten-freiesMagazin-programmierwettbewerbs

[3] http://www.freiesmagazin.de/20110130-umfrage-teilnahme-dritter-programmierwettbewerb

[4] http://www.freiesmagazin.de/20110110-umfrage-mobilversion-freiesmagazin

[5] http://de.wikipedia.org/wiki/Epub

[6] http://www.freiesmagazin.de/20110110-umfrage-mobilversion-freiesmagazin#comment-1627

[7] http://hutchinson.belmont.ma.us/tth/

Das Editorial kommentieren

Zum Index

von Hauke Goos-Habermann

Dieser Artikel stellt die Virtualisierungslösungen VirtualBox [1] OSE (Open Source Edition) und KVM [2]

(Kernel-based Virtual Machine) in einem kleinen

Projekt vor und zeigt auf, wie die gleichen Aktionen in beiden „Welten“ auf

der Kommandozeile durchgeführt werden können. Auch wenn beide dasselbe

Problem – Bereitstellen eines virtuellen Rechners zum Ausführen von

Betriebssystemen und Applikationen – lösen, gibt es in den Details und

insbesondere aus der Sicht des Nutzers einige Unterschiede.

Beide Lösungen stehen unter freien Lizenzen, bei VirtualBox gibt es zudem eine

nicht-freie Version, die unter der proprietären „VirtualBox Personal Use and

Evaluation License (PUEL)“ steht. Diese bringt zusätzliche bzw. andere

Funktionen mit, was aber in diesem Artikel nicht behandelt wird und für dieses

Projekt nicht weiter von Bedeutung ist.

Installation

Zuerst legt man ein neues Verzeichnis an, das die Daten für dieses Projekt

aufnehmen wird und wechselt in dieses.

KVM

Das für KVM essentielle Modul ist seit Linux 2.6.20 Teil des Kernels und

sollte daher bereits von jeder halbwegs aktuellen Distribution installiert

sein. Allerdings kann das Modul nur geladen werden, wenn die CPU über

Virtualisierungsfunktionen verfügt, ansonsten meldet das KVM-Modul einen

Fehler. Möchte man vorher

überprüfen, ob die eigene CPU KVM-tauglich ist, so muss das Flag

vmx bei Intel- und svm bei AMD-CPUs vorhanden sein.

Mit folgendem Einzeiler lässt sich dies leicht

überprüfen:

$ grep flags /proc/cpuinfo | egrep -c '(vmx|svm)'

Ist der Ausgabewert größer als 0, so steht der Verwendung von KVM nichts mehr im

Wege.

Zudem benötigt man noch die Pakete qemu-utils, kvm und

openvpn, die man über die Paketverwaltung installiert.

Nun lädt man das Skript VirtualBox-networking-setup.sh [3]

in das Projektverzeichnis herunter. Wie der Name

andeutet, wurde das Skript ursprünglich für VirtualBox geschrieben, um dort

Netzwerkbrücken und virtuelle Netzwerkschnittstellen anzulegen. Nun leistet es

dasselbe für KVM.

VirtualBox

VirtualBox OSE sollte sich ebenfalls in den Paketquellen der meisten

Distributionen – wenn auch nicht immer in der neuesten Version – befinden.

Da sich die Parameter von Version 2 zu 3 (meist doppeltes Minuszeichen

-- vor dem Parameter statt eines einfachen Minus - bei Version 2) leicht

geändert haben, ist darauf zu achten, dass VirtualBox in Version 3.x

installiert wird.

Ist VirtualBox in der eigenen Distribution zu alt, so gibt es die Möglichkeit,

eine aktuelle Version von der VirtualBox-Seite [4]

zu beziehen. Dort gibt es

vorkompilierte Pakete der unfreien VirtualBox für viele Distributionen und den

Quelltext der OSE zum Selberkompilieren. Vorkompilierte VirtualBox OSE-Pakete

für Debian Lenny gibt es bei den Dodger-Tools [5].

Ob man

VirtualBox OSE oder VirtualBox PUEL installiert, ist für die Beispiele in

diesem Artikel nicht wichtig.

Zu guter Letzt benötigt man noch das ISO-Abbild einer Linux-Distribution

(*BSD, Haiku, ReactOS, etc. sollten auch gehen). Welche man dafür wählt, ist

nicht entscheidend, man sollte sich aber mit deren Einrichtung auskennen.

Konfiguration

Nach der Installation muss man dafür sorgen, dass der eigene Benutzer in den

Gruppen kvm und vboxusers eingetragen ist, da dieser sonst keine

virtuelle Maschine (VM) starten kann.

Findet man die Benutzerverwaltung nicht auf Anhieb, kann man auch folgendes ausführen (BENUTZER durch den

Namen des eigenen Benutzers ersetzen) :

# adduser BENUTZER kvm

# adduser BENUTZER vboxusers

Damit die Gruppenzugehörigkeit wirksam wird, muss man sich aus- und wieder

einloggen. Das Skript

VirtualBox-networking-setup.sh bedarf noch einer kleinen Anpassung. So wird BENUTZER in der Zeile

user=BENUTZER ebenfalls durch den eigenen Benutzernamen ersetzt.

VM-Start vorbereiten

Da beide Virtualisierer nicht gleichzeitig betrieben werden können, muss vor

dem Laden des einen Kernel-Moduls das jeweils andere entfernt werden.

Zum Laden des VirtualBox-Moduls verwendet man

# /etc/init.d/vboxdrv start

und zum Entfernen

# /etc/init.d/vboxdrv stop

Bei KVM gibt es den kleinen Unterschied, dass je nach CPU-Typ (AMD oder Intel)

ein anderes Modul geladen bzw. wieder entfernt wird.

Zum Laden

# modprobe kvm-amd

bzw.

# modprobe kvm-intel

und zum Entfernen

# rmmod kvm-amd

bzw.

# rmmod kvm-intel

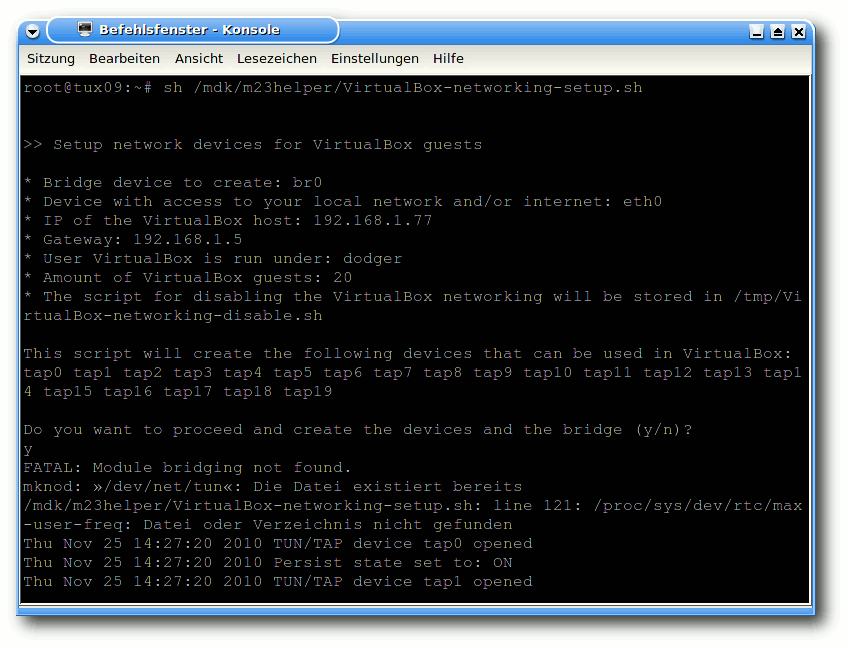

Für das Erstellen der Netzwerkbrücke führt man noch

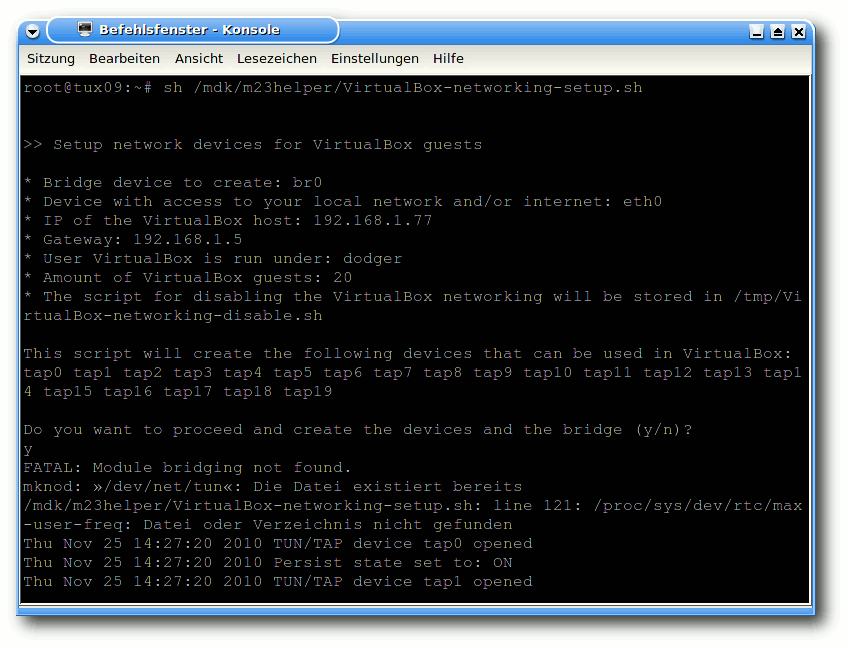

VirtualBox-networking-setup.sh aus (die Frage beantwortet man mit „Y“ + „Enter“):

# sh VirtualBox-networking-setup.sh

Ausgabe von VirtualBox-networking-setup.sh.

Nach einem Systemneustart muss das Skript erneut ausgeführt werden, da die

Erstellung nur temporär ist.

Die Netzwerkschnittstellen und die Netzwerkbrücke können auch wieder entfernt

werden (was aber im Normalfall nicht nötig sein sollte):

# /tmp/VirtualBox-networking-disable.sh

Virtuelle Festplatte vorbereiten

Ohne Festplatte geht auch bei virtuellen

Rechnern (fast) gar nichts. Diese

Festplatten, die in einer VM verwendet werden, liegen dabei meist als Dateien

vor. Sie verhalten sich aus der Sicht des in der VM ausgeführten

Betriebssystems wie eine herkömmliche Festplatte. Diese virtuellen Festplatten

können so angelegt werden, dass die dazugehörige Datei nur bis zum wirklich

benutzten Speicher anwächst und somit auf der physikalisch vorhandenen

Festplatte nur so viel Plattenplatz verwendet, wie benötigt wird. Man kann also

getrost eine etwas größere Maximalgröße angeben, auch wenn man nicht

beabsichtigt, diese auszuschöpfen. Denn nichts ist ärgerlicher als eine zu

kleine virtuelle Festplatte, die man nachträglich zu vergrößern versucht.

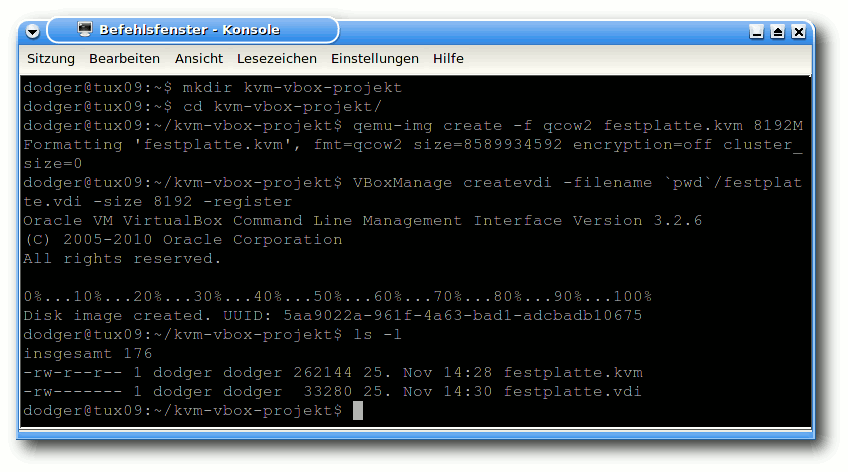

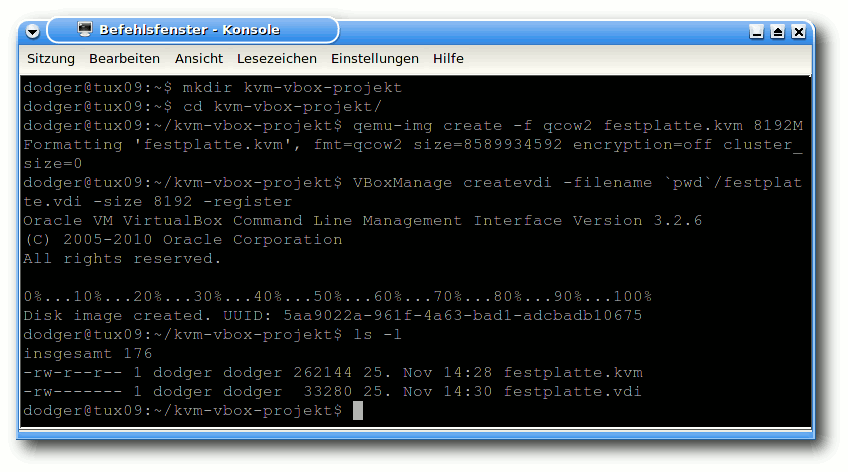

Das folgende Beispiel zeigt, wie eine 8 GB große Festplattendatei erzeugt wird.

Für KVM verwendet man das von QEMU stammende qemu-img:

$ qemu-img create -f qcow2 festplatte.kvm 8192M

Bei VirtualBox wird die Datei über das zentrale Verwaltungsprogramm

VBoxManage angelegt und gleichzeitig in einer internen Datenbank

registriert:

$ VBoxManage createvdi -filename festplatte.vdi -size 8192 -register

Anders als bei KVM landet die Datei nicht im aktuellen, sondern in einem von

VirtualBox dafür vorgesehenen Verzeichnis. Gibt man hingegen den vollen Pfad

an, so kann die Datei in jedem beliebigen Verzeichnis erstellt werden. So legt

das folgende Beispiel mit Hilfe von pwd die Datei im aktuellen

Verzeichnis an:

$ VBoxManage createvdi -filename `pwd`/festplatte.vdi -size 8192 -register

Anlegen der virtuellen Festplatten.

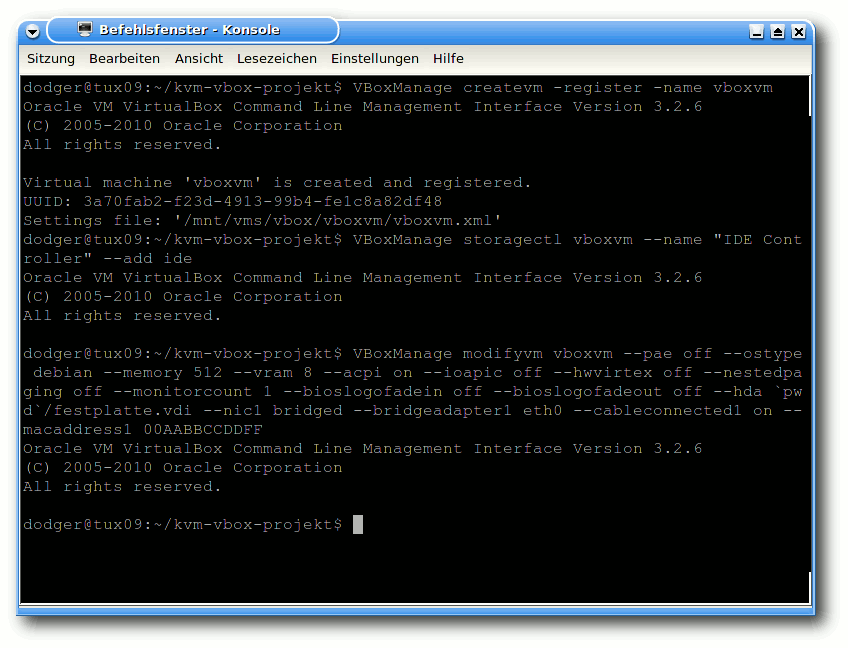

VMs anlegen

Bei VirtualBox muss man eine VM anlegen, um diese starten zu können. Bei

KVM ist dieser Schritt nicht vorgesehen.

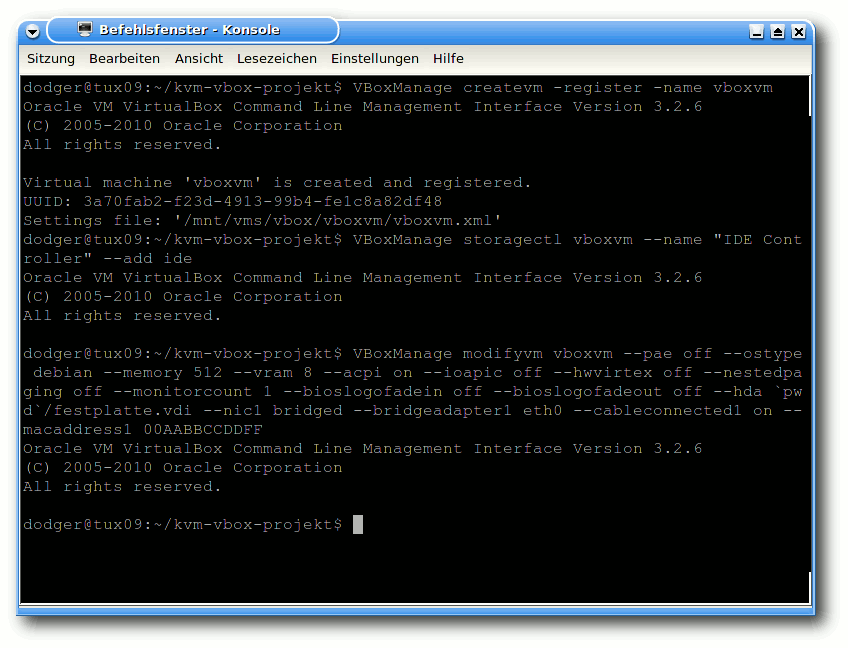

Mit dem bereits bekannten VBoxManage registriert man zunächst eine leere

VM:

$ VBoxManage createvm -register -name vboxvm

Diese wird im Folgenden um eine IDE-Schnittstelle erweitert, mit der jedes

Betriebssystem umgehen können sollte:

$ VBoxManage storagectl vboxvm --name "IDE Controller" --add ide

Erklärung der Parameter

Nun geht es ans Eingemachte. Dieses doch etwas längere Kommando konfiguriert

gleich eine Reihe von VM-Eigenschaften mit einem Schritt:

$ VBoxManage modifyvm vboxvm --pae off --ostype debian --memory 512 --vram 8 --acpi on --ioapic off --hwvirtex off --nestedpaging off --monitorcount 1 --bioslogofadein off --bioslogofadeout off --hda `pwd`/festplatte.vdi --nic1 bridged --bridgeadapter1 eth0 --cableconnected1 on --macaddress1 00AABBCCDDFF --boot1 dvd

Anlegen und Konfigurieren der VirtualBox-VM.

--pae off deaktiviert die sogenannte „Physical Address Extension“,

die auf 32-Bit-Maschinen für die Verwendung von mehr als 4 GB Arbeitsspeicher

erforderlich ist. Möchte man seiner VM mehr als 4 GB Arbeitsspeicher zuweisen,

so kann man die Option auch auf „on“ setzen, dies ist aber nur sinnvoll, wenn

man physikalisch mehr als 4 GB besitzt. Bei Aktivierung wird zudem eine CPU mit

Virtualisierungsfunktionen vorausgesetzt.

Der Parameter --memory 512 gibt an, dass 512 MB vom Arbeitsspeicher des

Wirtsrechners für die VM verwendet werden sollen. Andere Werte sind natürlich

auch möglich, nur sollte man darauf achten, dass für den Wirtsrechner noch

genügend zur Verfügung steht.

--ostype debian setzt das Profil für diese VM auf die

Debian-Distributionen. Das Profil setzt einige Einstellungen, die aber auch

separat konfiguriert werden können. Das passende Profil zu wählen ist

jedenfalls nie verkehrt. Mit

$ VBoxManage list ostypes

können alle von VirtualBox bekannten Betriebssysteme und Distributionen

aufgelistet werden.

Durch das Deaktivieren der „Nested paging“-Erweiterung (zum Ausführen

einer VM innerhalb

einer anderen VM) mittels --nestedpaging off

funktioniert die VM auch auf CPUs ohne Virtualisierungsfunktionen.

--monitorcount 1 legt die Anzahl der angeschlossenen (virtuellen)

Monitore fest.

Die beiden Optionen --bioslogofadein off --bioslogofadeout off

beschleunigen durch Entfernen der Einblendung von Logos das Starten der VM.

Mittels --hda `pwd`/festplatte.vdi wird die gerade angelegte virtuelle

Festplattendatei an das (virtuelle) Master-Kabel der IDE-Schnittstelle

„angeschlossen“.

Die Parameter --nic1 bridged --bridgeadapter1 eth0 versetzen die erste

(virtuelle) Netzwerkkarte mit der physikalischen

Netzwerkschnittstelle

„eth0“ in den Netzwerkbrücken-Modus („bridged“). „eth0“ sollte

hierbei die Schnittstelle sein, die mit dem übrigen Netzwerk (bzw. Internet)

kommunizieren kann.

--cableconnected1 on „steckt“ das virtuelle Netzwerkkabel in die

virtuelle Netzwerkschnittstelle, damit das Betriebssystem die Netzwerkkarte verwenden kann und nicht meldet, dass das

Kabel nicht angeschlossen sei.

--macaddress1 00AABBCCDDFF gibt der Karte noch die benötigte

MAC-Adresse. Möchte man mehrere VMs anlegen, so muss die virtuelle MAC-Adresse

angepasst werden, da es keine zwei Rechner

mit gleicher MAC geben darf. Für jede der insgesamt 12 Stellen

darf dafür eine Hex-Zahl,

also eine Ziffer von 0-9 oder ein Buchstabe von A-F, verwendet werden.

--boot1 dvd legt fest, dass die VM von einem virtuellen DVD-Laufwerk

booten soll.

CD/DVD-ISO „einlegen“

Bei VirtualBox wird das ISO-Abbild in das virtuelle CD/DVD-Laufwerk eingelegt.

Im folgenden wird davon ausgegangen, dass das ISO

xubuntu-10.10-desktop-i386.iso heißt und im Projekt-Verzeichnis

liegt. Von dort aus setzt man folgenden Befehl ab:

$ VBoxManage storageattach vboxvm --storagectl "IDE Controller" --type dvddrive --medium `pwd`/xubuntu-10.10-desktop-i386.iso --port 0 --device 1

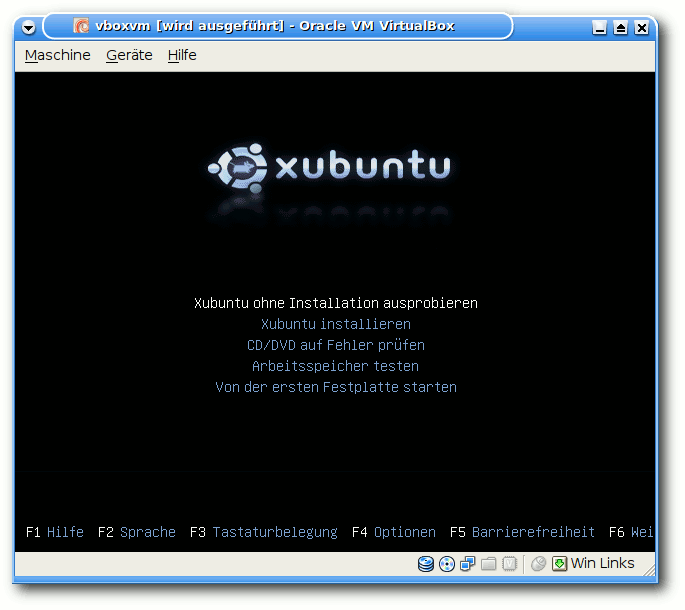

Ein Betriebssystem installieren

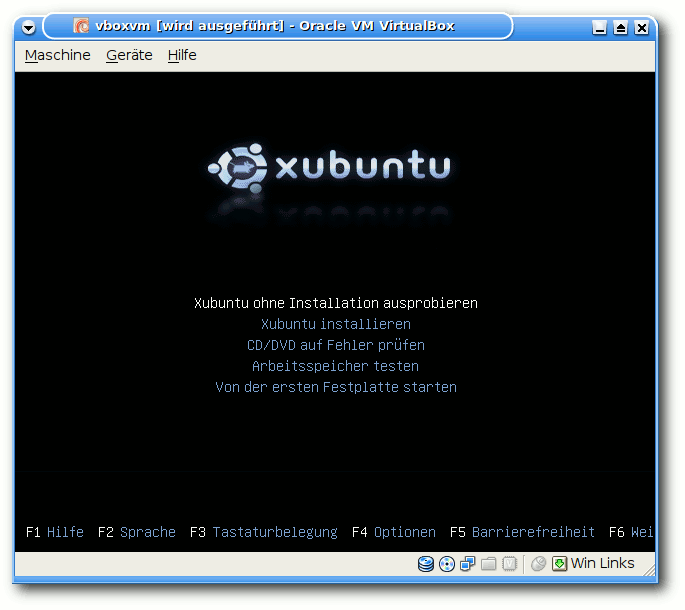

Nach den Vorarbeiten an der VirtualBox-VM ist das Starten ganz einfach:

$ VBoxManage startvm vboxvm --type gui

Neben dem Typ gui, der das VM-Fenster mit einem Menü versieht, gibt es

noch sdl (ohne Menü) sowie headless, womit jegliche Ausgabe

verhindert wird – was nur sinnvoll ist, wenn man die VM bereits installiert hat

und nur noch als Server verwenden und z.B. per SSH darauf zugreifen will.

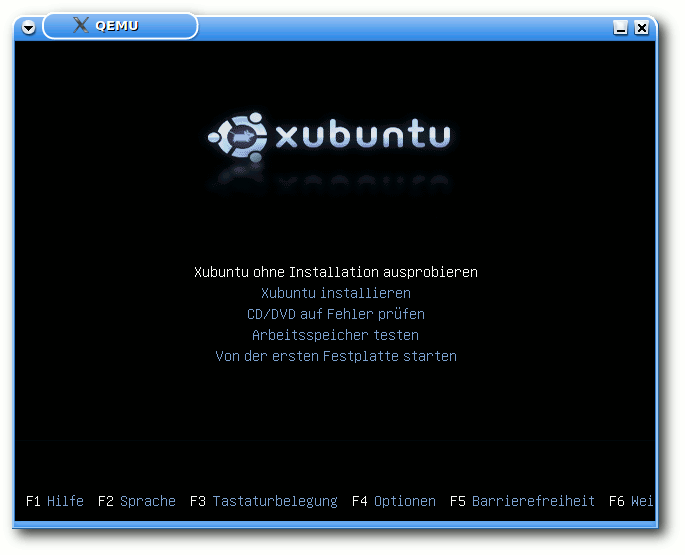

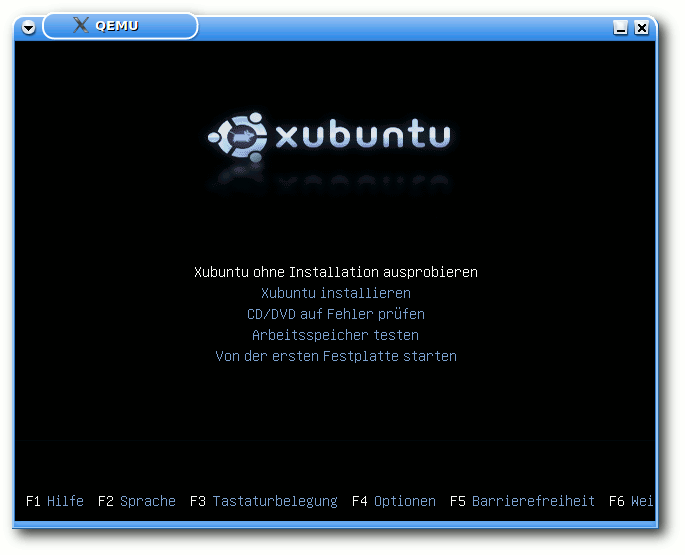

Gestartete Xubuntu-CD in VirtualBox.

KVM kennt keine Konfiguration wie VirtualBox. Um die KVM-VM zu starten, genügt

folgende Zeile:

$ kvm -m 512 -boot d -cdrom xubuntu-10.10-desktop-i386.iso -hda festplatte.kvm -net nic,model=rtl8139,vlan=0,macaddr=00:AA:BB:CC:DD:FF -net tap,ifname=tap0,script=/bin/true

-m 512 gibt wiederum die Größe des Arbeitsspeichers an, -boot d

legt das CD/DVD-Laufwerk als Bootmedium fest, -cdrom xubuntu-10.10-desktop-i386.iso

legt das ISO in das Laufwerk und -hda

festplatte.kvm dient zum Verbinden des (noch leeren) Festplattenabbildes mit

der VM. Die Konfiguration der

Netzwerkkarte -net nic,model=rtl8139,vlan=0,macaddr=00:AA:BB:CC:DD:FF ist ähnlich wie bei

VirtualBox. Hinzu kommt hier die Wahl der virtuellen Netzwerkschnittstelle

„tap0“ bei -net tap,ifname=tap0,script=/bin/true.

Möchte man mehrere

KVM-VMs parallel laufen lassen, so ist neben einer neuen MAC-Adresse auch die

nächste freie tapX zu wählen. Das Skript VirtualBox-networking-setup.sh

legt in der Standardeinstellung gleich 20 Stück von tap0 bis tap19 an.

Gestartete Xubuntu-CD in KVM.

VM starten

Hat man das Betriebssystem auf der virtuellen Platte installiert, so möchte

man wahrscheinlich nun von dieser starten.

Unter VirtualBox verändert man die Konfiguration der VM, sodass diese als erstes

von der Festplatte bootet:

$ VBoxManage modifyvm vboxvm --boot1 disk

Danach kann (wie zuvor beschrieben mittels VBoxManage startvm ...) die VM normal

gestartet werden.

Bei KVM wird die Zeile an einer Stelle angepasst und aus -boot d wird nun

-boot c:

$ kvm -m 512 -boot c ....

Fazit

Wie auf vielen anderen Gebieten ist es eine Geschmacksfrage, welchen der beiden

vorgestellten Virtualisierer man verwendet.

Aus meiner Sicht gibt es nichts, was prinzipiell gegen einen der beiden

Kandidaten sprechen würde. Sie lassen sich beide in (nahezu)

jedem Projekt

verwenden. Hat man es mit älteren Rechnern ohne Virtualisierungsfunktionen zu

tun, so scheidet KVM leider aus, auch kann VirtualBox unter einer Vielzahl von

Betriebssystemen (Linux, FreeBSD, Windows, Mac OS X/Intel, Solaris und OS/2)

betrieben werden. KVM bietet hingegen den Vorteil, dass es seit geraumer Zeit

in jedem Linux-Kernel vorhandenen ist und damit immer ohne Patches

funktioniert.

Links

[1] http://www.virtualbox.org

[2] http://www.linux-kvm.org/

[3] http://sourceforge.net/projects/dodger-tools/files/VirtualBox-OSE/VirtualBox-networking-setup.sh/download

[4] http://www.virtualbox.org/wiki/Downloads

[5] http://dodger-tools.sourceforge.net/cms/index.php?id=100000005

| Autoreninformation |

| Hauke Goos-Habermann (Webseite)

arbeitet freiberuflich als Entwickler und Trainer für

Linux und Open-Source-Software. Er ist zudem Hauptentwickler des

Softwareverteilungssystems m23 und weiterer OSS sowie Mitorganisator der Kieler

Open Source und Linux Tage.

|

| |

Diesen Artikel kommentieren

Zum Index

von Mirko Lindner

In einer idealen Welt stürzen weder Systeme noch Applikationen ab.

Da die Welt nun mal weder ideal noch der Mensch in der Lage ist, ab

einer gewissen Komplexität fehlerfreie Programme zu schreiben, hat

wahrscheinlich jeder schon einmal einen Absturz gesehen. Dieser

Artikel zeigt, wie Abstürze des ganzen Systems funktionieren, wie

sie korrekt gehandhabt und wie sie untersucht werden können.

Redaktioneller Hinweis: Der Artikel „Kernel-Crash-Analyse unter Linux“ erschien erstmals bei Pro-Linux [1].

Die graue Theorie

Der Linux-Kernel ist zweifelsohne ein solides System. Er ist für

seine Größe stabil, durchaus fehlertolerant und bietet wenig

Möglichkeiten zum Angriff. Doch auch Linux ist von Fehlern nicht

gefeit. Wohl jeder hat schon mal in seinem Leben einen Absturz oder

ein sogenanntes Oops [2] gesehen.

Prinzipiell sind Oopses nichts Schlimmes, zeugen sie in der Regel

nur von einem Fehlverhalten eines Subsystems, das so gravierend war,

dass es dem Programmierer wichtig war, den Anwender davon in

Kenntnis zu setzen. Viele solcher Fehler führen weder zum Stillstand

noch zum Absturz des Kernels. Oftmals sind es eher informierende

Ausgaben, die beispielsweise dem Anwender davon berichten, dass ein

bestimmtes System nicht korrekt abgemeldet wurde, während ein

Treiber entladen wurde. Ein Beispiel wären hier diverse

/proc-Einträge, die bei der Abmeldung eines Treibers vergessen wurden.

Solche Fehler handhabt der Kernel in der Regel, ohne das System

stoppen zu müssen. Sie können mitunter auch oft passieren, ohne dass

ein Anwender etwas davon mitbekommt. Oftmals müssen diverse

Debug-Einstellungen eingeschaltet werden, damit solche Ausgaben

sichtbar sind.

Viel dramatischer sind Fehler, die zum Stillstand des Systems

führen. Typischerweise sind es NULL-Pointer oder Zugriffe auf

falsche Speicherbereiche im Kernel. Dabei spielt es keine Rolle, ob

solche Zugriffe von Linux selbst oder von einem Treiber durchgeführt

werden – alle Speicherfehler führen zum sofortigen Stillstand des

Systems. Sofort?! Nein, nicht wirklich.

Auch wenn es den Anschein hat, dass der Kernel nach einem Fehler

abgestürzt ist, ist dem nicht so. Am besten lässt es sich an der

Meldung des Oopses selbst verdeutlichen. Der Oops selbst ist eine

normale Kernel-Funktion, die in der Datei traps.c residiert. Die

beiden für die Anzeige von Oops verantwortlichen Funktionen

dump_stack() und show_trace() sind Funktionen, die regulär verlassen

werden. Die eigentliche Behandlung eines Fehlers nach einem Oops

erfolgt später direkt im Kernel oder im System, das einen Oops

gemeldet hat.

Ein Beispiel gefällig? Die allseits bekannte Meldung „BUG: unable to

handle kernel NULL pointer dereference“ versteckt sich auf

x86-Systemen in der Funktion vmalloc_fault() und der Datei fault.c.

Doch erst der Aufruf von do_exit(SIGKILL) am Ende von

vmalloc_fault() und eine abschließende Schleife am Ende von

do_exit() oder der Aufruf von panic() versetzen den Kernel in eine

Endlosschleife und machen dem System die Lichter aus. Bis dahin ist

der Kernel durchaus in der Lage, noch zu interagieren und unter

Umständen diverse Systeme herunterzufahren oder gar zu starten.

Arten von Kernel-Debugging

Ist ein Kernel erst einmal gestoppt, stehen dem Entwickler nur

begrenzt Möglichkeiten zur Verfügung, den Fehler zu untersuchen. Im

Gegensatz zu Applikationen, die im Userspace gestartet werden,

wirken sich Fehler im Kernel sofort auf das komplette System aus. Da

aber der Kernel nach einem Absturz immer noch funktional ist, ist es

durchaus verständlich, dass sich diverse Entwickler Gedanken über

eine Möglichkeit gemacht haben, diese Tatsache für weitere

Untersuchungen zu nutzen.

Die wohl populärste Möglichkeit, Fehler im Kernel zu untersuchen,

stellt dabei printk() dar. printk() ist nichts anderes als das

Pendant für printf() im Kernel. Es bedarf allerdings wenig

Vorstellungsvermögen, um zu erkennen, dass die Untersuchung von

Fehlern mittels printk() nicht nur Erfahrung in der Programmierung

des Kernels erfordert, sondern auch nur bedingt für eine

Ferndiagnose eingesetzt werden kann. Vor allem komplizierte Probleme

lassen sich mit printk() unter Umständen recht schwer lokalisieren.

Dies führte zu einer zweiten Möglichkeit – den Oops-Meldungen.

Entgegen des ersten Eindrucks stellen diese Meldungen für einen

Programmierer eine extreme Bereicherung dar. Sie beinhalten oftmals

alle Informationen, die zur Lösung eines Problems benötigt werden.

Der einzige Wermutstropfen ist lediglich, dass sie manchmal von

Anwendern nicht korrekt interpretiert oder bei manchen Fehlerarten

(Schleifen, Deadlocks usw.) nicht ausgegeben werden. Ferner können

zum Beispiel Speicherbereiche so korrumpiert sein, dass auch die

Oops-Meldungen keinen Mehrwert mehr bieten.

Hier greift nun die dritte Möglichkeit: Debugging. Zwar hat diese

Art der Fehleruntersuchung erst recht spät in den Kernel Einzug

gehalten, doch stellt sie oftmals die einzige Möglichkeit dar,

komplizierte Fehler in einer vertretbaren Zeit zu finden. Das wohl

bekannteste Werkzeug stellt dabei der ursprünglich als Patch

implementierte und seit der Version 2.6.26 im Kernel vorhandene

KGDB [3] dar.

Das eigentliche Debugging wird dabei mit GDB per

Remote-Protokoll auf einem zweiten System ausgeführt.

Die wohl ergiebigste Art, Fehler zu untersuchen, stellen allerdings

Crash-Dump-Tools dar. Im Gegensatz zu anderen Ansätzen bedarf es

hier nicht der direkten Mitarbeit des Entwicklers. Ferner beinhalten

Crash-Dumps, sofern sie vollständig sind, alle drei oben genannten

Arten der Diagnose, sodass der Entwickler auf eine schier

unerschöpfliche Fülle an Informationen zurückgreifen kann. Die zwei

bekanntesten Werkzeuge sind dabei kdump und LKCD (Linux Kernel Crash

Dump [4]), wobei das letztgenannte bereits

eingestellt wurde.

kdump

Die Geschichte von Crash-Dumps im Linux-Kernel reicht in das Jahr

1999 zurück. Entgegen der Gepflogenheiten anderer Unix-Systeme

verfügte Linux nicht von Anfang an über eine Einrichtung, die es

ermöglichte, Crash-Dumps zu erstellen. Erst mit einem Patch im Jahre

1999 führte SGI mit dem LKCD (Linux Kernel Crash Dump) einen ersten

Versuch ein, Crash-Dumps zu nutzen. 2002 folgte ein zweiter, von Red

Hat initiierter, unter dem Namen Netdump, gefolgt 2004 von Diskdump.

Doch erst 2006 mit der im Kernel adaptierten kdump-Technologie

konnte Linux Crash-Dumps korrekt handhaben.

Technisch gesehen besteht kdump [5]

aus zwei voneinander separierten Bereichen: kexec und kdump. kexec

stellt dabei ein Fastboot-Mechanismus dar, der in der Lage ist,

einen weiteren Kernel zu starten, ohne dass die Hardware zuvor vom

BIOS initialisiert werden musste. Der eigentliche kdump stellt

dagegen den eigentlichen Mechanismus zur Speicherung von Crash-Dumps

dar.

Funktionsweise

Wirft man einen flüchtigen Blick in die Funktion panic(), so findet

man bereits vor der Abschaltung der SMP-Funktionen einen Aufruf von

crash_kexec(). Die in kexec.c enthaltene Funktion startet wie zuvor

angemerkt aus einem laufenden Kontext einen neuen Kernel. Damit

dieser nicht zuvor benutzte Bereiche überschreibt und möglichst

einen unverfälschten Dump des Systems wiedergeben kann, muss ein

Bereich im Speicher reserviert werden, in den der neue Kernel

kopiert werden kann. Üblicherweise beträgt die Größe des neuen

Speichers um die 128 MB und wird dem Kernel direkt als Bootparameter

übergeben, weshalb der Kernel nach der Installation von kdump neu

gestartet werden muss.

Angemerkt sei auch, dass der neue Kernel nicht zwangsläufig ein

wirklich neuer sein muss. Alternativ ist kexec auch in der Lage, auf

Systemen, die einen relokierbaren Kernel unterstützen (i386, x86_64,

ppc64 und ia64), denselben Kernel zu nutzen. In diesem Fall ist der

Crash-Kernel derselbe wie der ursprüngliche Kernel.

Ist der neue Kernel gebootet, startet dieser einen eigenen

Init-Prozess und bindet die in der Konfiguration festgelegte

Partition ein, auf die der Kernel-Dump geschrieben werden soll. Darüber

hinaus wird der kdump-Service gestartet, der wiederum einen Dump des

Systems durchführt. Ist alles erledigt, bleibt das System stehen

oder bootet neu, je nach Konfiguration.

Der Vorteil dieser Lösung ist ihre Flexibilität und ihre

Anpassbarkeit. Es bedarf weder

Änderungen im Kernel noch neuen

Funktionen, um die Dump-Funktion zu erweitern. Prinzipiell kann

jeder Anwender seine Dumps zusammenstellen und erweitern. Durch die

Nutzung eines separaten Kernel-Prozesses ist zudem immer sichergestellt,

dass das System zum Zeitpunkt der Generierung des

Crash-Dumps nicht korrumpiert war. Ferner lassen sich so auch

potentielle Probleme lösen, die unter Umständen dazu führen könnten,

dass der Dump beim Speichern auf das Dateisystem beschädigt werden

könnte.

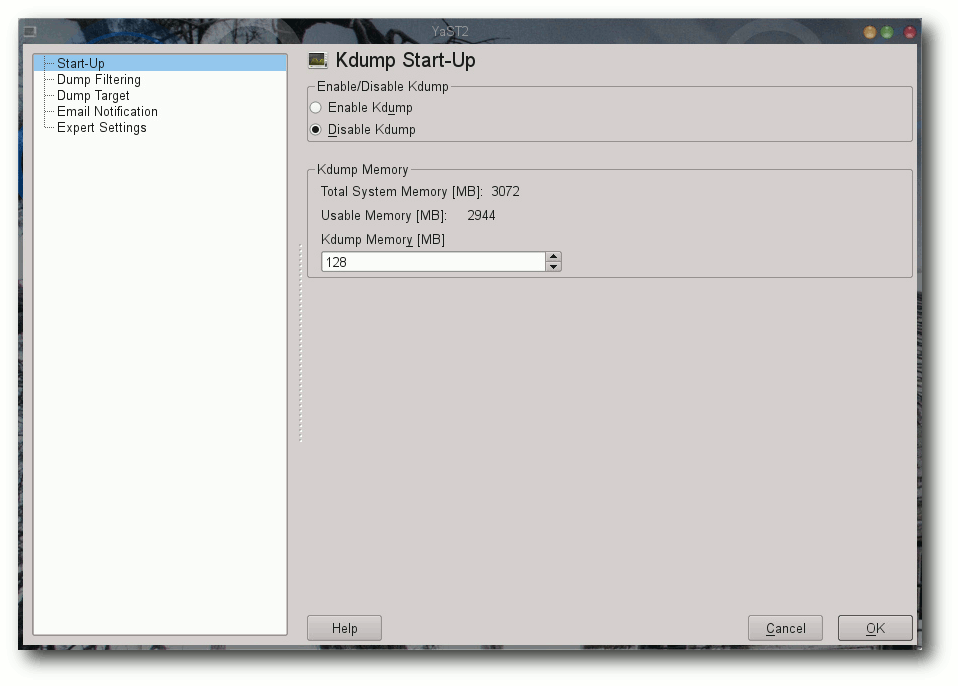

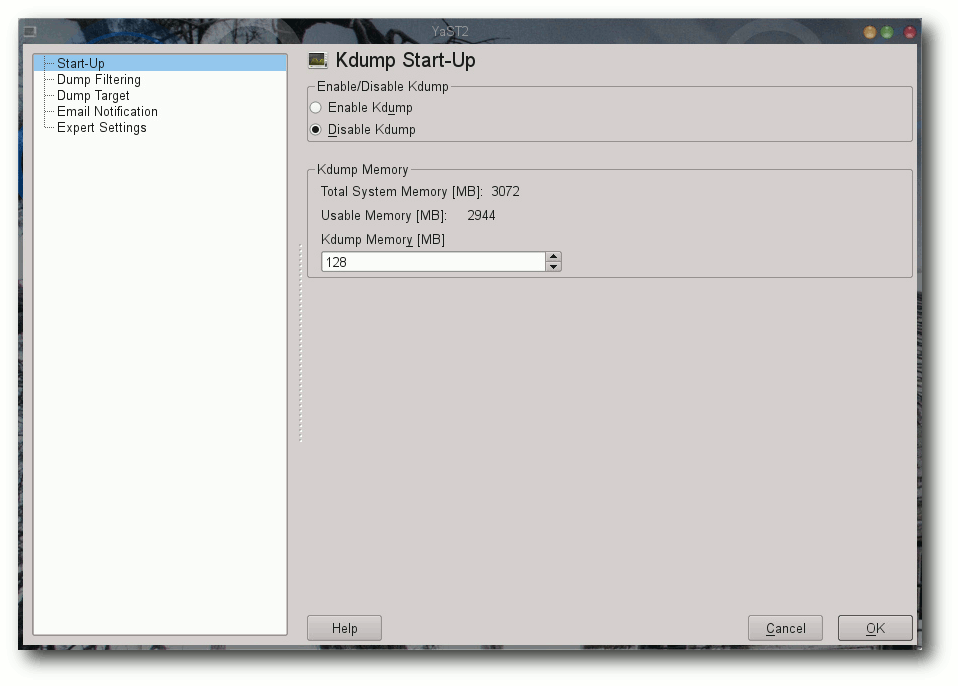

Grafische kdump-Konfiguration in openSUSE 11.3.

Installation

Die Installation des Systems beschränkt sich in den meisten

Distributionen auf die Installation

des Pakets kexec-tools.

Alternativ, wie im Falle von Red Hat Enterprise Linux oder openSUSE,

können noch Management-Tools installiert werden.

Anwender, die lieber ihre eigenen Versionen der Tools installieren

möchten, können es alternativ selbst kompilieren. Der Download ist

von der Seite des Projektes möglich. Die Installation ist dabei recht

unkompliziert:

$ ./configure

$ make

# make install

Ist die Applikation installiert, bedarf es der eigentlichen

Konfiguration. Wie bereits erwähnt bringen diverse Distributoren

bereits von Haus aus diverse grafische Werkzeuge mit, die die

Einrichtung des Systems erleichtern. Der Umfang und die

Funktionalität der Tools orientiert sich dabei maßgeblich am Umfang

der kdump-Funktionalität, die vom Distributor erstellt wurde.

Während beispielsweise RHEL 5 nur marginale Änderungen ermöglicht,

erlaubt das in Yast eingebundene Programm weitaus mehr Funktionen und

Einstellungen.

Anwender, die kdump aus den Quellen installiert haben, haben

freilich die Qual der Wahl, da sie faktisch sowieso alles selbst

einstellen müssen – angefangen von der Kernelkonfiguration über die

Konfiguration bis hin zur Anpassung des Systems. Ausführliche

Informationen zu den Kerneloptionen entnehmen Interessenten aufgrund

der Anzahl der Parameter direkt der Dokumentation [6].

Wichtig ist hier vor allem die Festlegung des Speichers mittels des

Bootparameters crashkernel. Der Parameter variiert von Architektur

zu Architektur und kann ebenso der Dokumentation entnommen werden.

Ist der neue Kernel erstellt und das System zwecks der

Initialisierung des neuen Speicherbereiches neu gestartet, kann das

Laden des neuen Kernels beginnen. Dies geschieht in der Regel im

Service kdump:

# /etc/init.d/kdump start

Vereinfacht gesagt, initialisiert das Programm den neuen Crash-Kernel

mittels der Userland-Anwendung kexec. Die Parameter variieren dabei

von Distribution zur Distribution und hängen von der Implementierung

ab. Der grundsätzliche Aufruf sieht allerdings wie folgt aus:

# kexec -p <dump-capture-kernel-vmlinux-image> --initrd=<initrd-for-dump-capture-kernel--args-linux> --append="root=<root-dev<arch-specific-options>"

Die Überprüfung, ob ein Crash-Dump-Kernel geladen wurde, kann

mittels des Kommandos

# cat /sys/kernel/kexec_crash_loaded

erfolgen. Ist ein Kernel geladen, gibt das Kommando den Wert 1 zurück.

Test

Wie eingangs beschrieben, ist kexec in der Lage, direkt aus einem

laufenden Kernel einen neuen Kernel zu starten. Was liegt also

näher, die Funktion zu testen und den Crash-Kernel zu booten? Dazu

reicht es, einfach einen neuen Kernel in den reservierten Speicher

zu laden. Auf x86-Systemen kann es in der Regel der bereits laufende

sein:

# kexec -l /boot/vmlinuz-image --initrd=/boot/initrd-image.img --command-line="`cat /proc/cmdline`"

Die Überprüfung erfolgt diesmal mit

cat /sys/kernel/kexec_loaded

da man mittels des Parameters -l nicht einen Panic-, sondern einen Load-Kernel geladen hat. Liefert die Zeile den Wert 1, kann das System mittels

# reboot

beendet werden. Die Besonderheit dabei: Wird der aktuelle Kernel beendet, sollte ohne einen einzigen BIOS-Zugriff sofort der neue Kernel gestartet werden.

Der Crash

Nun ist es an der Zeit, die Neueinrichtung in Aktion zu erleben.

Eine simple Möglichkeit, einen Fehler bzw. einen Absturz des Systems

zu verursachen, ist das Auslösen eines SysRQ mittels einer

geeigneten Tastenkombination oder mittels des Kommandos:

# echo "c" /proc/sysrq-trigger

Man sollte jetzt einen sofortigen Stillstand des Systems beobachten

mit einem anschließenden Booten eines neuen Kernels. Einige Minuten

später sollte sich das System beenden und ihre normale Umgebung

wieder erscheinen. In

dem Crash-Dump-Verzeichnis sollte sich nun

eine neue Datei mit dem Namen vmcore befinden:

# ls -l /var/crash/*/vmcore

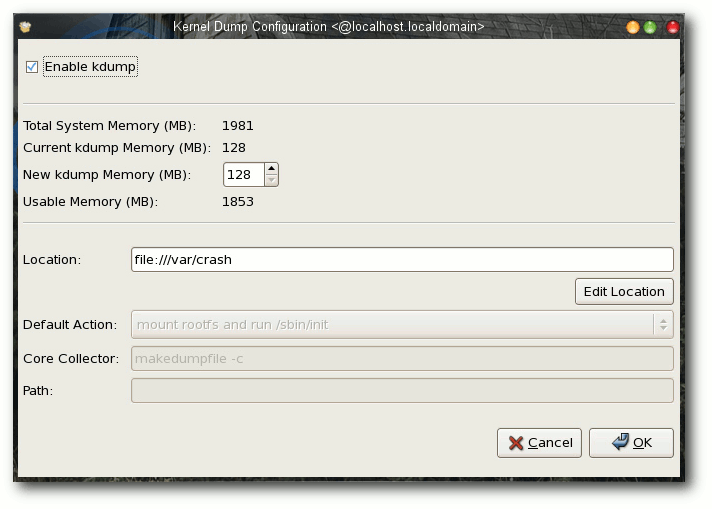

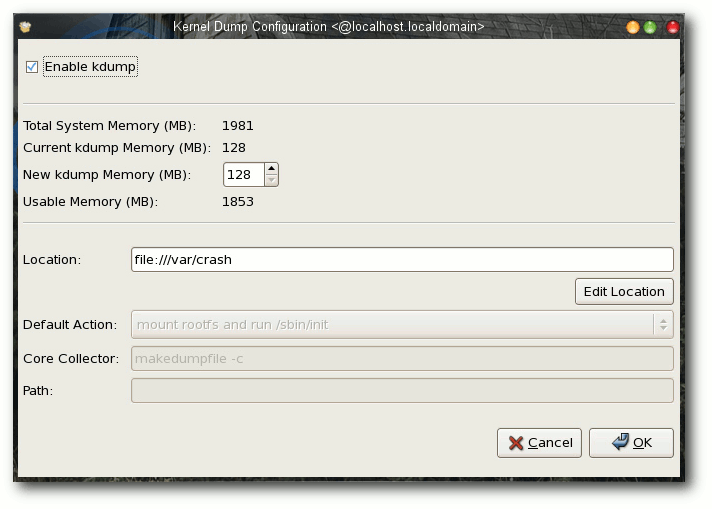

Das grafische Konfigurationstool für kdump in RHEL 5.

Analyse mittels gdb

Die generierte Crash-Datei kann mit den Standardprogrammen unter Linux

untersucht werden. Als Voraussetzung dafür gilt allerdings die

Installation der entsprechenden Debug-Pakete des Kernels. Der Name

und die Verfügbarkeit ist je nach Distribution unterschiedlich. So

heißen beispielsweise die Pakete unter RHEL 5.4 kernel-debug und

kernel-debuginfo. Sie sind nicht in der Standarddistribution

enthalten und müssen separat aus dem debuginfo-Verzeichnis der

Distribution heruntergeladen werden. Unter openSUSE 11.3 heißt der

Kernel dagegen kernel-<type>-debuginfo. Wichtig ist in allen Fällen,

dass die Version der Debug-Informationen zum laufenden Kernel passt.

Sind die Pakete und ihre Abhängigkeiten installiert, kann es an die eigentliche Untersuchung

gehen. Im Falle von RHEL dürfte das Kommando wie folgt aussehen:

# gdb /usr/lib/debug/lib/modules/<kernel>/vmlinux vmcore

Wichtig ist, dass dem Programm neben der korrekten

Crash-Datei auch die dazugehörende

Kernel-Objektdatei

übergeben wird. Unter openSUSE sehen die Parameter wie folgt aus:

# gdb /usr/lib/debug/boot/<kernel>.debug vmcore

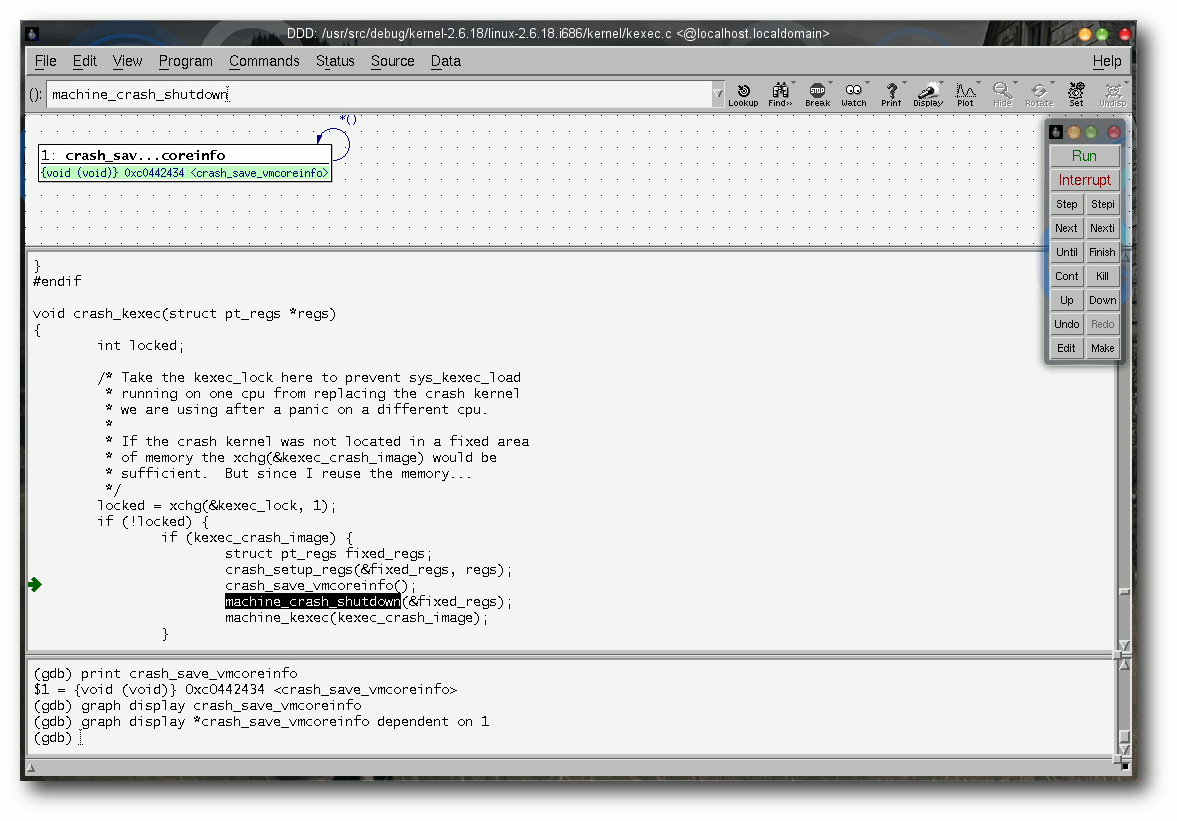

Alternativ können anstelle von gdb auch artverwandte Programme wie

gdbtui [7] oder

ddd [8] eingesetzt werden. Die

Parameter unterscheiden sich in der Standarddistribution nicht. So

kann beispielsweise der grafische Debugger ddd mit denselben

Optionen wie gdb gestartet werden.

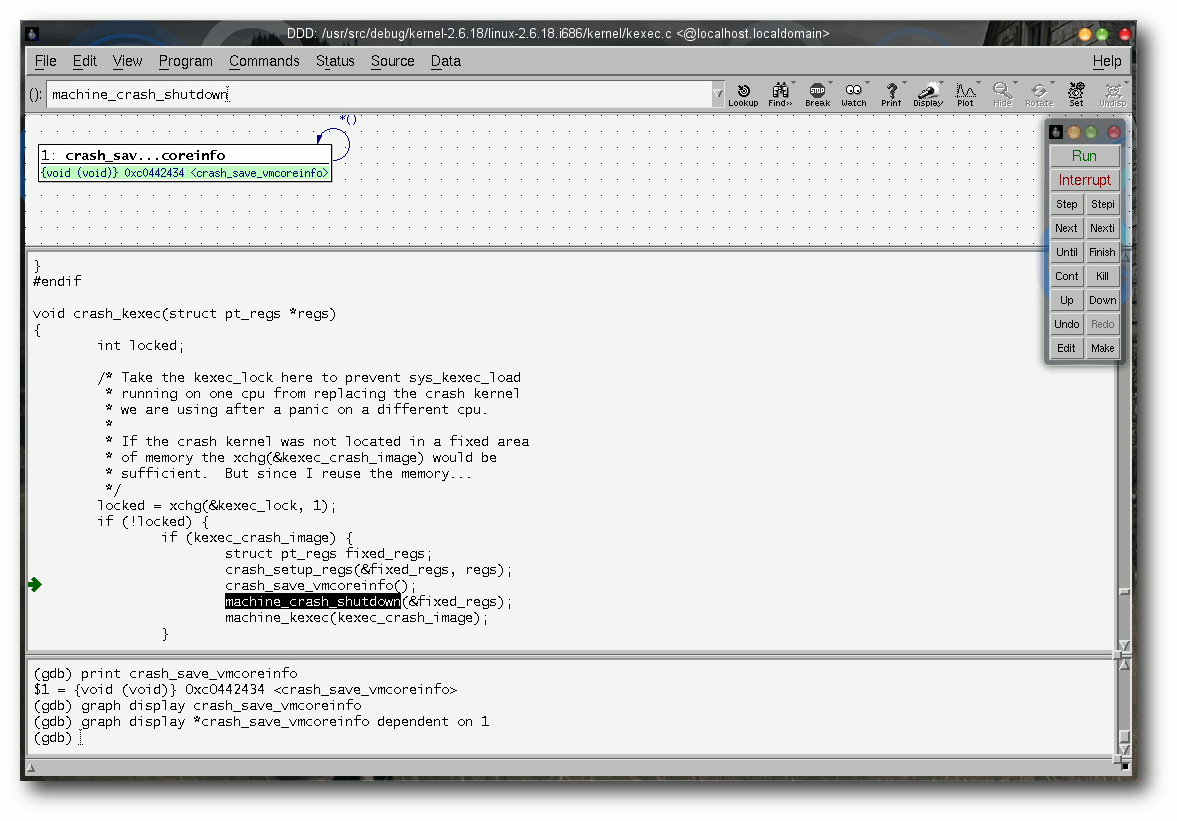

Untersuchung eines Kernelproblems mittels des grafischen gdb-Frontends ddd.

Analyse mit crash

Mag gdb noch so mächtig sein, liegen seine Einsatzbereiche nicht

unbedingt in der Untersuchung von Kernelproblemen. Oftmals ist

neben dem eigentlichen Code auch die Umgebung oder der Status des

Systems von besonderer Bedeutung für die Lösung eines

Kernelproblems. Oft führen Fehler in einem Subsystem zu

Fehlern in einem anderen, beispielsweise Speicherprobleme, in denen

Module ihnen nicht zugewiesenen Speicher überschreiben.

Die Crash-Datei enthält noch weit mehr Informationen. Neben dem Abbild

des Speichers sind in der Datei auch Log-Informationen, Prozessdaten,

Interrupts und Dateisysteminformationen enthalten. Diese ganzen Informationen sollen nur dem einen

Zweck dienen – der schnellen Untersuchung und Korrektur von Fehlern

im Kernel oder einem Subystem.

Sichtbar gemacht werden können die Crash-Informationen mittels des

Werkzeugs crash [9].

Crash erlaubt nicht nur, den Status des Systems während, sondern

auch nach einem Crash zu untersuchen. Dabei kommt das Programm mit

zahlreichen Crash-Formaten klar. Unter anderem vermag es Dumps von

netdump, diskdump, kdump oder xendump darzustellen. Die Grundlagen

von crash liegen dabei im crash-Kommando von System System V Release

4 (SVR4), das allerdings nicht nur auf Linux portiert, sondern auch

massiv angepasst wurde. Die wohl größte Änderung gegenüber dem

Original stellt die Integration des gdb dar. So ist es mittels crash

möglich, die Techniken des Urwerkzeugs und die des Quellcode-Debuggers

gemeinsam zu nutzen.

Der Aufruf von crash gleicht dem von gdb. So lässt sich das Programm

unter RHEL beispielsweise mittels folgenden Kommandos ausführen:

# crash /usr/lib/debug/lib/modules/<kernel>/vmlinux vmcore

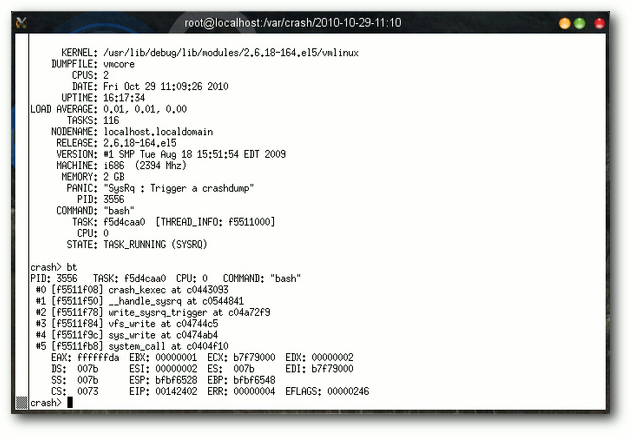

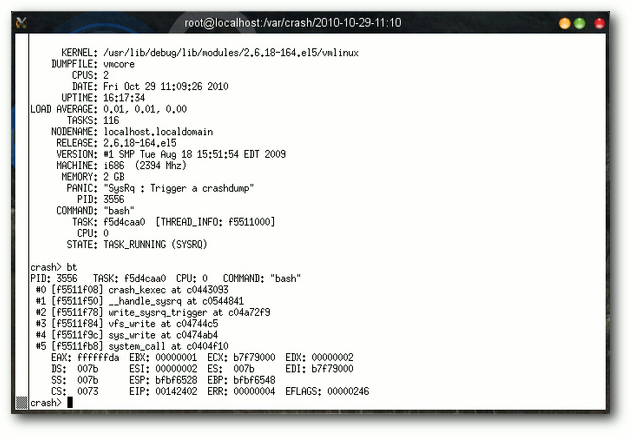

Informationen des Programms crash samt Kernel-Stacktrace.

Arbeiten mit crash

Streng genommen verfügt crash über vier verschiedene Arten von

Kommandos. Zum einen enthält es Befehle, die Kerneldaten oder Text

darstellen. Die wohl wichtigsten davon sind

struct und union

gepaart mit *, die Kernel-Datentypen darstellen. Ferner

unterstützt crash auch die Anzeige von Kernel-Variablen mittels p

und von Symbolen mittels whatis. Das Kommando sym übersetzt

dagegen einen Symbolnamen in eine virtuelle Adresse, dagegen disassembliert

dis eine Kernel-Funktion.

Der zweite Bereich von crash umfasst zahlreiche Werkzeuge, die sich dem

Status des Systems widmen. Neben bt, das einen Kernel-Stack

anzeigt und damit wohl das erste Kommando einer jeder Untersuchung

darstellt, bietet es auch Kommandos zur Anzeige von Geräten,

Dateien, Benutzerinformationen,

Prozessor- und Prozessdaten, Mount-

und Netzwerk-Optionen oder Speicherdaten. Im Grunde genommen

existieren nur wenige Bereiche, die sich dem Programm entziehen können.

So können beispielsweise mittels der Kommandos dmesg oder log im

Klartext die Loginformationen des Systems oder mittels ps der

Prozessbaum angezeigt werden.

Der dritte Bereich von crash beinhaltet Werkzeuge, die eine

Untersuchung erleichtern sollen. So können beispielsweise mittels

btop physikalische Adressen in Page-Nummern oder mittels ascii

numerische Werte in ASCII-Komponenten umgewandelt werden. Als

besonders mächtig erweist sich hier das wr-Kommando, das in der

Lage ist, in einem laufenden System Speicherbereiche zu ändern.

Voraussetzung hierfür ist allerdings ein Schreibzugriff auf

/dev/mem. In einem Crash-Dump ist das Kommando selbstverständlich

sinn- und funktionslos.

Schlussendlich bietet crash auch viele Kommandos zur Session-Kontrolle. alias definiert Aliase, q oder exit beenden die Anwendung.

Fazit

Wie bei allen Fehlern kann auch unter Linux keine Garantie für eine

fehlerfreie Funktionsweise eines Crash-Dumps gegeben werden.

Betrachtet man den Umstand, dass ein Dump durch einen fatalen Fehler

erzeugt wurde, besteht immer noch die Möglichkeit, dass die im

Abbild enthaltenen Daten keine Rückschlüsse auf die Quelle des

Problems zulassen.

Doch trotz allem sind Crash-Dumps, sei es bei Applikationen oder im

Kernel, eine wertvolle Quelle, um Probleme schnell zu identifizieren

und zu lösen. Die Wahrscheinlichkeit, einen Fehler mittels einer

Crash-Dump-Analyse im Kernel wenigstens einzugrenzen, ist ungleich

höher als durch eine Beschreibung. Denn die meisten Fehler des

Kernels oder eines Treibers geschehen nicht durch ein systematisches

Problem, sondern durch ein Fehlverhalten eines Subsystems, ein

Timingproblem oder schlicht Defekte

in der Hardware. Diese lokal zu

reproduzieren ist für einen Entwickler, der womöglich an einem

Treiber nur in seiner Freizeit schreibt, schier unmöglich.

Links

[1] http://www.pro-linux.de/artikel/2/1470/kernel-crash-analyse-unter-linux.html

[2] https://secure.wikimedia.org/wikipedia/en/wiki/Linux_kernel_oops

[3] https://secure.wikimedia.org/wikipedia/en/wiki/KGDB

[4] http://lkcd.sourceforge.net/

[5] http://lse.sourceforge.net/kdump/

[6] http://www.mjmwired.net/kernel/Documentation/kdump/

[7] http://www.gnu.org/software/gdb/

[8] http://www.gnu.org/software/ddd/

[9] http://people.redhat.com/anderson/crash_whitepaper/

| Autoreninformation |

| Mirko Lindner (Webseite)

befasst sich seit 1990 mit Unix. Seit 1998 ist er

aktiv in die Entwicklung des Kernels eingebunden und verantwortlich

für diverse Treiber und Subsysteme für Linux und andere freie

Plattformen. Daneben ist er einer der Betreiber von Pro-Linux.de.

|

| |

Diesen Artikel kommentieren

Zum Index

von Mathias Menzer Basis aller Distributionen ist der Linux-Kernel, der

fortwährend weiterentwickelt wird. Welche Geräte in einem halben

Jahr unterstützt werden und welche Funktionen neu hinzukommen,

erfährt man, wenn man den aktuellen Entwickler-Kernel im Auge

behält.

Kernel 2.6.37

Das Jahr 2010 beendete Torvalds noch mit einer letzten Vorabversion [1], die dem Treiber iwlwifi die Nutzung aktueller EEPROM auf Intels WLAN-Chipsätzen ermöglicht. Dazu kam noch eine Änderung am Treiber der für den Einsatz in Smartphones vorgesehenen System-on-a-Chip-Plattform S5Pv310, der nun alle zur Verfügung stehenden Register des System auch verwenden kann. All dem gab man noch ein paar Tage Zeit,

bevor dann nach 77 Tagen Entwicklungszeit Linux 2.6.37 veröffentlicht wurde [2].

Alles in allem fällt der jüngste Spross der Kernelreihe nicht unbedingt durch neue Jubelfunktionen ins Auge. Dafür wurde jedoch an bereits eingeführten Treibern und Funktionen gearbeitet, um sie zu verbessern.

Einer der größeren Stachel im Fleisch der Kernelentwickler, der veraltete Big Kernel Lock (BKL), konnte nun aus den Kernbereichen des Kernels so weit entfernt werden, dass das Kompilieren von 2.6.37 ohne BKL-Unterstützung grundsätzlich möglich ist. Leider kommt dieser Locking-Mechnismus nach wie vor in einigen Subsystemen zur Anwendung, sodass manche Treiber ohne BKL den Dienst verweigern.

Einiges hat sich im Bereich der Dateisysteme getan. Den Beginn macht hier Ext4, dem in Sachen Skalierbarkeit, also der Fähigkeit, sich an steigende Zahl und Leistungsfähigkeit von Prozessorkernen anzupassen, etwas Neues beigebracht wurde. So wird nun direkt mit der BIO-Schicht (Block-I/O) des Kernels kommuniziert, der bislang genutzte „Buffer Layer“ brachte zu viele Probleme mit der Leistungsfähigkeit und Skalierbarkeit mit sich. In einem Testszenario konnte eine Steigerung der Leistung von Ext4 um 300 % erreicht werden, während die Prozessornutzung um den Faktor 3 zurückging. Das Erstellen neuer Ext4-Partitionen wird nun erheblich schneller ablaufen als bislang gewohnt, da die Initialisierung der Inode-Tabelle, mit der der Ablageplatz einzelner Dateien auf der Partition gespeichert wird, nicht beim Erzeugen der Partition erfolgt, sondern erst beim ersten Einhängen in das System. Verschiedene Änderungen an XFS sollen auch hier die Leistung verbessern, weitere werden für 2.6.38 erwartet.

RBD (Rados Block Device) ist die Bezeichnung eines Treibers, mit dem sich blockorientierte Geräte anlegen lassen, die ihre Daten aus dem verteilten Netzwerk-Dateisystem Ceph beziehen. Bislang stand für den Zugriff auf Ceph nur ein auf FUSE (File System in Userspace) aufsetzender Treiber zur Verfügung. RBD unterstützt

Read-Only-Schnappschüsse und es gibt auch Patches für Qemu [3], mittels derer sich Block Devices für Virtuelle Maschinen in einem Ceph Cluster ablegen lassen. Das Thema Locking wurde auch bei Btrfs angegangen, ein anderer Locking-Mechanismus soll weniger aggressiv Zugriffe auf Bereiche des Dateisystems sperren und damit die Leitung verbessern. Einen positive Auswirkung auf die Leistungsfähigkeit des Dateisystems verspricht man sich davon, dass Btrfs nun freigegebene Bereiche in einer Liste auf dem Datenträger ablegt. Die Suche nach nicht zugewiesenen Blöcken soll damit in den meisten Fällen überflüssig werden, das Schreiben neuer Daten wird damit beschleunigt. Ebenso beschleunigt wurde das Erstellen von Schnappschüssen des Dateisystems, indem diese jetzt asynchron angelegt werden, also noch während Zugriffe erfolgen.

Wird das System in den Ruhezustand geschickt, komprimiert 2.6.37 das zu speichernde Abbild des Hauptspeichers mittels LZO [4], einem Verfahren, das als besonders schnell angesehen wird, und spart dadurch Zeit beim Übertragen auf den Datenträger, wodurch wiederum das Einschlafen und Wiederaufwachen des Systems weniger Zeit in Anspruch nehmen soll. Auch können Treiber nun ein Veto einlegen, wenn die von ihnen kontrollierten Geräte in den Schlafmodus geschickt werden, indem der Treiber sie für einige Zeit als inaktiv markiert.

Zum Schluss wurde das in 2.6.36 eingeführte Fanotify in der Standardkonfiguration aktiviert. Das System, das Prozesse über Änderungen am Dateisystem benachrichtigt, hatte mit Unklarheiten bezüglich seiner Schnittstelle zu kämpfen, die mittlerweile jedoch ausgeräumt wurden.

Kernel 2.6.38

Nach 14 Tagen ließ Torvalds das Merge Window wieder zufallen und veröffentlichte die erste Vorabversion von 2.6.38 [5]. Mit im Boot war auch der Patch für die Einführung der automatischen Task-Gruppen (siehe „Der November im Kernelrückblick; neue Wege für das Scheduling“, freiesMagazin 12/2010 [6]), die von Torvalds bereits im Vorfeld ausdrücklich gelobt worden waren und die insbesondere Desktop-Anwendern zugute kommen werden.

Locking-Mechanismen haben es dieser Tage nicht leicht. Hatte BKL bislang den Löwenanteil an Aufmerksamkeit auf sich gezogen, geht es jetzt dem weniger verbreiteten dcache_lock an den Kragen. Dieser kommt bislang unter anderem in der Dateisystem-Abstraktionsschicht VFS [7] zum Einsatz und zog damit unlängst den Blick von Nick Piggin auf sich. Er rückt dem Problem mit einer ganzen Reihe an Patches zu Leibe, mit denen er zuerst die Änderungen vorbereitete und dann die neuen Locking-Mechanismen einführte, bevor dcache ersetzt werden konnte.

Auf der Treiber-Seite wurde AMDs Fusion-Architektur bedacht, in der CPU und Grafikkern zusammengeführt werden. Weitere Updates am Direct Rendering Manager liefern Unterstützung für die Fermi-Grafikbeschleunigung von NVIDIA.

2.6.38-rc2 [8] und -rc3 [9] umrahmten zeitlich die australische Linux-Konferenz [10]; sie wurden vor Beginn und nach Ende des Treffens veröffentlicht. Die beiden Vorabversionen waren geprägt von Aufräumarbeiten im Bereich der zeichenorientierten Geräte, wo wieder zwei Treiber (hvc und serial) umziehen mussten. Die größte Änderung auf der Treiberseite war die Unterstützung für eine neue PCMCIA-Karte zur Anbindung eines CAN-BUS [11], ein auf speziell für die Kommunikation von Sensoren und Steuergeräten in Fahrzeugen ausgerichtetes System.

Kurz erläutert: „Locking“

Als Locking bezeichnet man eine Methode, die zeitgleiche Zugriffe auf ein Gerät oder einen Speicherplatz verhindert. Dabei errichtet der erste Prozess, der die Ressource nutzt, eine Sperre (englisch: Lock); alle anderen Prozesse müssen warten, bis sie wieder freigegeben wurde. Ältere Locking-Mechanismen zeigen sich häufig sehr gierig und sperren größere Adressräume als notwendig, wodurch andere Prozesse beim Zugriff gegebenenfalls warten müssen und damit ausgebremst werden. Die Bestrebungen laufen derzeit dahin, dass Prozesse nur den wirklich benötigten Teil einer Ressource sperren, zum Beispiel nur einen kleinen Zweig einer Struktur anstelle des ganzen Baumes. Dabei verhindert ein Read-Lock das Bearbeiten der Ressource, erlaubt jedoch anderen Prozessen ebenfalls das Lesen und wehrt nur Versuche zum Bearbeiten ab. Ein Write-Lock dagegen unterbindet auch Lesezugriffe, bis dass die Änderungen vollständig sind und der Lock entfernt wurde.

Locking kommt sowohl bei Zugriffen auf den Arbeitsspeicher als auch bei der Nutzung von Geräten, sowohl physikalischen als auch virtuellen, wie z. B. Treibern für Blockgeräte oder Dateisysteme, zum Einsatz.

|

Links

[1] http://lkml.org/lkml/2010/12/28/196

[2] http://lkml.org/lkml/2011/1/4/266

[3] http://de.wikipedia.org/wiki/Qemu

[4] http://de.wikipedia.org/wiki/Lempel-Ziv-Oberhumer

[5] http://lkml.org/lkml/2011/1/18/322

[6] http://www.freiesmagazin.de/freiesMagazin-2010-12

[7] http://de.wikipedia.org/wiki/Virtuelles_Dateisystem

[8] http://lkml.org/lkml/2011/1/21/530

[9] http://lkml.org/lkml/2011/1/31/547

[10] http://lca2011.linux.org.au/

[11] http://de.wikipedia.org/wiki/Controller_Area_Network

| Autoreninformation |

| Mathias Menzer

wirft gerne einen Blick auf die Kernel-Entwicklung, um mehr über die

Funktion von Linux zu erfahren und um seine Mitmenschen mit seltsamen

Begriffen und unverständlichen Abkürzungen verwirren zu können.

|

| |

Diesen Artikel kommentieren

Zum Index

von Daniel Nögel Im vorherigen Teil dieser Einführung (siehe freiesMagazin

01/2011 [1])

wurden Klassen besprochen. Mit diesem Teil soll nun ein Einstieg in

die praktische Programmierung in Angriff genommen werden. Zunächst

wird dazu aber noch auf die Fehlerbehandlung in Python eingegangen.

Fehlerbehandlung

Fehler werden in Python „Exceptions“ oder „Ausnahmen“ genannt. Sie

treten beispielsweise auf, wenn eine Datei nicht geöffnet werden

kann, ein Schlüssel einer Liste abgefragt wird, der gar nicht

existiert oder auf Variablen zugegriffen wird, die noch nicht

bekannt sind. Tritt ein Fehler auf, wird das Skript sofort beendet; in der Konsole erscheint eine Fehlermeldung:

>>> names = [u"Peter", u"Isabell"]

>>> names.remove(u"Karla")

Traceback (most recent call last):

File "<stdin>", line 1, in <module>

ValueError: list.remove(x): x not in list

In diesem Beispiel wird zunächst eine Liste mit Namen definiert.

Beim Versuch, den Eintrag Karla zu entfernen, tritt ein Fehler auf,

da dieser Eintrag sich gar nicht in der Liste befindet. Um diese

spezielle Situation exakt zu erfassen, wirft Python eine Ausnahme

vom Typ ValueError. Python kennt bereits in seiner

Standardbibliothek viele Typen von Fehlern [2].

Zusätzlich gibt Python noch die Zeilennummer und eine kurze

Fehlerbeschreibung aus.

Nun ist es in den meisten Fällen nicht erwünscht, dass das Programm

einfach endet und eine kryptische Fehlermeldung

ausgibt. Daher ist es möglich, Stellen, an denen Fehler auftreten

können, mit folgender Syntax zu umgeben:

try:

names.remove(u"Karla")

except ValueError:

print "Eintrag nicht in der Liste"

Bei dem Versuch, die Anweisung in Zeile 2 auszuführen, wird wie oben

auch ein ValueError ausgelöst. Statt aber das Programm abzubrechen,

überprüft der Interpreter, ob einer der except-Ausdrücke (es sind

mehrere möglich) diesen Fehler abfängt. Das ist in Zeile 3 der Fall;

der Programmfluss wird daher an dieser Stelle fortgesetzt. Grob ließe

sich try... except... also mit versuche... im Fehlerfall mache...

übersetzen.

Es lassen sich auch mehrere mögliche Fehler in einem except-Block abfangen:

try:

names.remove(u"Karla")

except (SyntaxError, ValueError) as error:

print u"Folgender Fehler ist aufgetreten {0}".format(error)

Hier wird also auf einen möglichen SyntaxError ebenso reagiert wie

auf einen ValueError. Das Konstrukt except ... as error führt

dazu, dass der aufgetretene Fehler im Rumpf des except-Blocks als

error zur Verfügung steht. Sprich, der aufgetretene Fehler wird an

den Namen error gebunden. Obwohl Fehler-Objekte keine

Zeichenketten sind, können sie in vielen Situationen wie solche

verwendet werden:

>>> error = ValueError("Hilfe")

>>> str(error)

'Hilfe'

In Zeile 4 des zweiten Beispiels oben geschieht im Grunde genommen

Ähnliches: Das Fehler-Objekt wird implizit in eine Zeichenkette

umgewandelt, sodass auf der Konsole einige Details zum Fehler

erscheinen.

else und finally

Wie auch if-Blöcke kennen try... except-Blöcke das

else-Statement. Der Rumpf eines else-Blockes wird ausgeführt,

wenn im try-Block kein Fehler aufgetreten ist. Der

finally-Block schließlich kommt immer zur Ausführung, egal ob ein

Fehler auftrat oder nicht:

l = [u"Peter", u"Isabell"]

try:

names.remove(u"Karla")

except ValueError:

print "Karla war gar nicht in der Liste."

else:

print "Karla wurde aus der Liste entfernt."

finally:

print "Mir doch egal, ob Karla in der Liste war oder nicht!"

Abhängig davon, ob Karla nun in der Liste vorhanden war oder nicht, erscheint entweder die Meldung:

Karla war gar nicht in der Liste.

Mir doch egal, ob Karla in der Liste war oder nicht!

oder

Karla wurde aus der Liste entfernt.

Mir doch egal, ob Karla in der Liste war oder nicht!

Ästhetik des Scheiterns

Die Ausnahmebehandlung in Python gilt als sehr mächtig und wird oft

gegenüber manuellen Tests bevorzugt. Statt also von Hand zu

überprüfen, ob eine Datei vorhanden ist und ob der Benutzer die

nötigen Rechte hat, diese Datei zu lesen, würde ein

Python-Programmierer es einfach auf einen Versuch ankommen lassen

und die Datei öffnen. Tritt ein Fehler auf, wird dieser durch

entsprechende except-Blöcke abgefangen und dort darauf reagiert.

Auftretende Fehler werden gewissermaßen von

„unten nach oben“ durchgereicht:

def innen():

return int("asd")

def mitte():

return innen()

def aussen():

return mitte()

print aussen()

Der Umwandeln einer Zeichenkette wie asd in eine Ganzzahl wird zu

einem ValueError führen. Die Frage lautet nun: An welcher Stelle

muss dieser Fehler nun abgefangen werden?

Tatsächlich gibt es theoretisch vier Möglichkeiten: Der Fehler tritt

zunächst in der Funktion innen() auf. Dort könnte er mit einem

try... except...-Block abgefangen werden. Wird der Fehler dort

nicht behandelt, wird er an die übergeordnete Funktion mitte()

weitergegeben. Geschieht auch hier keine Fehlerbehandlung, überprüft

der Interpreter, ob auf nächsthöherer Ebene (also in aussen()) eine

Fehlerbehandlung stattfindet. Ist auch dies nicht der Fall, besteht

noch die Möglichkeit, den Fehler in Zeile 10 abzufangen. Erst wenn

an all diesen Stellen keine Fehlerbehandlung stattgefunden hat,

bricht der Interpreter die Abarbeitung des Skripts ab.

Viele Anfänger mögen sich jetzt die Frage stellen: Wieso vermeidet

man nicht einfach Fehler, indem man dafür sorgt, dass die möglichen

Ausnahmen nicht auftreten können? Folgender Code-Schnipsel soll das

verdeutlichen:

# ein Dictionary

persons = {u"Peter": "m", u"Karla": "w"}

# irgend wo spaeter im Code

if u"Peter" in persons:

gender = persons[u"Peter"]

Man könnte an dieser Stelle natürlich auch einen KeyError abfangen:

try:

gender = persons[u"Peter"]

except KeyError:

pass

Diese kleine Situation zeigt das Dilemma. Oftmals ist nicht

unbedingt klar und direkt ersichtlich, wie man ein solches Problem

optimal löst. In Python wird das EAFP-Prinzip (frei übersetzt: „Erst

schießen, dann fragen.“) dem LBYL-Paradigma (in etwa: „Schau, bevor du

abspringst“) vorgezogen [3]. EAFP

würde offensichtlich für die zweite Variante sprechen, außerdem

spricht dafür, dass das Abklopfen aller Eventualitäten den Code

unter Umständen sehr aufblähen kann. Andererseits handelt es sich

bei Exceptions um Ausnahmen. Sollte es – wieso auch immer – sehr

wahrscheinlich sein, dass der Schlüssel (oben: Peter) an dieser

Stelle nicht verfügbar ist, so wäre die Lösung mittels Test auf

Vorhandensein sinnvoller, da es expliziter die erwartete Situation

ausdrückt. Entscheidend für die gute Nutzung von Exceptions ist also

die Situation im Code. Über die Vor- und Nachteile von EAFP und LBYL

hat Oran Looney einen sehr anschaulichen Artikel

verfasst [4]. Weitere allgemeine

Hinweise zur Fehlerbehandlung in Python finden sich in der

offiziellen Dokumentation [5].

Musikverwaltung

Die bisher vorgestellten Funktionen und Möglichkeiten Pythons sollen

nun in einem etwas umfassenderen Beispiel – einer kleinen

Musikverwaltung – veranschaulicht werden. In den nächsten beiden

Teilen dieser Reihe wird dieses Beispiel dann sukzessive ausgebaut.

Den Anfang macht ein kleines Modul, das Verzeichnisse rekursiv nach

Musikdateien durchsucht und deren Tags in einer Liste von

Dictionaries abbildet.

ID-Tags lesen

Zum Auslesen der ID3-Tags wird die Python-Bibliothek

mutagen [6] eingesetzt.

In Ubuntu ist es als Paket python-mutagen in den Paketquellen

verfügbar und kann darüber bequem nachinstalliert werden.

Das Modul zum Auslesen der MP3s soll readmp3s heißen. Entsprechend

wird die Datei readmp3s.py angelegt und mit folgenden Inhalt

befüllt:

#!/usr/bin/env python

# coding:utf-8

import os

import sys

from mutagen.easyid3 import EasyID3

import mutagen.mp3

import mutagen.oggvorbis

Listing: readmp3s-imports.py

Neben Shebang und Zeichenkodierung finden sich hier fünf Importe:

Das Modul os beinhaltet diverse betriebsystemabhängige

Schnittstellen. Das Modul sys wird genutzt, um auf die

Parameter des späteren Programmes zugreifen zu können. Der Import

from mutagen.easyid3 import EasyID3

erscheint zunächst kompliziert. Es wird aber lediglich vom

Submodul easyid3 des Paketes mutagen die Klasse EasyID3 in den

Namensraum des Skriptes importiert. In Teil 3 dieser Einführung

(siehe freiesMagazin 12/2010 [7])

wurde von derartigen from-Importen abgeraten, mutagen wurde aber

bewusst so geschrieben, dass das gezielte Importieren einzelner

Subbibliotheken möglich und sinnvoll ist.

Mit import mutagen.mp3 wird schließlich noch das Submodul mp3 in

den Namensraum des Skriptes importiert. Der letzte Import verfährt

parallel mit dem Submodul oggvorbis. Diese beiden Module stellen

später Schnittstellen zu den ID3- bzw. Vorbis-Tags bereit.

Als nächstes wird eine Funktion implementiert, welche die Tags der

Audiodateien ausliest und zurückgibt. Treten Fehler auf, gibt die

Funktion None zurück.

def get_infos(path):

path = path.decode("utf-8")

if path.lower().endswith(".mp3"):

audio = mutagen.mp3.MP3(path, ID3=EasyID3)

else:

audio = mutagen.oggvorbis.OggVorbis(path)

length = audio.info.length

infos = {"path":path, "length":length}

for tag in ["title", "artist", "album"]:

content = audio.get(tag, [None])[0]

infos[tag] = content

return infos

Listing: readmp3s-get_infos.py

Der Kopf der Funktion hält keine Überraschungen bereit: Die Funktion

get_infos erwartet nur einen Parameter path. In Zeile 3

werden die Pfadangaben in Unicode umgewandelt – dies ist schon

allein in Hinblick auf die SQLite-Datenbank zu empfehlen. Nun ist es

immer möglich, dass einige Dateinamen fehlerhaft kodiert wurden (das

berühmte Fragezeichen im Dateinamen). In diesem Fall würde eine

UnicodeDecodeError auftreten. Dieser Fehler wird in dieser Funktion

nicht behandelt, daher muss er also an anderer Stelle abgefangen werden.

In den Zeilen 6 und 8 wird abhängig von der Dateiendung (besser wäre

natürlich eine Überprüfung des MIME-Types [8])

eine Instanz der Klasse mutagen.mp3.MP3 oder mutagen.oggvorbis.OggVorbis

erstellt. Es wird jeweils der Pfad zur Audiodatei übergeben. Der

Zusatz ID3=EasyID3 in Zeile 6 sorgt weiterhin dafür, dass eine

vereinfachte Schnittstelle auf die ID3-Tags bereitsteht. Die etwas

kryptischen ID3-Tags (TPE1, TALB) können so einfach als artist

bzw. album angesprochen werden. Die erstellten MP3- und

OggVorbis-Objekte werden jeweils an den Namen audio gebunden

und verhalten sich in vielerlei Hinsicht ähnlich. So kann in Zeile 10

bequem die Dauer der Audiodatei ausgelesen werden – unabhängig davon,

um welches Format es sich dabei handelt.

In Zeile 12 wird zunächst ein neues Dict mit dem Pfad und der Dauer

erstellt und an den Namen infos gebunden. Die Schleife in Zeile 13

iteriert über die Liste mit Tags, die ausgelesen werden sollen. Die

Objekte mutagen.mp3.MP3 und mutagen.oggvorbis.OggVorbis

verhalten sich wie ein Dict, sodass mit audio["title"] der Titel

der jeweiligen Datei abgefragt werden könnte. Da aber nicht jede

Audiodatei zwangsläufig jedes Tag hat, könnten hier Fehler

auftreten. An dieser Stelle erspart man sich weitere

Fehlerbehandlungen und nutzt die get-Methode der Dicts. Allerdings

gibt Mutagen nicht einfach Zeichenketten für die gewünschten Tags

aus. Es werden immer Listen zurückgegeben, sodass man statt

Künstlername die Liste ["Künstlername"] erhält. Daher wird am Ende

von Zeile 14 mit [0] das erste Listenelement ausgelesen – das ist in

den meisten Fällen völlig ausreichend. Hier lauert freilich auch

eine kleine Stolperfalle: Die get-Methode arbeitet bekanntlich mit

einem Standard-Parameter, der zurückgegeben wird, falls das Dict den

angefragten Wert nicht enthält. Dieser Wert ist in dem Fall None.

Da die Rückgabe der get-Methode aber als Liste behandelt wird

([0]), muss auch None zunächst in eine Liste gepackt werden.

Nach dem Durchlaufen der Schleife wird in Zeile 17 das Dict an die

aufrufende Funktion übergeben.

Hinweis: In den Zeilen 10 und 14 werden audio.info.length und die

Rückgabe von audio.get() an die Namen length bzw. content

gebunden. Dieser Zwischenschritt dient hier lediglich der

Veranschaulichung und der Übersichtlichkeit. Für gewöhnlich würde

man diesen Zwischenschritt auslassen:

{"path":path, "length":audio.info.length}

...

infos[tag] = audio.get(tag, [None])[0]

Verzeichnis rekursiv auslesen

Nun wird noch eine Funktion benötigt, die die MP3s auf der

Festplatte findet und an die Funktion get_infos() übergibt. Diese

Funktion soll read_recursively() heißen.

def read_recursively(path):

audio_infos = []

counter = 0

error_counter = 0

for root, dirs, files in os.walk(path):

for fl in files:

if fl.lower().endswith(".mp3") or fl.lower().endswith(".ogg"):

path = os.path.join(root, fl)

try:

infos = get_infos(path)

except (UnicodeDecodeError, mutagen.mp3.HeaderNotFoundError, mutagen.id3.error) as inst:

print u"\n\nSKIPPING reading this file:"

print path

print u"ERROR: {0}\n".format(inst)

error_counter +=1

else:

audio_infos.append(infos)

counter +=1

print "\rScanning: {0} Files ok, {1} Files broken".format(counter, error_counter),

print

return audio_infos

Listing: readmp3s-read_recursively.py

Auch hier zunächst nichts Neues: Die Funktion kennt einen Parameter

path. Damit soll später das Verzeichnis übergeben werden, welches

rekursiv durchsucht werden soll. In Zeile 3 wird eine Liste erstellt

und an den Namen audio_infos gebunden. Damit sollen später

sämtliche von get_infos() erzeugten Dicts mit den Tags aufbewahrt

werden. counter und error_counter sollen lediglich zählen, wie

viele Audiodateien bereits verarbeitet wurden und bei wie vielen es

zu Fehlern kam.

In Zeile 7 wird eine neue Funktion eingeführt: os.walk()

durchläuft ein Verzeichnis rekursiv. Für jedes Verzeichnis gibt die

Funktion dabei den Pfad des aktuellen Verzeichnisses (root), die

Verzeichnisse in dem aktuellen Verzeichnis (dirs) und die Dateien

im jeweiligen Verzeichnis (files) an. Bei

os.walk() [9] handelt

es sich um einen sogenannten Generator. Das ist der Grund, warum

die Funktion in einer Schleife verwendet werden

kann [10].

Da für die Musikdatenbank nur Dateien von Interesse sind, genügt es,

in Zeile 8 über die

Dateiliste eines jeden Verzeichnisses zu

iterieren. In Zeile 9 wird für jede Datei geprüft, ob sie mit .mp3

oder .ogg endet. Da die Dateien theoretisch auch auf .mP3 oder

.OgG enden könnten, werden die Dateinamen in Kleinbuchstaben

verglichen. Auch hier gilt: Die Abfrage der Dateiendung ist keine

sonderlich befriedigende Lösung – für das erste kleine Projekt

sollte dieses Vorgehen aber ausreichend sein.

Da in der Liste files nur Dateinamen vorhanden sind, wird in

Zeile 10 der komplette Pfad erzeugt. Die Funktion os.path.join()

kümmert sich dabei darum, dass die korrekten Schrägstriche verwendet

werden (Linux und Windows unterscheiden sich in dieser Hinsicht).

Durch os.path.join wird weiterhin sicher gestellt, dass es nicht

versehentlich zu doppelten Schrägstrichen im Pfad kommt. In Zeile 12

schließlich wird der so erstellte Pfad an die Funktion get_infos()

übergeben und das Ergebnis an den Namen info gebunden.

In Zeile 11 wird aber zunächst die Fehlerbehandlung eingeleitet. Die

in der Funktion get_infos() nicht behandelten Fehler sollen also an

dieser Stelle abgefangen werden. In Zeile 13 werden dabei drei

Fehler erwartet: Der bereits erwähnte UnicodeDecodeError findet

sich ebenso wie die Fehler mutagen.mp3.HeaderNotFoundError und

mutagen.id3.error. Während der UnicodeDecodeError auftritt, wenn

eine Zeichenkette nicht in Unicode umgewandelt werden konnte und

damit für die später verwendete SQLite-Datenbank ungeeignet ist,

tritt der HeaderNotFoundError auf, wenn Mutagen in einer MP3-Datei

keinen MP3-Header finden konnte. mutagen.id3.error schließlich

fängt viele weitere Mutagen-Fehler ab. Dies erspart dem Entwickler

die Arbeit, jeden einzelnen möglichen Fehler im Vorfeld zu

definieren. Ihm genügt es (wie in diesem Beispiel) zu wissen, dass

Mutagen – warum auch immer – eine bestimmte Datei nicht verarbeiten

konnte.

In den Zeilen 14-17 findet die Fehlerbehandlung statt. Der Fehler

wird in der Konsole ausgegeben und der Fehlerzähler wird um 1

erhöht. Nur wenn kein Fehler auftritt (Zeile 18) wird in Zeile 19

die Rückgabe von get_infos() an die Liste audio_infos angehängt.

In diesem Fall wird counter um 1 erhöht.

Eine letzte Besonderheit findet sich in Zeile 21. Die Zeichenkette

dort beginnt mit \r. Diese Escape-Sequenz steht für den

sogenannten Wagenrücklauf. Dadurch wird der Cursor im Terminal

wieder auf den Anfang der Zeile gesetzt. Nachfolgende Ausgaben mit

print würden die vorherigen Ausgaben überschreiben. Da print

eine Zeile im Normalfall mit einem Zeilenumbruch abschließt, wird

dies hier mit dem Komma am Ende der Zeile unterbunden.

Der Wagenrücklauf und das Unterbinden des Zeilenumbruches sorgen

dafür, dass die Konsole nicht mit Textausgaben überflutet wird: Die

Anzahl der verarbeiteten Dateien wird immer in die selbe Zeile

geschrieben.

Hinweis: In Python >= 3 müsste Zeile 17 wie folgt aussehen:

print ("\rScanning: {0} MP3s ok, {1} MP3s broken".format(counter, error_counter), end="")

Kleiner Test

Obwohl die Musikdatenbank noch in weiter Ferne ist, kann zumindest

das Modul readmp3s schon einmal getestet werden. Dazu wird am Ende

des Skripts noch folgende if-Block ergänzt:

if __name__ == "__main__":

try:

path = sys.argv[1]

except IndexError:

print "Usage:"

print "readmp3s.py DIRECTORY"

else:

mp3s = read_recursively(path)

Listing: readmp3s-main.py

Die erste Zeile überprüft dabei, ob die Datei als Modul oder als

eigenständiges Skript geladen wurde. Nur im letzteren Fall kommen

die folgenden Zeilen zur Ausführung. In Zeile 3 wird der zweite

Parameter des Skriptes aus der Liste sys.argv gelesen. Der erste

Parameter ist immer der Dateiname (hier also readmp3s.py). Falls

der Benutzer keine Parameter übergeben und die Liste nur einen

Eintrag hat, wird es in Zeile 3 zu einem IndexError kommen, der

aber in Zeile 4 abgefangen wird. Im Fehlerfall wird dann ein kurzer

Hinweis auf den erforderlichen Parameter gegeben. In Zeile 8 wird

die Funktion read_recursively() aufgerufen. Wie bereits erwähnt

kommt dieser else-Block nur zur Ausführung, wenn zuvor kein Fehler

auftrat.

Das Skript wird nun das angegebene Verzeichnis durchsuchen, die

ID-Tags auslesen und über die Anzahl lesbarer und nicht-lesbarer

MP3s informieren. Keine Sorge: Das Skript ist bisweilen etwas

empfindlich, was die Zeichenkodierung und die MP3-Header betrifft

und nicht alle als defekt gemeldeten MP3s sind

tatsächlich unbrauchbar.

Im nächsten Teil dieser Reihe wird die Musikdatenbank um eine

SQLite-Datenbank ergänzt.

Links

[1] http://www.freiesmagazin.de/freiesMagazin-2011-01

[2] http://docs.python.org/library/exceptions.html

[3] http://docs.python.org/glossary.html

[4] http://oranlooney.com/lbyl-vs-eafp/

[5] http://docs.python.org/tutorial/errors.html

[6] http://code.google.com/p/mutagen/

[7] http://www.freiesmagazin.de/freiesMagazin-2010-12

[8] http://de.wikipedia.org/wiki/MIME-Type

[9] http://docs.python.org/library/os.html#os.walk

[10] http://de.wikibooks.org/wiki/Python-Programmierung:_Funktionen#Generatoren_und_yield

| Autoreninformation |

| Daniel Nögel

beschäftigt sich seit drei Jahren mit Python. Ihn überzeugt

besonders die intuitive Syntax und die Vielzahl der unterstützten

Bibliotheken, die Python auf dem Linux-Desktop zu einem wahren

Multitalent machen.

|

| |

Diesen Artikel kommentieren

Zum Index

von Jochen Schnelle Wer webbasierte Anwendungen in Python [1] programmiert,

nutzt heutzutage normalerweise den WSGI-Standard [2],

der eine einheitliche Schnittstelle zwischen Programm und Webserver

definiert. Der Umgang mit den WSGI-Modulen aus der Python-Standardbibliothek

ist zwar nicht schwierig, aber letztlich doch recht

trockener Formalismus. Hier kommt Bottle [3] ins

Spiel, mit dessen Hilfe Webanwendungen schnell und einfach erstellt werden können.

Bottle erledigt den WSGI-Formalismus mit wenigen Zeilen Code, sodass man

sich ganz auf die eigene Anwendung konzentrieren kann. Weiterhin stellt

das Modul zusätzliche Funktionen bereit, welche im Rahmen einer

Webapplikation nützlich und hilfreich sind. Bottle selbst besteht dabei nur

aus einem einzelnen Modul, das praktischerweise keine weiteren

Abhängigkeiten außer Python selbst hat. Das Programm läuft unter allen

Python-Versionen ab 2.5, inklusive Python 3.x. Somit ist das Modul recht

universell einsetzbar und läuft auf fast jedem Server bzw. Computer mit

installiertem Python.

Installation

Der einfachste Weg Bottle zu installieren, ist über easy_install aus den

Python-Setup-Tools [4]. Hat man diese

installiert, lautet der entsprechende Befehl:

# easy_install bottle

Da das Programm aber, wie oben bereits erwähnt, nur aus einer Datei besteht,

kann man alternativ das neueste Modul von der Git-Hub-Seite

herunterladen [5] und dann händisch ins Projektverzeichnis

kopieren, was je nach System bei der Programmentwicklung oder zum schnellen

Testen recht nützlich sein kann. Oder man kopiert Bottle direkt in das

Verzeichnis, in dem alle Python-Module liegen, unter Ubuntu/Debian z. B.

/usr/lib/python2.6/dist-packages/. Dies funktioniert so aber nur, wenn man

Python 2 nutzt. Nutzer von Python 3 müssen vorher noch die Datei bottle.py

mit dem Python-Hilfsprogramm 2to3 [6]

für Python 3 anpassen:

$ 2to3 -w bottle.py

Für Ubuntu gibt es seit der Version 10.04 „Lucid Lynx“

zwar auch ein fertiges Paket in den Paketquellen, dieses entspricht aber

nicht dem neuesten Stand von Bottle, sodass die manuelle Installation

bevorzugt werden sollte.

Nutzung

Bottle besteht aus einer Reihe von Klassen und Funktionen, die für das

eigene Programm genutzt werden können. Wie alle Python-Module muss Bottle

dazu zuerst einmal in das eigene Programm importiert werden:

import bottle # zum kompletten Import

# bzw.

from bottle import ... # einzelne Klassen importieren

Grundsätzlich gibt es mehrere Möglichkeiten, die eigene Bottle-Applikation

an einen Webserver zu binden. Bottle bietet eine Vielzahl von Anbindungen

von Hause aus an, bis hin zum Betrieb über den

Apache-Webserver [7] via

mod_wsgi [8]. Eine Übersicht über alle möglichen

und unterstützten Anbindungen findet man in der Dokumentation im Abschnitt

„Deployment“ [9]. Zusätzlich

bringt Bottle einen einfachen, eingebauten Server mit, welcher auf der

Referenzimplementierung des in Python enthaltenen WSGI-Servers

basiert [10].

Dieser eignet sich sehr gut zum lokalen Testen der Applikation und wird auch

im Folgenden für alle Beispiele genutzt. Weiterhin bietet der eingebaute

Server die Option „autoreload“. Dies bedeutet, dass der laufende Server

automatisch erkennt, wenn Änderungen an der zugrunde liegenden Applikation

vorgenommen wurden und sich dann selbstständig neu startet, sodass der

sonst notwendige händische Neustart entfallen kann.

Hinweis: Die Code-Beispiele sind alle unter Python

2.6 lauffähig und getestet, sollten aber auch unter neueren

Python-Versionen einsetzbar sein.

Einfaches Routing

Grundlegend ist bei Bottle route, das für das Routing zuständig ist. route

ist ein

Dekorator [11], welcher die darauf folgende Funktion an die in route angegebene Route

bindet.

#!/usr/bin/python

# -*- coding: utf-8 -*-

from bottle import route, run

@route('/hallo')

def hallo():

return 'Hallo Welt!'

run()

Listing: meine_app.py

Dieses Skript speichert man z. B. unter meine_app.py

und startet es dann mit:

$ python meine_app.py

Das Skript stellt eine minimale, mit Bottle erstellte Webapplikation dar.

@route('/hallo') definiert die Route hallo, welche an die folgende

Funktion hallo gebunden ist. Dort wird einfach nur ein „Hallo Welt!“ an

den Browser zurückgegeben. run() startet die Applikation. Ohne weitere

Angaben läuft diese nun lokal auf localhost und Port 8080. Testen kann man

dies, indem man das Programm wie oben beschrieben startet und im Browser