Zur Version ohne Bilder

freiesMagazin Oktober 2012

(ISSN 1867-7991)

RAW-Bildverarbeitung unter Linux: Techniken und Anwendungen

Wer hat sich nicht schon einmal über den weißen, vollständig neutralisierten Himmel geärgert, den man bei vermeintlich bestem Wetter und dem schönsten Sonnenschein fotografierte? Der Grund liegt dabei nicht nur an einer falschen Einstellung, sondern auch oftmals am Ausgabeformat. Dabei können Kameras der gehobenen Preisklasse häufig Bilder im Rohdatenformat (RAW) abspeichern. Dieser Artikel stellt die bekanntesten Applikationen unter Linux vor, vergleicht sie und erklärt, wie anspruchsvolle Fotografen ihre Bilder noch weiter verbessern können. (weiterlesen)

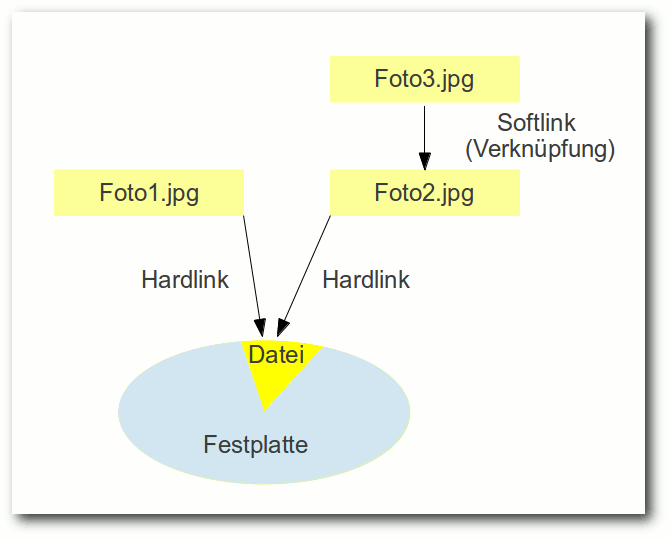

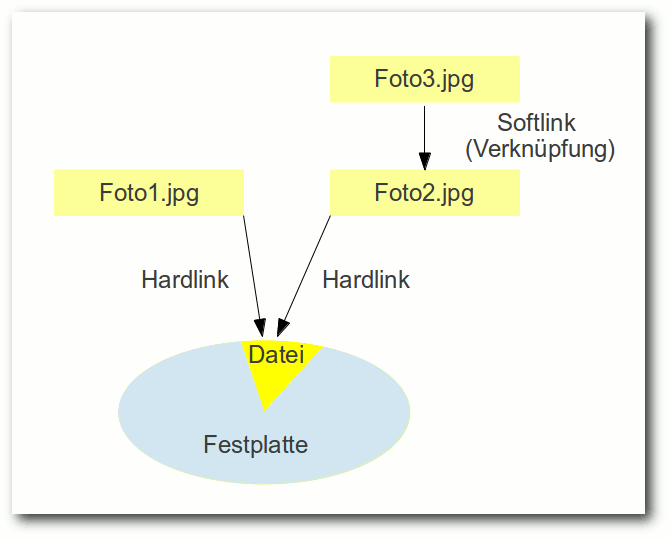

Pfiffige Datensicherung mit storeBackup

Wenn ein Backup kleiner ist als der von den Quelldateien beanspruchte Platz auf der Festplatte, hat man entweder einen Fehler gemacht – oder vielleicht storeBackup benutzt. Das Kommandozeilenprogramm geht äußerst sparsam mit dem verfügbaren Platz auf der Festplatte um, und mancher bezeichnet es als ideales Backupprogramm für Einsteiger und Profis. (weiterlesen)

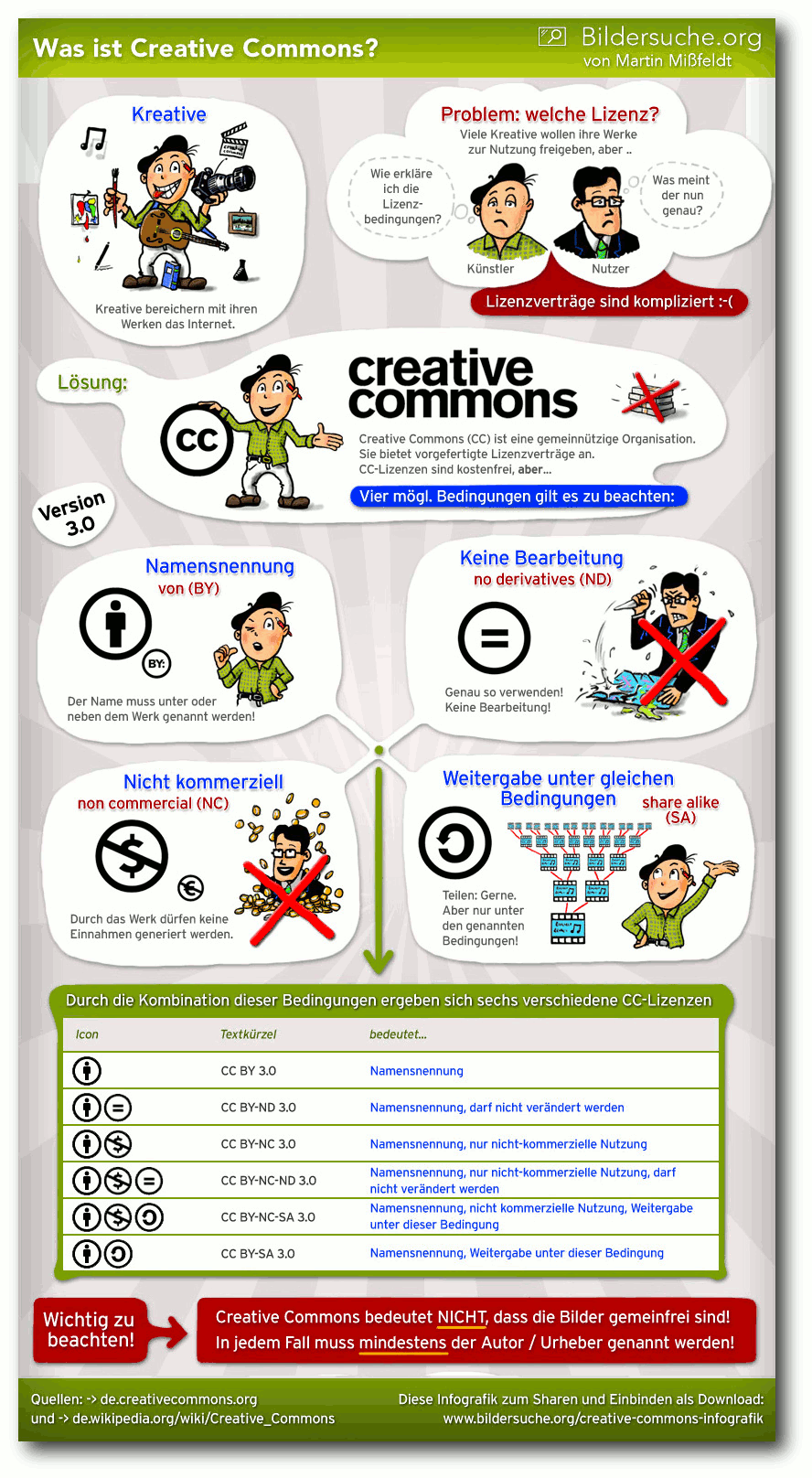

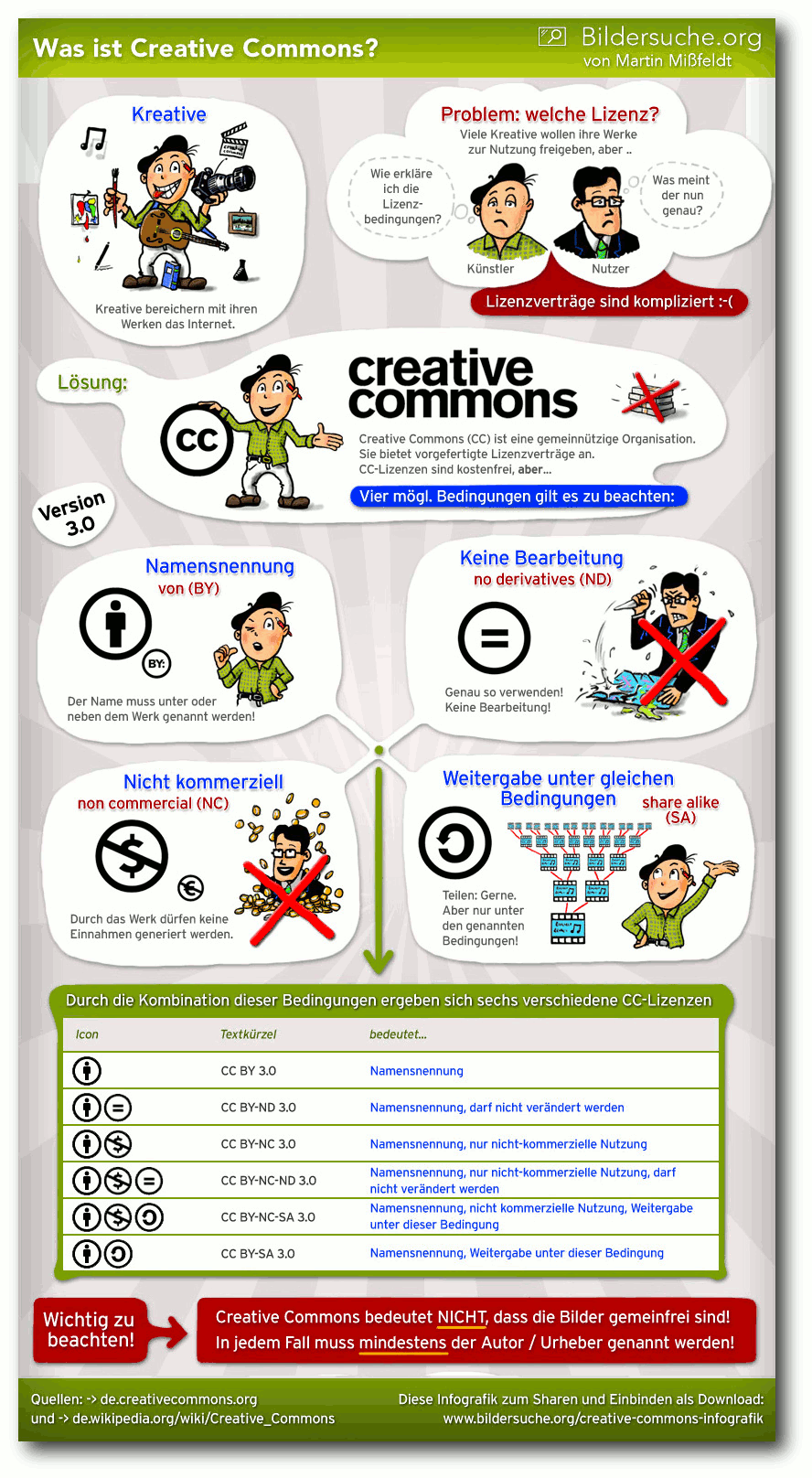

Creative Commons – Was ist das und kann man das essen?

Creative Commons ist in aller Munde und kommt an vielen Stellen zum Einsatz – sei es bei der Wikipedia, bei OpenStreetMap oder bei freiesMagazin. Der Artikel soll aufzeigen, was Creative Commons ist bzw. was sich hinter den Lizenzen versteckt, wie man diese anwendet und wie man Creative-Commons-lizenzierte Inhalte als Nutzer finden kann. (weiterlesen)

Zum Index

Linux allgemein

RAW-Bildverarbeitung unter Linux

Anleitungen

LanguageTool-Tutorial – Teil I

Software

Pfiffige Datensicherung mit storeBackup

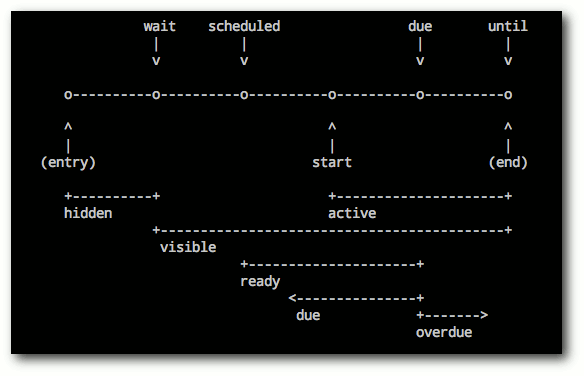

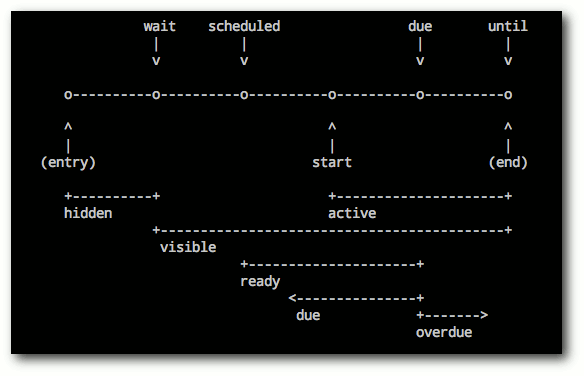

Taskwarrior - What's next? (Teil 3)

Redis – Suchen und Sortieren

Community

Creative Commons – Was ist das?

Rezension: Ubuntu 12.04 für Ein- und Umsteiger

Rezension: Android 4 – Apps entwickeln mit dem Android SDK

Magazin

Editorial

Leserbriefe

Veranstaltungen

Vorschau

Konventionen

Impressum

Zum Index

Neuzugang im September

Letzten Monat hatten wir im Editorial erwähnt [1],

dass uns ein Redakteur verlassen hat, aber bereits jemand Neues in den

Startlöchern steht. Dieser „Neue“ hat seinen Dienst pünktlich zur Oktoberausgabe

angetreten.

Sein Name ist für deutschsprachige Menschen fast unaussprechlich,

aber zumindest schreiben können wir ihn und heißen somit Sujeevan Vijayakumaran

in der Redaktion willkommen.

Sujeevan Vijayakumaran hält in der Redaktion wie die anderen Redakteure

den Kontakt zu den Autoren und betreut diese, wenn neue Artikel eingereicht

werden. Daneben kümmert er sich natürlich auch um die Beantwortung von

Leserbriefen, über die wir uns im Übrigen immer wieder freuen.

Neben freiesMagazin ist Sujeevan Vijayakumaran auch bei Ikhaya, dem Newsteam von

ubuntuusers.de [2], aktiv.

Wir wünschen Sujeevan eine schöne, lustige, aber vor allem auch eine lange Zeit

bei uns im freiesMagazin-Team.

Wo ist der Programmierwettbewerb?

Die letzten Jahre gab es bei freiesMagazin von Oktober bis Dezember immer wieder

verschiedene Programmierwettbewerbe [3].

Da wir derzeit auch Anfragen oder Vorschläge für einen neuen Wettbewerb bekommen,

hier ein kleines Update.

Auch dieses Jahr ist wieder ein Programmierwettbewerb geplant. Die groben

Details stehen schon, die Feinjustierung nimmt aber noch etwas Zeit in Anspruch.

Vor allem durch andere, private Verpflichtungen verzögert sich der

freiesMagazin-Programmierwettbewerb dieses Jahr etwas und wird voraussicht erst Anfang

Dezember starten. Über die Weihnachtsfeiertage sollten die

Teilnehmer dann hoffentlich etwas Zeit finden, um in die Tasten zu hauen.

Probleme mit Adobe Reader

Ein Autor meldete uns Probleme beim Öffnen eines unserer erstellen PDF-Dateien

mit dem Adobe Reader. So kann es passieren, dass der Adobe Reader einen

„Fehler 131“ beim Lesen des Dokumentes meldet.

Das Problem tritt beim Einsatz der LiveCycle ReaderExtensions auf. Hilfestellung

zur Behebung bietet dabei der Blog von Adobe [4].

Wir empfehlen daher zum Lesen der PDF-Ausgabe von freiesMagazin den Einsatz freier

PDF-Betrachter wie Evince oder Okular [5].

Ihre freiesMagazin-Redaktion

Links

[1] http://www.freiesmagazin.de/freiesMagazin-2012-09

[2] http://ikhaya.ubuntuusers.de/

[3] http://www.freiesmagazin.de/mitmachen#wettbewerb

[4] http://blogs.adobe.com/dmcmahon/2011/02/07/acrobatreader-there-was-a-problem-reading-this-document-131

[5] http://pdfreaders.org/index.de.html

Das Editorial kommentieren

Zum Index

von Mirko Lindner

Kameras der gehobenen Preisklasse können häufig Bilder im Rohdatenformat (RAW)

abspeichern. Dieser Artikel stellt die bekanntesten Applikationen unter Linux vor,

vergleicht sie und erklärt, wie anspruchsvolle Fotografen ihre Bilder noch

weiter verbessern können.

Redaktioneller Hinweis: Der Artikel „RAW-Bildverarbeitung unter Linux“ erschien erstmals bei

Pro-Linux [1].

Wer hat sich nicht schon einmal über den weißen, vollständig neutralisierten

Himmel geärgert, den man bei vermeintlich bestem Wetter und dem schönsten

Sonnenschein fotografierte? Der Grund liegt dabei nicht nur an einer falschen

Einstellung, sondern auch oftmals an einer technischen Schwäche der meisten

Geräte – dem Ausgabeformat.

Digitalkameras für gehobenere Bildverarbeitungsansprüche können deshalb neben

JPEG und anderen Dateiformaten oftmals die Ausgabe auch in einem

herstellerspezifischen Rohdatenformat (RAW) speichern. Im Gegensatz zu den

herkömmlichen Formaten handelt es sich bei der Ausgabe um keinen Standard und

man benötigt spezielle Applikationen, um sie zu verarbeiten.

Einführung

Sieht man von einem gedruckten Bild ab, so stellt die wohl am häufigsten

eingesetzte Möglichkeit, Bilder zu archivieren oder abzuspeichern,

mittlerweile

die Konvertierung des Bildmaterials in JPEG dar. Der in der Regel direkt durch

die Fotokamera durchgeführte Schritt ermöglicht dem Fotografen, seine Bilder

nicht nur platzsparend zu archivieren, sondern erspart ihm auch eine Menge

Arbeit. Denn betrachtet man die interne Struktur einer Digitalkamera, so wird

einem schnell klar, wie komplex die Arbeitsabläufe auch in den günstigsten

Modellen mittlerweile geworden sind.

Technisch gesehen wandelt der in einer digitalen Kamera integrierte CCD-Sensor

lediglich die Lichtintensität des einfallenden und durch verschiedene Filter in

die Grundfarben zerlegten Lichtes in elektrische Spannung um, welche dann in

eine digitale Form in Bits und Bytes übersetzt wird. Die eigentliche Mechanik

und Optik der Digitalkamera sind lediglich für die Scharfstellung, die

Abschätzung der Belichtungszeit- und Blendenkombination sowie für die optische

Filterung verantwortlich. Fällt das Licht durch das Objektiv auf die Kamera,

wird es durch diverse Tiefpass-, Infrarot- und

Farbfilter durchgereicht und die

daraus gewonnenen Lichtintensitäten in entsprechende elektrische Signale mittels

Diskretisierung und Quantisierung gewandelt.

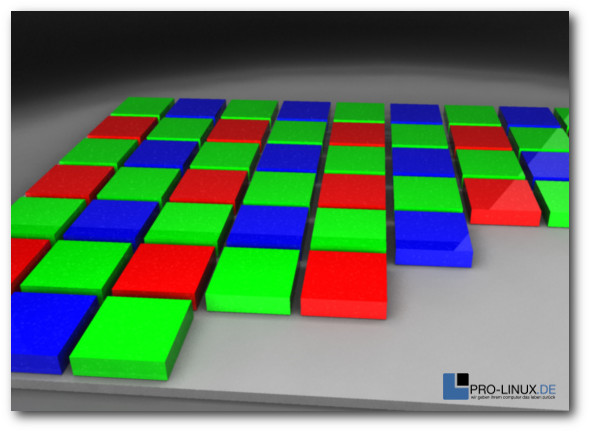

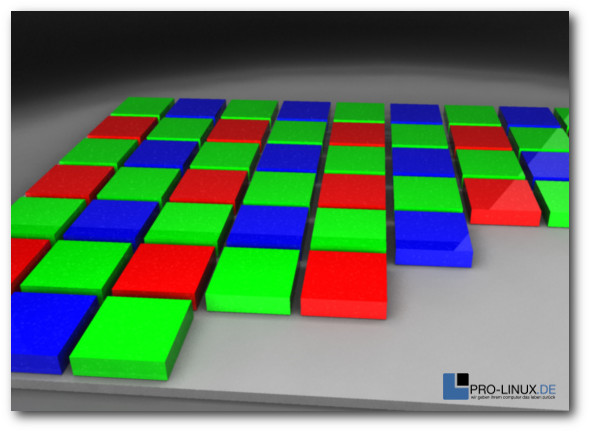

Verantwortlich für die Aufnahme eines Bildes ist der Fotosensor eines Gerätes,

der ähnlich wie ein Schachbrett mit einem Farbfilter nach dem Konzept der

Bayer-Matrix überzogen ist. Die lichtempfindlichen Zellen einer einzelnen

Fotozelle können dabei nur Helligkeitswerte erfassen. Um Farbinformationen zu

erhalten, wird vor jeder einzelnen Zelle ein Farbfilter in einer der drei

Grundfarben Rot, Grün oder Blau aufgebracht. Jeder Farbpunkt liefert dabei nur

Informationen für eine einzige Farbkomponente.

Farbmuster eines Chip-Farb-CCDs – Hier der Bayer-Sensor.

Die eigentliche Berechnung der Bildwerte übernimmt deshalb eine integrierte

Firmware direkt auf dem Gerät mittels einer Interpolation

(Demosaicing [2]). Die verwendete Software

geht in der Regel davon aus, dass es im Bild zwischen zwei benachbarten Pixeln

gleicher Farbe nur zu geringen Farbunterschieden kommt. Einfache Verfahren

interpolieren deshalb den Farbwert aus den Pixeln gleicher Farbe in der

Nachbarschaft und errechnen somit den Farbwert eines Pixels. So errechnete

Bilder werden schlussendlich in einer Datei, meistens JPEG, gespeichert.

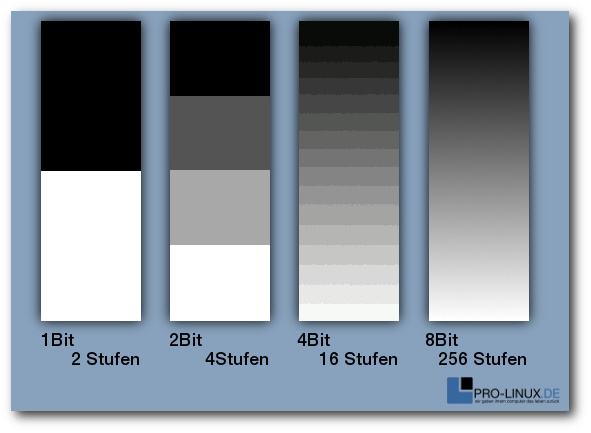

Doch gerade die gebräuchlichsten Formate zur Bildspeicherung erlauben es häufig

nicht, alle Informationen, die der Sensor der Kamera liefert, zu speichern. So

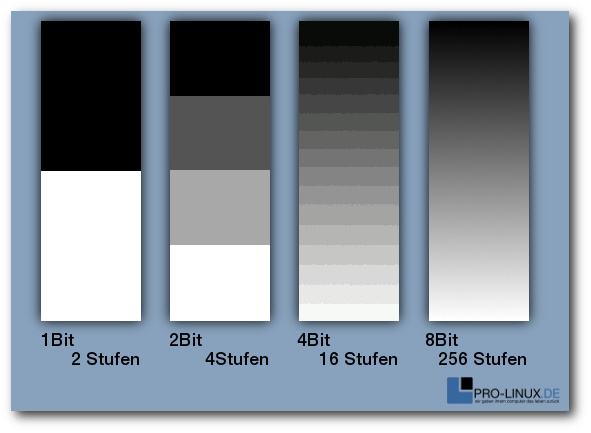

bieten beispielsweise die allseits eingesetzten JPEG-Varianten nur 8 Bit pro

Farbkanal an. Einfach dargestellt ist es also in einem JPEG-Bild nicht möglich,

mehr als 256 Helligkeitsabstufungen in einem einzelnen Farbkanal zu nutzen.

Aufgrund der Charakteristik des üblicherweise eingesetzten Sensors sind

allerdings bei weitem mehr Helligkeitsabstufungen möglich. Um die Informationen

des Bildes zu speichern, konvertieren die meisten Kameras nach dem Demosaicing

das Bild in ein gängiges Format und zerstören dabei unwiderruflich

Bildinformationen. Die Speicherung des Bildes in einem verlustbehafteten Format

wie JPEG tut schlussendlich den Rest, damit viele der ursprünglich vorhandenen

Bilddaten vollends vernichtet sind.

Das RAW-Format

Um das Problem zu umgehen, können deshalb vor allem Digitalkameras für

gehobenere Bildverarbeitungsansprüche neben JPEG oftmals auch ein sogenanntes

RAW-Format verarbeiten. Die Bilder der Digitalkamera, die normalerweise durch

die interne Elektronik verarbeitet werden, werden so in einem verlustfrei

komprimierten Format noch vor der Verarbeitung durch die Firmware mit

vollständigen Farbwerten auf

die Speicherkarte geschrieben (auch wenn manche

Modelle auch hier bereits automatische Eingriffe durchführen). Der Fotograf

behält so die komplette Kontrolle über das eigene Bild und kann nahezu alle

Parameter nachträglich – einschließlich der Interpolation – ändern oder

korrigieren. Einstellungen wie Weißabgleich, Farbtemperatur, Scharfzeichnung

oder Kontrasteinstellung können zu einem späteren Zeitpunkt am PC den eigenen

Bedürfnissen angepasst und verändert werden. Darüber hinaus beherrschen die

meisten Rohdatenformatdateien viel feinere Abstufungen jenseits des limitierten

JPEG-Formats. So sind bei RAW 12 (4.096 Stufen) oder 14 Bit (16.384 Stufen)

mittlerweile die Regel. Dadurch steht beispielsweise einer nachträglichen

Helligkeitsanpassung von nicht optimal belichteten Bildern nichts im Wege.

Zudem lassen sich in RAW-Dateien vor allem Übergänge zwischen verschiedenen

Helligkeitsstufen, wie Schatten, besser darstellen.

Die Zahl der Abstufungen innerhalb eines Farbkanals wird in Bit gemessen. Beispiele für Helligkeitsstufen.

Doch des einen Freud ist des anderen Leid. Zwar lassen sich auch in RAW Bilder

zügig erstellen, doch bedürfen sie später einer nachträglichen Bearbeitung.

Es gibt mittlerweile auch Kameramodelle, die die Ausgabe des bearbeiteten

Bildmaterials auch in RAW ermöglichen, doch hebelt diese Möglichkeit in der

Regel die Vorteile des Formats aus. Zudem sind die Dateien des RAW-Formats

erheblich größer als die von JPEG, was nicht nur eine längere Übertragungszeit

bedeutet, sondern auch eine Verringerung der erreichbaren Bilder pro Sekunde,

die eine Digitalkamera abspeichern kann.

Ein weiterer, nicht zu unterschätzender Nachteil von RAW-Formaten stellen die

Kosten der Hardware dar. Zwar gingen in der Vergangenheit immer mehr Hersteller

dazu über, auch kompakte und semiprofessionelle Digitalkameras mit

RAW-Unterstützung auszustatten, doch mittlerweile stellt die Ausgabe einen

strategischen Mehrwert dar und wird in der Regel als Unterscheidungskriterium

zwischen den verschiedenen Einsatzbereichen genutzt. So verbaut beispielsweise

Canon seine RAW-fähigen DIGIC-Bildprozessoren gleichermaßen in

semiprofessionellen wie in Einsteiger-Geräten. Doch während die erstgenannte

Zielgruppe die Bilder auch im RAW-Format speichern kann, müssen Einsteiger auf

diese Funktionen verzichten. Abhilfe lässt sich hier allerdings mittels des

Firmware-Aufsatzes CHDK (Canon Hacker Development

Kit [3]) schaffen, der neben erweiterten

Aufnahme-Modi auch Funktionen zur Raw-Speicherung in Kompaktkameras freischaltet.

RAW-Bilder bearbeiten

Betrachtet man das RAW-Dateiformat als das, was es ist – ein Kamera-spezifischer

Datenstrom – so kommt man sehr schnell zu dem Schluss,

dass das „Format“ im

Grunde kein allgemeines Format sein kann. In der Praxis verwendet jeder

Hersteller ein eigenes Format. So

versieht etwa Canon RAW-Dateien mit der Extension CR, CD2 und in neuen Geräten

mit CRW. Minolta kennzeichnet die eigenen Dateien mit MRW oder MDC und Nikon

vergibt die Endung NEF oder

NRW. Kodak dagegen hat das eigene Format bereits

mehrfach geändert und kommt mit den Endungen DCR, DCS oder KDC daher, während

Sony auf SRF, SR2 und ARW zurückgreift. Somit muss eine Applikation die Formate

vieler Kamera-Hersteller beherrschen, wenn sie den Anspruch hat, RAW-Dateien zu

unterstützen.

Dementsprechend bieten viele Produzenten von Digitalkameras ihre eigenen

Applikationen an, die das interne Format einlesen und weiterverarbeiten können.

Zudem existieren auch diverse Erweiterungen, wie beispielsweise für Photoshop,

die auch mit neuen Geräten zurecht kommen. Doch auch unter Linux gibt es eine

Fülle von Anwendungen, die für die Weiterverarbeitung und die Manipulation der

Bilder genutzt werden können. Manche davon sind frei, andere wiederum

proprietär.

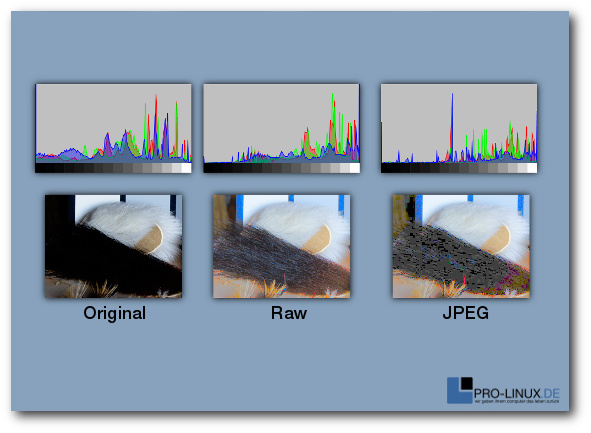

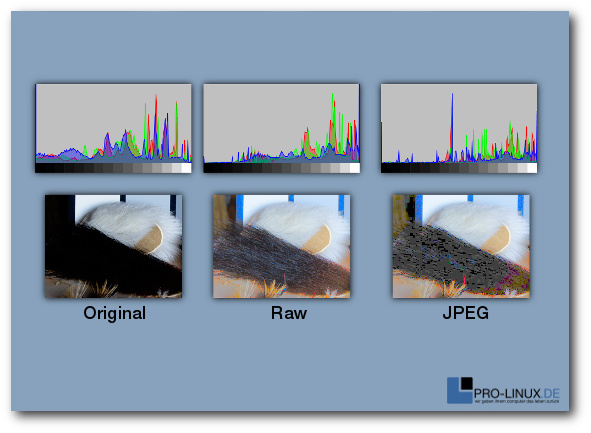

Beispiel eines Bildes nach einer extremen Aufhellung: Original, Raw und JPEG.

Doch wozu das Ganze? Beschränken sich die eigenen Ambitionen beim Fotografieren

lediglich auf das Festhalten von Bildinformationen und eine kleinere

nachträgliche Änderung, wie zum Beispiel die Entfernung von roten Augen, so ist

der Einsatz von RAW-Dateien nicht wirklich zu empfehlen. Der Aufwand der

Bearbeitung und die daraus resultierenden Vorteile werden in den seltensten

Fällen die geringe Qualitätssteigerung rechtfertigen. Hier kann die

Kamera-Elektronik bei weitem die eigenen Ansprüche erfüllen.

Anders verhält es sich, wenn der Anwender umfangreichere Nachbearbeitungen

vornehmen und Werte, wie etwa die Tonwertkorrektur oder die Anpassung von

Kontrast und Bilddynamik, selbst einstellen möchte. Ein weiterer Fall stellt die

Korrektur des Weißabgleichs dar oder die Rettung von Bildern. Wie im

nebenstehenden Beispiel erkennbar, liefert das RAW-Format auch bei vermeintlich

nicht mehr zu gebrauchenden Bildern noch akzeptable Resultate, während das

JPEG-Format hier meistens passen muss.

Das RAW-Format ist also in der Regel dann angebracht, wenn der Anwender entweder

die volle Kontrolle über ein Bild erhalten will oder er damit rechnen muss, dass

eine spätere Nachbearbeitung von Nöten sein wird. Dies kann zum einen von den

herrschenden Wetter- oder

Lichtverhältnissen, zum anderen von der gegebenen

Situation abhängen.

RAW und HDR

In der Digitalfotografie sind die Grenzen des technisch Machbaren recht eng

gesteckt. Sobald

eine Szene über einen großen Dynamikumfang verfügt, ist auch

ein Kamerasensor schnell überfordert. Zu sehen sind die Effekte bei vielen

Anlässen, denn sobald das Spektrum zwischen hellen und dunklen Stellen für einen

Sensor zu groß wird, verschwinden Details, Schatten werden zu dunklen Flecken

oder Wolken zu einer weißen Masse. Tritt solch ein Fall ein, hilft auch das

RAW-Bild nicht weiter, denn auch hier bilden die Rohdatenformate von

Digitalkameras nicht den gewünschten Dynamikumfang ab.

Doch es gibt durchaus Wege, den Dynamikbereich auszuweiten. So bilden

beispielsweise HDR-Aufnahmen ein Motiv mit einer Belichtungsreihe in vollem

Dynamikumfang der Kamera ab. Vereinfacht gesagt wird in diesem Fall ein Motiv

normal, unter- und überbelichtet. Die so entstandenen Einzelfotos der

Belichtungsreihe werden am PC zu einem HDRI („High Dynamic Range Image“) Bild

zusammengesetzt. Das Ergebnis kann dabei sehr unterschiedlich ausfallen, doch

die Bilder zeichnen sich durch einen Detailreichtum aus, der weit über den

Dynamikumfang des Sensors und des RAW-Bildes hinausgehen kann.

Beispiel einer aus vier Einzelbildern erstellten HDR-Szene.

© Vorlage: Kevin McCoy, Gesamtwerk: Darxus (CC-BY-SA 3.0)

Auch wenn ein HDR-Bild den Dynamikumfang im Ausgangsbild steigern kann, spielt

auch hier das Eingangsmaterial eine Rolle. Wurde das Bild aus mehreren

RAW-Bildern erzeugt, lässt das Ausgangsbild erheblich mehr Farbabstufungen zu

als ein HDR-Bild auf Basis von gleich vielen JPEG-Dateien. Der Grund sollte auch

hier klar sein: In den Ausgangsbildern des RAW-Formats ist der Dynamikumfang in

mehr Farbabstufungen abgebildet worden, als es beispielsweise bei JPEG der Fall

sein kann. Die Folge sind Bilder, die durch die verwendete Software noch

präziser berechnet und dargestellt werden können.

RAW unter Linux

Auch das freie Betriebssystem Linux bietet zahlreiche Anwendungen zur

Bearbeitung von RAW-Bildern an. Doch bei der Nutzung ist Vorsicht geboten, denn

nicht jede Applikation eignet sich für die Einsatzzwecke. Zwar verfügen

mittlerweile viele Tools dank libraw oder dcraw auch über eine Import-Funktion,

doch können sie aufgrund ihrer Funktionsweise oftmals nicht korrekt mit dem

gelieferten Material umgehen. Ihnen fehlt es schlicht an einer internen

Unterstützung für den erweiterten Dynamikbereich. Die Folge sind unter anderem

Bilder, die zwar dem RAW-Format entstammen, von der Software aber auf einen

kleineren Dynamikbereich heruntergerechnet wurden.

Ein prominentes Beispiel stellt dabei der allseits beliebte Grafikkünstler Gimp

dar, der mittels diverser Plugins auch um einen RAW-Import ergänzt werden kann.

Da die Anwendung intern allerdings nur mit 8 Bit arbeitet, verlieren Anwender

bei der Bearbeitung mit Gimp unwiderruflich Bild-Informationen. Eine Abhilfe

wird wohl erst eine kommende Version mit sich bringen, die auch mit dem

erweiterten Dynamikbereich klar kommen soll. Gimp informiert deshalb in der

aktuellen Version vor einem Import über die Gefahren. Viele andere Anwendungen tun es

allerdings nicht.

Die folgende Auflistung unterschlägt deshalb bewusst alle Applikationen, die

nicht in der Lage sind, den vollen Dynamikumfang der RAW-Quelle zu verarbeiten.

Auch diverse kleinere Applikationen, die nicht über ein Mindestmaß an

Korrekturfunktionen verfügen, finden sich nicht in der Liste der getesteten

Programme. Ebenso das Kommandozeilentool „dcraw“ selbst, das zwar die Basis

vieler Tools darstellt, aber nur über marginale Korrekturmöglichkeiten verfügt.

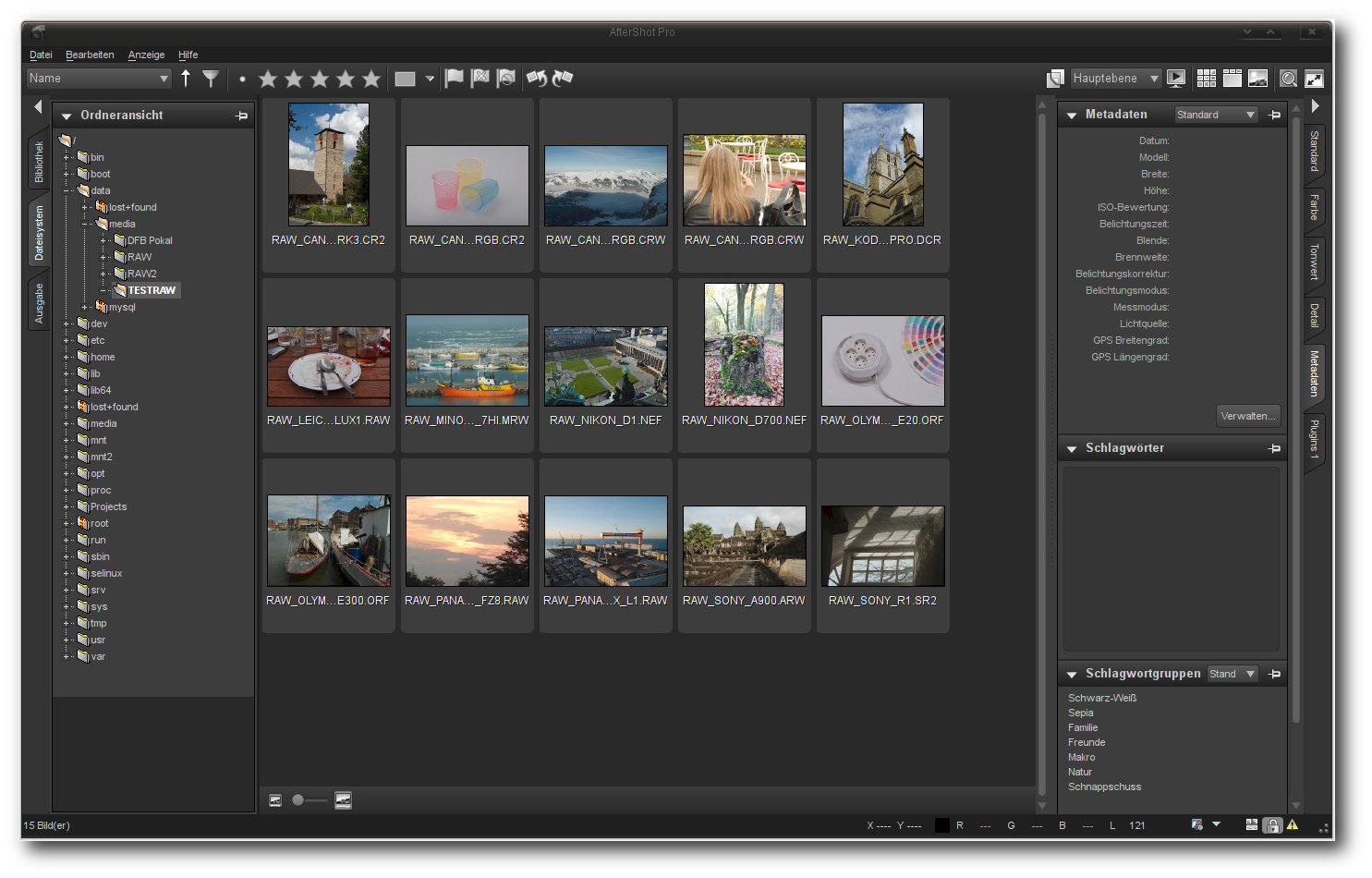

AfterShot Pro

Das Fotoentwicklungs-Programm AfterShot

Pro [4] des kanadischen Herstellers Corel

könnte eigentlich auch Bibble 6 heißen. Seit der Übernahme der kleinen

texanischen Software-Schmiede

Bibble [5]

hat sich optisch nicht viel getan und AfterShot Pro sieht nicht nur wie Bibble

aus, sondern fühlt sich auch so an. Die Software zeichnet sich auch in der neuen

Version durch eine hohe Arbeitsgeschwindigkeit und viele Funktionen aus. Eine

Stärke von AfterShot

Pro stellt auch die Plugin-Schnittstelle dar. Noch sind

allerdings nicht alle mit Bibble lauffähigen Plugins kompatibel mit der neuen

Anwendung.

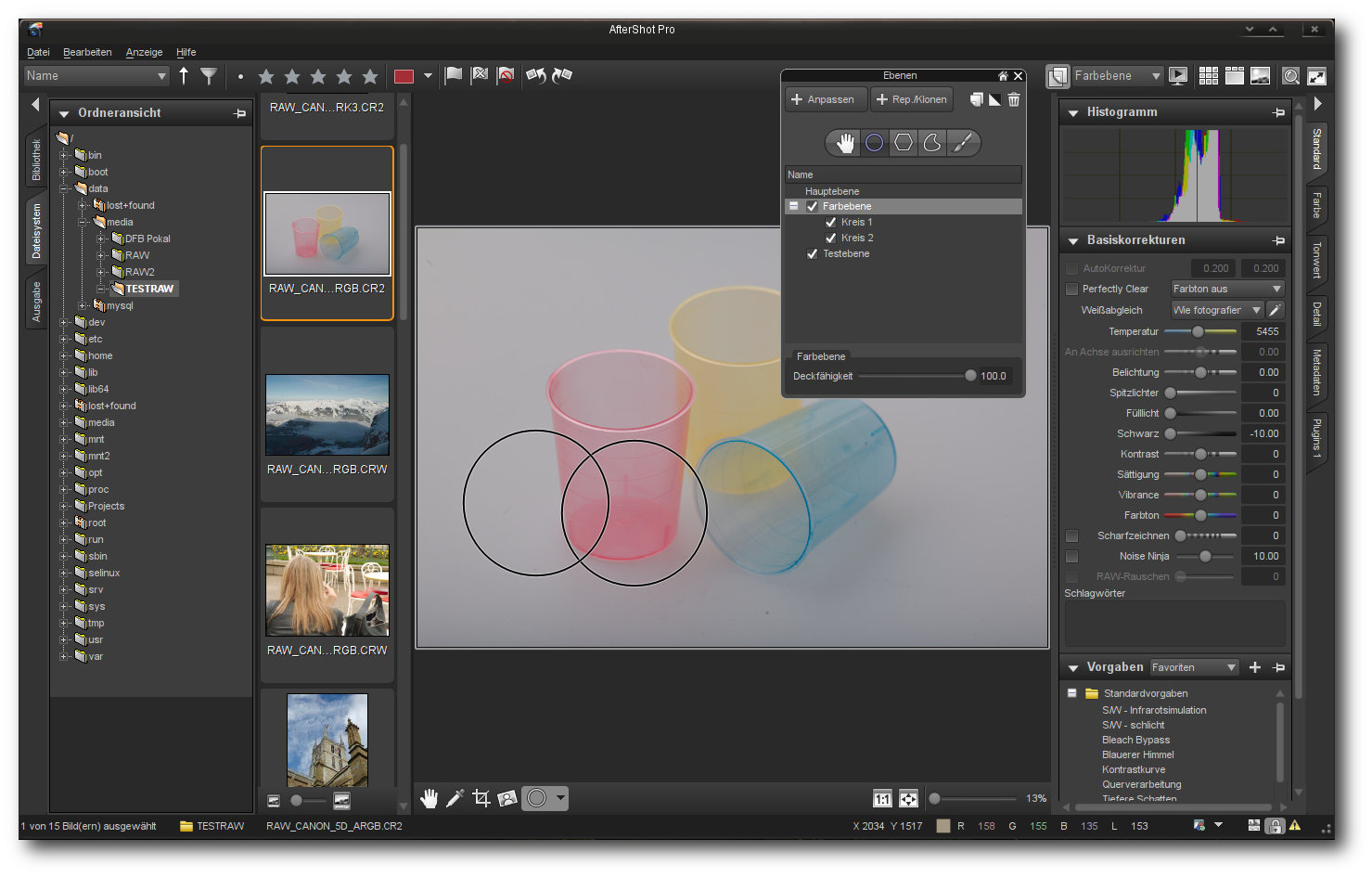

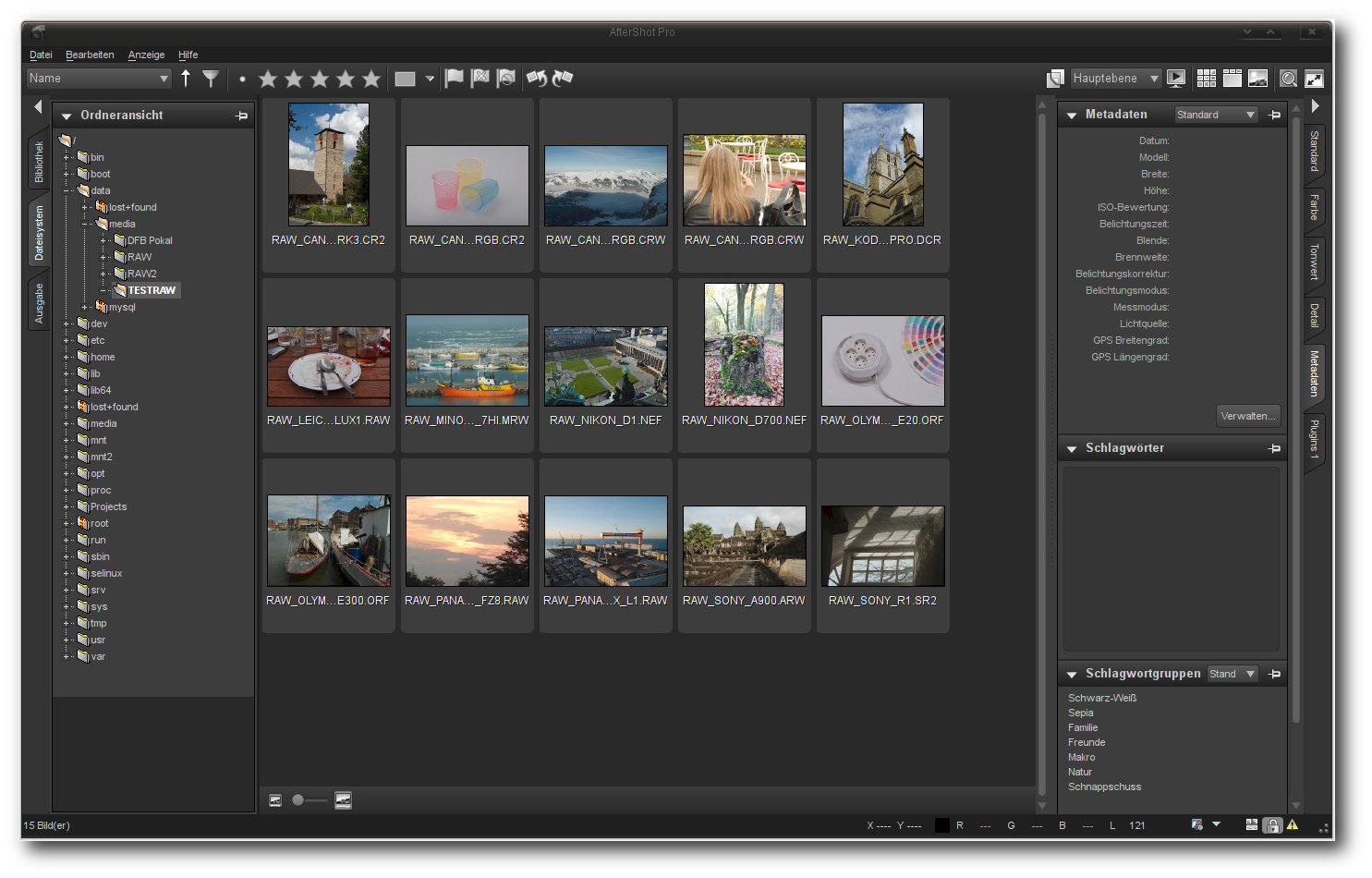

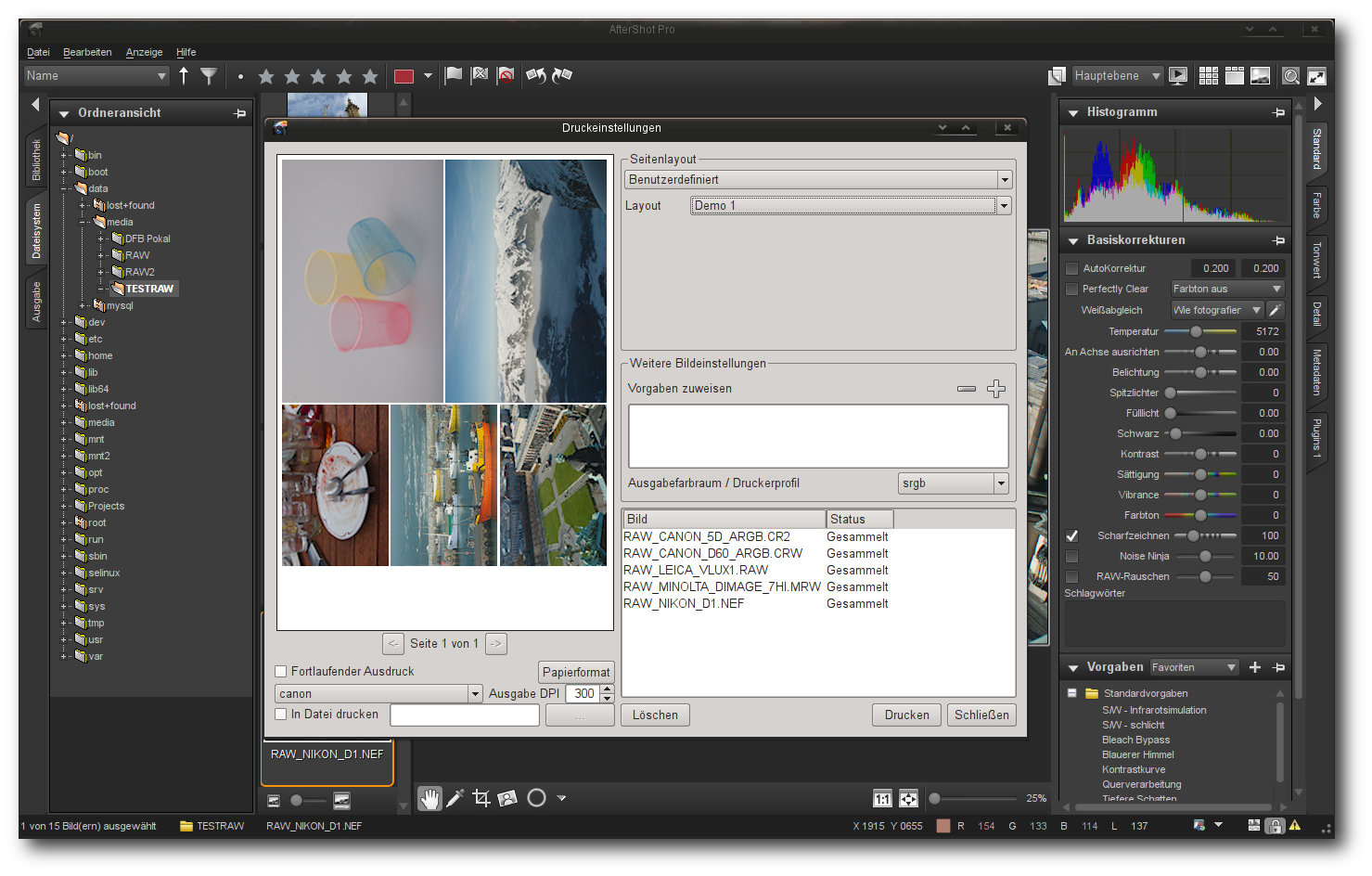

AfterShot Pro.

Wie in anderen Anwendungen nimmt auch unter AfterShot Pro die Bilddarstellung

den Großteil des Bildschirms ein. Hier können Anwender zwischen verschiedenen

Ansichten eines Bildes wählen – unter anderem einer Miniaturansicht, einer

Einzelbildanzeige oder einem Vergleich verschiedener Bilder. Links angeordnet in

der Applikation sind die Reiter „Bibliothek“, „Dateisystem“ und „Ausgabe“, die

einen schnellen Zugriff auf die Ein- und Ausgabe Funktionen der Anwendung

gewähren. Am rechten Bildschirmrand der Anwendung bindet AfterShot Pro die

Korrekturwerkzeuge ein, die in die Gruppen „Standard“, „Farbe“, „Tonwert“,

„Detail“, „Metadaten“ und „Plugins“ unterteilt sind. Die Werkzeugleiste selbst

lässt sich von der Hauptanwendung trennen und auf einen Zweitmonitor

verschieben, was noch mehr Platz der eigentlichen Bilddarstellung verschafft.

Die Anzeige der Bilder in der Galerieansicht erlaubt eine Bewertung, Verschlagwortung oder aber auch die Suche.

Bereits vorhandene Archive werden bei AfterShot Pro entweder direkt in eine

zuvor festgelegte Struktur integriert oder auf dem Speicherort belassen. So

können bereits bewährte Strukturen auch beibehalten werden, ohne dass sie auf

die Anwendung zugeschnitten sein müssen. Zudem lassen sich neue Verzeichnisse

als Kataloge in die Anwendung einbinden, was in der Praxis

einer getrennten

Datenbank gleichzusetzen ist. Erwähnenswert ist hier auch, dass die Anwendung

bei der Suche nicht nur eine, sondern auch mehrere Datenbanken berücksichtigen

kann. Der Direktzugriff auf Dateisystemordner ist möglich, ohne dass die Bilder

zuvor in die Datenbank importiert werden mussten. Eine direkte Importfunktion

von einer Kamera aus bringt die Anwendung allerdings nicht mit.

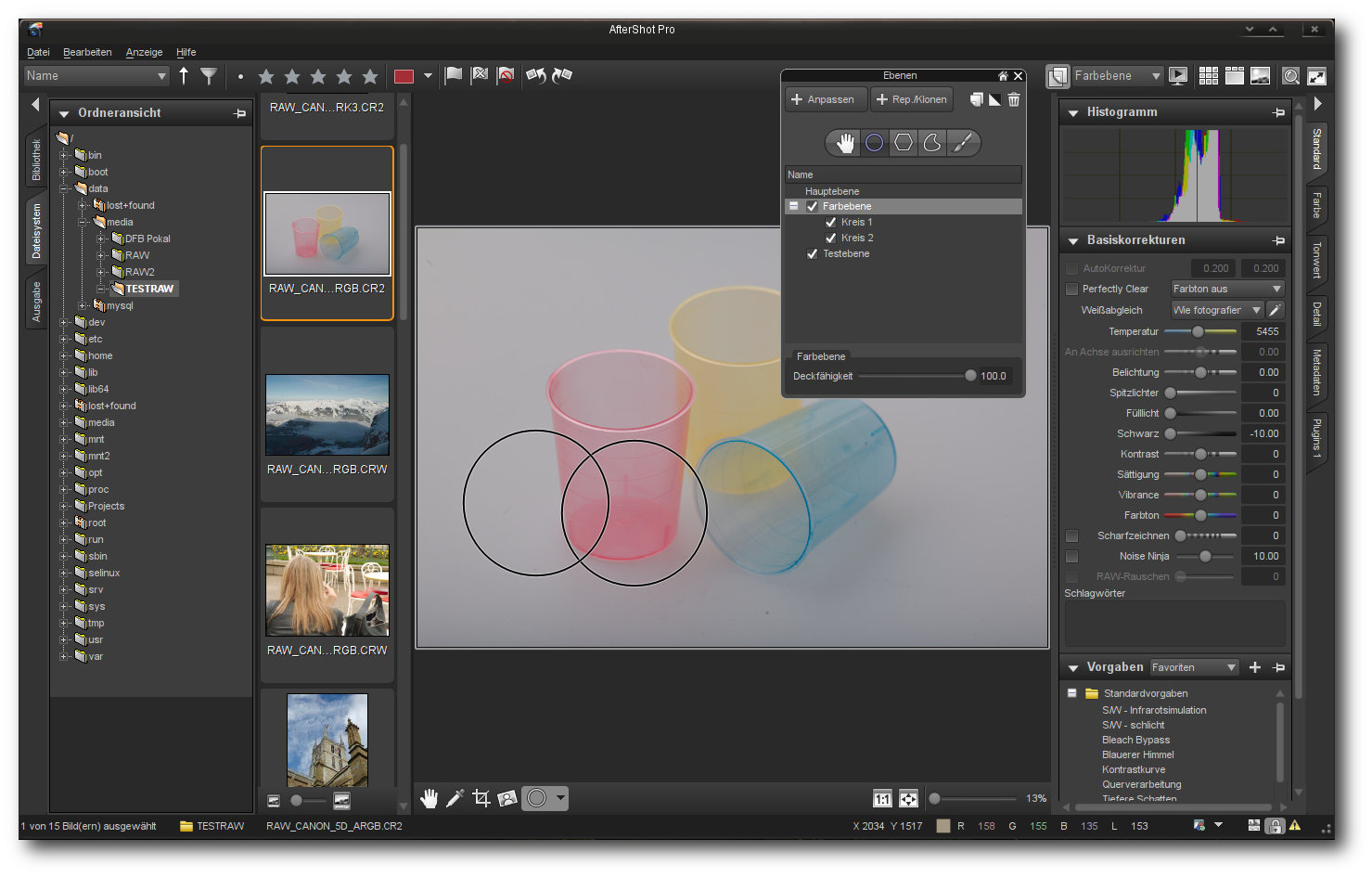

Die eigentliche Bearbeitung von RAW-Dateien mit AfterShot erfolgt flott. Dank

konfigurierbarer Werkzeuge und Ansichten kann die Anwendung an den individuellen

RAW-Workflow angepasst werden. Die Fotobearbeitung geschieht dabei, wie auch

schon bei Bibble, durch das nichtdestruktive Anwenden von Werkzeugen. So lassen

sich zu jedem Zeitpunkt immer die Quelldaten rekonstruieren und alle Schritte

wiederholen, ohne dass nur ein Pixel im Original verändert worden ist.

Änderungen speichert AfterShot Pro in einer separaten Steuerungsdatei, die im

selben Verzeichnis wie das Original liegt. Beim Laden des Bildes wendet die

Applikation dann automatisch alle durchgeführten Schritte an.

Änderungen können auch auf einzelne Layer oder Regionen angewendet werden.

Die ausgeklügelte Stapelverarbeitung erlaubt verschiedene Parameter,

beispielsweise für Fülllichter für die Aufhellung, Weißabgleich oder Noise Ninja

auf hunderte von Fotos anzuwenden. Doch nicht nur globale Parameteränderungen

sind mit der Funktion möglich, auch zahlreiche aufwändige Bearbeitungsschritte

lassen sich im Stapelbetrieb auf mehrere Bilder anwenden.

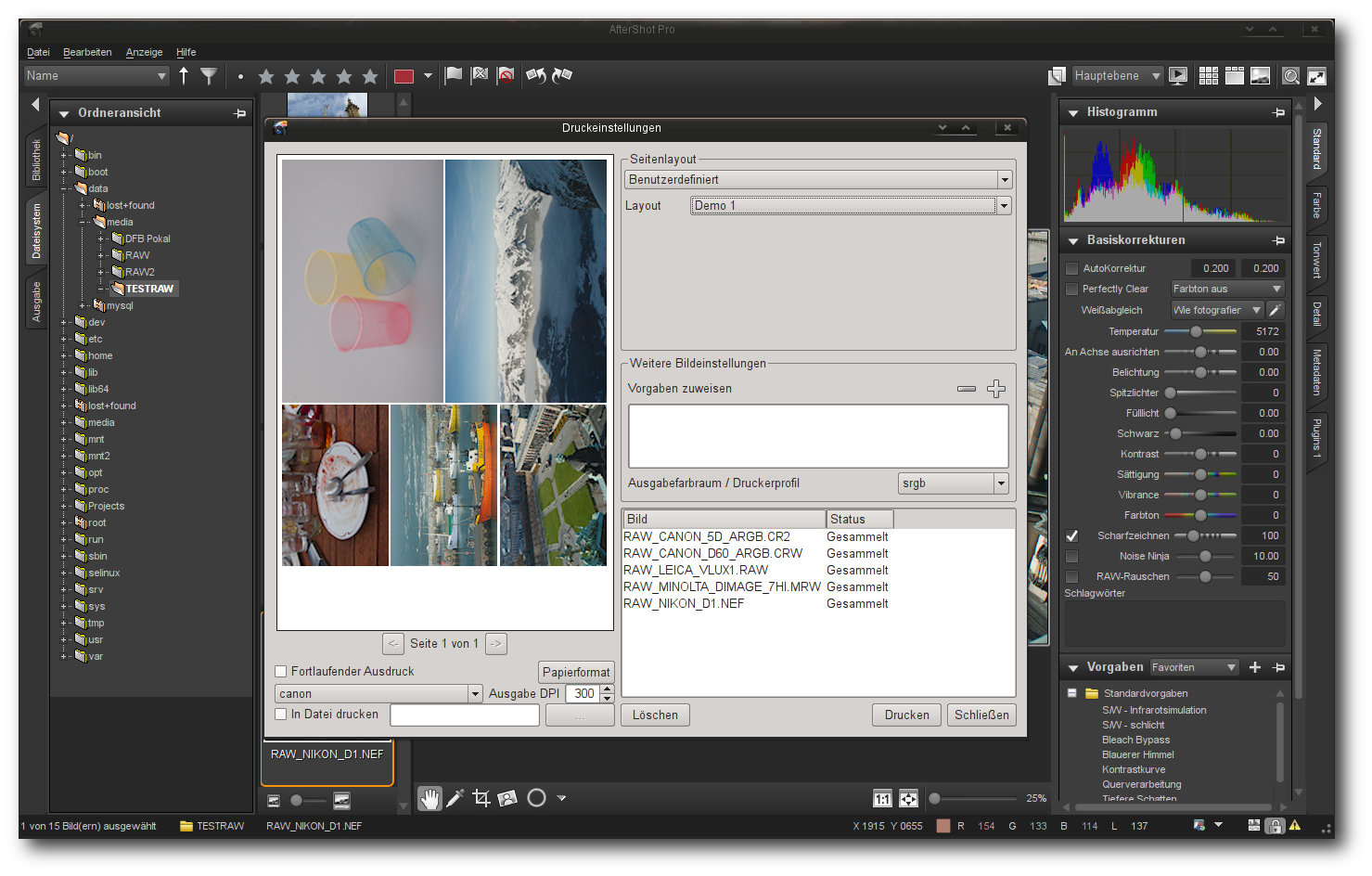

Die Druckoption erlaubt es, eigene Layouts zu definieren.

Sämtliche Bearbeitungsfunktionen lassen sich über Ebenen auf einzelne

Bildbereiche anwenden. Der Konverter unterstützt zudem viele Kameras und

Objektive. Sind ein Kameramodell und ein Objektiv bekannt, kann die Anwendung

die Korrekturen für Weichzeichung und Vignettierung automatisch durchführen. Zum

Entrauschen setzt AfterShot Pro auf eine funktionsreduzierte Version von

Noise Ninja [6].

Die Korrektur von stürzenden Linien ist in der Anwendung nicht

eingebaut, die kann allerdings mit dem kostenlosen Plugin

zPerspector [7]

nachgerüstet werden. Einmal getätigte Korrekturschritte lassen sich zudem

abspeichern und automatisiert auf andere Bilder anwenden.

Ergebnisse bei einer Suche nach gewünschten Inhalten liefert AfterShot Pro dank

einer

integrierten Datenbank schnell. Als Kriterien stehen dabei sämtliche durch

IPTC und/oder EXIF bereitgestellten Informationen, Bewertungen oder Tags zur

Verfügung. Hier könnte der Hersteller allerdings noch ein wenig mehr Arbeit

leisten und die Suchfunktion um eine Verknüpfung unterschiedlicher Merkmale

ergänzen. Beim Speichern trägt die Anwendung die Tags in die eigene Datenbank

oder in eine XMP-Begleitdatei ein. Direktes Schreiben der EXIF- oder IPTC-Daten

in die Originaldatei unterstützt das Programm nicht. Lediglich die Kopie des

Originals enthält auf Wunsch die zusätzlichen Daten. Auch die Auswertung von

Geotags unterstützt AfterShot Pro nicht.

Die Ausgabe der Bilder erfolgt bei AfterShot Pro in den Formaten JPEG und TIFF

(8/16 Bit). Weitere Formate unterstützt die Anwendung nicht. Zudem lassen sich

Bilder direkt von der Anwendung aus in verschiedenen zuvor definierten Layouts

drucken. Ein in der Bildanzeige zuschaltbares Soft-Proofing liefert erste

Anhaltspunkte, wie es unter verschiedenen Profilen aussehen wird. Auch eine

Ausgabe in Form einer Diashow ist in der Anwendung implementiert, wobei die

Ausgabe als solche recht minimalistisch daherkommt und beispielsweise über

keinerlei Effekte verfügt.

Fazit: AfterShot Pro bietet eine Fülle von Korrekturfunktionen und eine durchaus

ansehnliche Bildverwaltung. Die mächtige Stapelbearbeitung erlaubt es, hunderte

von Bildern automatisch zu korrigieren und zu archivieren. Auch die Integration

in die Linux-Umgebung kann als gelungen bezeichnet werden. Probleme zeigt

AfterShot Pro dagegen in fast allen Belangen der Bildpräsentation. Auch ein

Import von Bildern direkt von einer Kamera aus und die unausgereifte Suche

trüben das ansonsten perfekte Bild.

Darktable

Der relativ neue und erst Anfang des Jahres in der Version 1.0 freigegebene

Bildverwalter und -Optimierer Darktable [8] wartet

mit einer vertrauten Optik und einem durchdachten

Bedienkonzept auf. Trotz des

relativ geringes Alters von drei Jahren beherrscht das Programm erstaunlich viele

Funktionen, die von der Konvertierung über die Bearbeitung bis hin zu einer

ausgeklügelten Ausgabe samt einer durchdachten Stapelverarbeitung reichen.

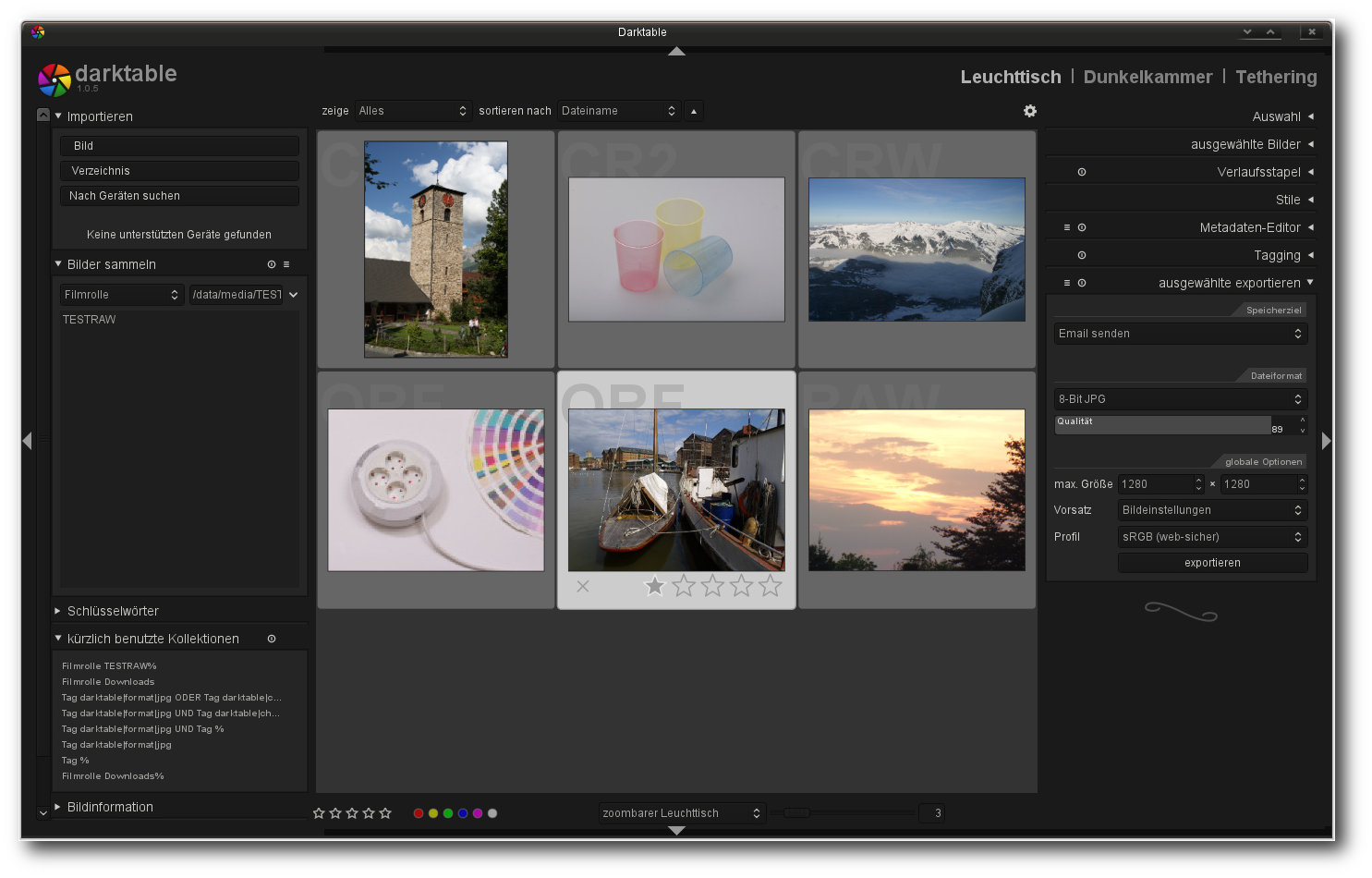

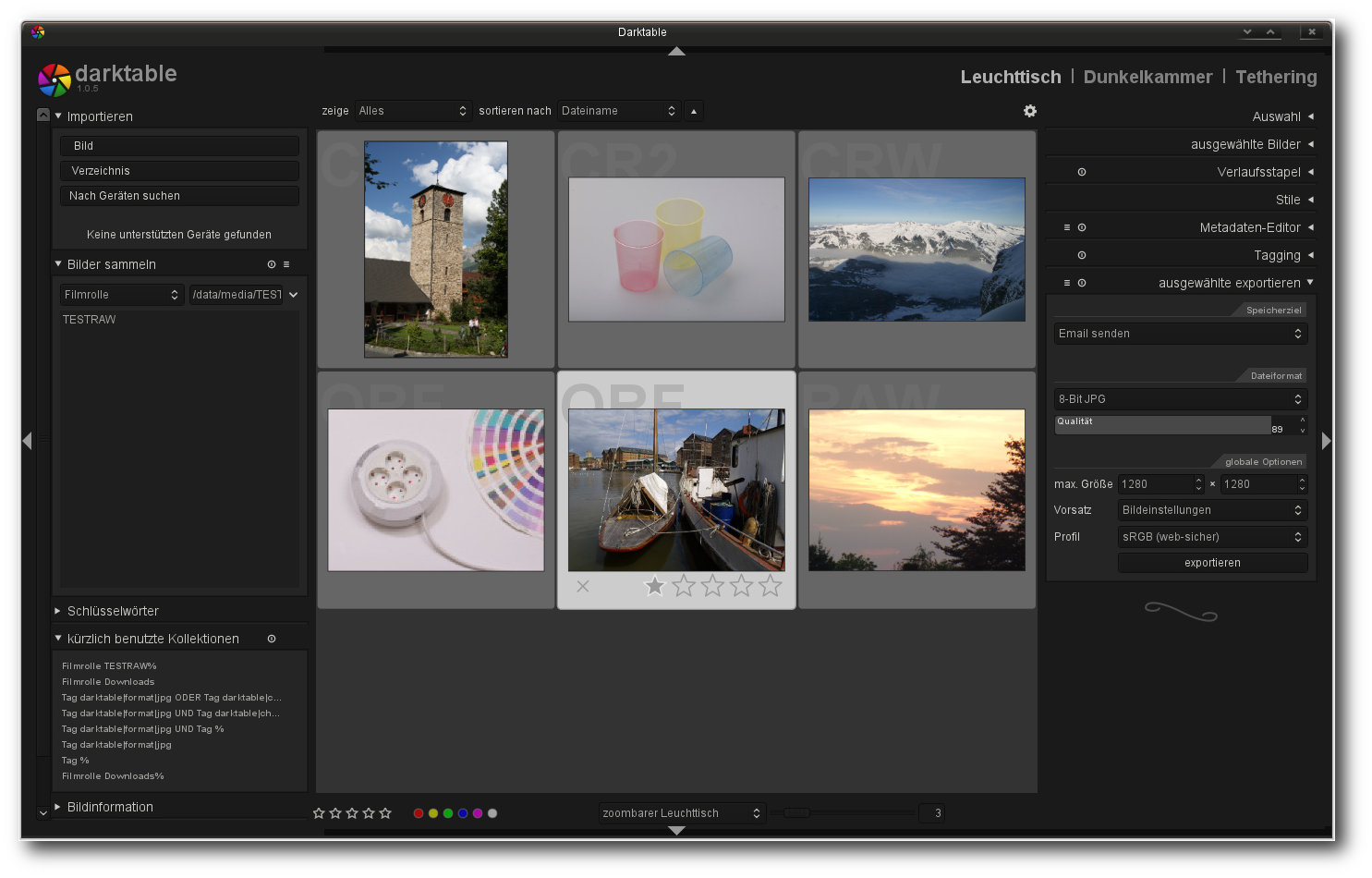

Darktable.

Die Oberfläche von Darktable wirkt auf den ersten Blick spartanisch. Doch der

Schein trügt, denn hinter den wenigen Punkten verbergen sich Funktionen, die

einen kompletten RAW-Workflow ermöglichen. Auf der linken Seite der Anwendung

sind die Datei- und Datenbankfunktionen untergebracht. Auch in Darktable

dominiert der mittlere Bildbereich, der fast die komplette Fläche füllt. Auf der

rechten Seite sind dagegen die

für den momentan aktiven Bereich verfügbaren

Werkzeuge zu finden.

Streng genommen kann Darktable in drei logisch angeordnete Bereiche unterteilt

werden: Leuchttisch („lighttable“), Dunkelkammer („darkroom“) und „Tethering“.

So finden sich auf dem Leuchttisch alle Operationen, die mit der Verwaltung der

Bilder zu tun haben. Hier können Verzeichnisse zu Galerien zusammengefasst,

Geräte eingebunden oder Bildern eine Wertung oder die passenden Schlüsselwörter

gegeben werden. Auch die Suche nach Bildern ist hier implementiert. Sie erlaubt

unter anderem logische Operationen und die Verknüpfung von mehreren

Kategorien. Auf ausgewählte Bilder können auf dem

Leuchttisch zudem automatisch

ablaufende Operationen angewendet werden, was die Bearbeitung einer großen Zahl

an Bildern mit einem minimalen Zeitaufwand ermöglicht.

Den zweiten Bereich stellt die Dunkelkammer dar. Neben einer Auflistung der

Werkzeuge blendet der Bereich auch eine Filmrolle ein, die zur schnellen

Umschaltung zwischen verschiedenen Bildern genutzt werden kann. Bei der

Werkzeugauswahl ist zu beachten, dass die Applikation im Standardmodus nicht

alle Funktionen einblendet. Viele wenig benutzte Funktionen oder Funktionen,

die die Entwickler für weniger relevant halten, finden sich hinter der

Schaltfläche „Weitere Module“. Ein Klick auf den Bereich bringt

ein Fenster mit

Piktogrammen zum Vorschein, in dem Werkzeuge ein- und ausgeschaltet oder in die

Favoritenleiste verfrachtet werden können.

In der Dateisystemansicht können Bilder bewertet, verschlagwortet oder gesucht werden.

Der Funktionsumfang der Dunkelkammer ist mittlerweile beachtlich und braucht

sich nicht hinter anderen Anwendungen zu verstecken. Bildkorrekturen werden in

Darktable verlustfrei durchgeführt. Alle Korrekturen wie beispielsweise die

Anpassung des Weißabgleichs, das Schärfen oder die Farbkorrektur können in

einer Voreinstellung gespeichert und wenn benötigt, später auch für andere

Bilder projiziert werden. Alle durchgeführten Aktionen, samt Werten, speichert

Darktable zudem in einem Verlaufsbereich, der zu jedem Zeitpunkt gespeichert und

als Basis für andere Bilder oder für eine Stapelverarbeitung genutzt werden

kann. Selten war die Erstellung von RAW-Prozessketten so einfach wie unter

Darktable.

Die Bedienung der mitgelieferten Werkzeuge gestaltet sich durchaus intuitiv,

auch wenn die Auswahl der Tools teilweise verwirren kann. Ein Kritikpunkt ist

allerdings die Geschwindigkeit mancher Helfer, die in manchen Bereichen noch

Wünsche offen lässt. Auch die Funktionsweise diverser Werkzeuge könnte

Verbesserungen erfahren. So korrigiert beispielsweise die Objektivfunktion das

Bild nicht wirklich zufriedenstellend.

Hinter dem Reiter „weitere Module“ verstecken sich weitere Funktionen, die explizit eingeschaltet oder als Favoriten gesetzt werden können.

In der Version

1.0 [9] stellte

Darktable erstmalig auch die Tethering-Funktion vor, die nun im dritten Bereich

der Anwendung zu finden ist. Bei der Funktion handelt es sich um nichts anderes,

als um eine LiveView-Anzeige, die auch in diversen Kameras zu finden ist. Hier

wird das Bild der Kamera – ein unterstütztes Modell vorausgesetzt - direkt auf dem

Bildschirm dargestellt. Doch nicht nur eine Anzeige des Bildes ist möglich. Auch

eine Steuerung der wichtigsten Optionen erlaubt die Ansicht. So lassen sich hier

beispielsweise der ISO-Wert oder der Weißabgleich korrigieren. Daneben gibt das

Tool dem Anwender auch die Möglichkeit, Bilder direkt aufzunehmen, die sofort

mit Tags versehen werden können.

Der zoombare Leuchttisch ermöglicht schnelle Anpassungen an Bildern.

Die dauerhafte Ausgabe der Bearbeitungsschritte erfolgt in Darktable über eine

im Leuchttisch-Bereich erreichbare Exportfunktion. Neben der Speicherung der

Resultate auf der Festplatte erlaubt die Funktion auch einen Export in Form

einer Galerie, den Versand per E-Mail oder die Übermittlung der Resulate an einen

Webdienstleister. Eine Funktion zum Drucken der Bilder oder eine Präsentation in

Form einer Diashow sind nicht vorhanden.

Fazit: Trotz des relativ geringen Alters bietet Darktable eine beachtliche Anzahl

an Tools, die fast alle Anwender zufriedenstellen sollten. Bei unserem Test fiel

uns kaum ein Workflow-Schritt auf, der nicht mit den zahlreichen Werkzeugen

erledigt werden konnte. Die Stapelbearbeitung ist durchdacht und erleichtert die

Arbeit ungemein. Auch die oftmals angesprochene Abweichung in der Bedienung kann

überzeugen und stört nach einer kurzen Einarbeitung nicht. Defizite zeigt die

Applikation dagegen in der Geschwindigkeit und der Qualität der Werkzeuge, die

nicht immer die gewünschten Resultate liefern und teilweise auch nicht korrekt

funktionieren. Auch das Fehlen einer Druckoption fällt negativ auf.

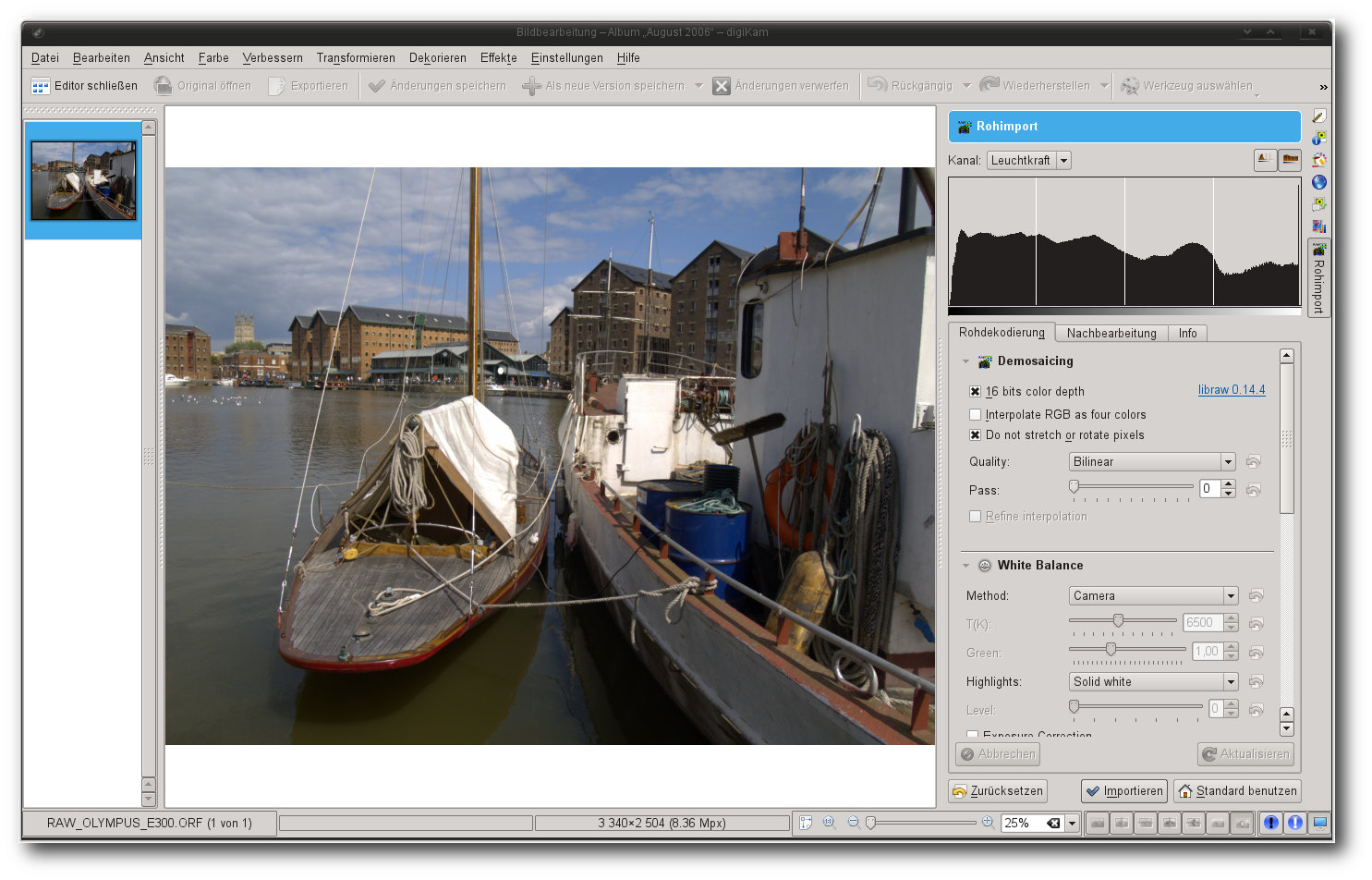

Digikam

Digikam [10] ist einer der beliebtesten Bildverwalter

für KDE unter Linux, aber auch für Windows.

Seit digiKam 1.0, so die

Eigenschreibweise, kurz vor Weihnachten 2009 freigegeben wurde, wird die

Applikation in einem Tempo entwickelt, das zweifelsohne zum Staunen verleitet.

Dementsprechend fällt auch der Funktionsumfang aus. Abgesehen von

fortgeschrittenen Bildeditierfunktionen findet sich mittlerweile kaum noch eine

Nische, die Digikam nicht ausfüllen kann. So auch die Entwicklung von

RAW-Bildern.

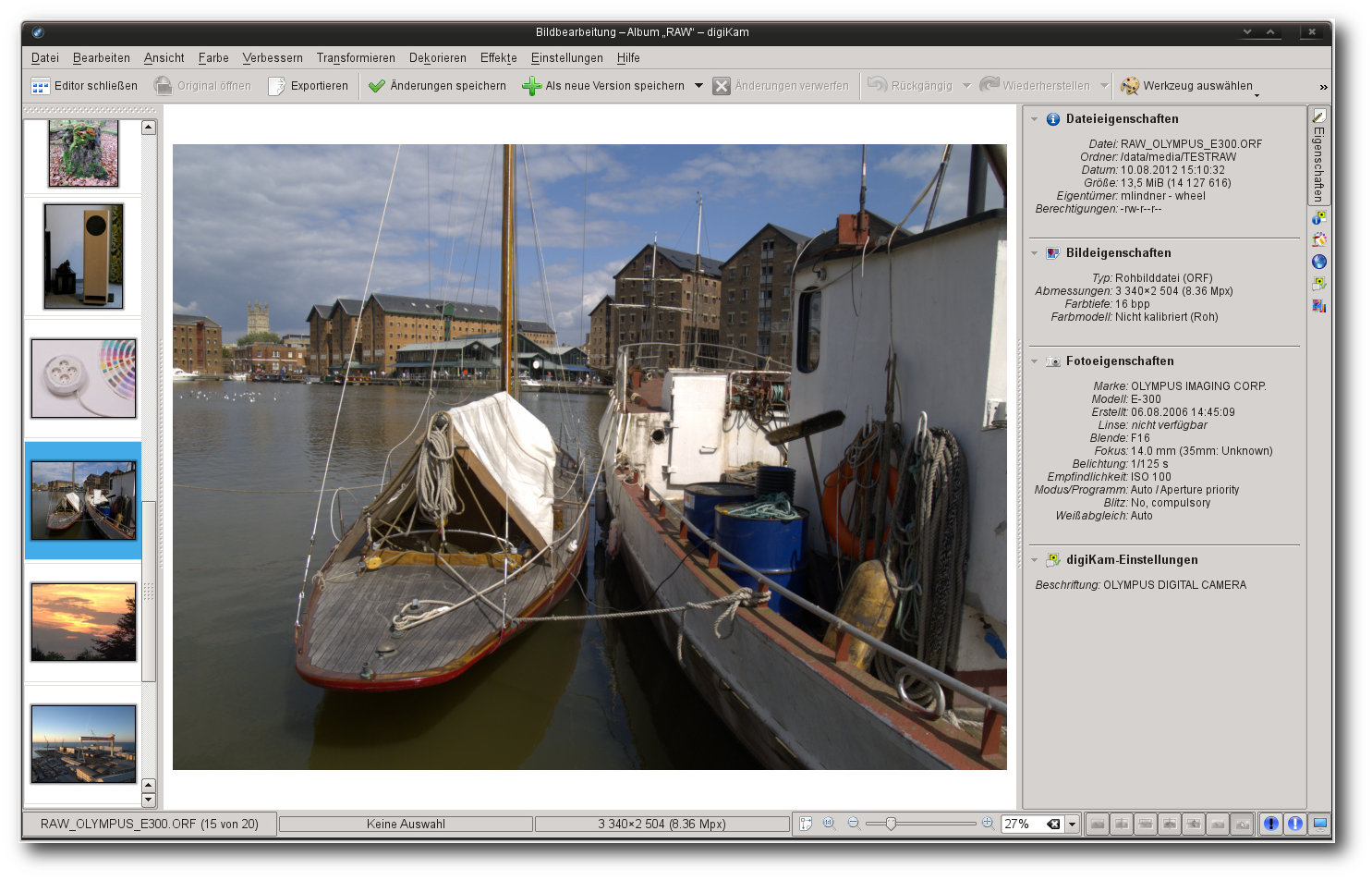

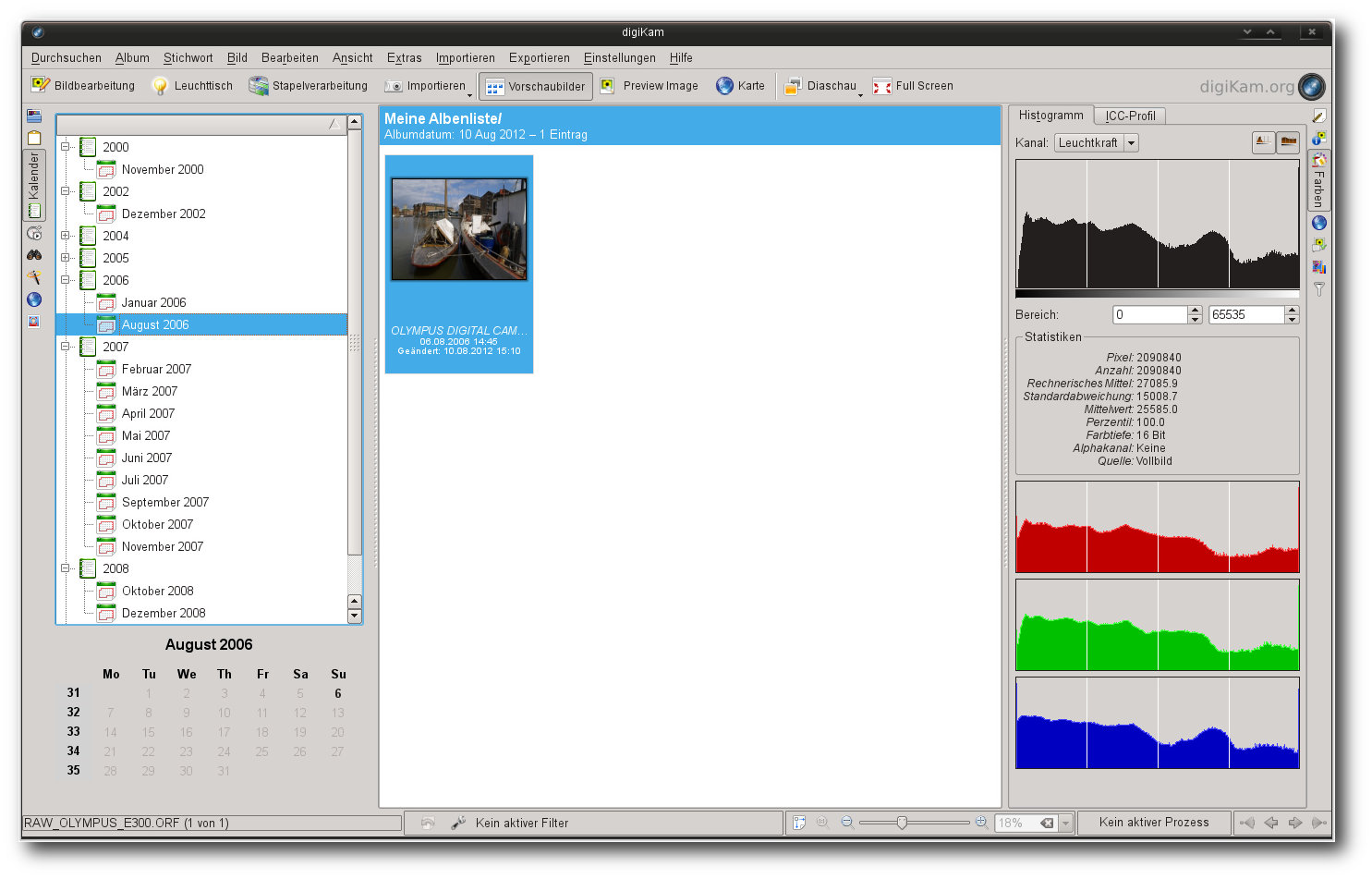

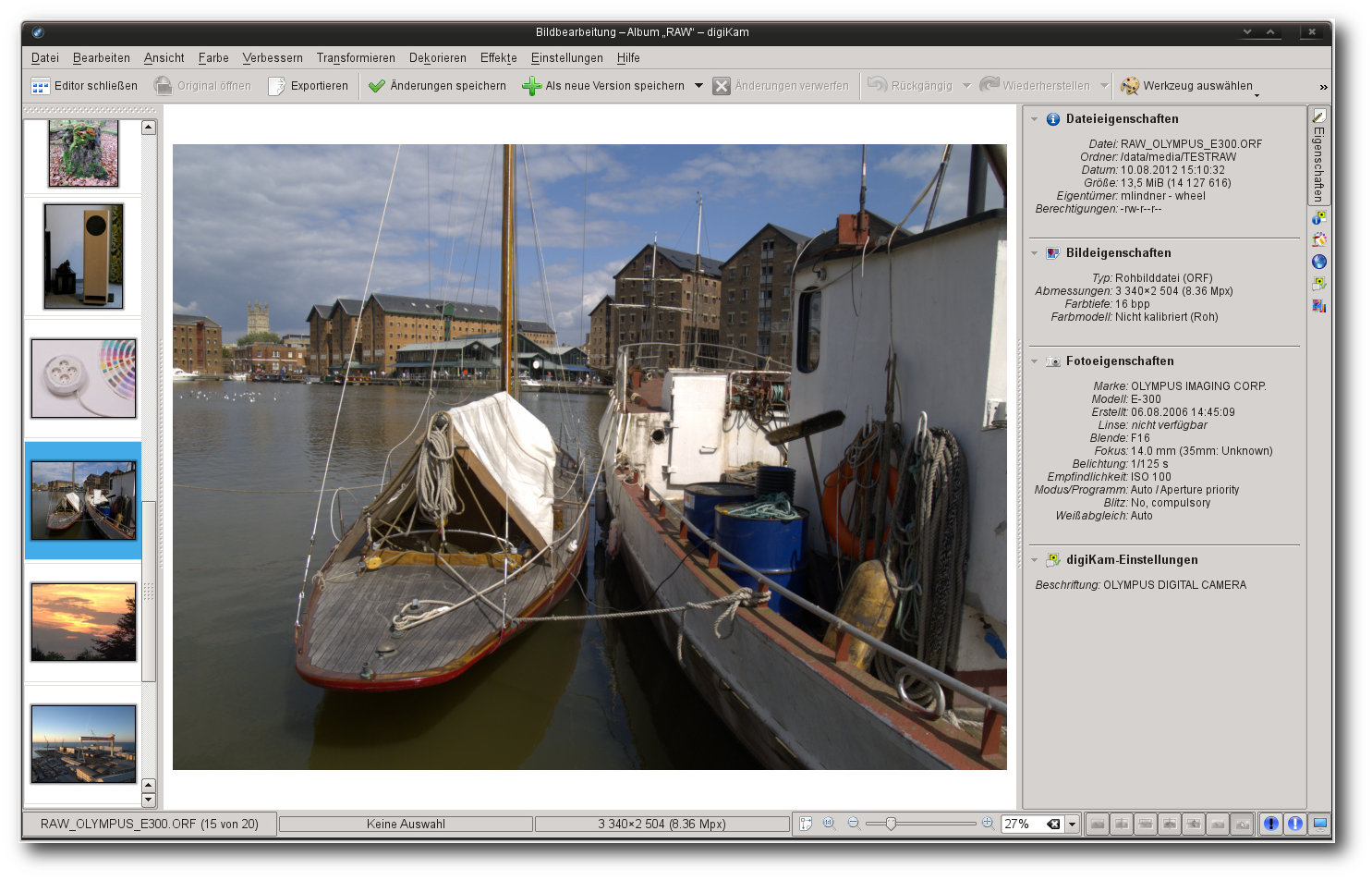

Digikam.

Verantwortlich für den enormen Funktionsumfang zeigt sich unter anderem KIPI.

Das im Rahmen von Digikam entwickelte „KDE Image Plugins Interface“ (KIPI)

stellt eine Schnittstelle dar, die Fremdanwendungen zahlreiche Funktionen zur

Bearbeitung von Bildern zur Verfügung stellt. Die Lösung wird unter anderem von

Digikam,

KPhotoAlbum [11] und Gwenview [12] verwendet und stellt einen integralen

Teil der Funktionalität der Applikationen dar. Unter anderem bietet sie auch die

Möglichkeit, mittels diverser Im- und Export-Modi Bilder weiter zu verarbeiten

und zu katalogisieren. Auch der RAW-Import wurde als KIPI-Modul realisiert.

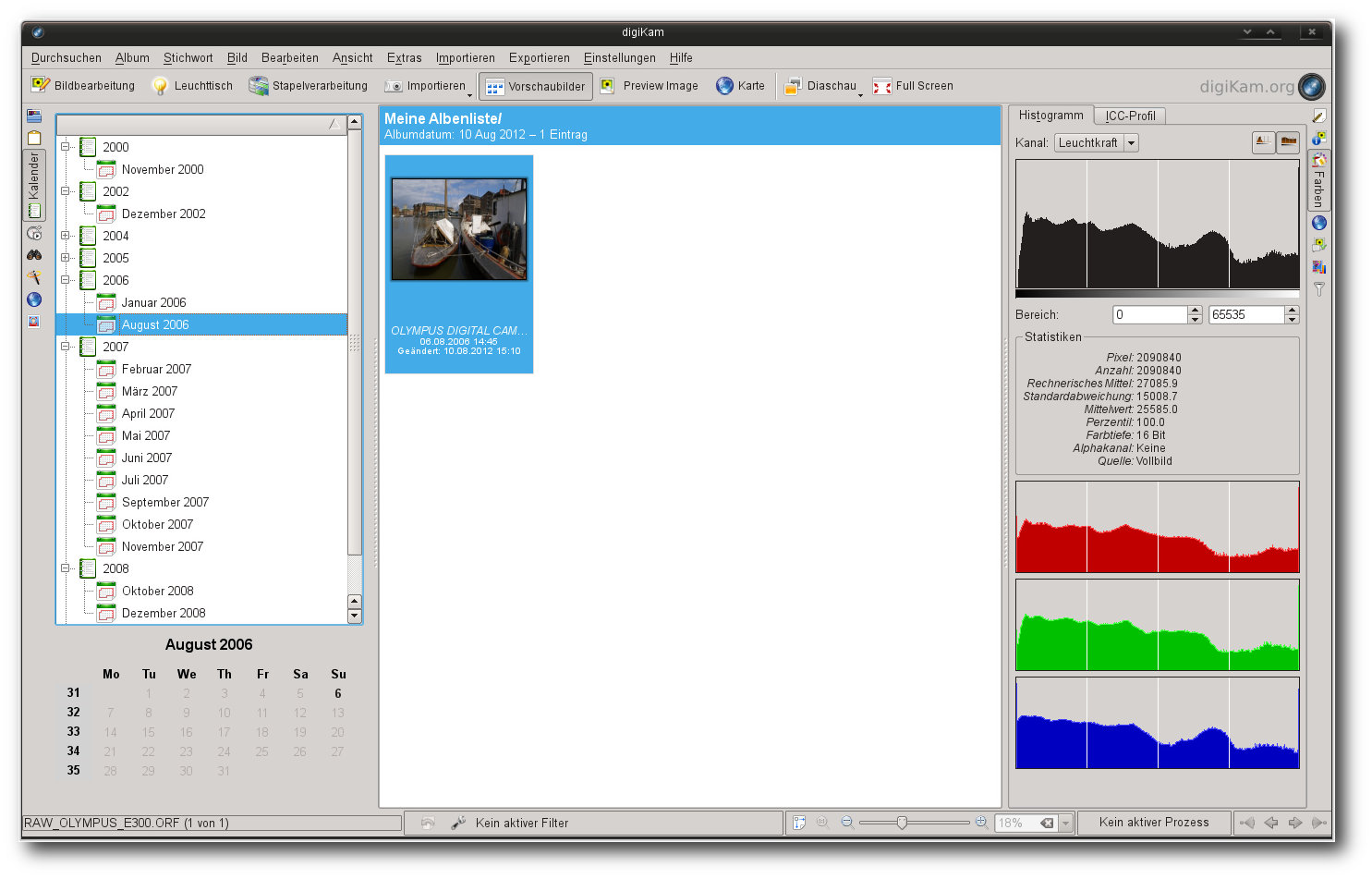

Digikam setzt sich aus verschiedenen Bereichen zusammen,

die

jeweils in neuen

Fenstern geöffnet werden. Der erste Bereich, den der Anwender sieht, stellt die

Album-Ansicht dar. Die Komponente dient als die zentrale Anlaufstelle der

Anwendung und bietet Zugriff auf die anderen Bereiche. Zudem können hier als

Alben eingebundene Bilder bewertet, verschlagwortet oder aber einfach nur

durchsucht werden. Der unmittelbare Zugriff auf beliebige Datenträger und

Verzeichnisse ist allerdings nicht möglich. So müssen alle Bilder, die in

Digikam bearbeitet werden sollen, zuvor einem Album zugewiesen werden.

Schlagwörter, Bildunterschriften oder allgemeine Informationen weist die

Applikation sowohl einzelnen, oder aber auch mehreren Bildern zu. Ferner verfügt

Digikam über eine Stapelverarbeitung, die allerdings im Vergleich zu anderen

Anwendungen etwas gewöhnungsbedürftig ausfällt. So müssen bei der Erstellung

eines Workflows alle benötigten Tools in einem speziellen Editor platziert und

angepasst werden. Einen weiteren Nachteil der Stapelverarbeitung stellt die

Tatsache dar, dass die meisten Funktionen „blind“ durchgeführt werden müssen und

nicht alle Funktionen von Digikam auch in der automatischen Verarbeitung genutzt

werden können. So war es beispielsweise nicht möglich, RAW-Bilder automatisch

anzupassen. Für diesen Zweck bietet die Anwendung eine spezielle

Rohbild-Stapelkonvertierung an, die vor der eigentlichen Stapelverarbeitung

ausgeführt werden muss. Versucht man dagegen direkt RAW-Bilder in der regulären

Stapelverarbeitung zu bearbeiten, meldet die Anwendung bei der Abarbeitung der

Funktionen einen unbekannten Fehler.

Die Galerieansicht geht weit über die Möglichkeiten auch fortgeschrittener Tools hinaus. Hier spielt Digikam seine Stärke als Bildverwalter klar aus.

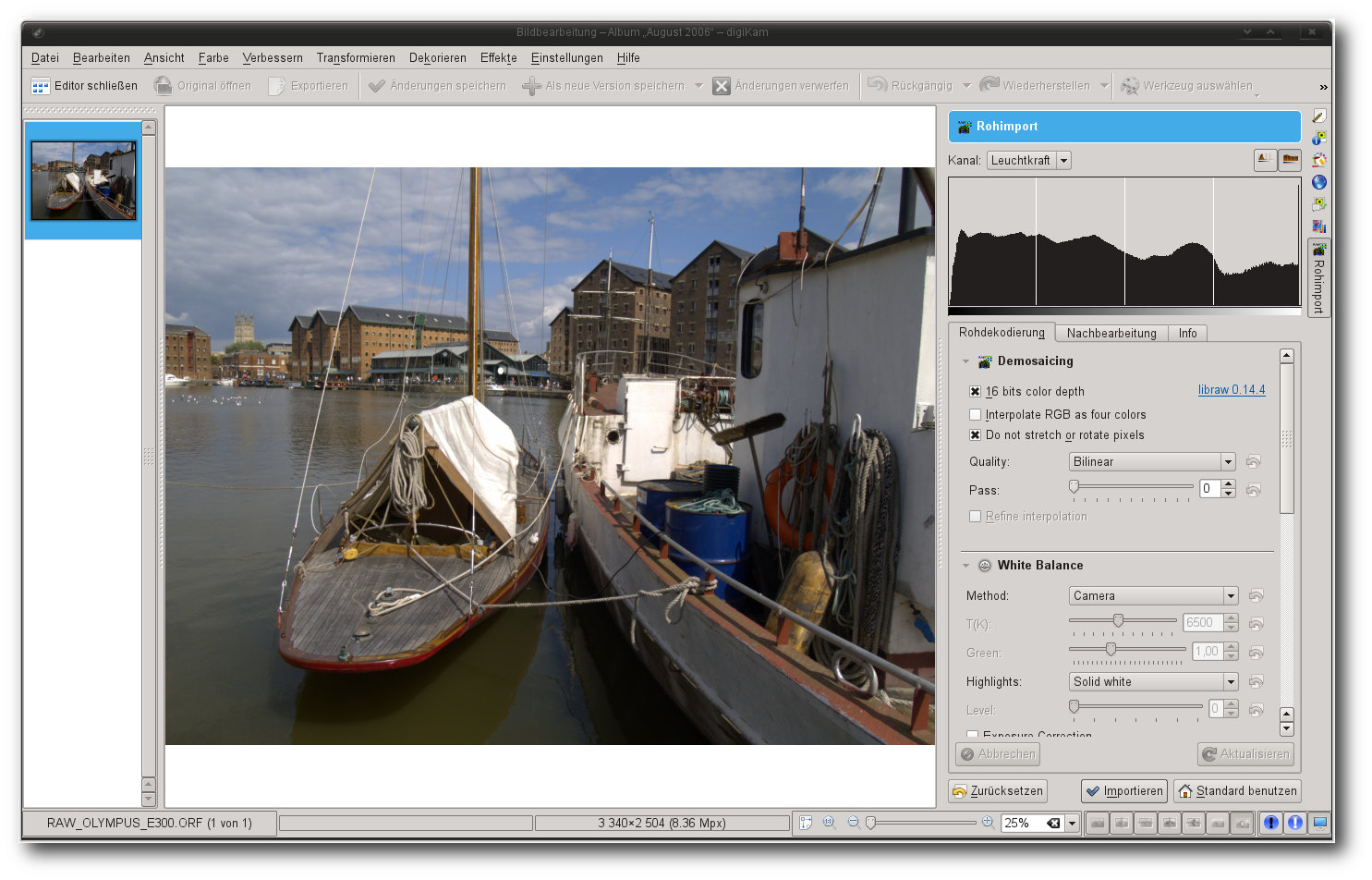

Die eigentliche Bearbeitung der Bilder findet in der Editor-Komponente statt,

die entweder durch den Klick auf „Bildbearbeitung“ oder durch das Drücken der

Taste F4 erreicht werden kann. Öffnet man dabei ein RAW-Bild, konvertiert

Digikam die Quelle automatisch in ein 8-Bit-Bild. Abhilfe bringt hier die

Änderung des Standardverhaltens unter „Rohdekodierung“ und die Festlegung des

Dekodierverhaltens. Zur schnelleren Navigation kann der Anwender eine

Miniaturliste aller im aktuellen Albenverzeichnis enthaltenen Bilder anzeigen.

Hier stört es allerdings, dass ein Wechsel zwischen den Bildern nicht ohne das

vorherige Speichern möglich ist. Des Weiteren speichert Digikam die Bilder

entweder in einer vereinfachten Form nicht-destruktiv, wobei die Anwendung für

jedes Bild eine Kopie anlegt, oder

überschreibt das Original. So abgespeicherte

Bilder lassen zwar Rückschlüsse auf die durchgeführten Schritte ziehen, eine

Wiederherstellung der Informationen oder gar der Einzelschritte ist aber nicht

möglich.

RAW-Bilder kann die Anwendung entweder automatisch oder kontrolliert über eine separate Option laden.

Die Korrekturwerkzeuge der Anwendung sind solide und bieten alle Funktionen an,

die man für einen RAW-Workflow benötigt. Nach jedem Schritt blendet die

Applikation eine Vorschau der Änderung an. Die Art der Darstellung kann bei den

meisten Tools individuell festgelegt werden. Die Geschwindigkeit und die

Resultate der Werkzeuge sind akzeptabel und bieten nur wenige Punkte zur Kritik.

Alle typischen Punkte eines RAW-Workflows konnten mühelos und ohne größere

Anstrengung durchgeführt werden. Zusätzlich bietet Digikam noch eine Fülle von

Spezialwerkzeugen an, die das Leben des Fotografen extrem erleichtern können.

So erkennt die Applikation beispielsweise Gesichter auf den Bildern, ist in der

Lage, aus verschiedenen

Bildserien HDR-Bilder zu generieren, stellt Geotags dar

oder lässt sie grafisch verändern und ermöglicht es, verschiedene Bilder zu

einem einzelnen Panoramabild zusammenzufügen. Keine andere Anwendung unter Linux

hat so viele universelle Funktionen unter einer Oberfläche vereint.

Anfängern greift die Anwendung dank zahlreicher Tools (hier eine automatische Korrektur) unter die Arme.

Eine weitere Stärke von Digikam stellt die Ausgabe dar. Neben der Möglichkeit

der Speicherung auf der Festplatte in verschiedenen Formaten eröffnet die

Anwendung zahlreiche Export-Möglichkeiten. Unter anderem erlaubt das Programm

automatisierte Veröffentlichungen bei zahlreichen Online-Diensten, darunter

Flickr oder Facebook. Auch ein Abgleich mit mobilen Geräten ist möglich. Für

eine Druckausgabe bietet das Tool mannigfaltige Layout-Vorgaben. Zudem

ermöglicht die Anwendung einen Export der Daten in eine grafisch ansprechende

HTML-Galerie.

Fazit: Digikam ist mit Abstand die funktionsreichste Anwendung unter allen hier

vorgestellten Tools. Funktionen wie HDR, Geotagging, Panorama, eine

Gesichtserkennung, ausgefeilte Taggingfunktionen oder aber eine ausgereifte

Bildverwaltung sind nur die herausragendsten Eigenschaften der Anwendung. Der

eigentliche RAW-Workflow ist dagegen nicht wirklich auf dem Stand der Technik.

Zwar bietet das Programm alle Funktionen an, die für eine Bearbeitung von

RAW-Bildern notwendig sind, doch vor allem bei einer großen Zahl an Material

stößt die Handhabung wegen der etwas ungewöhnlichen Stapelverarbeitung schnell

an ihre Grenzen.

Stärken zeigt das Programm dagegen beim Export und beim

Drucken.

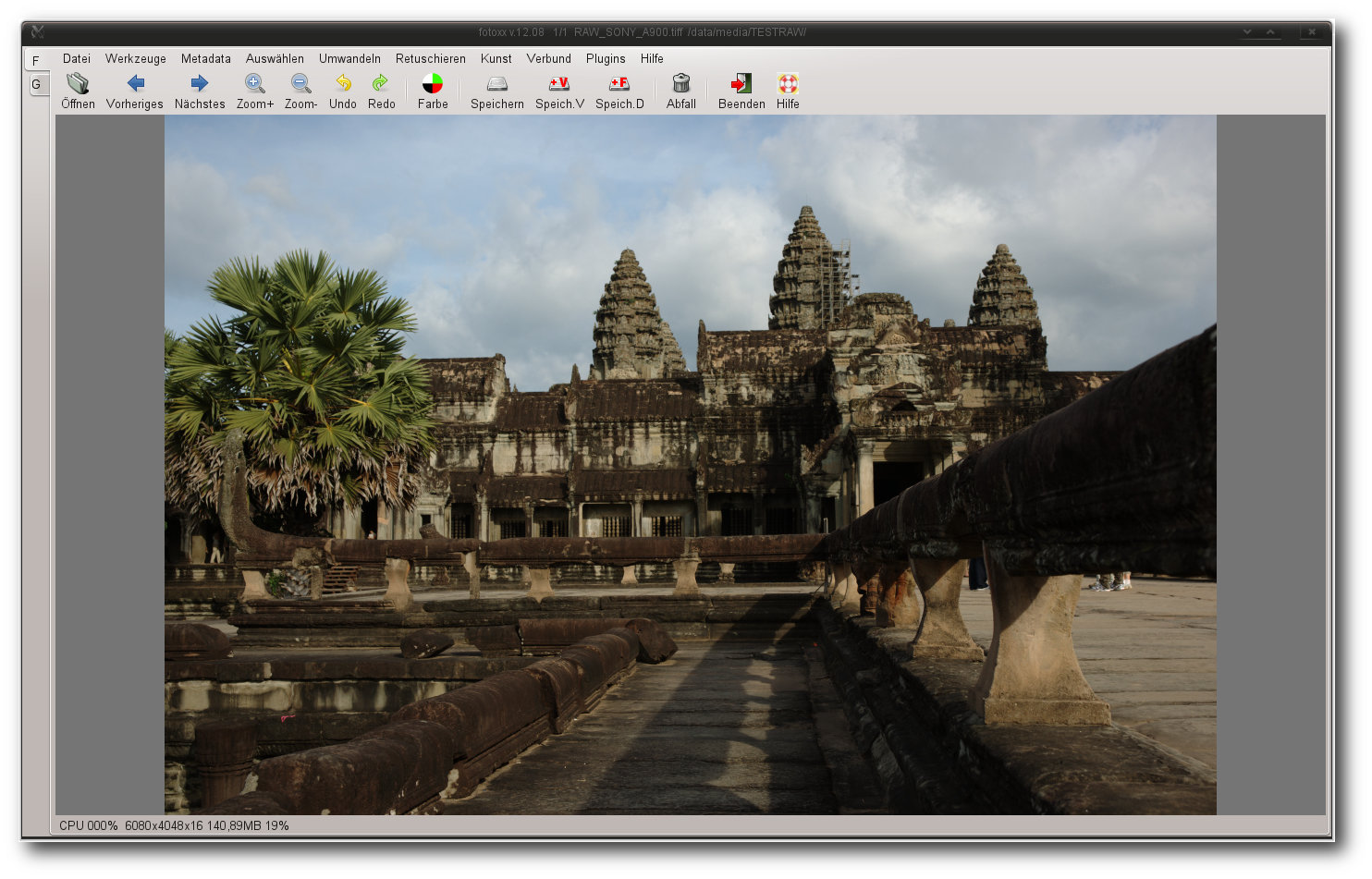

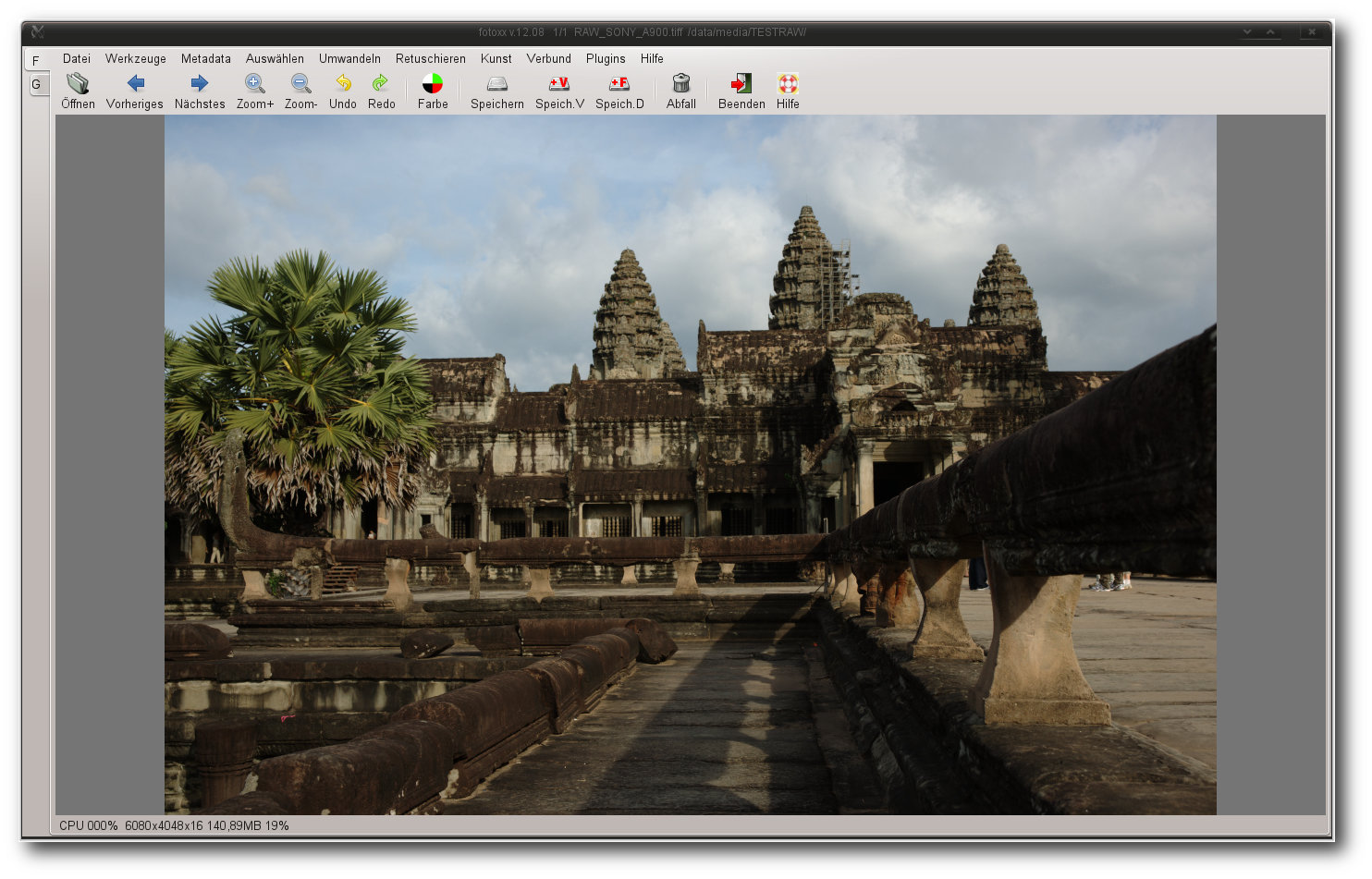

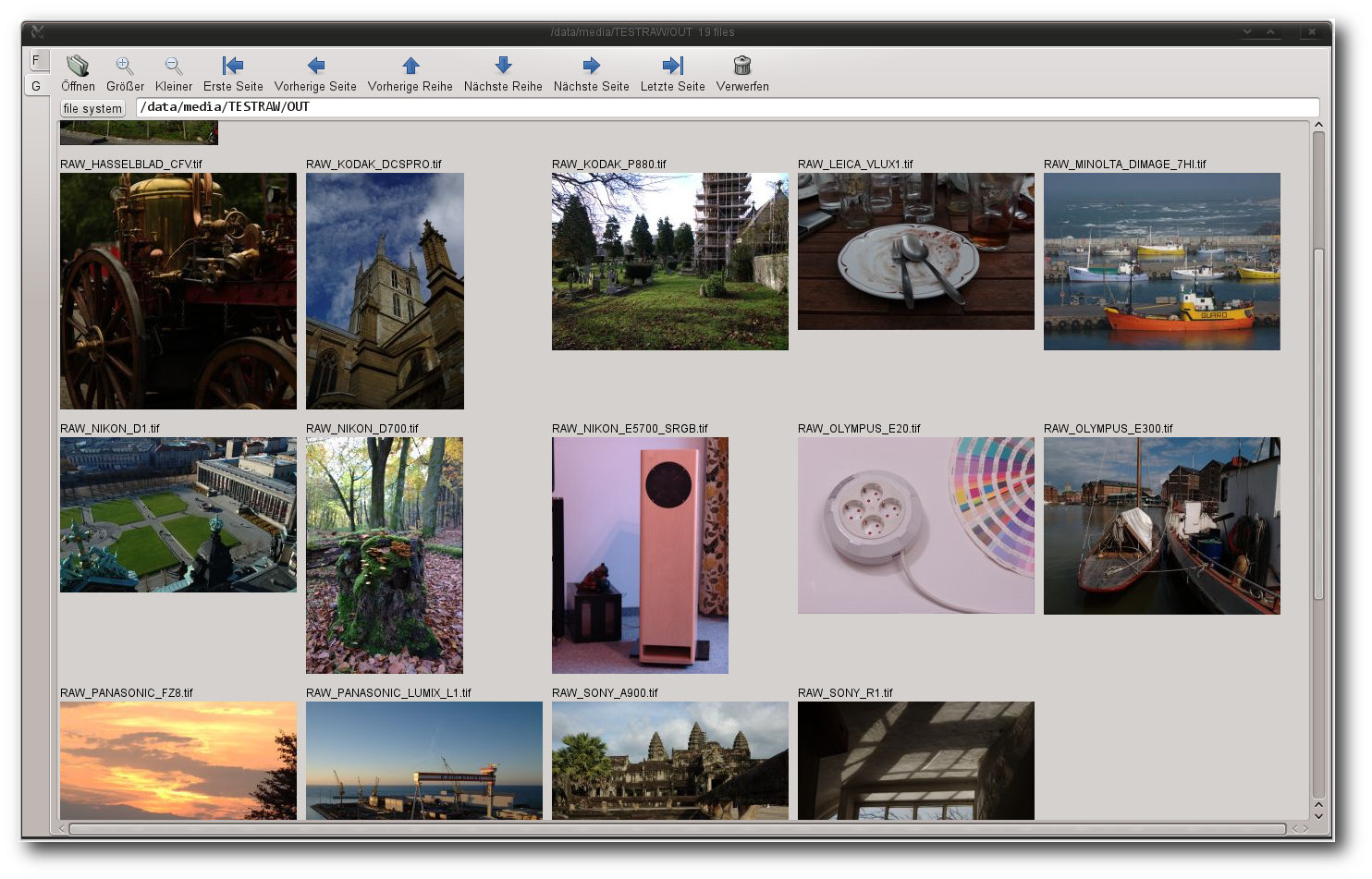

Fotoxx

Wie die Mehrzahl der hier vorgestellten Applikationen ist auch Fotoxx [13] eine Software zur Bildverwaltung und

Bildverarbeitung. Der Schwerpunkt der Anwendung liegt laut Aussage des

Entwicklers auf einer einfachen und schnellen Bedienung. Vor allem Einsteiger

sollen mit Fotoxx ein

Tool erhalten, das sie nicht überfordert und alle für

einen Bildbearbeitungsprozess benötigten Funktionen mit sich bringt.

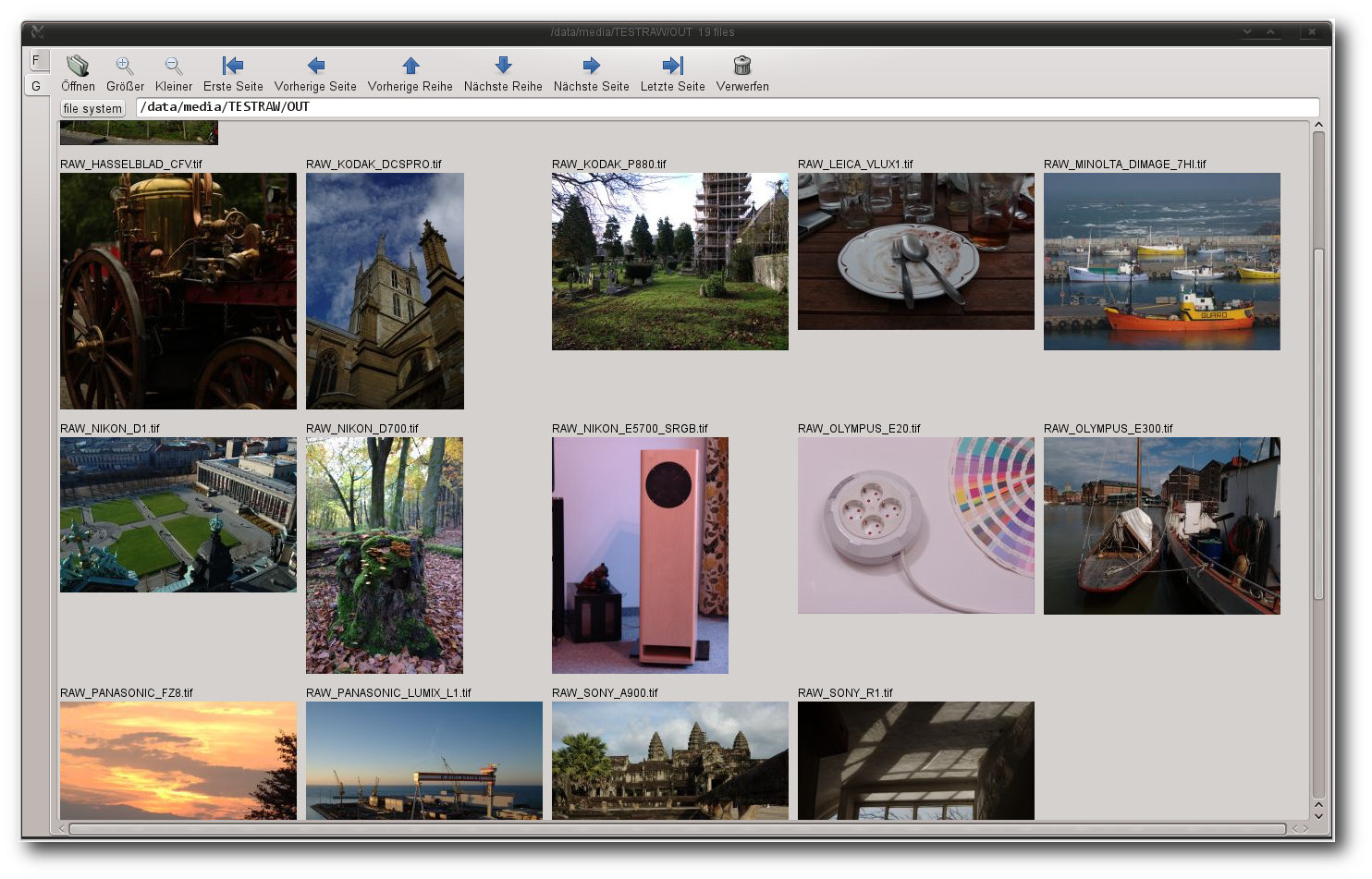

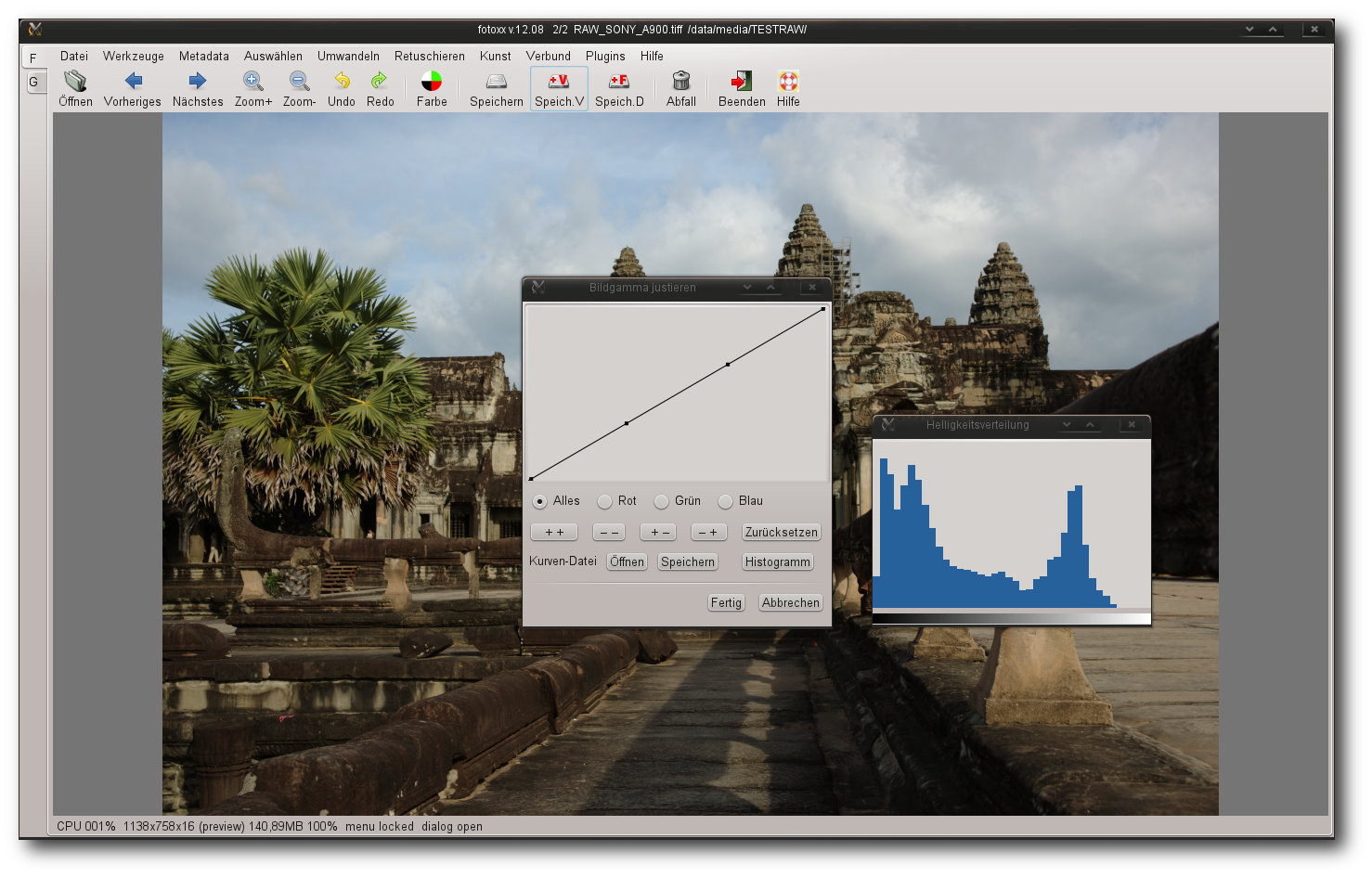

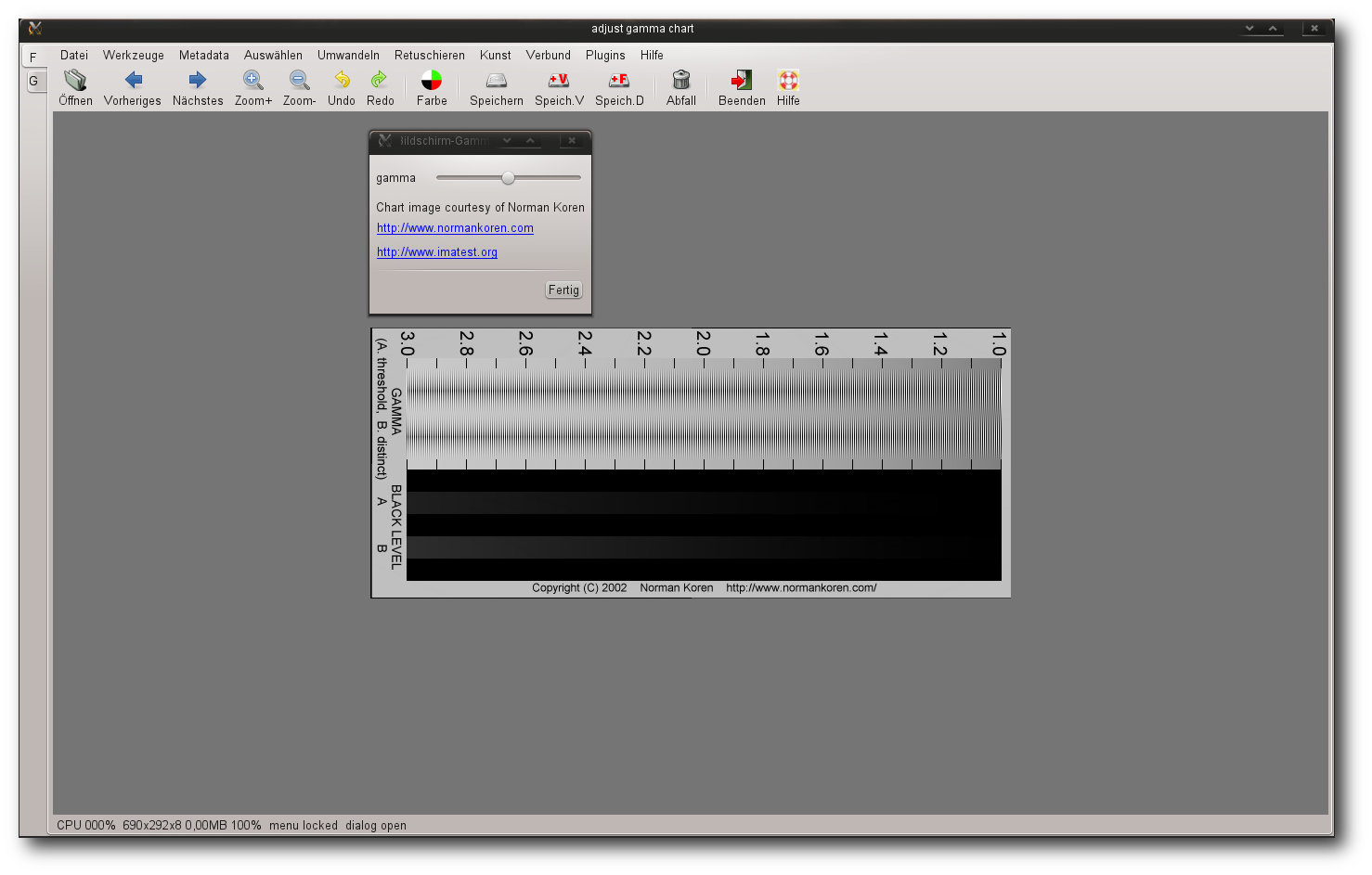

Fotoxx.

Die Oberfläche der Anwendung ist in zwei separate Bereiche gegliedert, die sich

jeweils hinter den Reitern „F“ und „G“ auf der linken Seite des Hauptfensters

befinden. Während unter „F“ alle Bearbeitungsschritte durchgeführt werden,

blendet der Bereich „G“ einen Galeriemodus ein, in dem durch die im Dateisystem

oder durch die

in der Datenbank gespeicherten Bilder navigiert werden kann. Ein

Nachteil der Galeriedarstellung ist allerdings, dass sie nicht dediziert

aufgerufen werden, sondern nur aus dem Bearbeitungsmodus gestartet werden kann.

Auch die Navigation durch die Verzeichnisstruktur ist gewöhnungsbedürftig.

Erschwerend kommt noch hinzu, dass der Vorschaubrowser nur Bildertypen anzeigt,

die ihm bekannt sind. RAW oder DNG gehören nicht dazu. Ein Umschalten zwischen

den

zwei verschiedenen Darstellungsmodi ist jederzeit möglich, wobei allerdings

alle Änderungen zuvor gespeichert werden müssen.

Fotoxx unterscheidet sich fundamental von den typischen Applikationen des

Genres. Vieles ist in der Anwendung zunächst gewöhnungsbedürftig. So müssen

fast alle Tools im Bearbeitungsmodus direkt aus dem teilweise unübersichtlichen

Menü gestartet werden. Eine Funktion für Favoriten gibt es nicht. Genauso wenig

gibt es eine Funktion für

Stapelverarbeitung, sodass alle Bearbeitungsschritte

manuell für jedes Bild einzeln durchgeführt werden müssen. Ungewohnt ist auch

die Anordnung mancher Menüs. So finden sich beispielsweise die

Benutzereinstellung unter dem Menüpunkt „Werkzeuge“. Vor allem beim ersten Start

ist eine längere Suche nach den Tools unvermeidlich. Hat sich der Anwender

allerdings mit der Anwendung eine Weile beschäftigt, findet er sich doch recht

zügig zurecht.

Das Laden von RAW-Bildern erledigt Fotoxx durch den Aufruf einer auf ufraw-batch

aufbauenden Importfunktion. Eine Übergabe von Parametern ist nicht vorgesehen.

Hier muss der Anwender dem Automatismus der Anwendung vertrauen. Dedizierte

Korrekturen eines Bildes erledigt Fotoxx im Bearbeitungsbereich, der zahlreiche

Tools aufweist, die die meisten Bearbeitungsschritte eines RAW-Workflows

abdecken. So lassen sich in der Anwendung nicht nur zahlreiche

Tonwertkorrekturen erledigen, sondern auch die Perspektive ändern. Auch das

Zusammensetzen von HDR oder Panoramabildern beherrscht das Programm. Viele

Werkzeuge können zudem parallel aufgerufen und benutzt werden, was vor allem auf

Dual-Monitoren sehr angenehm ist. Unter anderem lassen sich so fast die

kompletten Farbanpassungen durchführen. Eine Vorher/Nachher-Ansicht gibt es

nicht, doch das Programm erledigt die Transformation derartig schnell, dass man

durchgeführte Änderungen fast sofort sieht.

Die Galerieansicht zeigt nur bekannte Formate an – RAW-Dateien gehören nicht dazu.

Gefundene Bilder können auch unter Fotoxx mit Tags versehen, bewertet oder nach

anderen Kriterien katalogisiert werden. Die Suche erweist sich allerdings als

unlogisch. So werden beispielsweise die Resultate im Galeriebereich dargestellt,

die eigentliche Suche muss aber im Bearbeitungsbereich gestartet werden.

Einsortierte

Bilder können nach Tags, Datum oder selbst definierten Kriterien

gesucht werden. Auch eine Suche nach Geo-Informationen, samt einer grafischen

Anzeige des Ortes, erlaubt die Anwendung.

Werkzeuge werden in der Anwendung stets in neuen Fenstern geöffnet und können simultan benutzt werden.

Bearbeitete Bilder schreibt Fotoxx entweder in dieselbe oder eine neue

Versionsdatei. Unterstützt werden neben TIFF (8/16) ebenso PNG (8), ICO, BMP und

JPEG. Zudem erlaubt die Anwendung eine Ausgabe der Resultate auf einem Drucker,

wobei hier sowohl Vorlagen als auch weitreichende Konfigurationsmöglichkeiten

fehlen.

Fotoxx bietet auch zahlreiche Tools an, die primär nichts mit der Entwicklung von RAW-Dateien zu tun haben.

Fazit: Die Intention des Programmierers, eine einfache und schnelle Anwendung

zu erstellen, sieht man Fotoxx sofort an. Setzt man eine gewisse

Einarbeitungszeit voraus, gestaltet sich die

Arbeit mit der Anwendung durchaus

flott, auch wenn viele Menüpunkte unlogisch und verwirrend erscheinen. Die

Werkzeuge sind schnell und bieten zahlreiche Möglichkeiten für Optimierungen und

ein ausreichendes Feintuning an. Bei vielen fortgeschrittenen Funktionen muss

Fotoxx allerdings passen. So lassen sich in der Anwendung weder ausreichende

Objektivanpassungen noch ein automatisierter Ablauf mittels einer

Stapelverarbeitung durchführen. Auch die Galerie und die Dateisystemansicht

überzeugen nicht. Weitere Defizite weist Fotoxx bei der Ausgabe des

Bildmaterials auf.

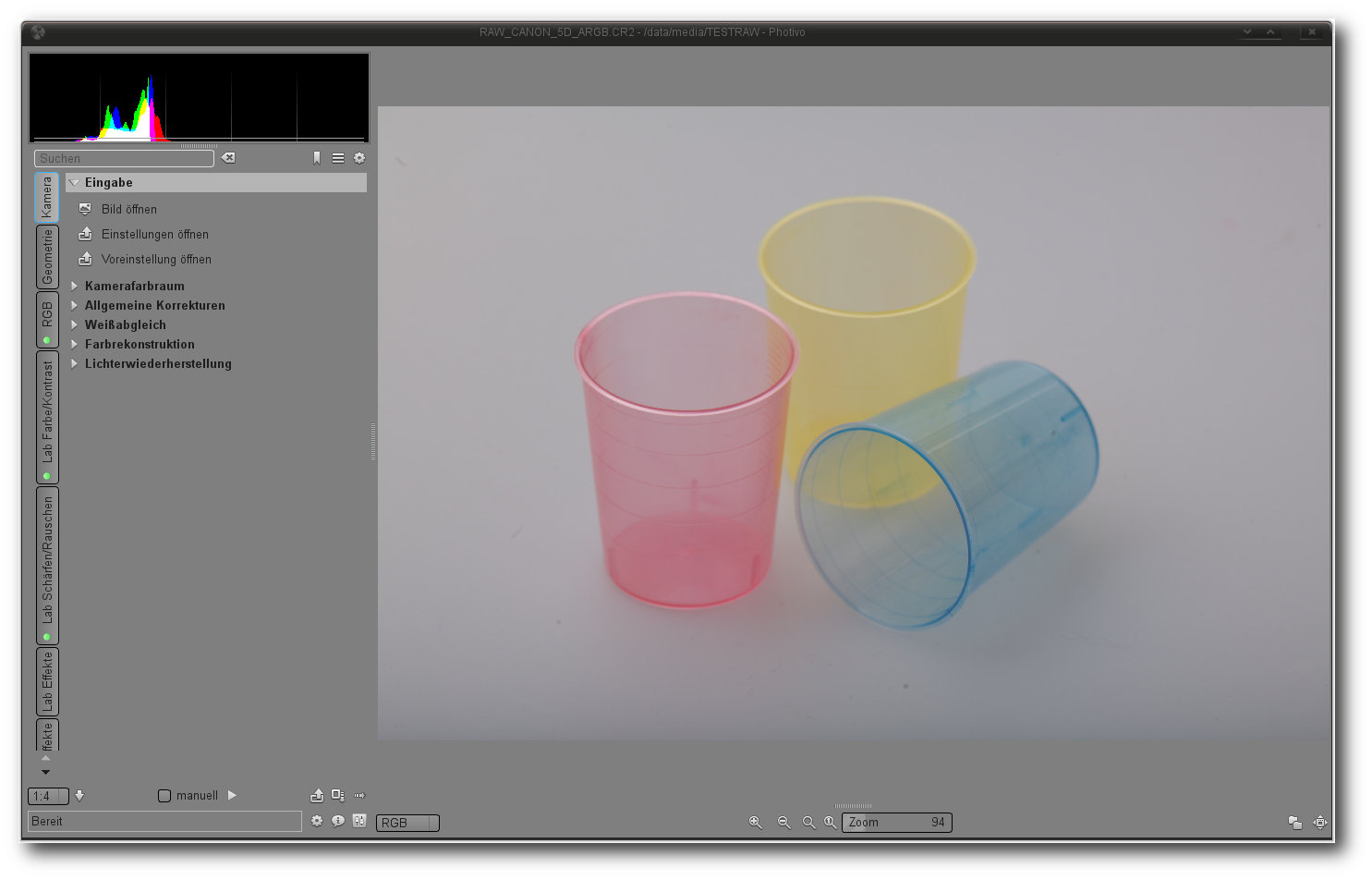

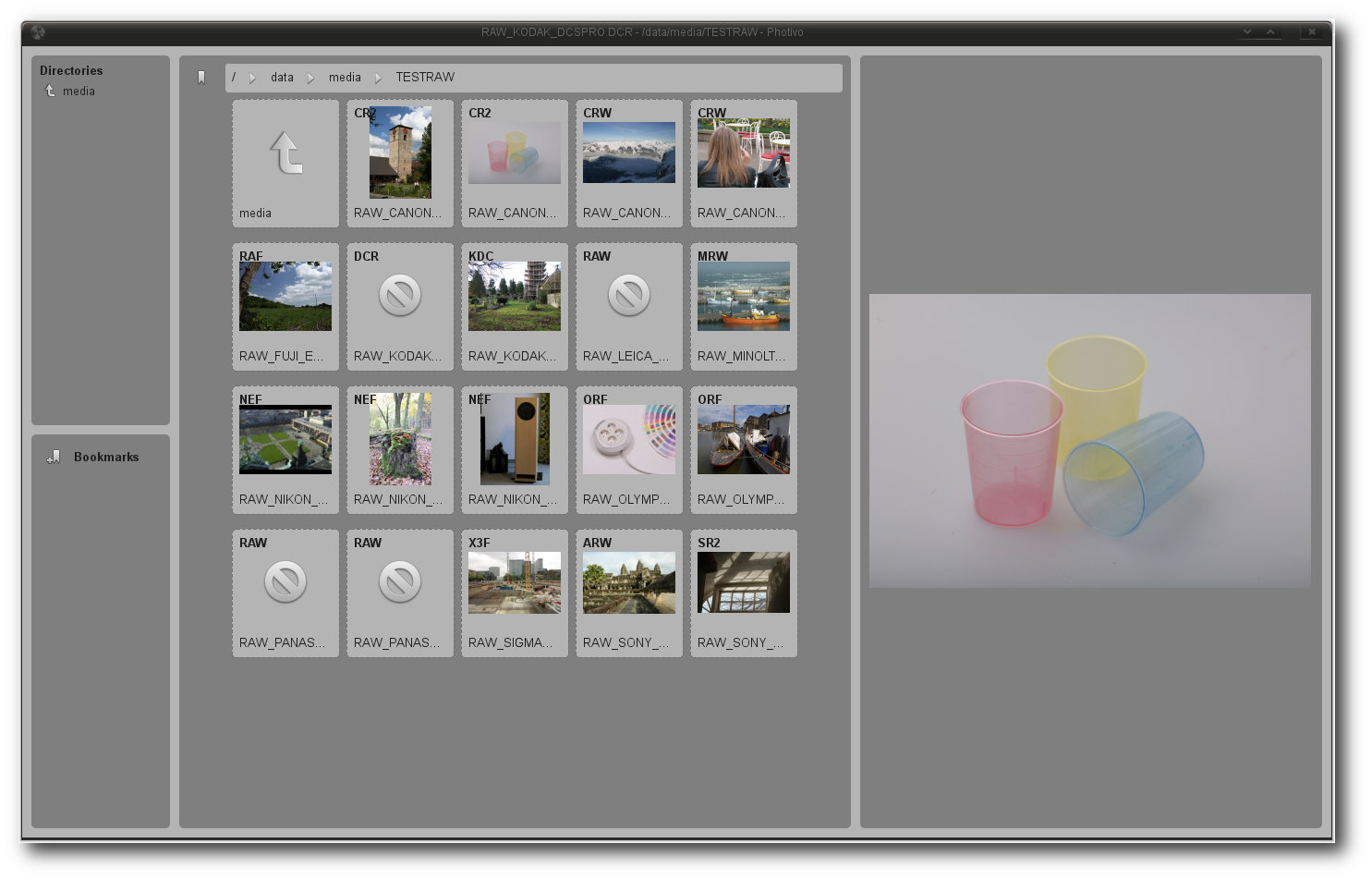

Photivo

Auch Photivo [14] stellt ein relativ junges Projekt dar,

das sich primär der Entwicklung von RAW-Bildern verschrieben hat. Das Programm

bietet einen umfassenden Workflow, beschränkt sich allerdings weitgehend auf die

Bearbeitung von Bildern. Ausgeklügelte Importfunktionen gibt es in der Anwendung

genauso wenig wie eine Bildverwaltung. Zur Verwaltung größerer Bildbestände

eignet sich das Programm deshalb nur bedingt. Eine Datenbank, die Schlagwörter

speichert oder katalogisiert, weist das Programm genauso wenig auf wie eine

Suche.

Bearbeitungsfunktionen für Metadaten sind nicht vorhanden. Dasselbe gilt

auch für Geotagging.

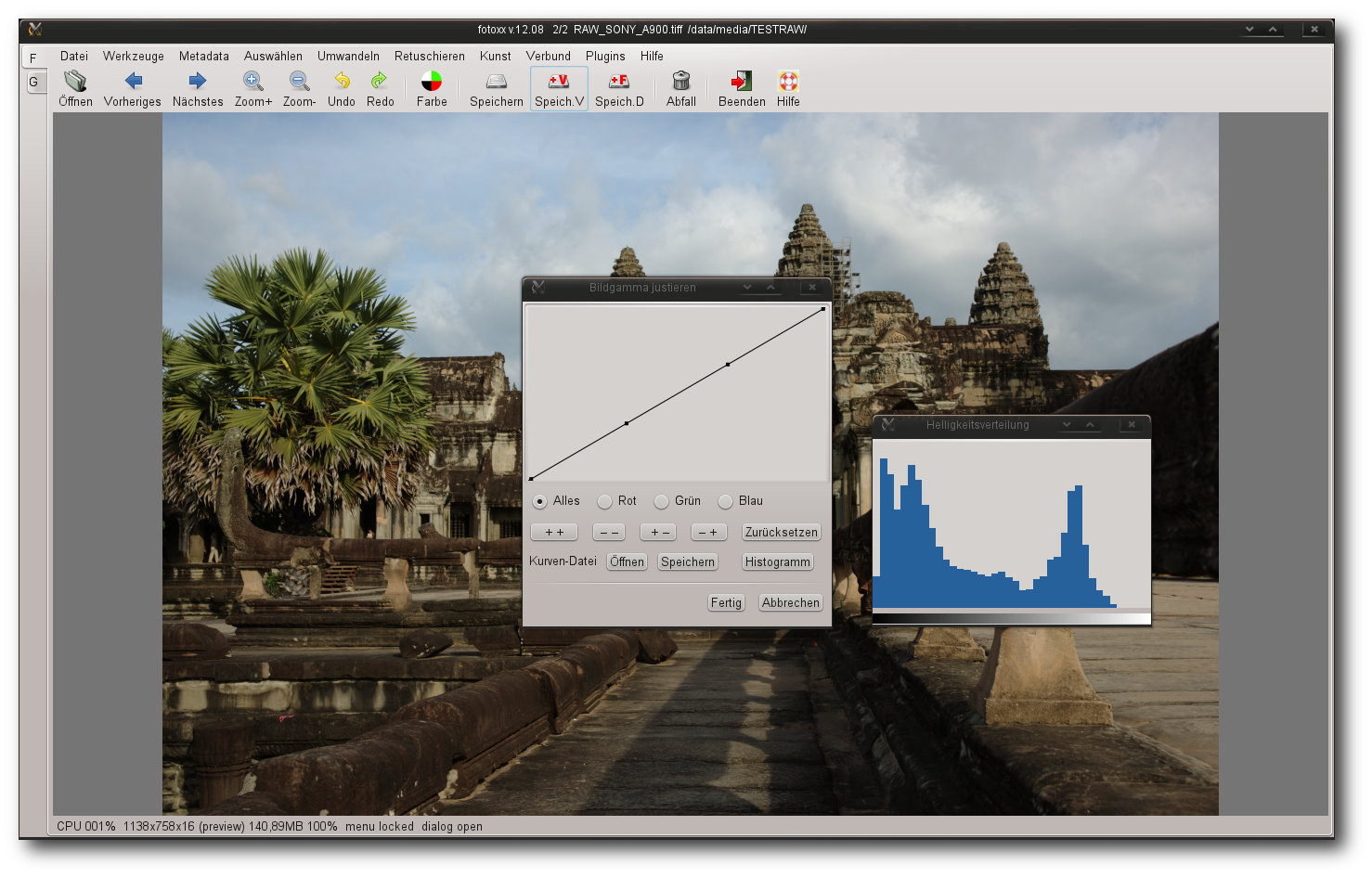

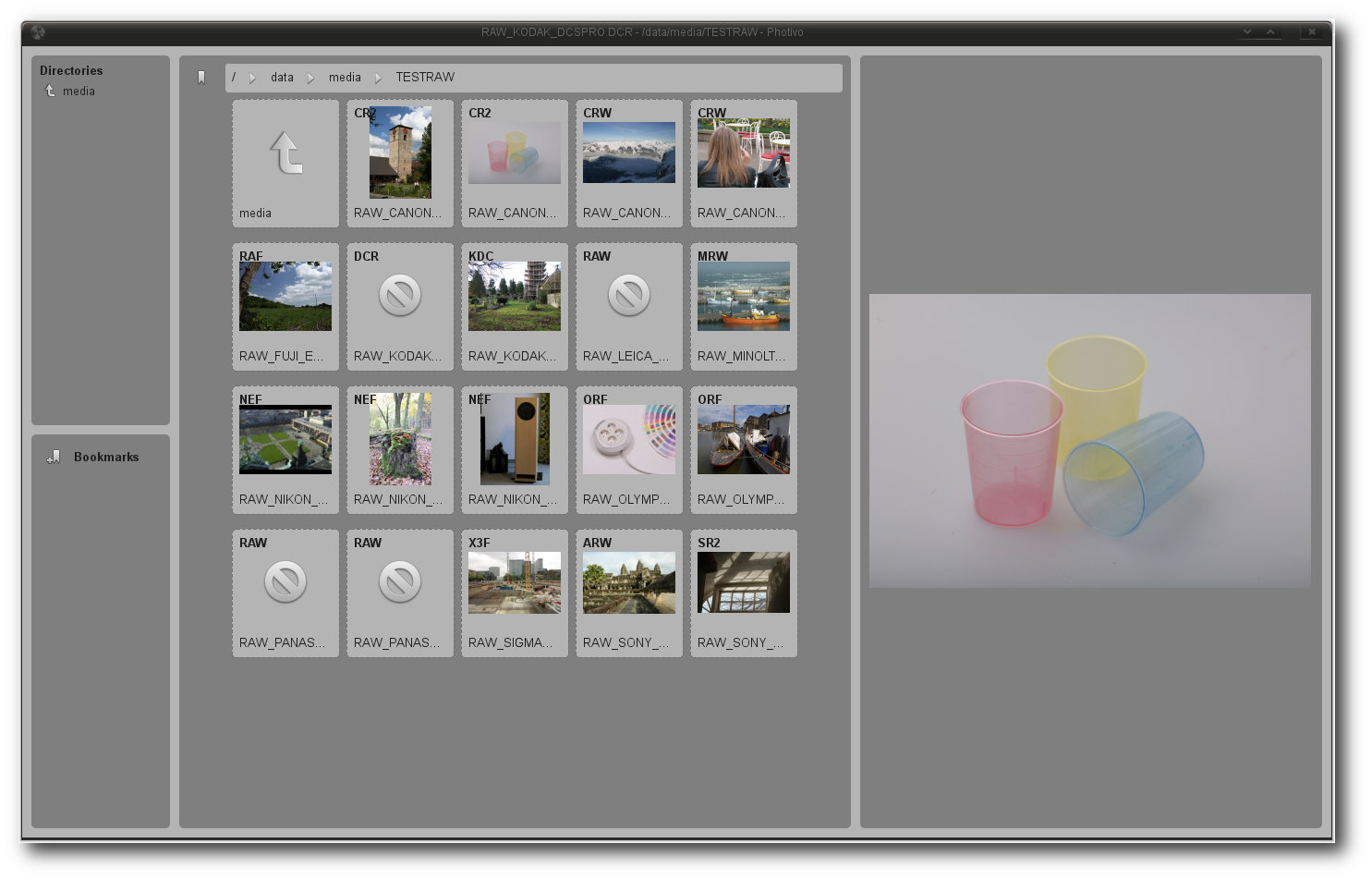

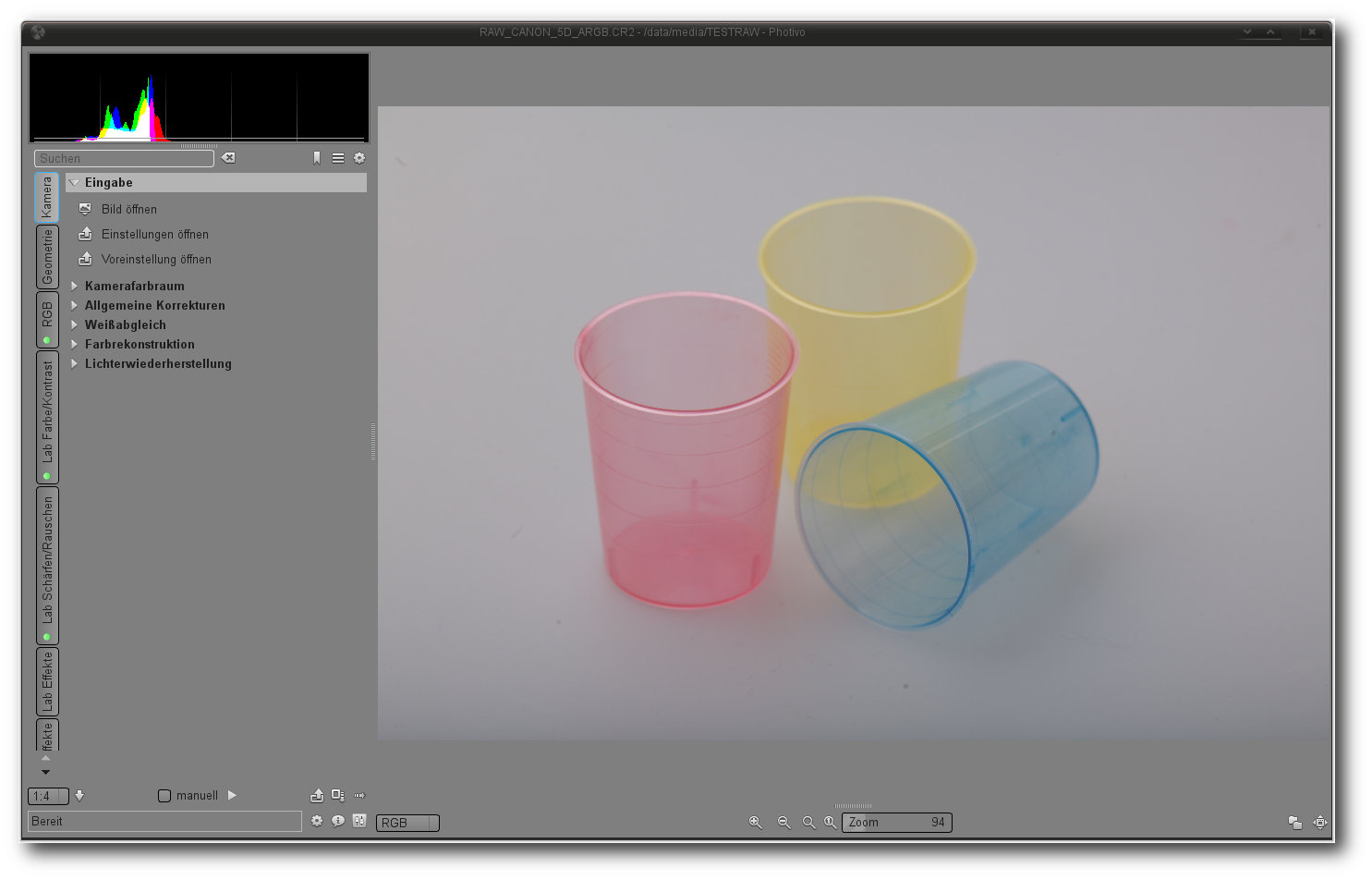

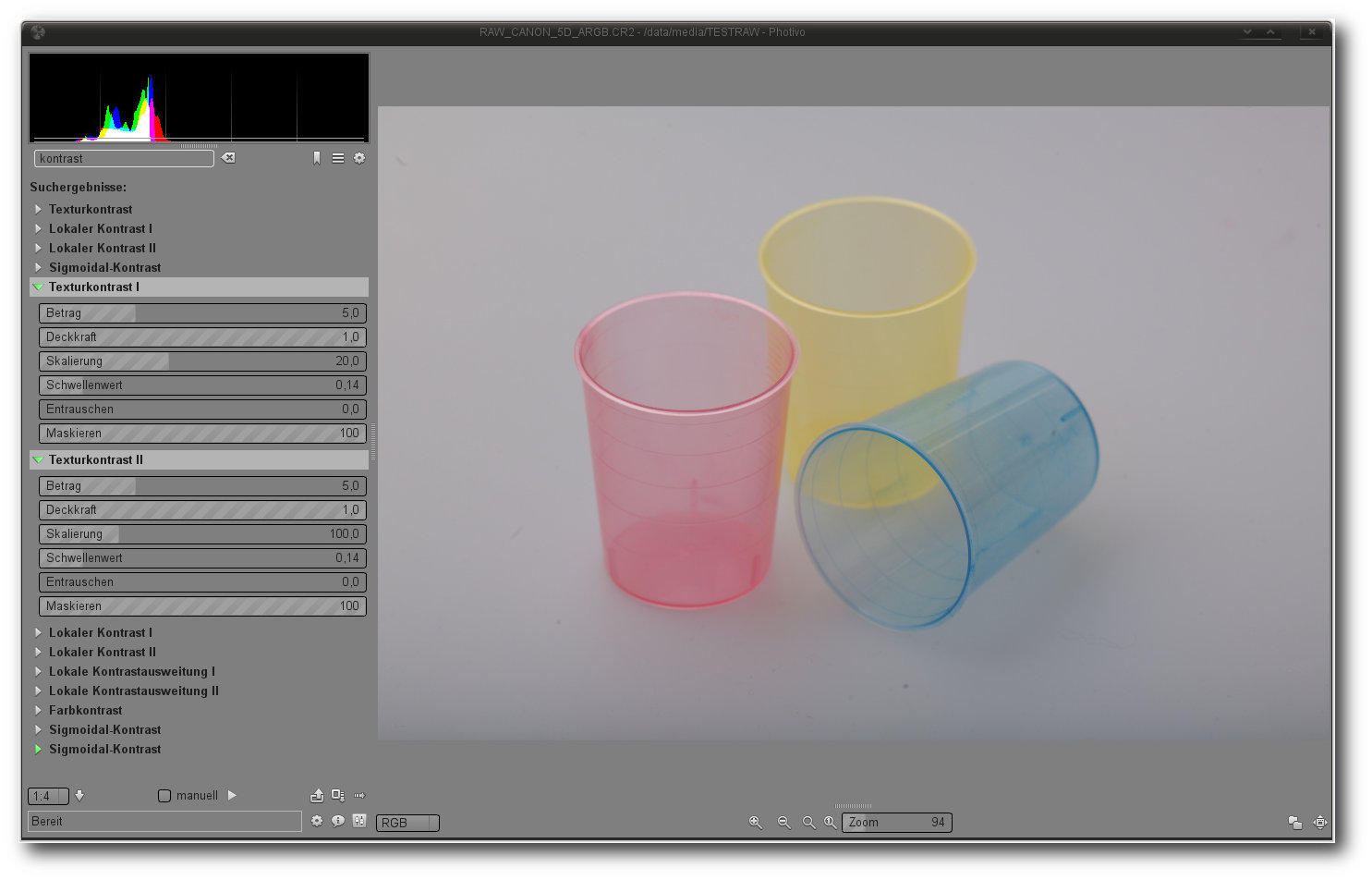

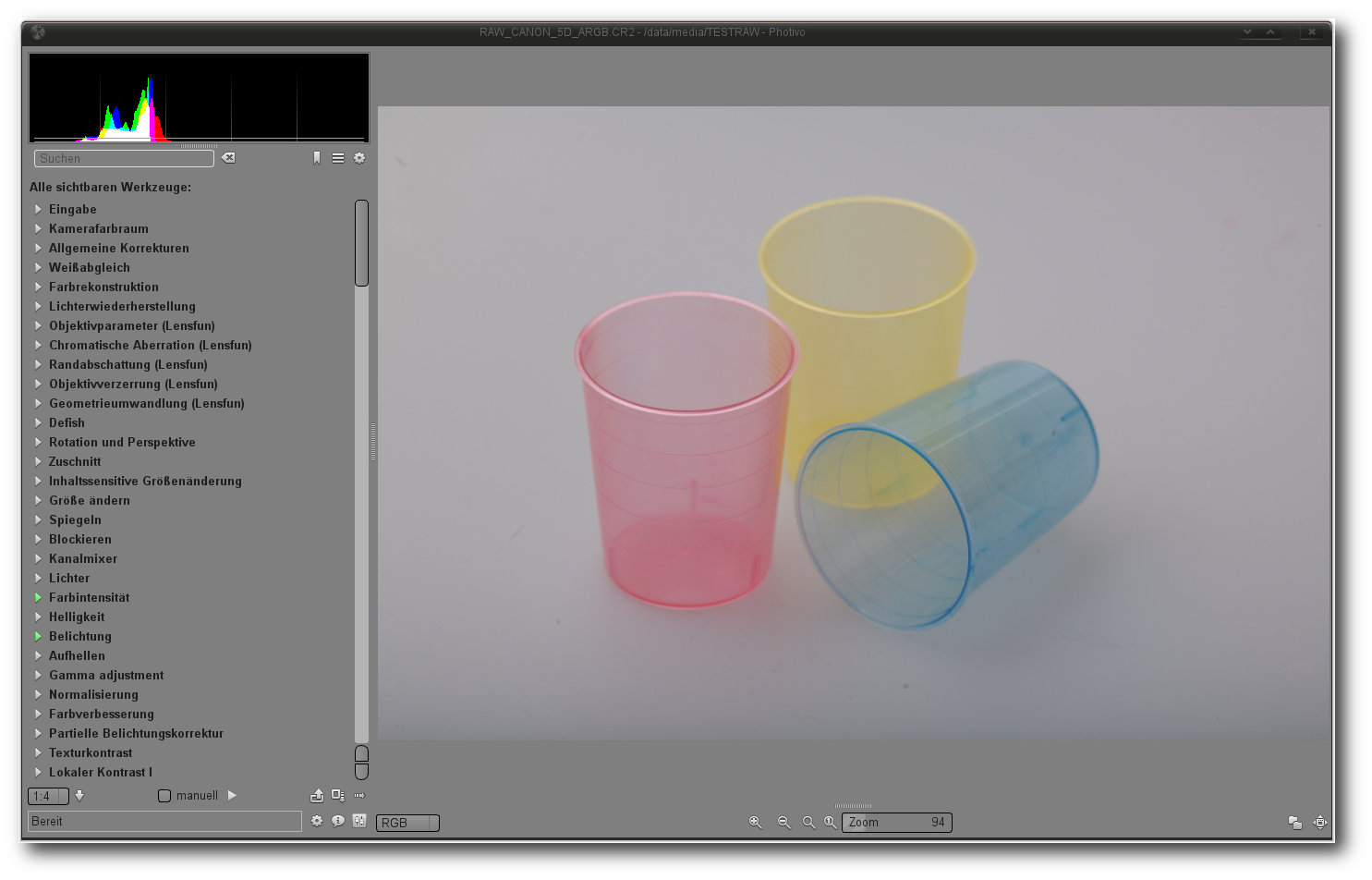

Photivo.

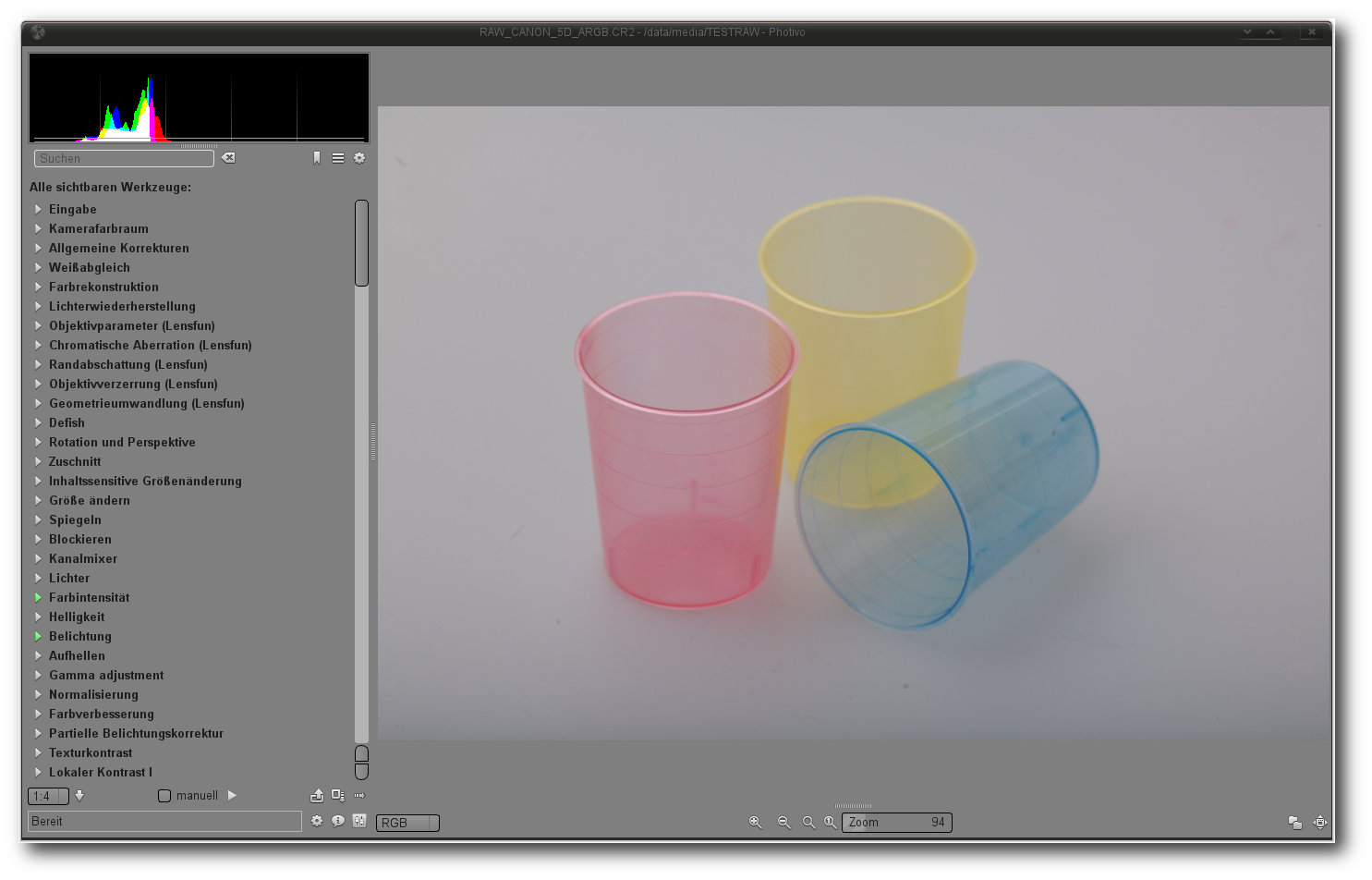

Die Darstellung des Editierbereichs orientiert sich an bekannten

Genrevertretern. So nimmt auch bei Photivo das Bild die prominenteste Rolle ein.

Links davon sind ein Histogramm, die Werkzeugleiste sowie diverse Informationen

angeordnet. Etwas verloren sind ganz unten Funktionen zur Ansicht, Export oder

der Vorschau angebracht. Auch ein Link zum Dateimanager und die Wahl der

Vorschaufunktion sind hier angeordnet.

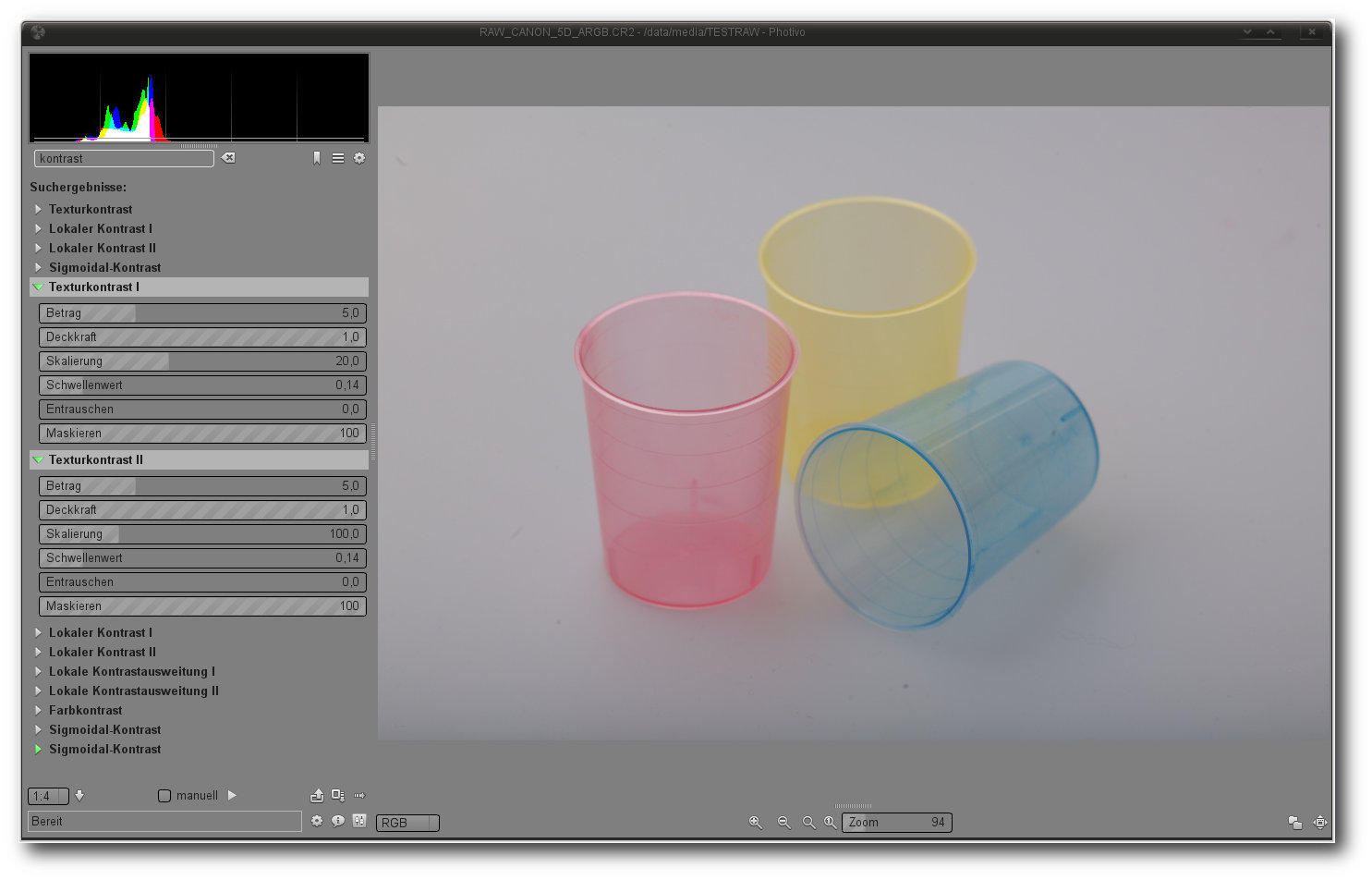

Die Oberfläche des RAW-Editors wirkt auf den ersten Blick aufgeräumt und hält

alle Funktionen über strukturierte Reiter bereit. So finden sich hier unter

anderem Bereiche für die Kamera, Geometrie, Effekte oder die Ausgabe. Bei einer

näheren Betrachtung verwirren aber zahlreiche Punkte. Hier hilft auch nicht die

eingebaute Suche, die nach dem Titel eines Werkzeugs sucht. Wer beispielsweise

nach dem Schlagwort „Kontrast“ fahndet, findet insgesamt 13 verschiedene Tools,

die teilweise den gleichen Namen tragen und dieselben Kontrollelemente haben,

weil sie in verschiedenen Bereichen des Menüs auftauchen. Erfreulich ist hier

allerdings, dass die zahlreichen Menüpunkte vom Anwender unter „Einstellungen“

selbst definiert werden können.

Der Funktionsumfang für RAW-Bearbeitung ist beeindruckend. Ob allgemeine

Bildkorrekturen oder die Beseitigung spezieller Problemstellungen - mit Photivo

kein Problem. Die angebotenen Tools sind qualitativ hochwertig und erlauben

einen kompletten RAW-Workflow.

Operationen, die Photivo durchführt, berechnet

die Anwendung standardmäßig auf einer verkleinerten Ausgabe des Materials.

Nutzer mit schnellen Systemen können allerdings auch auf eine Berechnung des

Originals wechseln. Zudem kann der Anwender festlegen, ob das Bild sofort bei

einer Änderung aktualisiert werden soll oder manuell durch das Starten einer

Vorschau. Das fertige Bild berechnet Photivo dagegen wie bei vielen anderen

Applikationen beim Rendering. Und das kann durchaus dauern, denn Photivo gehört

nicht zu den schnellen Vertretern

seiner Gattung. Die Entwickler selbst erklären

das durch die Qualität der Werkzeuge und den Willen, die besten Algorithmen zu

verwenden, anstatt die Geschwindigkeit im Fokus zu haben.

Die Dateisystemansicht von Photivo wirkt aufgeräumt und erlaubt eine leichte Navigation.

Interessant sind auch die in Photivo eingebundenen Filter, die nicht der

Korrektur, sondern der Verfremdung dienen. Auch hier beeindruckt die Qualität

der gelieferten Arbeit. So liefert beispielsweise der Filter für graduelle

Überlagerung Resultate, die sich auch nicht hinter kommerziellen Produkten

verstecken müssen. Der

Schwarz-Weiß-Filter erlaubt dagegen so fein nuancierte

Einstellungen, dass kaum ein Element nach der Konvertierung auf der Strecke

bleibt.

Der Werkzeugbereich verwirrt nicht selten (hier: Suche nach dem Stichwort Kontrast).

Die eigentliche Fotobearbeitung geschieht auch bei Photivo durch das

nichtdestruktive Anwenden der Werkzeuge. So lassen sich auch in dieser Anwendung zu

jedem Zeitpunkt Filter abschalten oder Tools weiter optimieren, ohne dass der

Anwender auf eine Undo-Funktion angewiesen ist. Durchgeführte Aktionen speichert

Photivo intern. Zudem lassen sich die für jedes Werkzeug festgelegten Parameter in

einer Datei speichern und notfalls wieder laden. Aktive Werkzeuge können in

einem separaten Bereich ein- und ausgeblendet werden. Auch lässt sich der

komplette Workflow abspeichern. So abgelegte Vorlagen können später für andere

Bilder genutzt werden. Über eine echte Stapelverarbeitung verfügt die Anwendung

allerdings nicht. So lassen sich zwar die Vorlagen jeweils einem neuen Bild

zuweisen, wer aber eine Serie von Bildern bearbeiten will, muss zu diversen

Shell-Tricks greifen.

Der Funktionsumfang der Anwendung ist enorm (hier: alle Werkzeuge).

Fertige Resultate sendet die Anwendung an Gimp oder speichert in einem zuvor

festgelegten Format. Dabei erzeugt die Exportfunktion auf Wunsch Bildversionen

in voller Auflösung, wahlweise mit 8 oder 16 Bit Farbtiefe. Beim Verlassen des

Editors erzeugt Photivo zudem eine JPEG- und eine Steuerungsdatei, in der

eine Liste der zur Korrektur genutzten Befehle enthalten ist.

Über weitergehende

Optionen jenseits der Ausgabe auf einer Festplatte verfügt Photivo allerdings

nicht. So ist es unter anderem nicht möglich, Bilder zu drucken oder in einer

Diashow zu präsentieren.

Fazit: Dass der Funktionsumfang junger Projekte durchaus sehr leistungsfähig und

professionell ausfallen kann, beweist Photivo. Die Anwendung hat sich zu einem

äußerst mächtigen Programm entwickelt und bietet zahlreiche Tools an, um ein

Bild an die eigenen Bedürfnisse anzupassen. Für Anfänger in der Materie könnte

Photivo deshalb zu umfangreich ausfallen. Schwächen weist Photivo dagegen in der

Ausgabe, der Geschwindigkeit und der Struktur der Oberfläche auf. Auch die

fehlende Stapelverarbeitung für mehrere Bilder und die nicht vorhandene

Bildverwaltung trüben das ansonsten exzellente Bild.

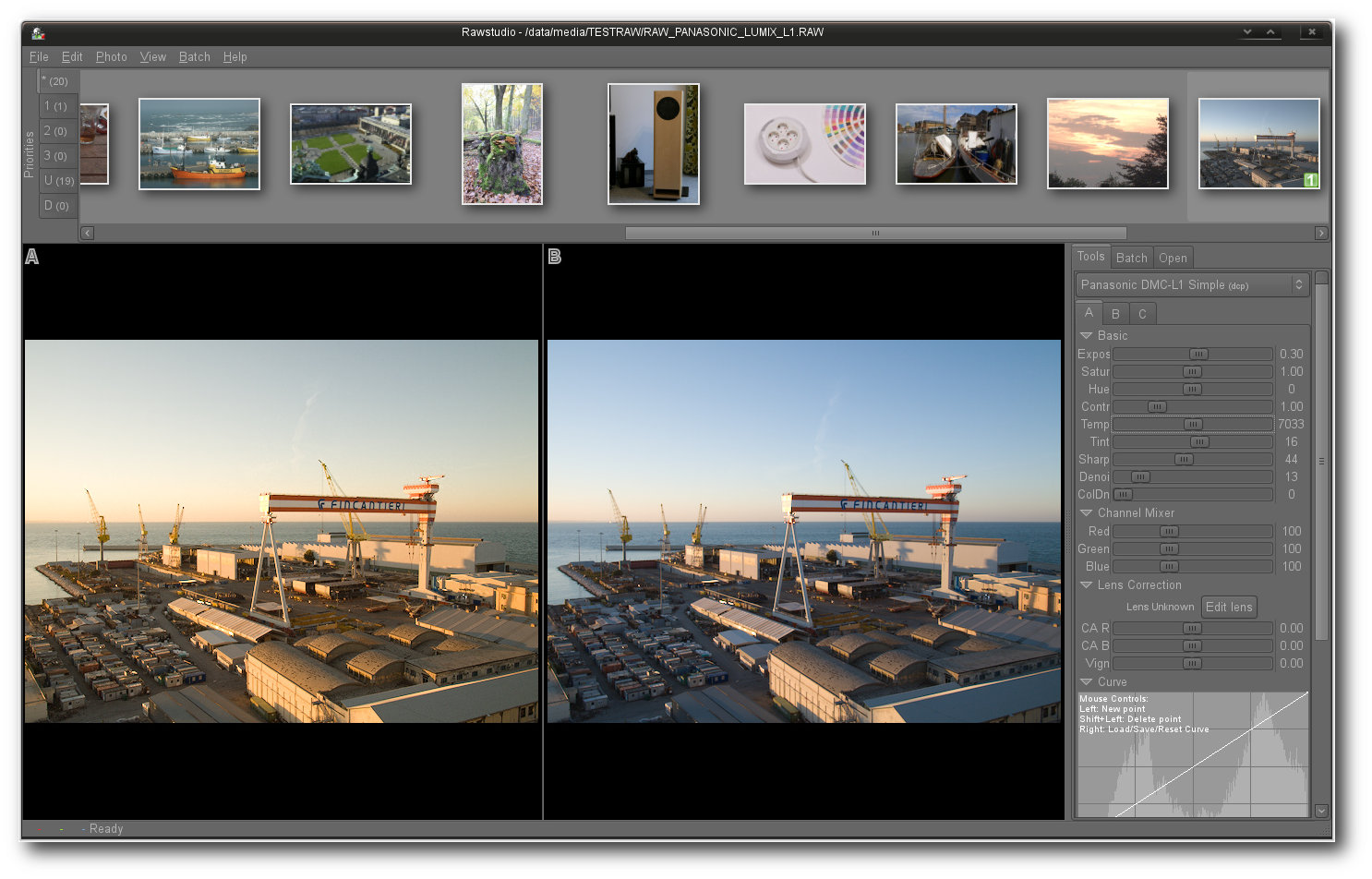

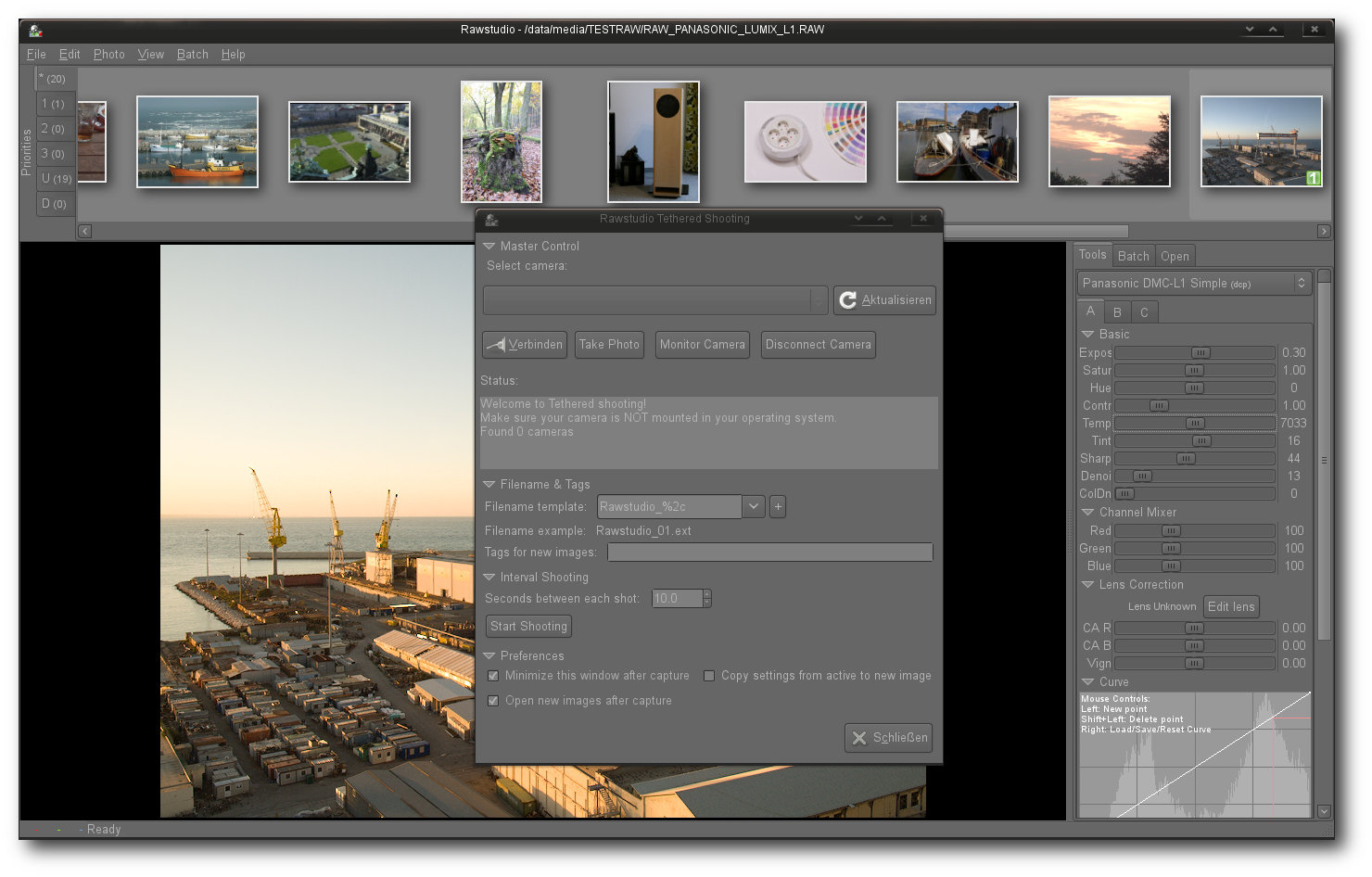

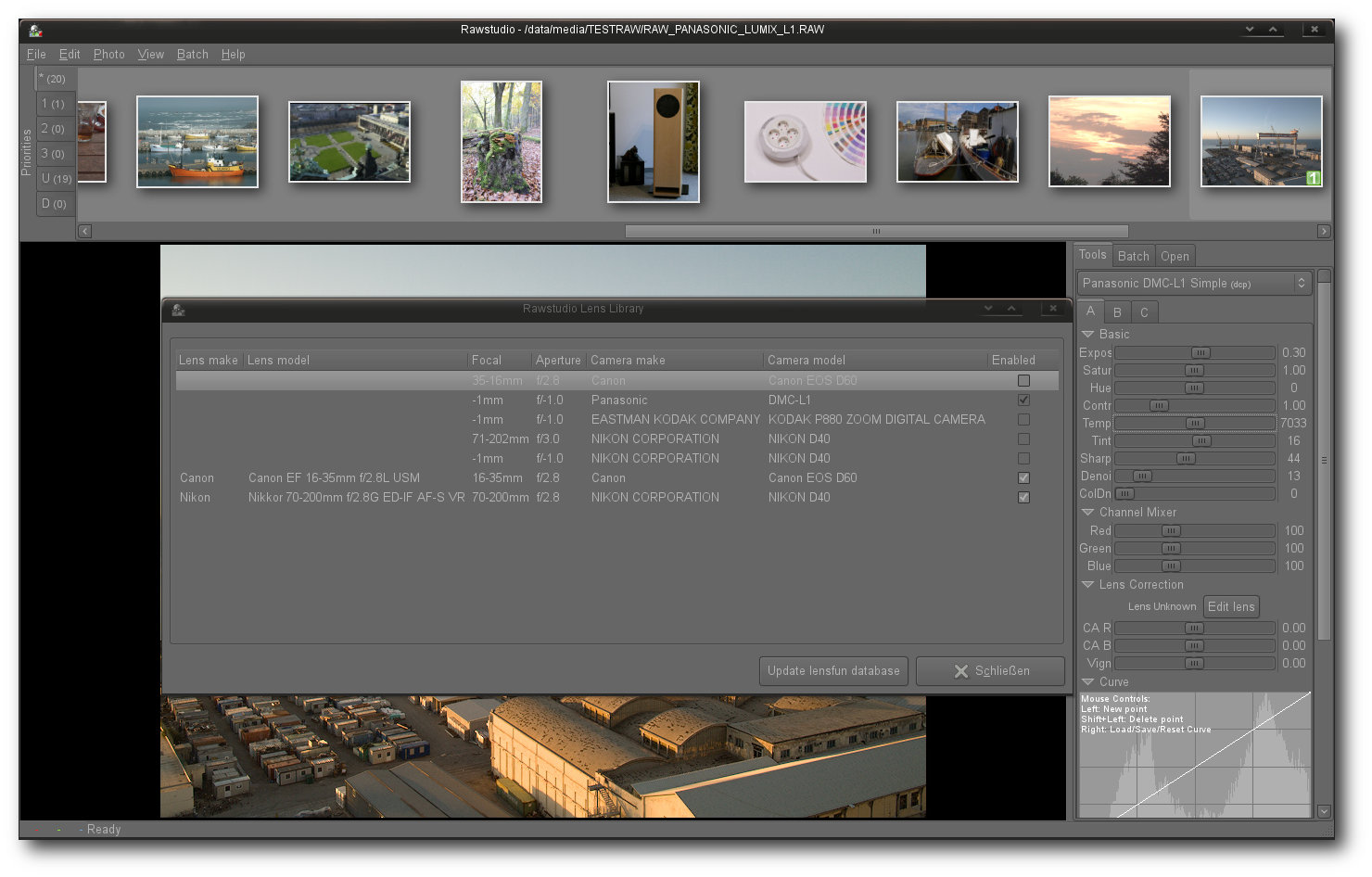

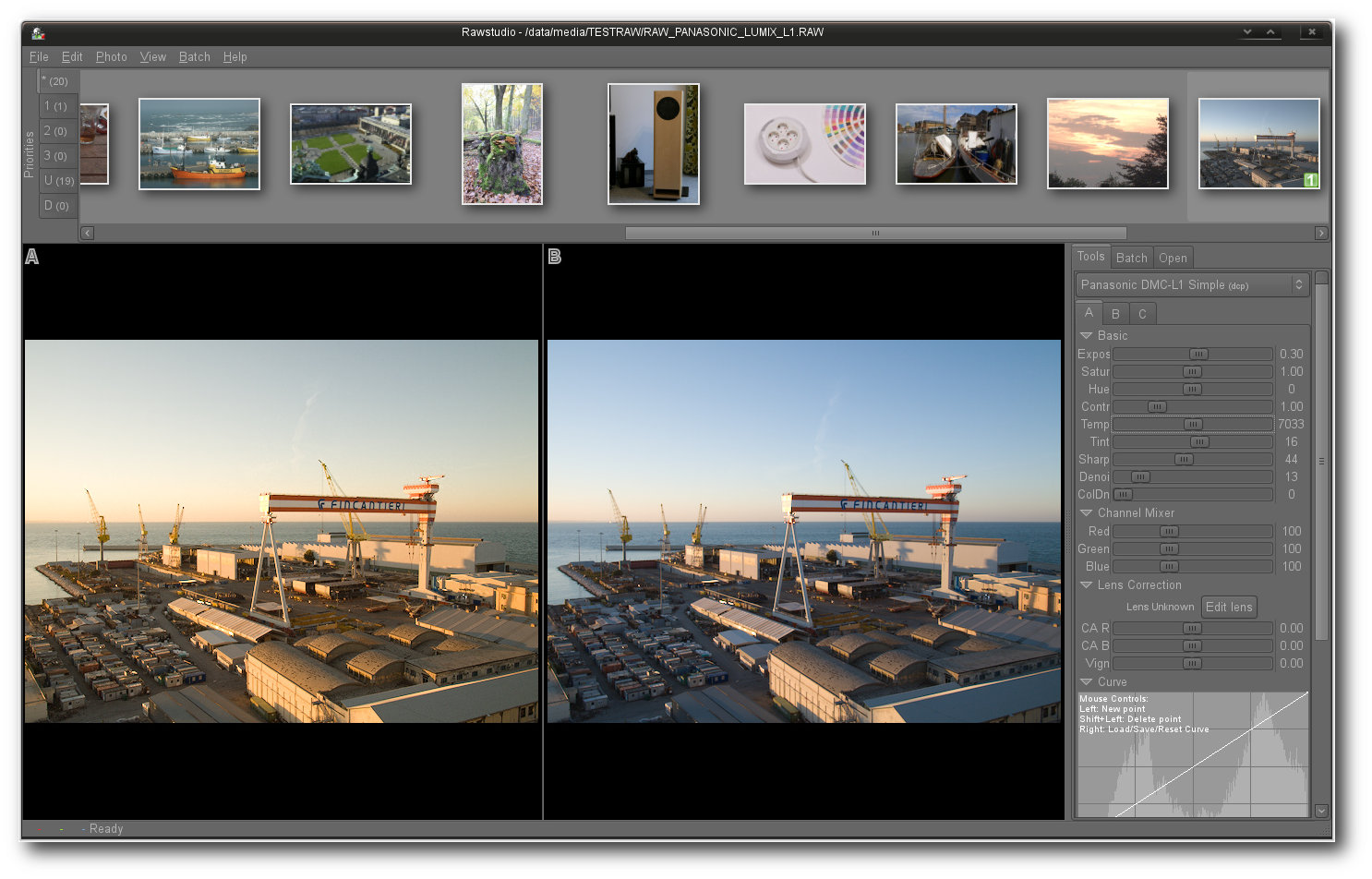

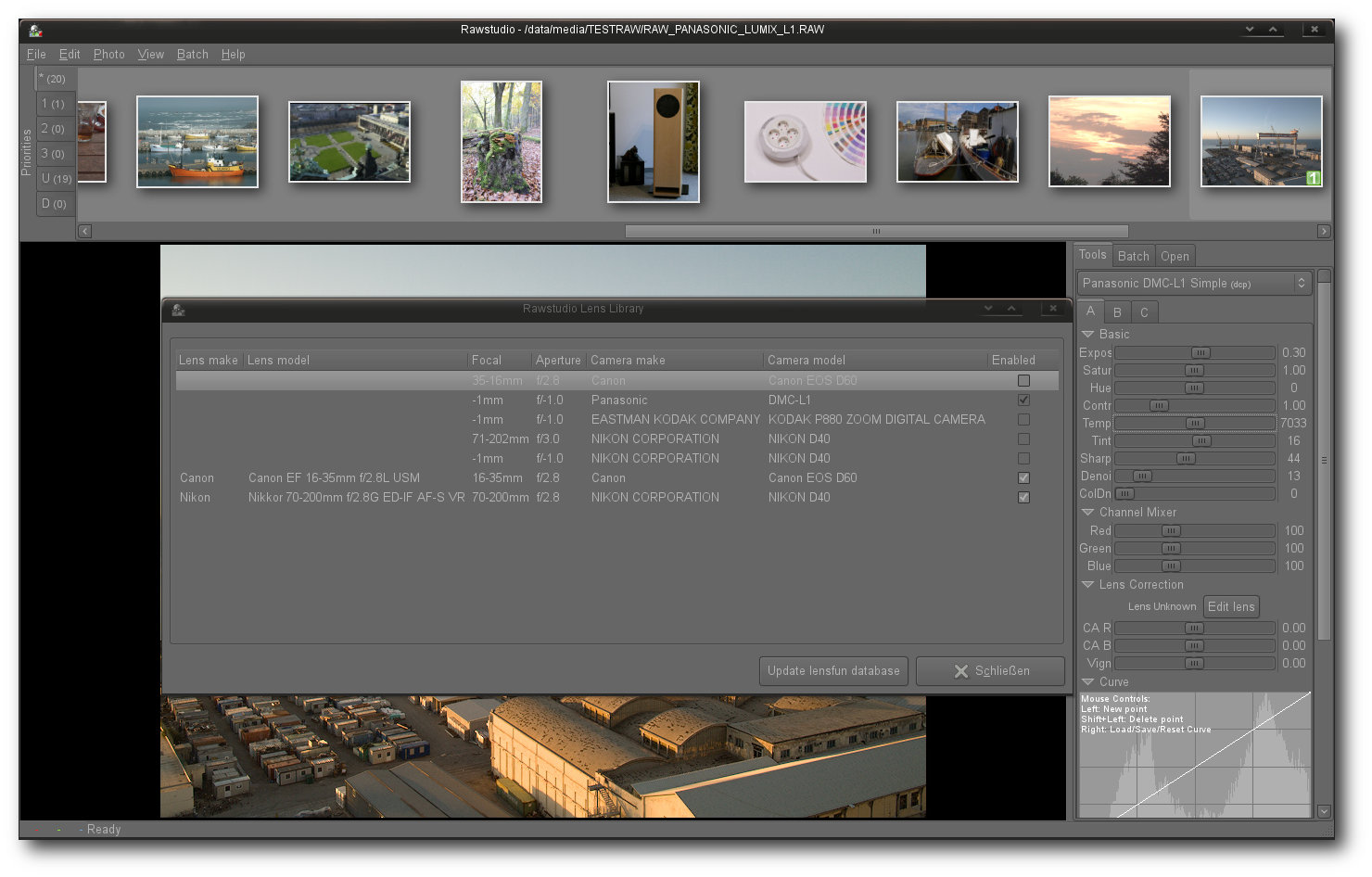

Rawstudio

Das bereits im Jahre 2006 aus der Taufe gehobene

Rawstudio [15] konzentriert sich voll und ganz auf die

Entwicklung von Bildern und verzichtet weitgehend auf jegliche „branchenfremde“

Funktionalität. Die Oberfläche der Anwendung gliedert sich in drei verschiedene

Bereiche. Im

oberen Bereich der Anwendung befindet sich die Vorschauleiste, die

wiederum in sechs verschiedene Unterreiter angeordnet ist. Deren Bedeutung ist

allerdings nicht sofort erkennbar. So listet der oberste Reiter alle geladenen

Bilder, die im Übrigen in der Standardeinstellung nur RAW-Dateien sein dürfen.

Die Bereiche 1 bis 3 entsprechen einer Queue/Priorität, die man jedem Bild

mitgeben kann, während unter „U“ alle noch nicht bewerteten Bilder zu sehen

sind. Der Reiter „D“ listet schlussendlich alle Bilder

auf, die als gelöscht

markiert worden sind. Einzelne Bilder können schnell mittels der Tasten „1“, „2“

oder „3“ einer bestimmen Queue zugeordnet werden, was sich vor allem in der

Praxis als äußerst praktisch erweist. Vor allem größere Bildersammlungen sind so

in kürzester Zeit sortiert und katalogisiert.

Rawstudio.

Das Laden der Bilder erfolgt bei Rawstudio durch eine dedizierte Auswahl direkt

aus einen Dateisystembaum. Zur eigentlichen Verwaltung größerer Bildbestände

eignet sich Rawstudio deshalb nur bedingt. Neben der Möglichkeit einer einfachen

Verschlagwortung von Bildern und der bereits zuvor erwähnten Katalogisierung

bietet die Anwendung zwar noch eine einfache Suchmöglichkeit. Diese beschränkt

sich allerdings nur auf Schlagwörter. Weitere Funktionen, wie beispielsweise

Geotagging oder komplexe Exif-Funktionen samt einer selektiven Suche sucht man

in der Anwendung vergebens.

Auch bei Rawstudio nimmt der Bildbereich den prominentesten Platz ein. Durch das

Drücken der Taste F10 lässt sich der Bereich zudem in einer Volldarstellung auf

einem zweiten Monitor einblenden. Ein Klick mit der rechten Maustaste auf den

Bildbereich blendet diverse Optionen ein - unter anderem eine

Vorher/Nachher-Ansicht und eine Über/Unterbelichtungs-Warnung. Ein direkter Klick

auf den Bildbereich mit der linken Maustaste korrigiert dagegen den

Weißabgleich.

Der Werkzeugbereich liegt auf der rechten Seite des Fensters. Hier findet der

Anwender unter

anderem die Möglichkeit, Kamera- oder Farbprofile in den Workflow

einzubinden. Ferner beinhaltet der Bereich auch alle relevanten Regler,

Transformationswerkzeuge oder ein Histogramm. Ebenfalls im Werkzeugbereich

enthalten sind eine Tagsuche, eine Baumansicht des Dateisystems und der

Batch-Manager, in dem neben dem Ausgabeverzeichnis auch das zu verwendete Format

bestimmt werden kann. Zudem listet Rawstudio hier alle Bilder auf, die durch

einen Batch-Vorgang bearbeitet werden.

Eine Vorschauansicht sorgt für Kontrolle bei der Bearbeitung des Bildes.

Bei der Korrektur und der Anpassung von Bildern beschränkt sich Rawstudio auf

das absolut Notwendige. Dass die Anwendung trotzdem für die meisten Anwender von

Interesse sein könnte, dürfte unter anderem in der Auswahl der Funktionen und

der hohen Arbeitsgeschwindigkeit liegen. Größere Wartezeiten bei der Anwendung

von Werkzeugen sind auch auf schmalbrüstigen Systemen kaum zu erwarten. Zur

Auswahl

stehen dabei neben Standardwerkzeugen, wie der Korrektur von Kontrast

oder der Temperatur, auch ein Kanalmischer und eine Objektivkorrektur. Elemente

für Lichter- oder eine Schattenkompression lässt Rawstudio allerdings vermissen.

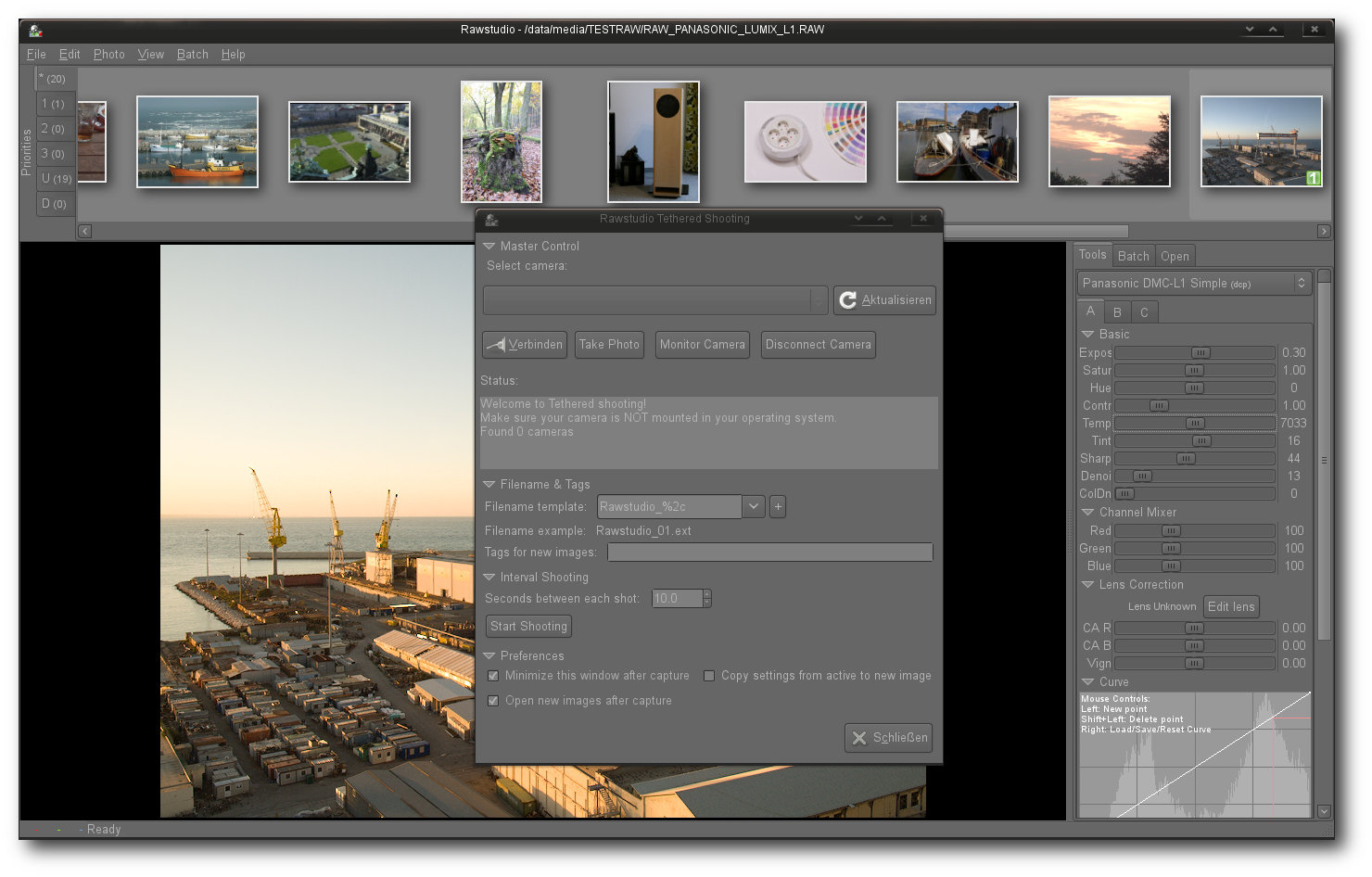

Ebenfalls in der Anwendung integriert – eine Tethering-Funktion.

Einstellungen eines Bildes können unter Rawstudio mühelos zwischen verschiedenen

Bildern geteilt werden. Neben der Möglichkeit, Änderungen durch eine

Stapelverarbeitung auch auf andere Bilder anzuwenden, erlaubt die Anwendung auch

das direkte Kopieren von Einstellungen mittels „Strg“ + „C“ und „Strg“ + „V“. Das Programm

öffnet in diesem Fall ein neues Fenster mit allen zu übertragenden Werten, die

je nach Vorhaben entweder an- oder abgewählt werden können.

Dank der Einbindung von Lensfun erkennt auch Rawstudio Objektive automatisch.

In Bildern durchgeführte Änderungen werden auch in Rawstudio verlustfrei

durchgeführt. Dabei speichert die Anwendung, wie die meisten RAW-Konverter,

neben dem Resultat auch

die Veränderungen in separaten Steuerungsdateien. Bei

Rawstudio liegen die Korrekturen im Verzeichnis des Originals im Unterordner

.rawstudio. Zudem legt die Export-Funktion in demselben Ordner eine Vorschau des

Bildes ab. Fertig bearbeitete Bilder werden wahlweise einzeln oder stapelweise

in ein zuvor festgelegtes Verzeichnis exportiert. Zusätzlich bietet die

Anwendung auch die Möglichkeit, die Ausgaben an Gimp umzuleiten oder via

Facebook, Flickr oder Picasa zu publizieren. Eine Druckoption oder eine

Möglichkeit der Präsentation sind allerdings nicht vorhanden.

Fazit: Dass Rawstudio trotz funktionaler Einschränkungen mittlerweile eine große

Fangemeinde um sich versammelt hat, verwundert nicht. Zwar beschränkt sich die

Anwendung auf die wichtigsten Funktionen eines RAW-Workflows, erledigt aber die

an das Programm gestellten Aufgaben mit Bravour. Weder die

Qualität noch die

Geschwindigkeit lassen irgendwelche Wünsche offen. Schwächen weist Rawstudio

dagegen bei der Ausgabe der Bilder und bei fortgeschrittenen Funktionen auf. Wie

kaum ein anderes Projekt krankt das Programm zudem an einem akuten

Dokumentationsmangel.

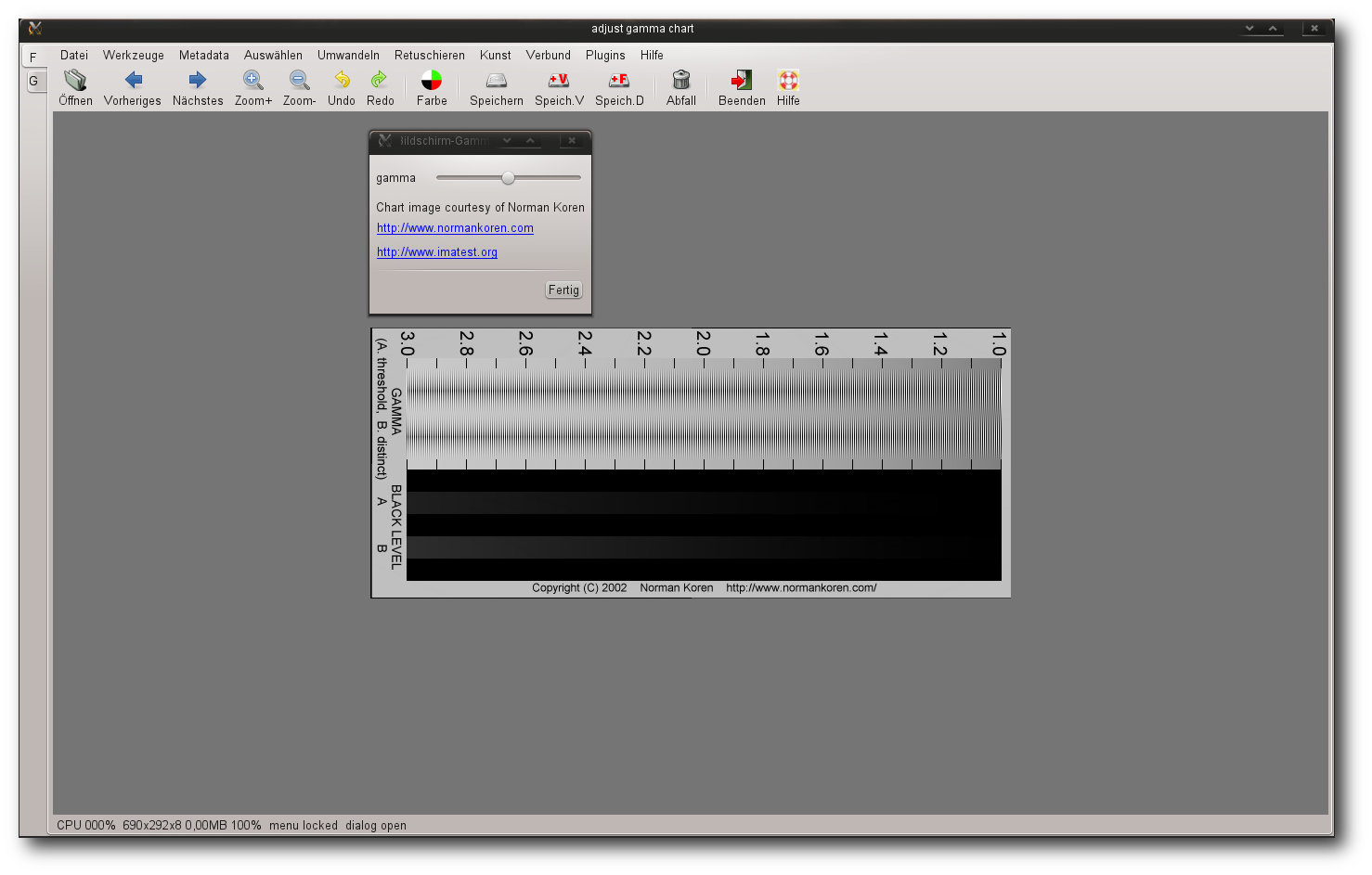

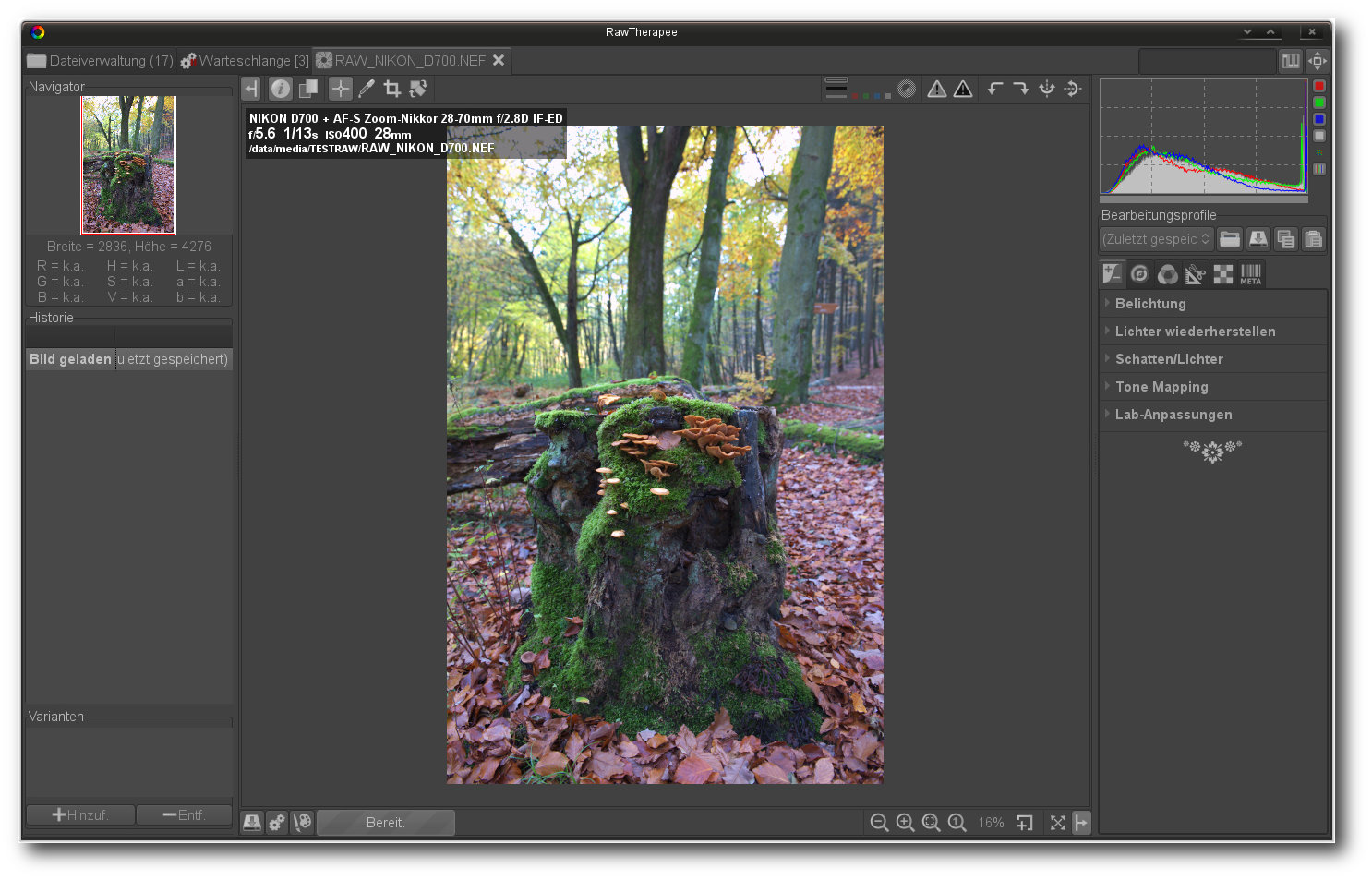

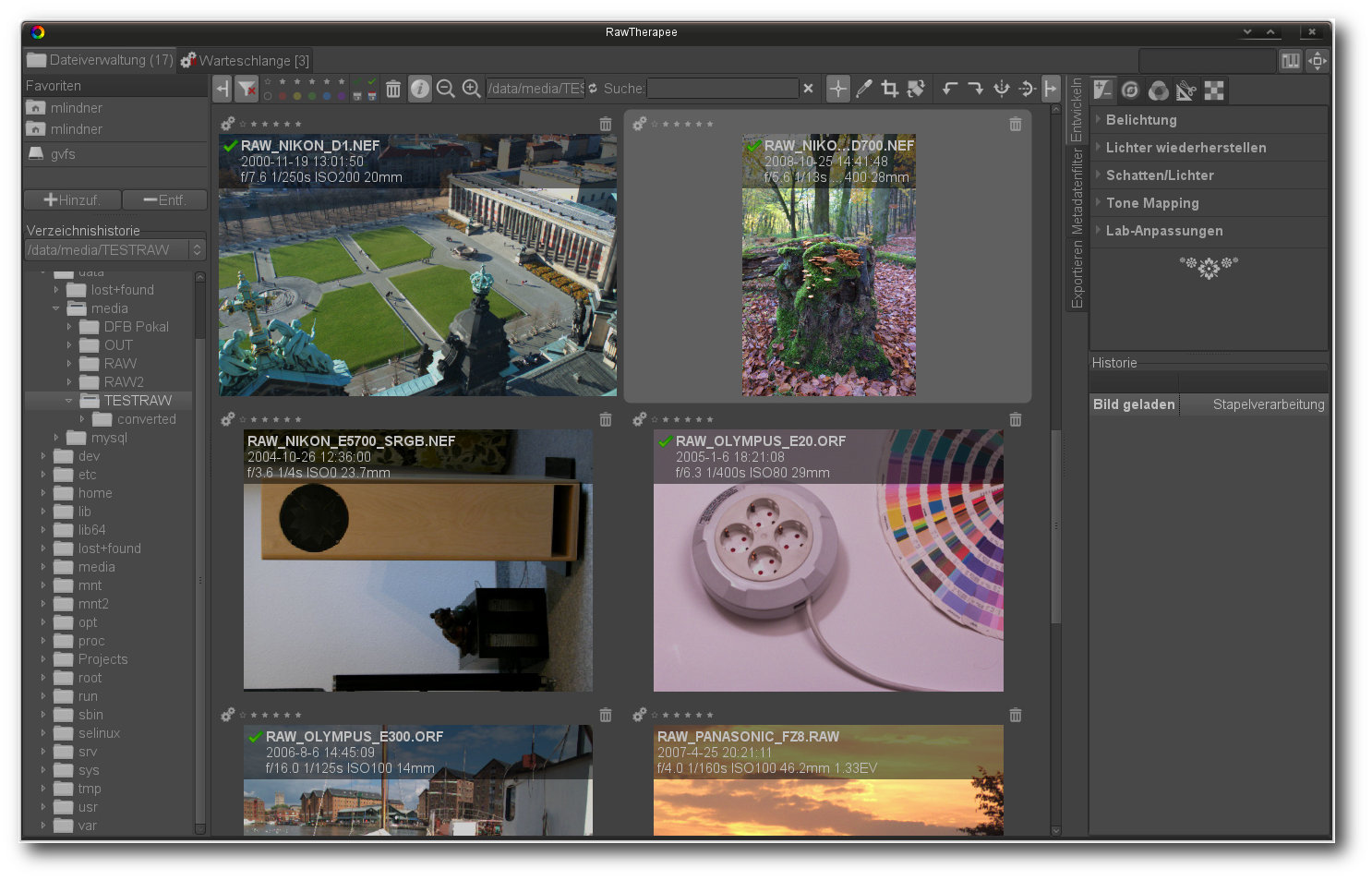

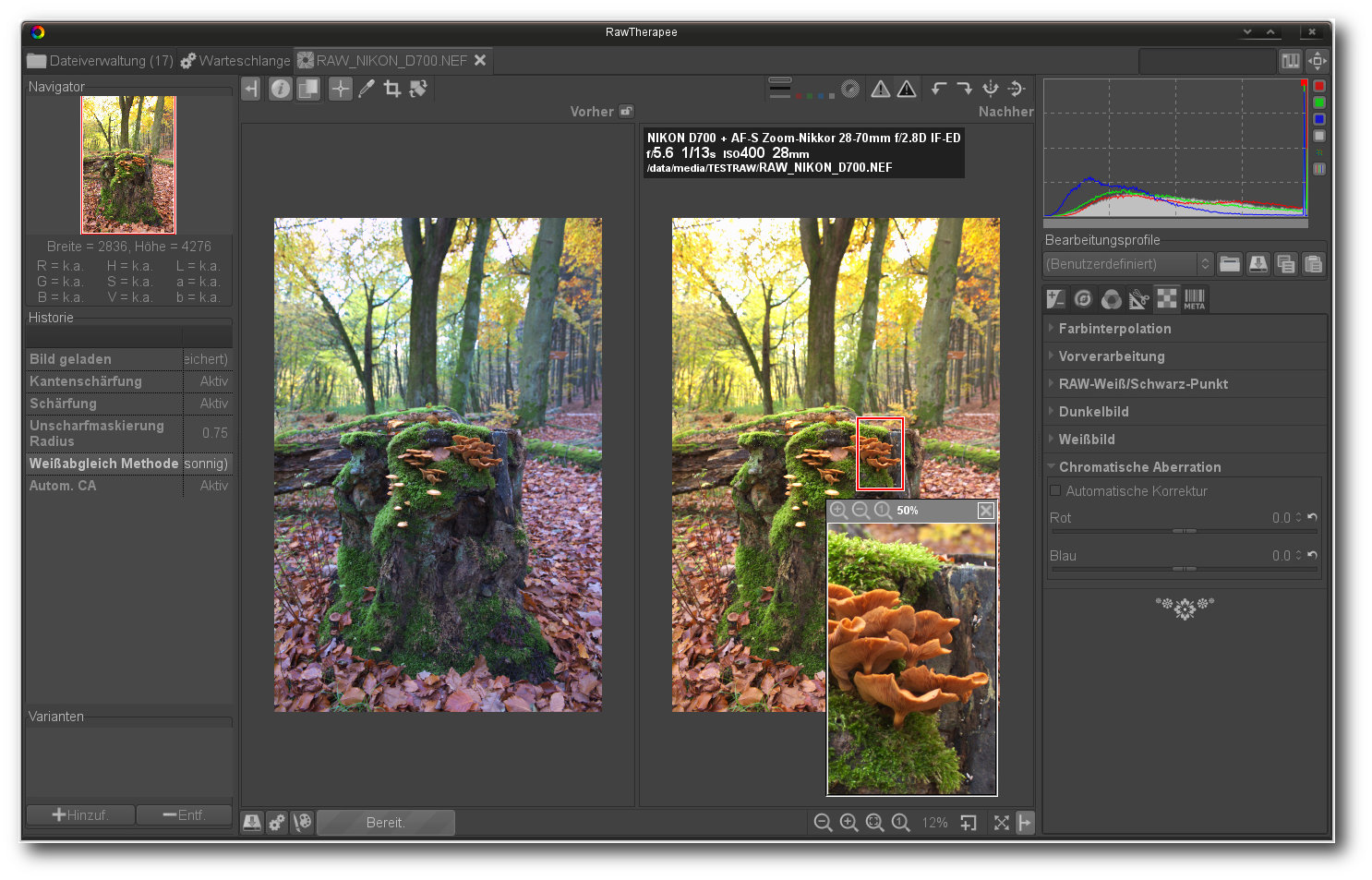

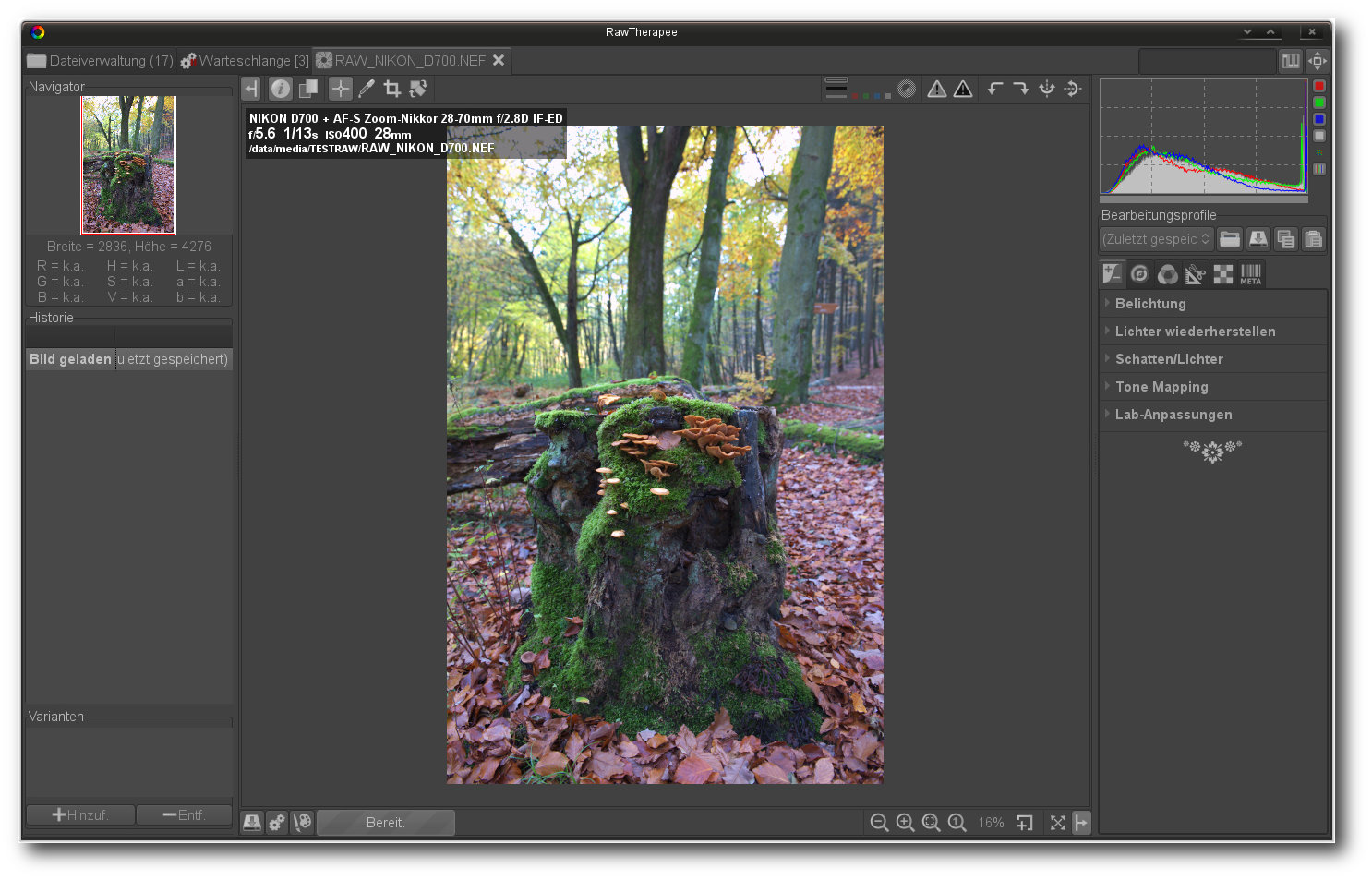

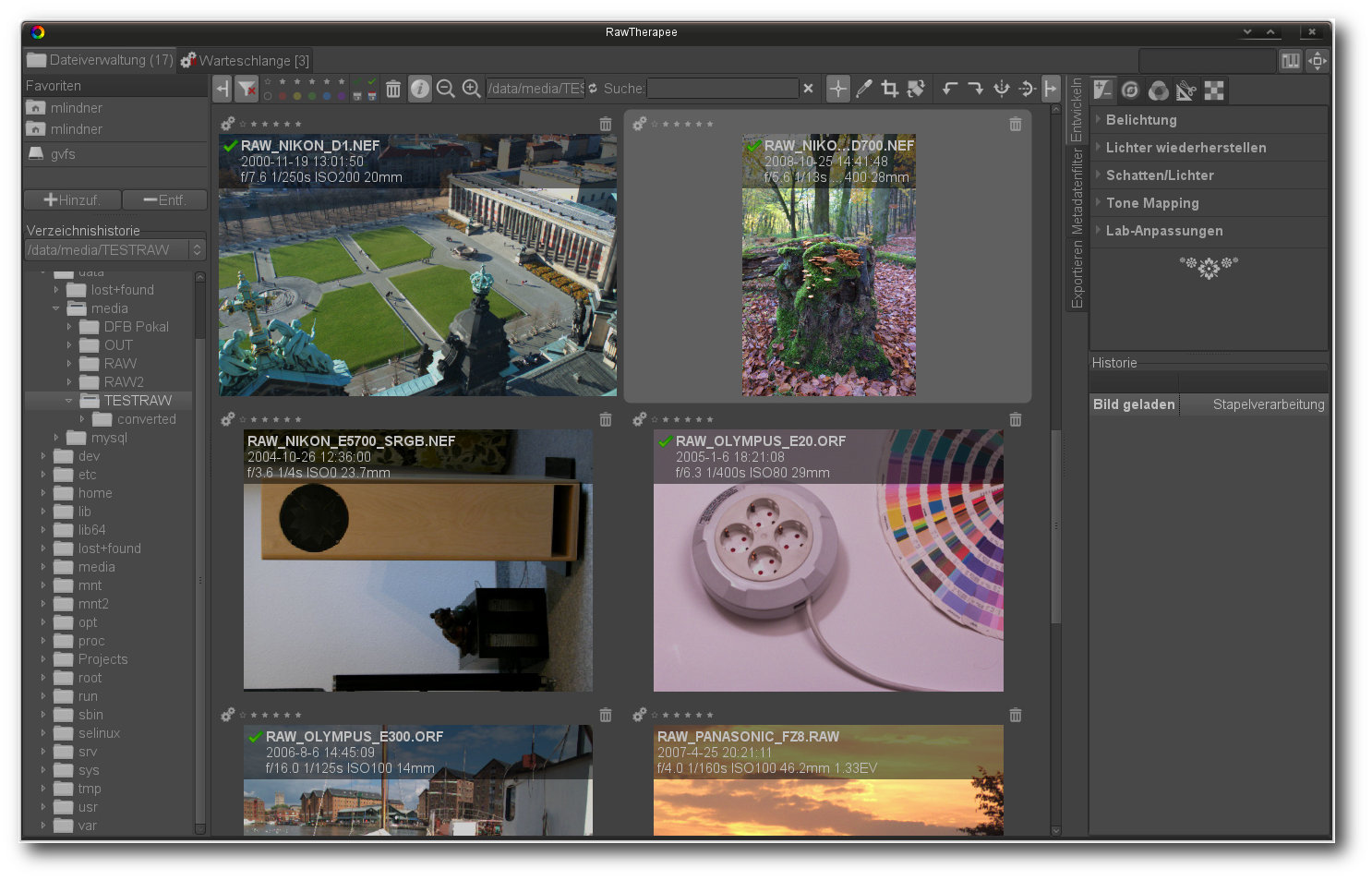

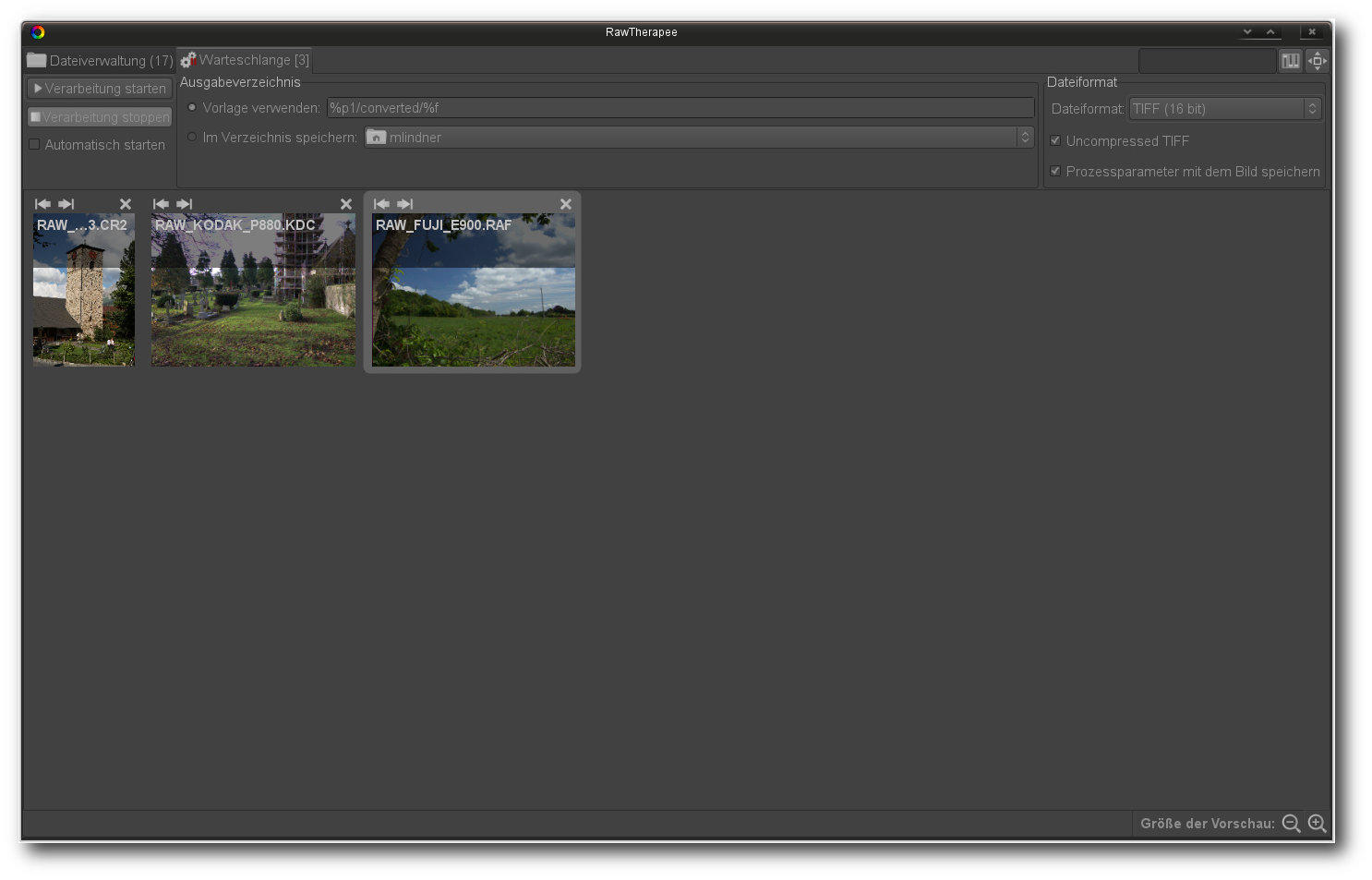

RawTherapee

Der ursprünglich proprietäre und seit Anfang 2010 unter der Bedingung der GNU

GPLv3

vertriebene Konverter RawTherapee [16] mauserte

sich in der letzten Zeit zu einem der beliebtesten Tools sowohl unter Linux als

auch unter Windows. Das Programm bietet zahlreiche fortschrittliche

Einstellungsmöglichkeiten, eine intuitive Bedienung und Funktionen, die den

allermeisten Aufgaben eines RAW-Workflows gewachsen sind. Wie auch bei anderen

Vertretern der Konverter-Sparte verzichtet allerdings auch RawTherapee auf

jegliche Funktionalität jenseits des reinen Entwickelns. Datenbankfunktionen,

Druckeroptionen oder Werkzeuge für den Online-Export sucht man in der Anwendung

genauso vergebens wie fortgeschrittene Katalogisierungs- oder

Tagging-Operationen.

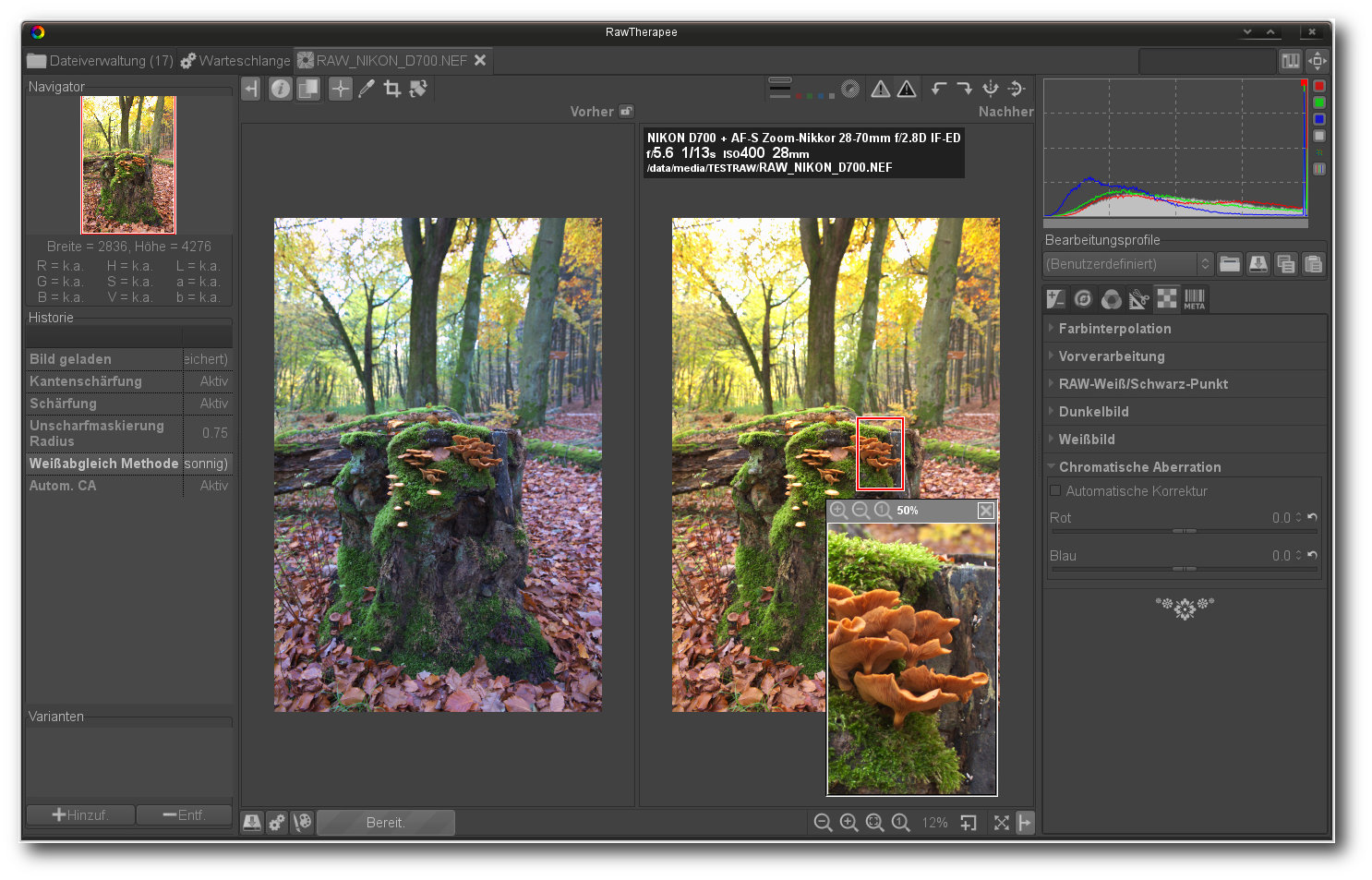

RawTherapee.

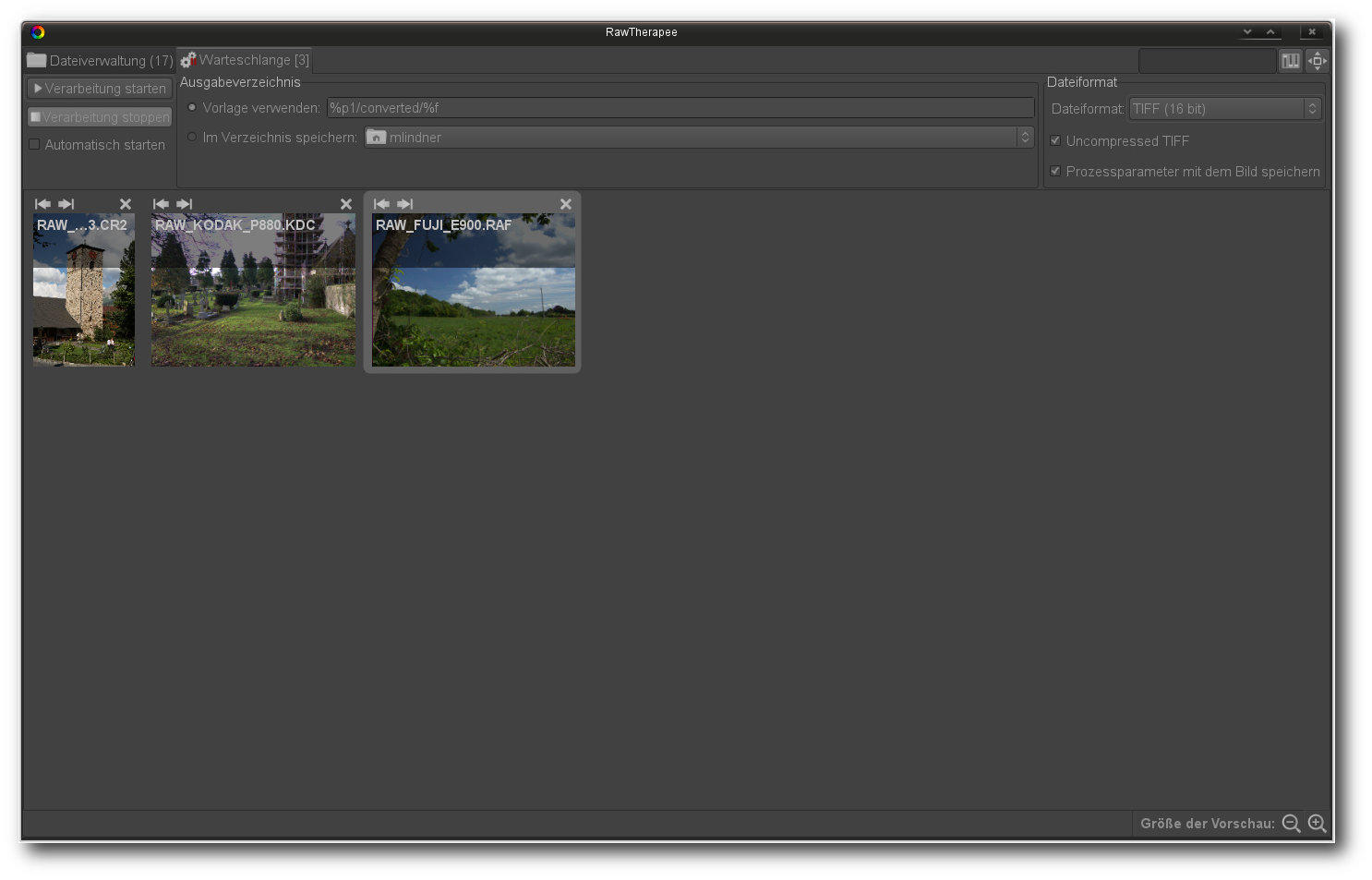

Die Oberfläche von RawTherapee ist in verschiedene Reiter gruppiert. Der erste

nennt sich „Dateiverwaltung“ und beinhaltet alle Funktionen, die zur Ansicht und

der Auswahl von Bildern notwendig sind. Hier können Anwender unter anderem durch

die Verzeichnisstruktur des Systems oder durch die Favoriten navigieren, Bilder

mittels zahlreicher Filter suchen, sie bewerten oder ihnen Farbmarkierungen

geben. Auch zahlreiche Basisoperationen wie Drehen, Spiegeln oder Zuschneiden

sind hier zu finden. Ferner bietet der Bereich auch diverse Tools zum Entwickeln

an, die direkt und ohne Umwege auf eine ausgewählte Vorschau angewendet werden

können. Korrekturen, die in der Vorschauansicht durchgeführt wurden, werden

sofort in der Vorschau sichtbar und lassen sich dank der recht großzügigen

Darstellung der Vorschaubilder auch durchaus gut beurteilen.

Ebenfalls in der Vorschauansicht findet die Steuerung der Stapelbearbeitung

statt. Eine Mehrfachauswahl von Bildern erlaubt ein Zuweisen eines zuvor

erstellten Profils zu mehreren Dateien. So markierte Elemente können an die

Stapelbearbeitung geschickt werden. Die Stapelbearbeitung, unter RawTherapee

auch „Warteschlange“ genannt, findet ihren Platz im zweiten Reiter und ist für

die Entwicklung der Bilder verantwortlich. Der Start der Warteschlange kann

individuell beeinflusst werden. So können beispielsweise zuerst der Verarbeitung

Bilder zugewiesen werden, die erst nach einem dedizierten Start abgearbeitet

werden. Doch auch ein automatischer Start ist möglich. Wird der Warteschlange

ein Bild zugewiesen, so kann sie automatisch anlaufen und alle Schritte im

Hintergrund abarbeiten, während der Anwender selbst weiter an einem anderen Bild

arbeitet. Die Ausgabe der Bilder kann wahlweise im JPEG-, TIFF- oder PNG-Format

erfolgen.

Für die eigentliche Bearbeitung in der Vollbildansicht öffnet die Anwendung je

einen separaten Reiter. Die zahlreich darin platzierten Werkzeuge unterteilt die

Anwendung in die Kategorien „Belichtung“, „Detail“, „Farbe“, „Verändern“, „RAW“

und „Metadaten“. Unter „Belichtung“ findet sich, wie erwartet, die Steuerung der

Lichter, Schatten, des Schwarzpegels, aber auch eine Tonwertkurve und die

Korrekturen des Tone-Mappings oder der Sättigung. Besonders elegant hantiert die

Anwendung dabei mit der Sättigung, die beispielsweise nur auf ungesättigte

Farben angewendet werden kann. Der Bereich „Details“ weist dagegen zahlreiche

Einstellungen auf, die sich der Schärfung und der Rauschunterdrückung

verschrieben haben. Unter „Farbe“ kann dagegen der automatische oder manuelle

Weißabgleich durchgeführt werden. Ebenso hier findet sich auch ein Kanalmixer,

HSV-Equalizer und ein Regler für Dynamik eines Bildes. Schaltet man die Option

ein, erhöht RawTherapee die Sättigung, ohne allerdings dabei die Farben zu

ändern. Über eine eigene Schwarz-Weiß-Funktion verfügt RawTherapee allerdings

nicht. Hier muss manuell Hand an die Sättigung und den Kanalmixer gelegt

werden. Ebenso nicht vorhanden sind Werkzeuge zum Entfernen roter Augen.

Die Dateisystemansicht lässt eine einfache Navigation durch Galerien zu.

Objektivkorrekturen, wie beispielsweise eine Vignettierungs- oder eine

Verzeichungskorrektur, oder Funktionen zum Ausschnitt listet der

„Verändern“-Bereich auf. Im Gegensatz zu anderen freien Anwendungen nutzt

RawTherapee allerdings nicht die Bibliothek von lensfun, sondern erlaubt die

Einbindung von Adobe LCP-Profilen, was in der Praxis erheblich mehr

Arbeitsaufwand erfordert und weniger automatisiert abläuft. Wie der Seite des

Projektes allerdings entnommen werden kann, ist eine Integration von lensfun

bereits angedacht und steht auf der Liste der Entwickler.

Bilder können entweder sofort gespeichert oder in eine Warteschlange eingereiht werden.

„RAW“-Bereich führt eine breite Palette an Werkzeugen, die für eine

Verarbeitung

von RAW-Dateien verantwortlich sind. Unter anderem können hier die

Vorverarbeitung und die Farbinterpolation bestimmt werden. Ebenso sind hier die

Bestimmung des Dunkel- und Weißbildes sowie diverse

RAW-Weiß/Schwarzpunkt-Korrekturen zu finden. Metadaten werden dagegen in dem

gleichnamigen, letzten Bereich verändert. RawTherapee erkennt in der Bilddatei

abgelegte Exif-Daten und ermöglicht die Änderung der darin enthaltenen

Informationen. Über den Unterreiter „IPTC“ erhält der Nutzer zudem Zugriff zu

Schlagwort-Einträgen etwa zur Bildbeschreibung, Autor, Titel, Copyright oder

Aufnahmeort. Hier ist auch die Verschlagwortung der Bilder möglich, um sie

schneller anhand der Tags finden zu können.

RawTherapee kommt mit zahlreichen Werkzeugen, die den kompletten RAW-Workflow abdecken.

Bearbeitete Fotos müssen, wie auch in anderen Anwendungen üblich, explizit

exportiert werden. Dies kann entweder direkt oder durch das Hinzufügen des

Bildes in die Warteschlange erfolgen. Die Arbeitsgeschwindigkeit ist dabei

akzeptabel, auch wenn die Anwendung nicht zu den schnellsten Vertretern der

Gattung gehört. Über Funktionen zur Präsentation oder zum Druck verfügt das

Programm genauso wenig wie über eine Panoramagenerierung oder HDR-Berechnung.

Fazit: RawTherapee beherrscht mühelos das Darstellen, Bearbeiten und

Konvertieren von RAW-Dateien. Das Programm verfügt über zahlreiche Funktionen

und überrascht durch professionelle und funktionsstarke Werkzeuge. Die

Oberfläche der Anwendung wirkt aufgeräumt und ist intuitiv bedienbar. Doch

gerade der große Umfang der Funktionen könnte überfordern. Die Lektüre der

ausgezeichneten Dokumentation ist deshalb vor allem für RAW-Neulinge Pflicht.

Schwächen weist die Anwendung hingegen in der Verwaltung der Bilder und dem

Ausgabeoptionen auf. Die manuelle Einbindung von Linsen-Korrekturprofilen wirkt

nicht mehr zeitgemäß, wobei das Problem den Entwicklern bekannt und eine

Lösung bereits angedacht ist.

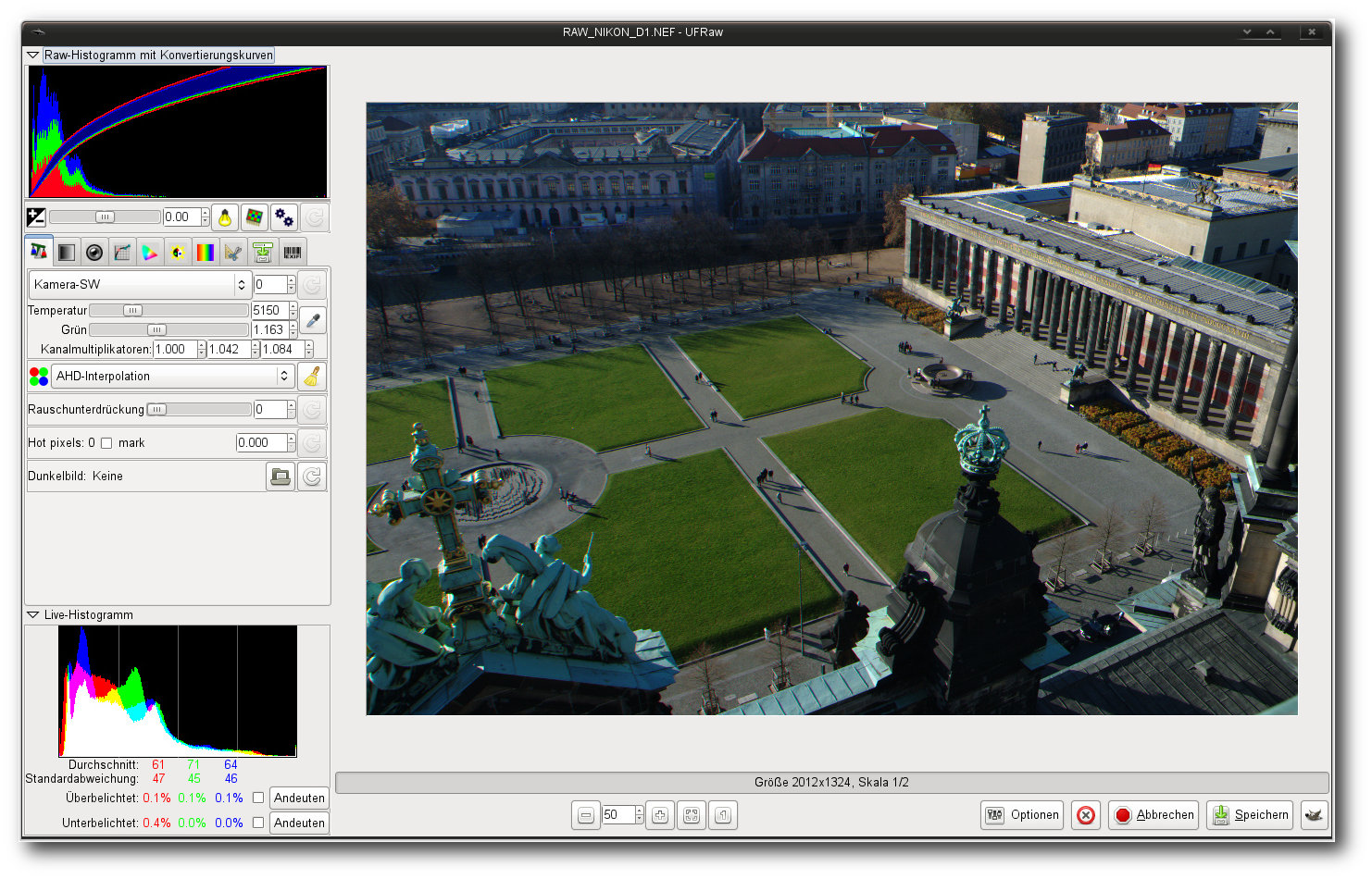

UFRaw

Wie die Mehrzahl der hier vorgestellten Anwendungen stellt auch der Unidentified

Flying Raw-Konverter (UFRaw [17]) ein freies

Programm zum Auslesen, Bearbeiten und Umwandeln von Bilddateien dar, die im

Rohdatenformat von Digitalkameras geliefert werden. Das Programm kann sowohl als

Plug-in für den Grafikkünstler Gimp als auch als eigenständige Anwendung

installiert werden. Grundsätzlich bleibt festzuhalten, dass UFRaw ein wahrer

Allrounder ist, der eine breite Verwendung findet. Viele Applikationen setzen im

Hintergrund auf die Funktionalität UFRaw und erledigen beispielsweise die

Konvertierung der RAW-Dateien mittels „ufraw-batch“.

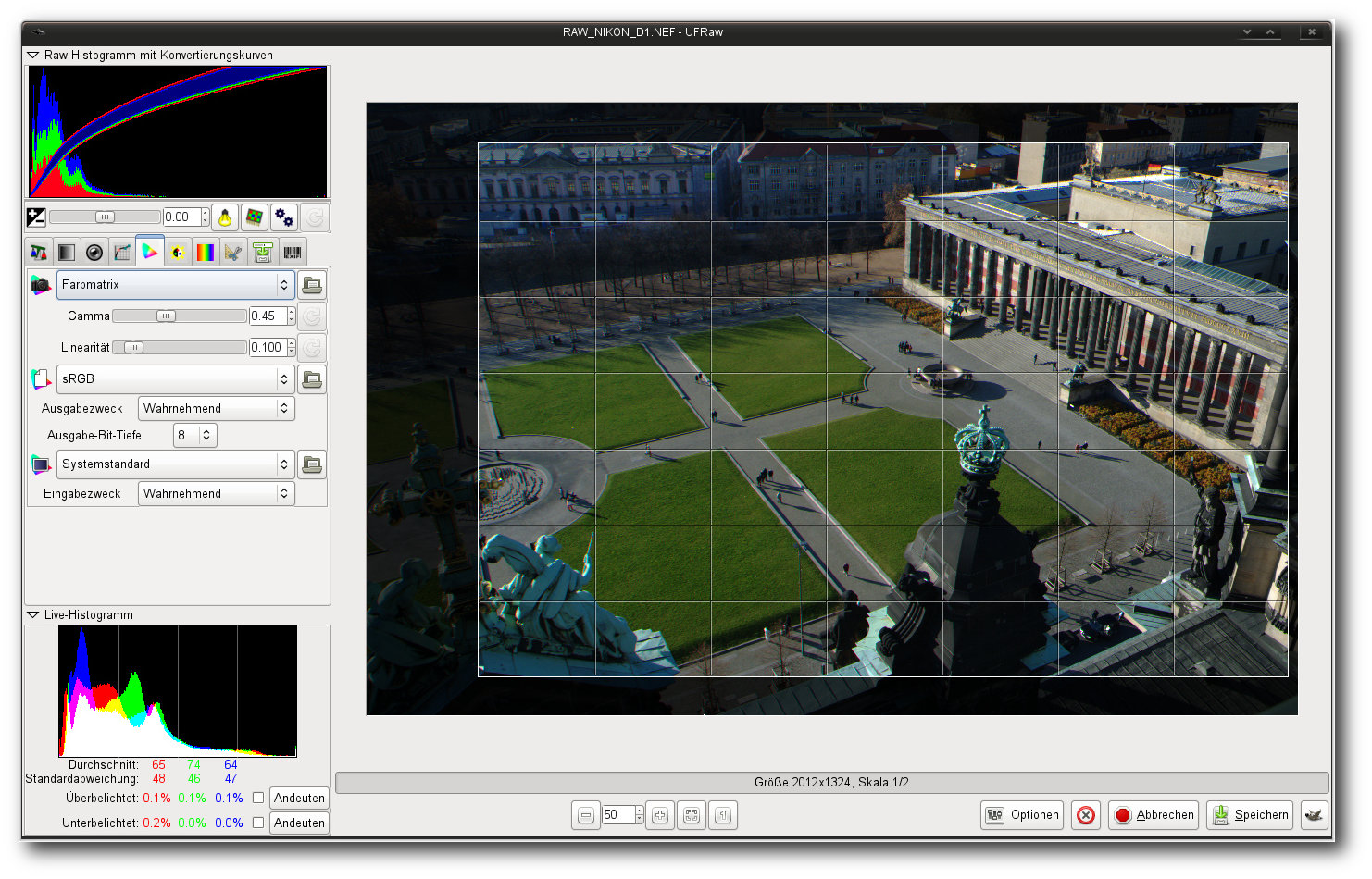

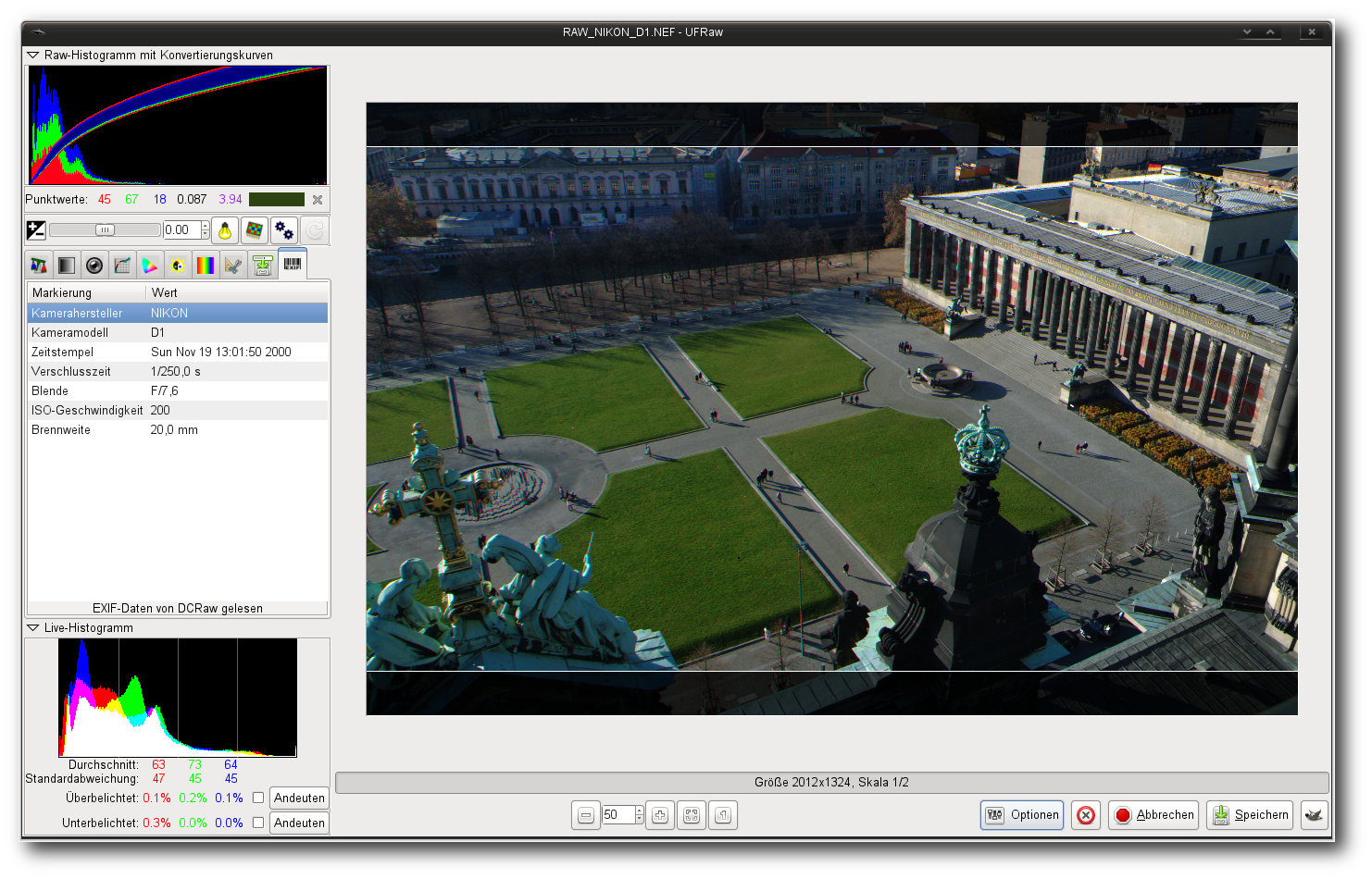

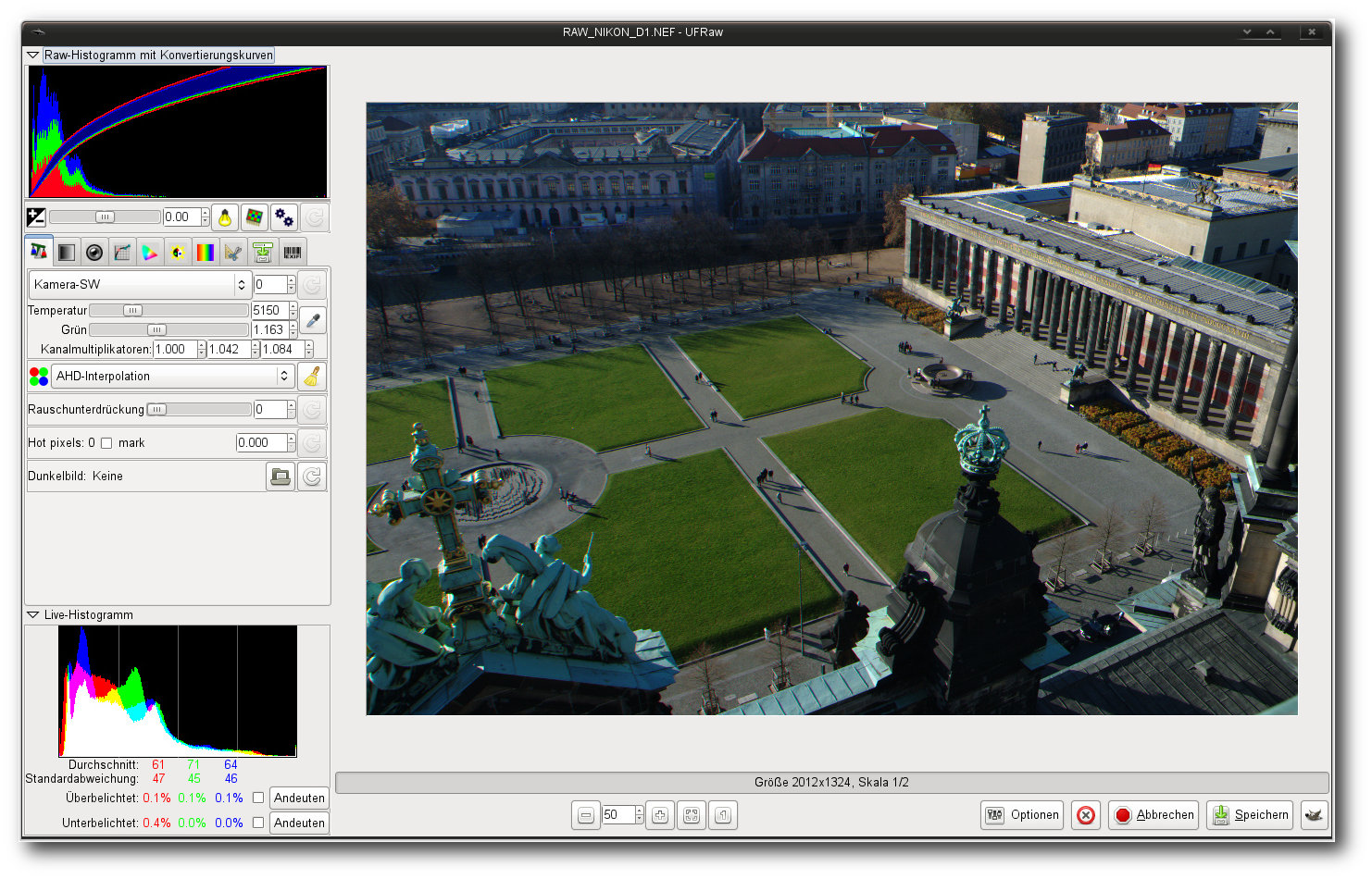

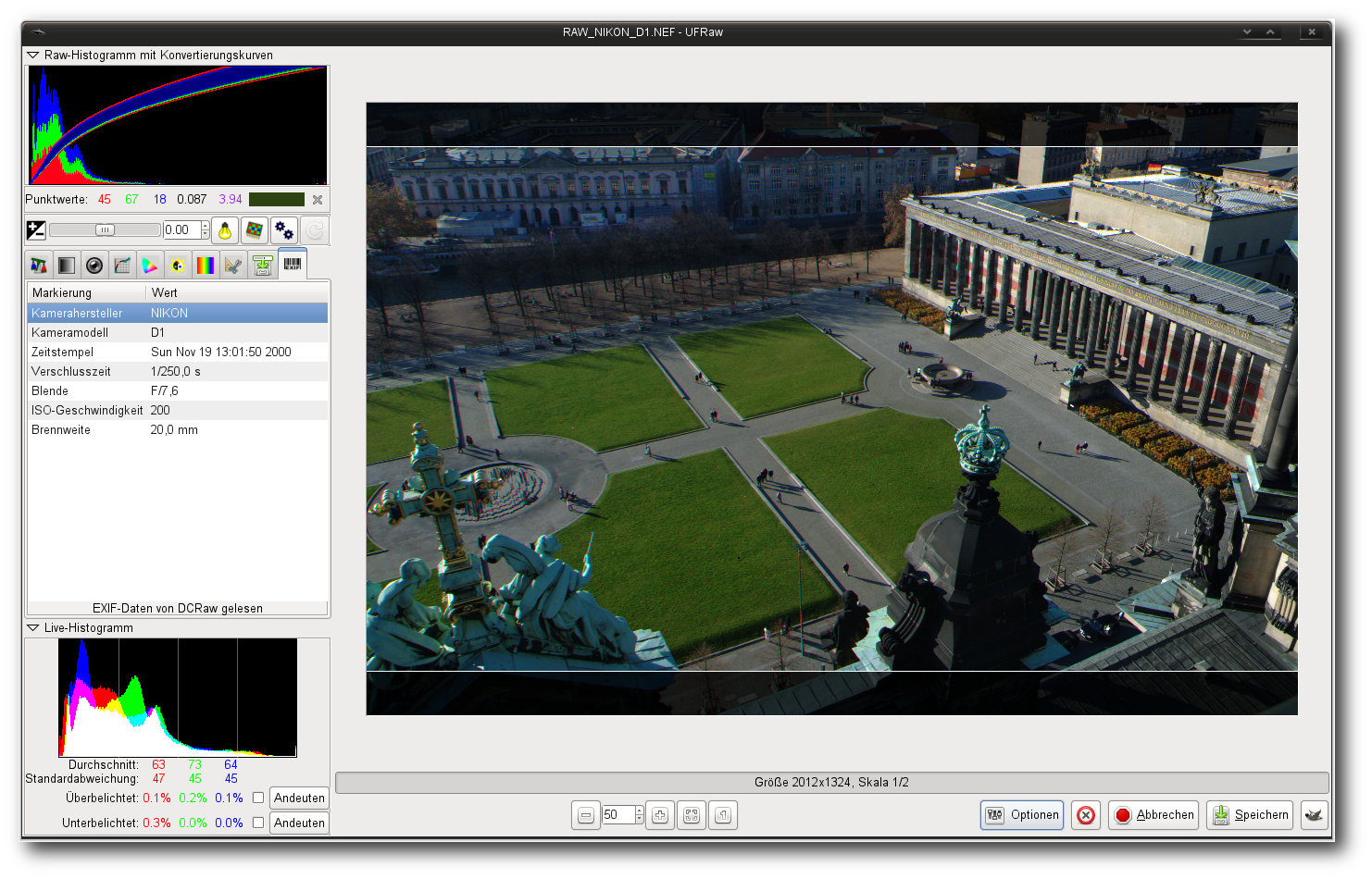

UFRaw.

Die eigenständige Variante von UFRaw kommt mit einer GTK+-Oberfläche und bietet

zahlreiche Funktionen zur Korrektur von Bilddaten. Im Gegensatz zu allen anderen

hier vorgestellten Anwendungen lädt das Programm allerdings nur

RAW-Dateiformate. Das Einlesen und Korrigieren von Standard-Bildern ist in der

Anwendung nicht vorgesehen. Genauso wenig verfügt das Tool über einen

Galerie-Modus oder einen Katalog. Wird UFRaw ohne einen Dateinamen gestartet,

präsentiert das Programm eine Dateiauswahl, aus der das gewünschte Bild

ausgewählt werden kann. Das gleichzeitige Laden von mehreren Bildern in einer

einzigen Instanz des Programms funktioniert allerdings nicht. Will der Anwender

mehrere Bilder bearbeiten, muss er das zuvor angepasste Objekt schließen, bevor

er aus der Auswahl ein weiteres laden kann.

Das Hauptfenster der Applikation teilt sich in zwei Bereiche: Den größten

Teil nimmt auch bei UFRaw der Bildbereich ein, unter dem eine Leiste mit

Informationen zur Größe der Bilddatei, Skala, dem Zoombereich und der Ausgabe

platziert wurde. Auf der linken Seite finden sich dagegen zwei Histogramme und

eine Palette an Werkzeugen, die hinter verschiedenen Reitern positioniert

wurden. So bietet der erste Reiter einen kompletten Satz an Werkzeugen für den

Weißabgleich.

Unter anderem kann hier neben einem automatischen auch ein

manueller Abgleich durchgeführt werden. Auch die Art der Interpolation,

Rauschunterdrückung oder die Festlegung des Dunkelbildes kann hier erfolgen.

Die Konfiguration der Graustufen samt eines Kanalmixers ist dagegen im Reiter

„Graustufen“ zu finden, wohingegen im Reiter „Linsenkorrektur“ die Justierung

des Objektivs erledigt werden kann. Bei unserem Test verrichtete die Funktion

allerdings nur bedingt zufriedenstellend ihre Arbeit. So wurde zwar immer das

passende Kameramodell gefunden, die dazugehörende Linse erkannte das Programm

aber nicht mehr. Doch auch bei einer dedizierten Wahl der Linse waren die

Resultate bei manchen Modellen immer noch weit von einer guten Lösung entfernt.

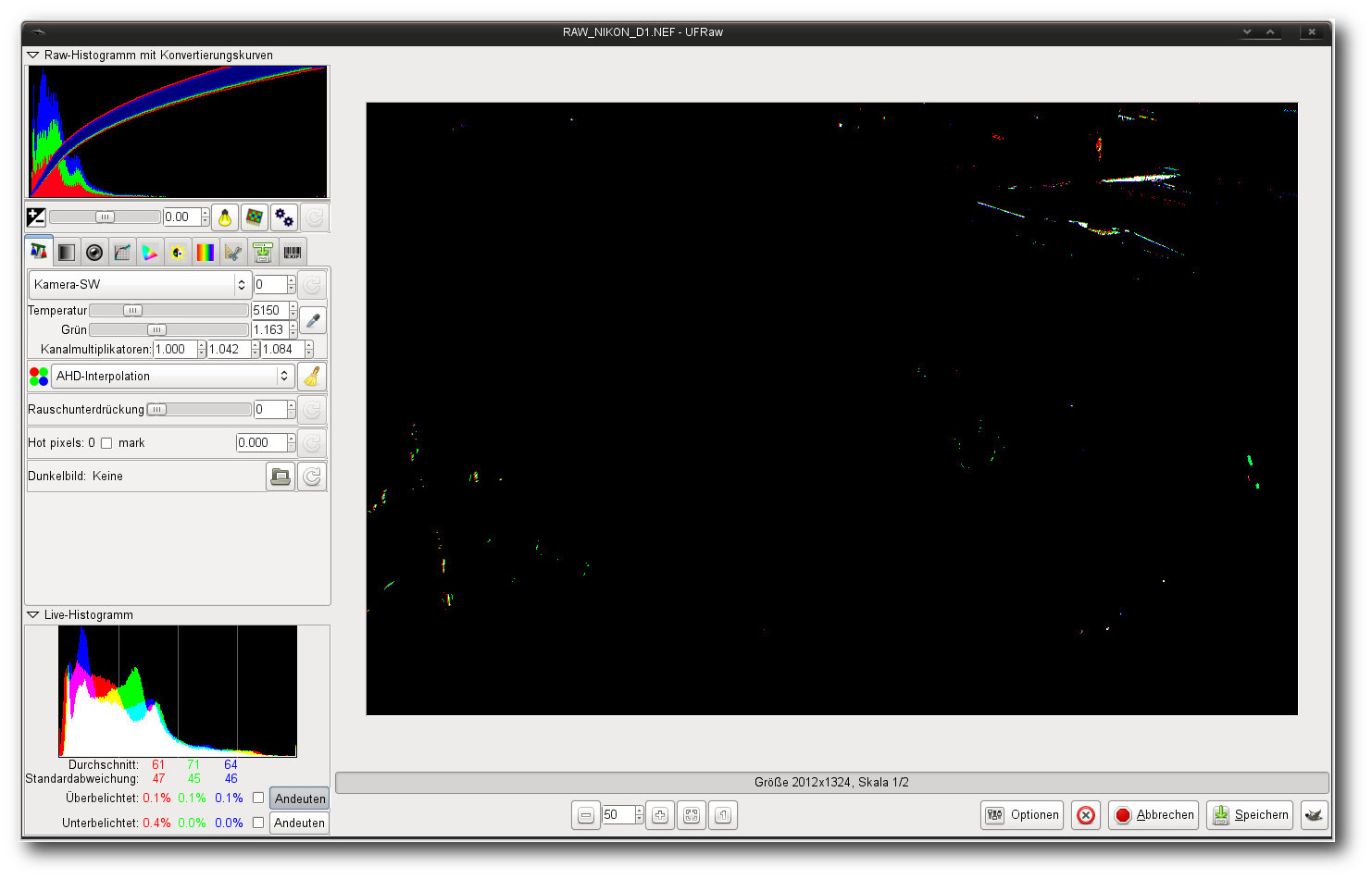

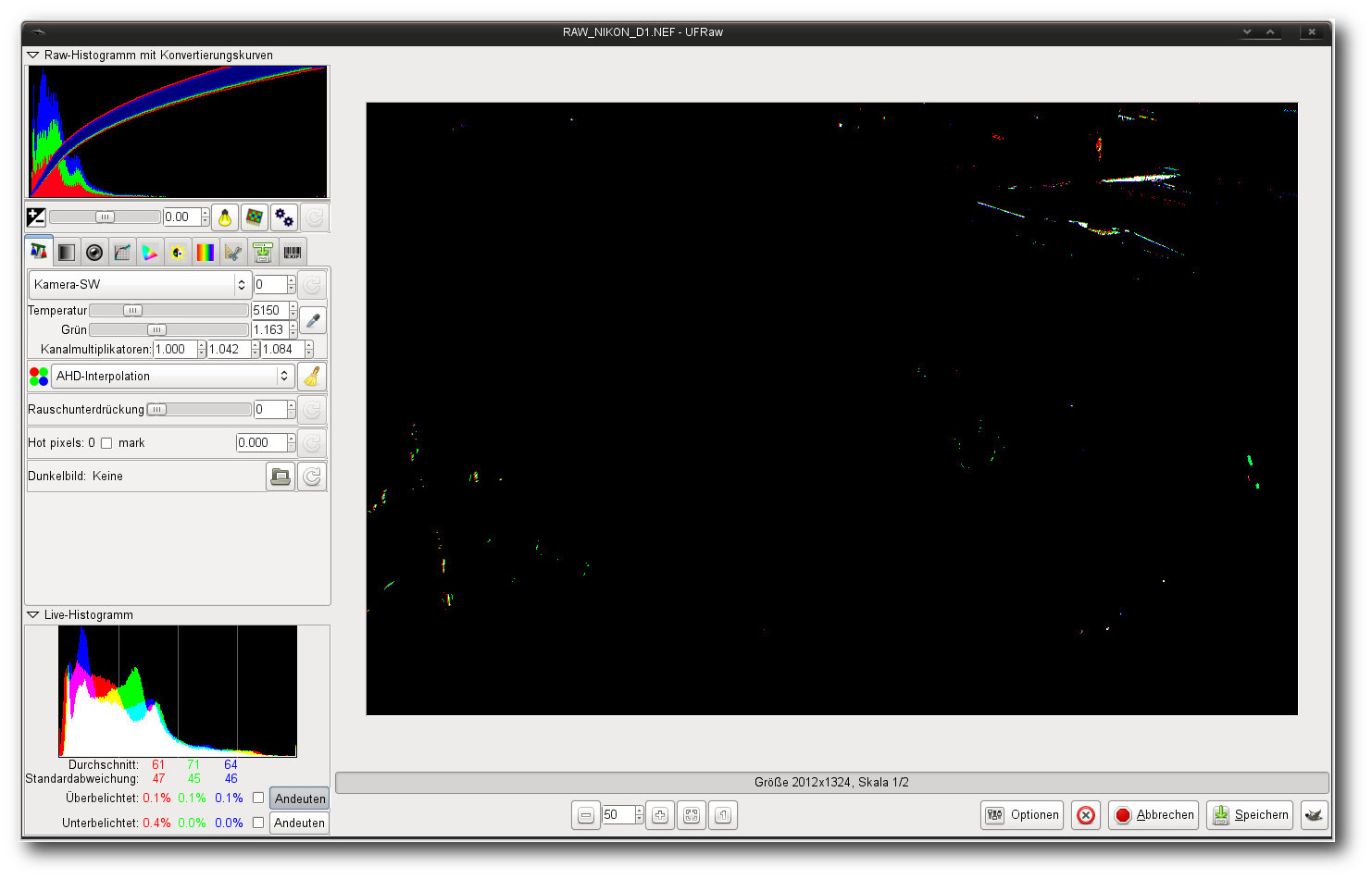

Überbelichtete Stellen zeigt UFRaw auf verschiedene Arten an.

Eine Gradationskurve liegt im Reiter unter „Basiskurve“. Sie kann als Vorlage

gespeichert und bei Bedarf in anderen Bildern eingelesen werden.

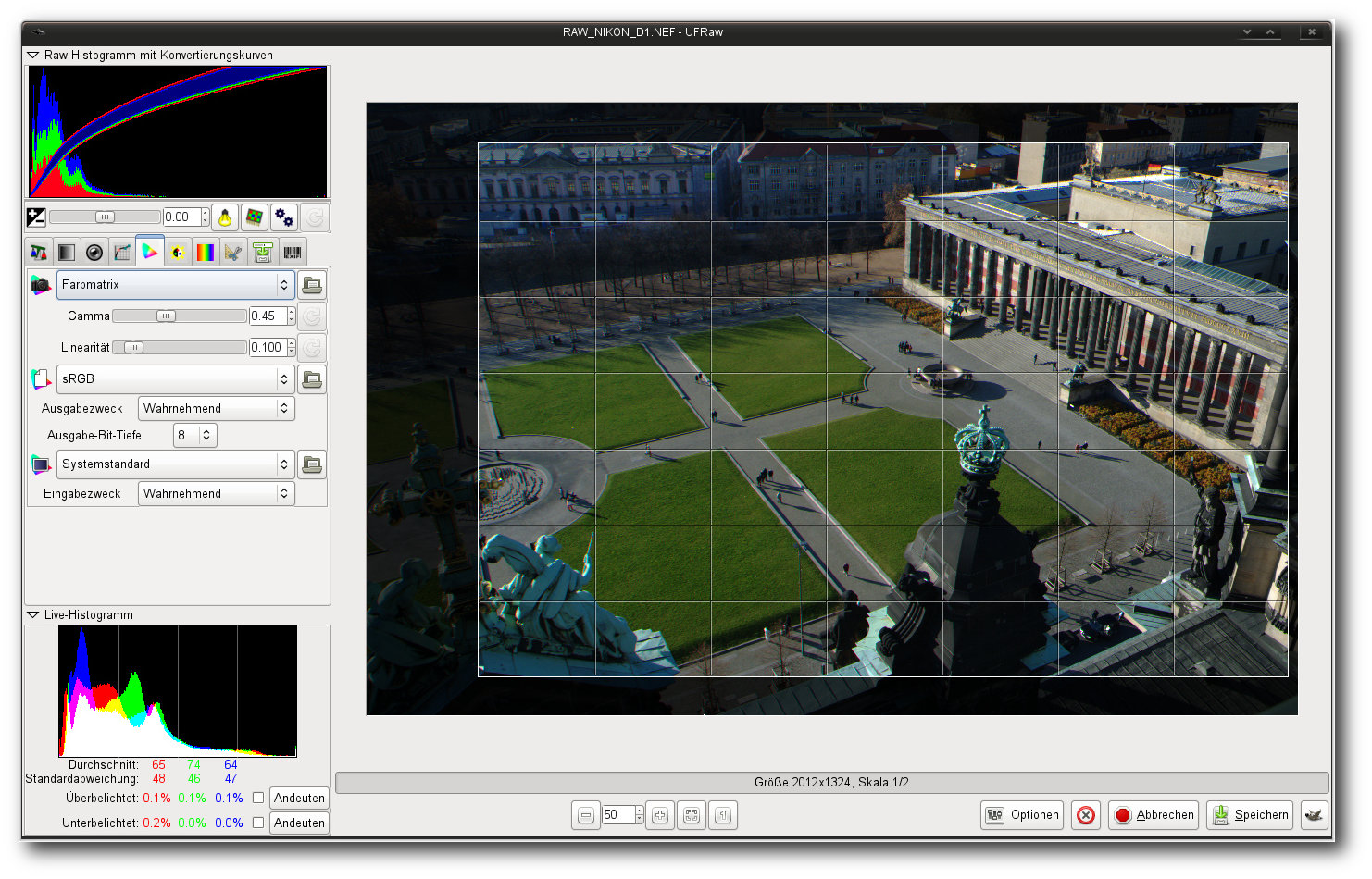

Der Reiter

„Farbverwaltung“ beherbergt dagegen zahlreiche Optionen, die sich, wie der Name

bereits suggeriert, der Anpassung von Farben widmen. Hier können unter anderem

ICC-Profile für die Ein- und Ausgabe sowie den Bildschirm eingebunden werden.

Kontrast und Sättigung werden dagegen im Bereich „Leuchtstärke und Sättigung“

korrigiert, gefolgt von dem Reiter zur Korrektur des Farbtons und einem Reiter

zur Korrektur der Größe eines Bildes. Unter anderem lässt sich hier das Bild

drehen, spiegeln und zuschneiden. Der Ausgabeformat wird im Reiter „Sichern“

festgelegt. Neben PPM, PNG und TIFF unterstützt UFRaw auch JPEG als

Ausgabeformat. Zudem kann unter „Sichern“ auch festgelegt werden, ob die

Anwendung die Werkzeugstandards speichern soll. Im Gegensatz zu anderen

Applikationen speichert UFRaw nicht die Bearbeitungsschritte in einer separaten

Datei für jedes Bild einzeln, sondern global. Dies führt unter anderem dazu,

dass jedes geladene Bild die Voreinstellungen des Vorgängers übernimmt. Will man

das Verhalten abstellen, muss die Option „Bildstandards sichern“ entsprechend

angepasst werden.

Aufgaben erledigt die Applikation nichtdestruktiv (Hier: Zuschnitt).

Eine dedizierte Stapelbearbeitung besitzt die GUI-Variante nicht. Wer jedoch

eine Reihe von Bildern abarbeiten will, kann sich des zugrunde liegendem Tools

„ufraw-batch“ bedienen. Wie UFRaw erlaubt auch „ufraw-batch“ das Setzen von

Parametern direkt von der Kommandozeile aus. Kombiniert mit den Möglichkeiten

der Shell und den zahlreichen Tools unter Linux lassen sich so Kaskaden an

Funktionen bilden, die wohl

mit keinem anderen Programm möglich sind. So können

beispielsweise das Drucken oder eine Publikation im Netz, die UFRaw nicht selbst

im Lieferumfang mit sich bringt, durch eine Kombination mit anderen Tools

mühelos realisiert werden. Den einzigen Wermutstropfen stellt die Komplexität und

die damit einhergehende Bedienung dar, die vor allem unerfahrene Benutzern

anfänglich frustrieren werden.

Eine Möglichkeit, Exif-Daten zu bearbeiten, gibt es nicht.

Fazit: Auch UFRaw überzeugt durch einen vollständigen Satz von Funktionen, die

die meisten Anforderungen an einen RAW-Konverter erfüllen. Neben zahlreichen

grundlegenden Anpassungen lassen sich mit der Anwendung auch diverse

fortgeschrittene Aktivitäten durchführen. Die Objektivkorrektur könnte

allerdings noch

diverse Überarbeitungen vertragen. Im Gegensatz zu anderen

Anwendungen beschränkt sich UFRaw lediglich auf die eigentliche Entwicklung der

Bilder. Funktionen jenseits des Bereichs oder gar Funktionen zur Katalogisierung

oder dem Druck sucht man in der Anwendung vergebens. Dafür ist die Bedienung

der GUI-Variante erfreulich intuitiv. Die Komponenten sind logisch angeordnet

und verwirren nicht. Kenner werden sich in der Applikation schnell zurecht

finden, ohne dass sie groß nach Funktionen suchen müssen.

Vergleich der Funktionen

Einen Vergleich der Funktionen zwischen den verschiedenen Programmen, die hier vorgestellt wurden,

bietet Pro-Linux im Originalartikel [18].

Links

[1] http://www.pro-linux.de/artikel/2/1583/raw-bessere-fotos.html

[2] http://de.wikipedia.org/wiki/Demosaicing

[3] http://chdk.wikia.com/wiki/CHDK

[4] http://www.corel.com/corel/product/index.jsp?pid=prod4670071&cid=catalog20038&segid=6000006&storeKey=us&languageCode=en

[5] http://www.pro-linux.de/news/1/17908/corel-stellt-aftershot-pro-vor.html

[6] http://www.pro-linux.de/news/1/17908/corel-stellt-aftershot-pro-vor.html

[7] http://aftershotpro.com/plugins/index.html?plug=zperspector

[8] http://www.darktable.org/

[9] http://www.darktable.org/2012/03/darktable-1-0-released/

[10] http://www.digikam.org/

[11] ttp://www.kphotoalbum.org/

[12] http://gwenview.sourceforge.net/

[13] http://www.kornelix.com/fotoxx.html

[14] http://photivo.org/

[15] http://rawstudio.org/

[16] http://rawtherapee.com/

[17] http://ufraw.sourceforge.net/

[18] http://www.pro-linux.de/artikel/2/1583/11,einfuehrung.html

| Autoreninformation |

| Mirko Lindner (Webseite)

befasst sich seit 1990 mit Unix. Seit 1998 ist er aktiv in die Entwicklung des Kernels eingebunden und verantwortlich für diverse Treiber und

Subsysteme für Linux und andere freie Plattformen. Daneben ist er einer der Betreiber von Pro-Linux.de.

|

Diesen Artikel kommentieren

Zum Index

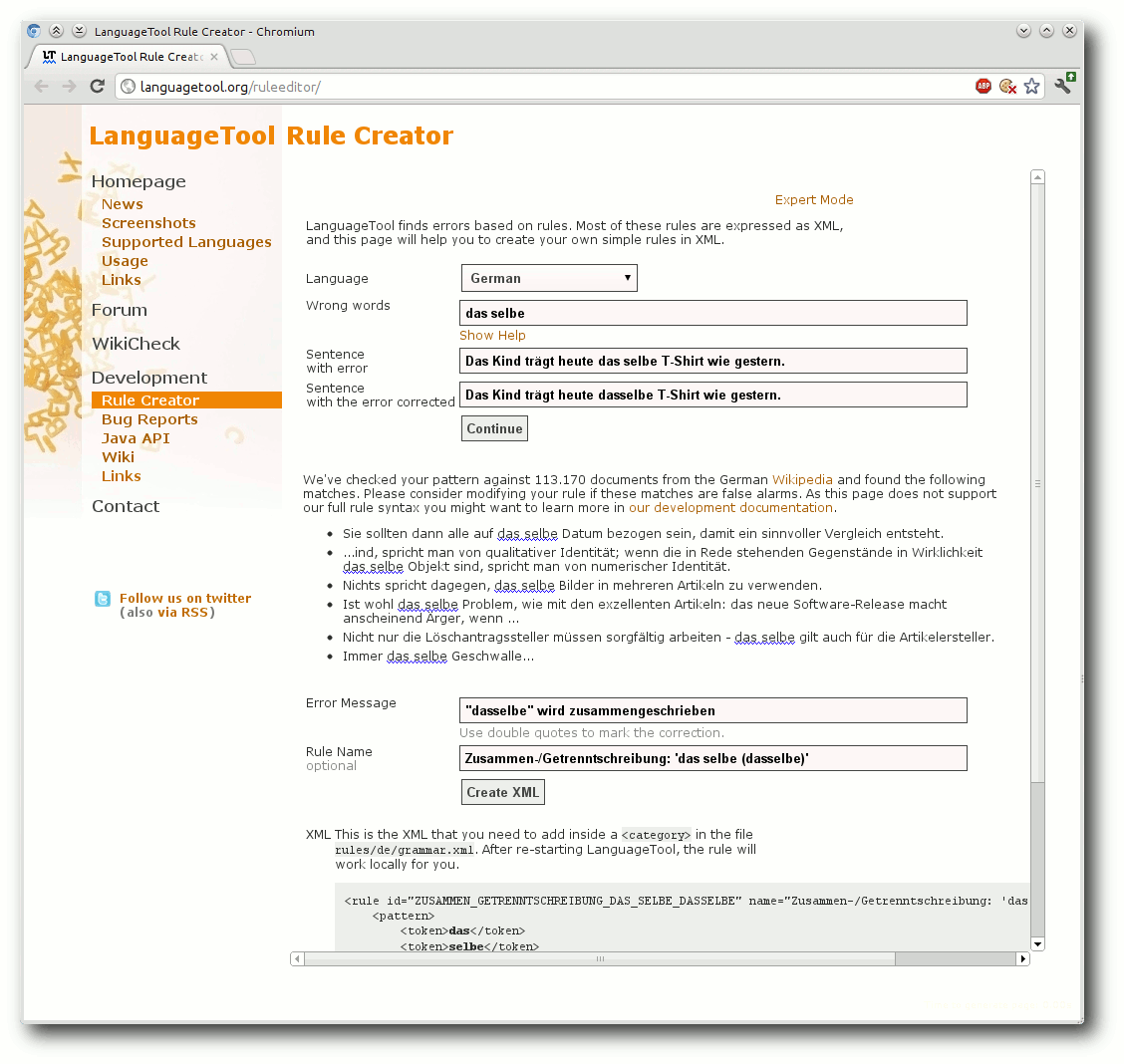

von Markus Brenneis

In der vorletzten Ausgabe von

freiesMagazin [1]

wurde die freie Stil- und Grammatikprüfung

LanguageTool [2] vorgestellt. Wie

versprochen wird in dieser Ausgabe gezeigt, wie einfache, in

XML [3]

geschriebene Regeln für LanguageTool erstellt werden. Und es sei

nochmals erwähnt: Programmierkenntnisse sind nicht erforderlich

(XML-Grundkenntnisse könnten aber nicht schaden).

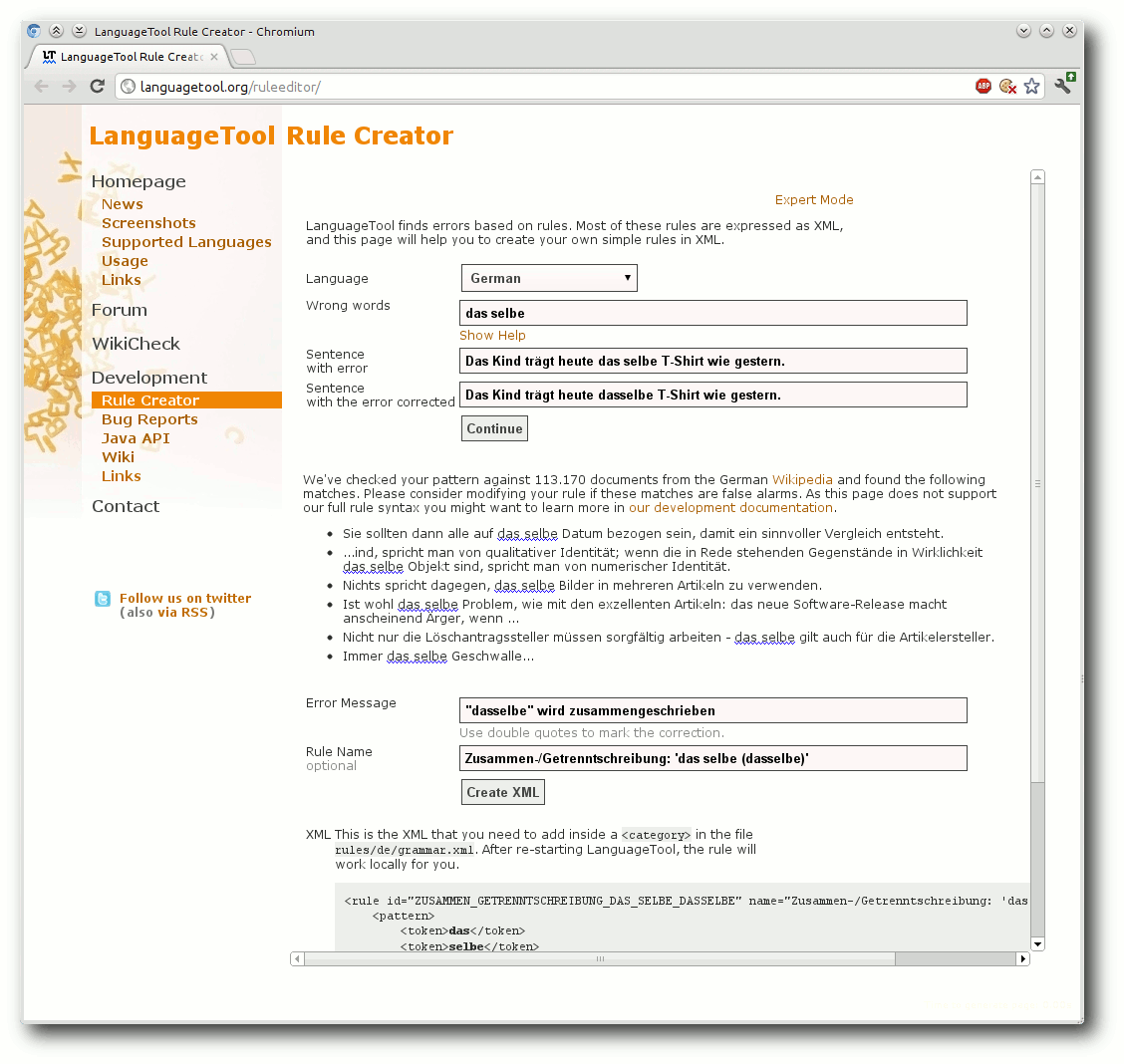

Es ist doch immer wieder das selbe…

Wie die Überschrift vermuten lässt, soll als erstes eine Regel

erstellt werden, die auf ein fälschlicherweise getrennt geschriebenes

„dasselbe“ hinweisen soll. Mit Hilfe des Rule

Creators [4] ist dies relativ

einfach möglich.

Als erstes wählt man als Sprache („Language“) Deutsch („German“)

aus; das hat keine Auswirkung auf die generierte Regel, sondern ist

für das automatische Testen der Regel notwendig. Als falsche Wörter

(„Wrong words“) wird das fehlerhafte „das selbe“ eingetragen.

Anschließend müssen noch zwei Beispielsätze eingegeben werden: einen

Satz, der den Fehler enthält („Sentence with error“) und einen Satz,

in dem der Fehler behoben ist („Sentence with error corrected“).

Also z. B. „Das Kind trägt heute das selbe T-Shirt wie gestern.“ und

die korrekte Variante mit „dasselbe“. Nach einem Klick auf

„Continue“ werden mehr als 8.000 Wikipediaartikel anhand der fast

fertigen Regel geprüft. Sollten dabei Fehler gefunden werden, sind

dies entweder Fehler in dem entsprechenden Wikipedia-Artikel oder

die Regel generiert Fehlalarme und sollte verbessert werden.

Da dies für das Beispiel aber nicht der Fall ist, kann jetzt die

Meldung („Error Message“), die von LanguageTool ausgegeben werden

soll, wenn der Fehler gefunden wird, eingegeben werden (z. B.:

„"dasselbe" wird zusammengeschrieben.“); der Korrekturvorschlag muss

dabei in doppelten Anführungszeichen stehen. Als Regelname („Rule

Name“) würde sich – passend zu den anderen in LanguageTool

verwendeten Regelbezeichnungen nach dem Muster „Kategorie: 'falsch

(richtig)'“ – „Zusammen-/Getrenntschreibung: 'das selbe (dasselbe)'“

anbieten. Durch einen Klick auf „Create XML“ wird die Regel erstellt:

<rule id="ZUSAMMEN_GETRENNTSCHREIBUNG_DAS_SELBE_DASSELBE" name="Zusammen-/Getrenntschreibung: 'das selbe (dasselbe)'">

<pattern>

<token>das</token>

<token>selbe</token>

</pattern>

<message><suggestion>dasselbe</suggestion> wird zusammengeschrieben.</message>

<example type="incorrect">Das Kind trägt heute <marker>das selbe</marker> T-Shirt wie gestern.</example>

<example type="correct">Das Kind trägt heute dasselbe T-Shirt wie gestern.</example>

</rule>

Die Regel erklärt

Die Regel steht in einem rule-Element mit den Attributen id und

name. Die ID ist eine einmalige Bezeichnung, die nur aus

Großbuchstaben und keinen Leerzeichen besteht und intern benutzt

wird, um die Regel anzusprechen. Die automatisch generierte ID

könnte auch problemlos auf „DAS_SELBE“ gekürzt werden. Der Name der

Regel wird im Einstellungsdialog angezeigt.

Zwischen den pattern-Tags steht das „Muster“, das den Fehler

beschreibt und aus einer Folge von Tokens besteht, die im

Beispiel die Wörter „das“ und „selbe“ sind. Zu beachten ist, dass

<token>das selbe</token> nicht funktionieren würde. (Merke: Ein

Token enthält nie ein Leerzeichen.) Die message-Tags enthalten die

Fehlerbeschreibung, wobei der Korrekturvorschlag in

suggestion-Tags eingeschlossen ist.

Mit Hilfe des Rule Creator kann man einfache Regeln erstellen.

Last but not least kommen noch

die beiden Beispielsätze, die zum automatischen Testen der Regeln

verwendet werden. Die Wörter, die LanguageTool im Text als falsch

markieren soll, stehen dabei im marker-Element.

Erweiterung der Regel

Nun wäre es schön, wenn die Regel neben „das selbe“ auch „der selbe“,

„die selben“ usw. erkennen würde. Anstatt jetzt für jeden Fall eine

eigene Regel mit dem Rule Creator zu erstellen, kann die bestehende

Regel mit Hilfe regulärer

Ausdrücke [5]

erweitert werden. Der pattern-Teil sähe dann so aus:

<pattern>

<token regexp="yes">der|die|das|des|dem|den</token>

<token regexp="yes">selben?</token>

</pattern>

Die token-Tags haben also das Attribut regexp="yes" bekommen,

das es erlaubt, anstelle einfacher Wörter, reguläre Ausdrücke zu

benutzen. Nun meldet die Regel dann einen Fehler, wenn auf einen

Artikel („der“, „die“, „das“, „des“, „dem“ oder „den“) „selbe“ oder

„selben“ folgt. Jetzt ist nur noch dafür zu sorgen, dass nicht immer

„dasselbe“ als Vorschlag angezeigt wird, sondern „derselbe“ usw.,

also dass der Vorschlag von den im Text tatsächlich vorhandenen

Wörtern abhängt. Dazu kann man innerhalb der message-Tags mit \1

den Text des ersten und mit \2 den Text des zweiten Tokens

erhalten. Damit würde die Fehlermeldung wie folgt aussehen:

<message><suggestion>\1\2</suggestion> wird zusammengeschrieben.</message>

Um zu testen, ob die Regel auch wie gewünscht funktioniert, wird ein weiterer Beispielsatz hinzugefügt:

<example type="incorrect" correction="Denselben"><marker>Den selben</marker> Pullover trägt er heute.</example>

Hier wird zusätzlich das Attribut correction verwendet, um

sicherzustellen, dass die Regel die richtige Schreibweise

vorschlägt. Außerdem zeigt dieser Beispielsatz, dass bei den Tokens

standardmäßig nicht zwischen Groß- und Kleinschreibung unterschieden

wird.

Der vollständige Code sieht nun so aus:

<rule id="DAS_SELBE" name="Zusammen-/Getrenntschreibung: 'das selbe (dasselbe)' etc.">

<pattern>

<token regexp="yes">der|die|das|des|dem|den</token>

<token regexp="yes">selben?</token>

</pattern>

<message><suggestion>\1\2</suggestion> wird zusammengeschrieben.</message>

<example type="incorrect" correction="dasselbe">Das Kind trägt heute <marker>das selbe</marker> T-Shirt wie gestern.</example>

<example type="correct">Das Kind trägt heute dasselbe T-Shirt wie gestern.</example>

<example type="incorrect" correction="Denselben"><marker>Den selben</marker> Pullover trägt er heute.</example>

</rule>

Testen der Regel

Um sicherzugehen, dass die erweiterte Regel

keine Fehlalarme

auslöst, sollte sie wieder anhand von Wikipedia-Artikeln getestet

werden. Dies ist auch wieder über den Rule Creator möglich, der jetzt

über den Link oben rechts in den „Expert Mode“ geschaltet werden

muss. Dort muss nun als Sprache German eingestellt, der komplette

Code eingegeben und auf „Check XML“ geklickt werden. Zur Zeit (Juli

2012) werden ein paar Fehler in der Wikipedia gefunden, die aber

keine Fehlalarme, sondern schlicht Fehler in den Wikipedia-Artikeln

sind, die natürlich direkt in der Wikipedia korrigiert werden sollten

(ein Hinweis auf LanguageTool in der

Änderungszusammenfassung wäre wünschenswert). Da die Testdaten aber

nicht immer den aktuellen Artikelversionen entsprechen, könnte der

Fehler zwischenzeitlich schon behoben sein.

Jetzt sollte die Regel noch in LanguageTool selbst getestet werden.

Dazu lädt man zunächst die Stand-Alone-Version (.zip) herunter,

wobei es bei der Regelentwicklung sinnvoll ist, eine aktuelle

Entwicklerversion [6]

zu nehmen, damit man nicht aus Versehen eine bereits existierende

Regel neu erfindet.

Wenn man die zip-Datei entpackt hat, findet man

in der Datei rules/de/grammar.xml alle XML-Regeln für die deutsche

Sprache. Dort fügt man in der passenden Kategorie den Code der Regel

ein. (Für das Beispiel wäre das nach der Zeile <category

name="Zusammen-/Getrenntschreibung">.)

Nach dem Speichern der Änderung kann nun die Benutzeroberfläche

durch das Öffnen von LanguageToolGUI.jar gestartet werden. Dort gibt

man noch einmal einen Beispielsatz ein und überprüft, ob sowohl der

Vorschlag als auch die angezeigte Fehlermeldung richtig sind.

Darüber hinaus sollte man, wenn die Regel veröffentlicht werden